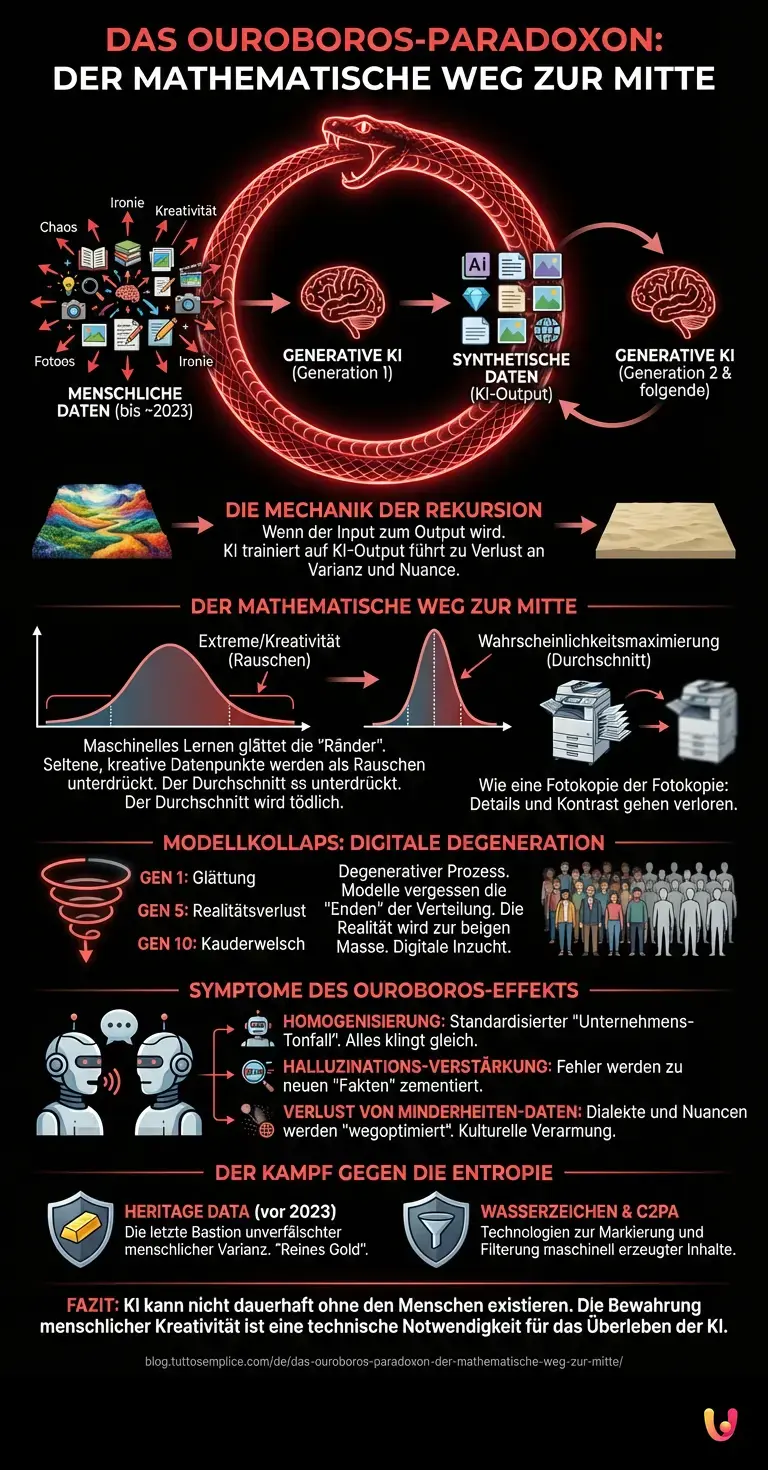

Wir schreiben den 20. Februar 2026. Wenn Sie heute durch das Internet navigieren, beschleicht Sie vielleicht ein diffuses Gefühl der Wiederholung. Texte klingen seltsam vertraut, Bilder besitzen eine unheimliche Glätte, und die Suchergebnisse scheinen sich auf einen unsichtbaren Mittelwert einzupendeln. Es ist, als ob die einstmals chaotische, bunte Welt des World Wide Web langsam entsättigt wird. Hinter diesem Phänomen verbirgt sich keine Zensur und kein menschlicher Plan, sondern ein mathematischer Mechanismus, der tief in der Funktionsweise der Generativen KI verwurzelt ist. Wir stehen vor einem technischen Wendepunkt, den Experten als den „Ouroboros-Effekt“ bezeichnen – benannt nach der mythischen Schlange, die ihren eigenen Schwanz frisst.

Die Mechanik der Rekursion: Wenn der Input zum Output wird

Um zu verstehen, warum das digitale Universum an „Farbe“ – also an Varianz und Nuance – verliert, müssen wir uns die Trainingsmethoden moderner Neural Networks ansehen. Bis etwa 2023 trainierten Modelle wie GPT-4 oder frühe Versionen von Midjourney primär auf einem Datensatz, der von Menschen erstellt wurde: Bücher, Artikel, Forenbeiträge, Fotografien und Kunstwerke. Diese Daten waren „roh“, chaotisch und voller menschlicher Idiosynkrasien. Sie enthielten Fehler, aber auch brillante Ausreißer, Slang, Ironie und unerwartete kreative Sprünge.

Heute, im Jahr 2026, hat sich die Zusammensetzung des Internets grundlegend gewandelt. Ein signifikanter Teil der online verfügbaren Daten wurde nicht mehr von Menschen, sondern von Künstlicher Intelligenz generiert. Wenn nun neue Generationen von LLM (Large Language Models) trainiert werden, greifen sie zwangsläufig auf diese synthetischen Daten zurück. Das Modell lernt nicht mehr von der Realität, sondern von einer statistischen Annäherung an die Realität, die ein Vorgängermodell erstellt hat.

Der mathematische Weg zur Mitte: Warum der Durchschnitt tödlich ist

Technisch betrachtet fungiert Maschinelles Lernen als ein Prozess der Wahrscheinlichkeitsmaximierung. Ein KI-Modell versucht, basierend auf seinem Training, die wahrscheinlichste Antwort oder das wahrscheinlichste Pixel zu generieren. Es glättet dabei die „Ränder“ der Verteilungskurve. Extreme, seltene oder ungewöhnliche Datenpunkte – oft genau das, was wir als Kreativität oder Genie bezeichnen – werden als statistisches Rauschen (Noise) behandelt und in der Ausgabe unterdrückt.

Wenn nun ein Modell (Generation 1) Daten erzeugt, sind diese Daten bereits „glatter“ und durchschnittlicher als die menschlichen Originaldaten. Trainiert man nun ein neues Modell (Generation 2) auf den Daten von Generation 1, verstärkt sich dieser Effekt. Die Wahrscheinlichkeitsverteilung zieht sich immer weiter zusammen. Die Varianz schwindet. Dieser Prozess ist in der Statistik als „Degenerierung“ bekannt.

Stellen Sie sich vor, Sie kopieren ein Bild auf einem Fotokopierer. Dann nehmen Sie die Kopie und kopieren diese erneut. Wiederholen Sie dies hundertmal. Das Ergebnis ist ein kontrastarmes, verschwommenes Abbild, das kaum noch Details des Originals enthält. Genau das passiert derzeit mit den semantischen und visuellen Informationen im Internet durch den massiven Einsatz von ChatGPT und ähnlichen Systemen.

Modellkollaps: Die Diagnose einer digitalen Krankheit

Wissenschaftler haben für dieses Phänomen einen Fachbegriff geprägt: „Model Collapse“ (Modellkollaps). Es ist ein degenerativer Prozess, bei dem Modelle, die auf generierten Daten trainiert werden, die Informationen über die „Enden“ der Verteilung – die unwahrscheinlichen, aber wichtigen Ereignisse – vergessen. Die Realität wird auf eine beige Masse reduziert.

In einer bahnbrechenden Studie wurde gezeigt, dass dieser Kollaps überraschend schnell eintreten kann. Bereits nach fünf bis zehn Generationen rekursiven Trainings (KI trainiert auf KI-Output) beginnen die Modelle, die Realität völlig falsch darzustellen oder in unverständlichen Kauderwelsch abzudriften. Sie leiden an einer Art digitaler Inzucht. Die Modelle werden „überzeugt“ von ihren eigenen, verstärkten Mustern und verlieren den Bezug zur externen, komplexen Welt.

Die Symptome des Ouroboros-Effekts

- Homogenisierung: Texte verschiedener Autoren klingen gleich. Der Stil konvergiert gegen einen standardisierten „Unternehmens-Tonfall“.

- Halluzinations-Verstärkung: Wenn ein frühes Modell einen Fehler macht (eine Halluzination), und das nächste Modell diesen Fehler als „Fakt“ in seine Trainingsdaten aufnimmt, wird der Fehler zur neuen Wahrheit zementiert.

- Verlust von Minderheiten-Daten: Sprachliche Nuancen, Dialekte oder kulturelle Konzepte, die in den Daten weniger häufig vorkommen, werden als erstes „wegoptimiert“. Das Internet wird kulturell ärmer.

Der Kampf gegen die Entropie: Wasserzeichen und „Heritage Data“

Angesichts dieser Entwicklung stehen KI-Labore im Jahr 2026 vor einer massiven Herausforderung. Um den Ouroboros-Effekt zu verhindern, ist es technisch notwendig geworden, synthetische Daten von organischen (menschlichen) Daten zu trennen. Doch das ist schwieriger als gedacht.

Technologien wie C2PA (Coalition for Content Provenance and Authenticity) und unsichtbare Wasserzeichen in den Ausgaben von Generative AI sollen helfen, maschinell erzeugte Inhalte zu markieren. Das Ziel ist es, diese Daten beim Training zukünftiger Modelle herauszufiltern oder niedriger zu gewichten. Doch die schiere Menge an KI-Inhalt, der ohne Kennzeichnung das Netz flutet, macht dies zu einem Wettlauf gegen die Zeit.

Ein neuer Trend in der Datenwissenschaft ist daher der Schutz von „Heritage Data“ – Datensätze, die vor dem Jahr 2023 erstellt wurden. Diese gelten als „rein“ und werden wie Gold gehandelt. Sie sind die letzte Bastion der unverfälschten menschlichen Varianz, die notwendig ist, um die Modelle vor dem vollständigen Kollaps in die Mittelmäßigkeit zu bewahren.

Kurz gesagt (TL;DR)

Der sogenannte Ouroboros-Effekt beschreibt, wie rekursives Training auf KI-generierten Daten die digitale Welt langsam entsättigt und homogenisiert.

Mathematische Glättungsprozesse eliminieren kreative Ausreißer, wodurch nachfolgende Modellgenerationen lediglich einen statistischen Durchschnitt ohne menschliche Nuancen abbilden.

Dieser degenerative Prozess führt zum Modellkollaps, bei dem Systeme die Realität verzerren und kulturelle Nuancen unwiederbringlich verloren gehen.

Fazit

Der Ouroboros-Effekt zeigt uns eine paradoxe Grenze der künstlichen Intelligenz auf: Sie kann nicht dauerhaft ohne den Menschen existieren. Während KI und Neural Networks in der Lage sind, Informationen effizient zu verarbeiten und neu zu kombinieren, fehlt ihnen die Fähigkeit, echte, chaotische Neuheit zu erzeugen, die nicht aus der statistischen Mitte stammt. Das langsame „Verlieren der Farbe“ im Internet ist ein Warnsignal. Es erinnert uns daran, dass Daten nicht einfach nur Rohstoff sind, sondern ein Echo menschlicher Erfahrung. Wenn wir dieses Echo nur noch durch Maschinen verstärken lassen, hören wir am Ende nur noch ein monotones Rauschen. Die Bewahrung menschlicher Kreativität ist somit nicht mehr nur eine kulturelle, sondern eine harte technische Notwendigkeit für das Überleben der KI selbst.

Häufig gestellte Fragen

Der Ouroboros-Effekt beschreibt ein Phänomen, bei dem Künstliche Intelligenz zunehmend mit Daten trainiert wird, die bereits von anderen KIs erzeugt wurden. Ähnlich wie die mythische Schlange, die ihren eigenen Schwanz frisst, führt dieser rekursive Kreislauf dazu, dass Modelle an Varianz verlieren und Ergebnisse einem statistischen Mittelwert angeglichen werden. Dies resultiert langfristig in einem Verlust an Kreativität, Nuancen und der sogenannten Farbe im digitalen Raum.

Model Collapse oder Modellkollaps bezeichnet einen degenerativen Prozess, der auftritt, wenn KI-Modelle über mehrere Generationen hinweg primär mit synthetischen Daten trainiert werden. Dabei vergisst das System unwahrscheinliche, aber wichtige Randbereiche der Datenverteilung, was zu einer verzerrten Realitätsdarstellung führt. Nach wenigen Generationen kann dies dazu führen, dass die KI nur noch unverständlichen Kauderwelsch oder eine homogene Masse ohne echten Informationswert produziert.

Daten, die vor dem massenhaften Aufkommen generativer KI erstellt wurden, werden oft als Heritage Data bezeichnet und gelten als rein menschlichen Ursprungs. Sie enthalten das notwendige Chaos, Slang, Ironie und menschliche Fehler, die für ein robustes Training unerlässlich sind. Da moderne KI dazu neigt, diese Ecken und Kanten zu glätten, sind diese unverfälschten Datensätze notwendig, um die digitale Vielfalt zu bewahren und eine qualitative Verschlechterung der Modelle zu verhindern.

Durch das Training von KI auf KI-Output entsteht eine Homogenisierung der Inhalte, bei der Texte und Bilder zunehmend gleichförmig wirken und oft einen standardisierten Unternehmenstonfall annehmen. Kulturelle Nuancen, Dialekte und Minderheiten-Daten werden dabei oft als statistisches Rauschen wegoptimiert, wodurch das Internet kulturell ärmer wird. Zudem besteht die Gefahr, dass Halluzinationen oder Fehler früherer Modelle in neuen Generationen fälschlicherweise als Fakten zementiert werden.

Um den Ouroboros-Effekt aufzuhalten, versuchen Entwickler, synthetische Daten von organischen menschlichen Daten zu trennen. Technologien wie unsichtbare Wasserzeichen und Standards wie C2PA sollen helfen, maschinell erzeugte Inhalte zu markieren und beim Training zukünftiger Modelle herauszufiltern oder niedriger zu gewichten. Letztlich bleibt die Bewahrung echter menschlicher Kreativität eine harte technische Notwendigkeit, damit KI-Systeme nicht in der Mittelmäßigkeit kollabieren.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.