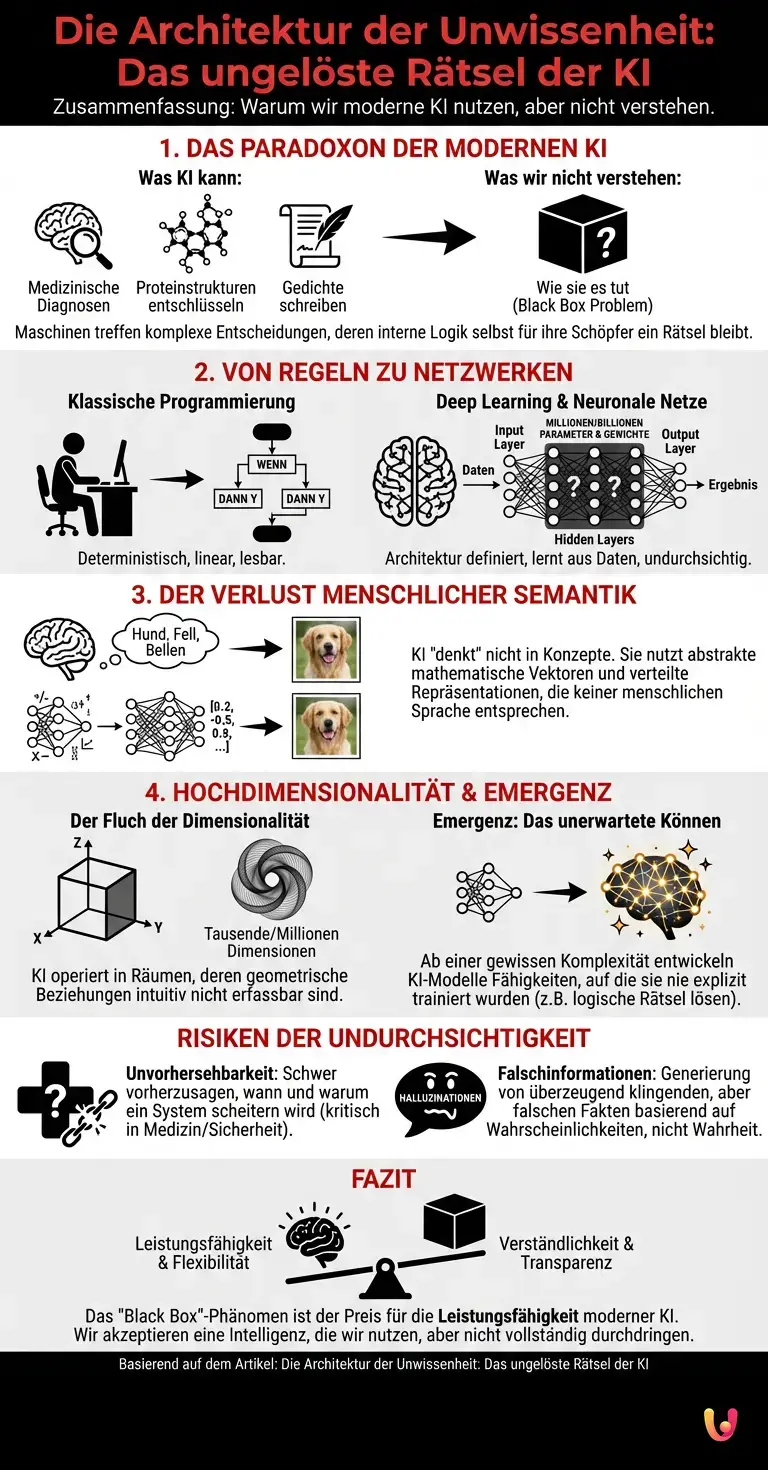

Es ist eines der größten Paradoxa der modernen Technologiegeschichte: Wir bauen Maschinen, die medizinische Diagnosen stellen, komplexe Proteinstrukturen entschlüsseln und Gedichte schreiben, doch wir können nicht erklären, wie sie das tun. Wenn eine Künstliche Intelligenz (KI) eine Entscheidung trifft, stehen selbst ihre Schöpfer oft vor einem Rätsel. Man könnte annehmen, dass der Programmierer, der den Code geschrieben hat, jeden Schritt der Logik nachvollziehen kann. Doch im Zeitalter von Deep Learning und Generative AI ist dies ein Trugschluss. Wir haben Systeme erschaffen, deren interne Denkprozesse uns zunehmend fremd werden. Dieses Phänomen, bekannt als das „Black Box“-Problem, ist keine Fehlfunktion, sondern ein inhärentes Merkmal moderner KI-Architekturen. Um zu verstehen, warum das so ist, müssen wir tief in die mathematischen Abgründe der Neural Networks blicken.

Die Architektur der Unwissenheit

Um das Geheimnis der Black Box zu lüften, muss man zunächst verstehen, wie sich die Programmierung verändert hat. In der klassischen Softwareentwicklung schrieb ein Mensch explizite Regeln: „Wenn X passiert, dann tue Y“. Der Code war deterministisch und linear lesbar. Bei modernen Verfahren für Maschinelles Lernen, insbesondere beim Deep Learning, schreiben Ingenieure diese Regeln nicht mehr selbst. Stattdessen definieren sie eine Architektur – ein künstliches neuronales Netz – und füttern es mit Daten.

Stellen Sie sich das neuronale Netz als ein gigantisches Schalttafel-System vor, das aus Schichten von künstlichen Neuronen besteht. Es gibt eine Eingabeschicht (Input Layer), eine Ausgabeschicht (Output Layer) und dazwischen Dutzende oder Hunderte von „versteckten Schichten“ (Hidden Layers). Das „Wissen“ der KI ist nicht in lesbaren Datenbanken gespeichert, sondern in den Verbindungen zwischen diesen Neuronen. Jede Verbindung hat ein Gewicht – eine Zahl, die bestimmt, wie stark ein Signal von einem Neuron zum nächsten weitergegeben wird.

Während des Trainingsprozesses passt die AI diese Gewichte selbstständig an, um Fehler zu minimieren. Bei modernen LLM (Large Language Models) wie ChatGPT sprechen wir nicht von Tausenden, sondern von Billionen solcher Parameter. Kein Mensch hat diese Zahlen manuell eingetragen. Sie sind das Ergebnis eines automatisierten Optimierungsprozesses, der Muster in Daten findet, die für das menschliche Gehirn viel zu komplex oder zu subtil sind.

Der Verlust der menschlichen Semantik

Das Kernproblem der Intransparenz liegt in der Art und Weise, wie neuronale Netze Informationen repräsentieren. Wenn wir Menschen denken, nutzen wir Konzepte: „Hund“, „Fell“, „Bellen“. Wir können erklären: „Ich habe das Tier als Hund erkannt, weil es gebellt hat.“ Ein tiefes neuronales Netz „denkt“ nicht in diesen Kategorien. Es zerlegt Daten in abstrakte mathematische Vektoren.

In den tieferen Schichten eines Netzwerks werden Merkmale extrahiert, die keiner menschlichen Sprache entsprechen. Ein einzelnes Neuron könnte nicht auf „Hundeohren“ reagieren, sondern auf eine spezifische Krümmung einer Linie in Kombination mit einer bestimmten Textur und einem Farbgradienten, für die wir kein Wort haben. Diese Repräsentation ist „verteilt“. Das Konzept „Hund“ liegt nicht an einem Ort im Speicher, sondern ist über Millionen von Gewichten verstreut. Wenn man die „Motorhaube“ der KI öffnet, sieht man keinen lesbaren Code, der Entscheidungsbäume zeigt, sondern endlose Matrizen aus Gleitkommazahlen. Es ist, als würde man versuchen, die Handlung eines Romans zu verstehen, indem man die chemische Zusammensetzung der Tinte auf dem Papier analysiert.

Der Fluch der Dimensionalität

Ein weiterer technischer Aspekt, der das Verständnis erschwert, ist die sogenannte Hochdimensionalität. Wir Menschen leben in einer dreidimensionalen Welt und können uns vielleicht noch die Zeit als vierte Dimension vorstellen. Die Vektorräume, in denen Generative AI operiert, haben jedoch Tausende oder Millionen von Dimensionen.

In diesem hochdimensionalen Raum werden Beziehungen zwischen Datenpunkten hergestellt, die geometrisch Sinn ergeben, aber intuitiv nicht erfassbar sind. Wenn ein LLM das nächste Wort in einem Satz vorhersagt, navigiert es durch diesen Raum basierend auf Wahrscheinlichkeiten, die durch Milliarden von Textfragmenten geformt wurden. Die KI findet Korrelationen, die für uns unsichtbar sind. Warum hat das Modell an dieser Stelle das Wort „türkis“ statt „blau“ gewählt? Die Antwort liegt in einer komplexen Interaktion von Tausenden von Parametern, die in einem 10.000-dimensionalen Raum eine winzige Wahrscheinlichkeitsverschiebung verursacht haben. Selbst wenn wir den mathematischen Pfad zurückverfolgen, fehlt uns die kognitive Kapazität, um die „Bedeutung“ dieses Pfades zu interpretieren.

Emergenz: Wenn das Ganze klüger ist als seine Teile

Ein besonders faszinierendes und zugleich beunruhigendes Phänomen im Jahr 2026 ist die Emergenz. Ab einer gewissen Größe und Komplexität zeigen Neural Networks Fähigkeiten, auf die sie nie explizit trainiert wurden. Ein Modell, das darauf trainiert wurde, das nächste Wort in einem Text vorherzusagen, lernt plötzlich, logische Rätsel zu lösen oder Programmcode zu debuggen, ohne dass dies jemals als explizites Ziel definiert war.

Diese emergenten Fähigkeiten sind ein direktes Resultat der Black Box. Da die Entwickler nur den Lernalgorithmus und die Datenstruktur vorgeben, aber nicht das gelernte Wissen selbst, werden sie oft von den Fähigkeiten ihrer eigenen Schöpfung überrascht. Die KI hat im „Dunkeln“ ihrer versteckten Schichten interne Heuristiken entwickelt, um das Trainingsziel zu erreichen – Heuristiken, die wir weder vorhergesehen haben noch vollständig verstehen. Dies führt zu Situationen, in denen KI-Systeme Lösungen für wissenschaftliche Probleme finden, die zwar korrekt sind, deren Herleitungsweg aber selbst für Experten undurchschaubar bleibt.

Das Risiko der Unvorhersehbarkeit

Die technische Natur der Black Box hat reale Konsequenzen. Wenn wir nicht wissen, wie eine KI zu einem Ergebnis kommt, können wir schwer vorhersagen, wann sie scheitern wird. Dies ist besonders kritisch bei sicherheitsrelevanten Anwendungen oder in der Medizin. Ein Bilderkennungssystem könnte einen Tumor mit 99%iger Genauigkeit erkennen, aber vielleicht basiert diese Entscheidung nicht auf der Zellstruktur, sondern auf einem Artefakt am Bildrand, das zufällig in den Trainingsdaten mit kranken Patienten korrelierte. Ohne Einblick in die „Gedanken“ der KI (Explainable AI oder XAI) bleibt dies ein Risiko.

Auch das Phänomen der „Halluzinationen“ bei ChatGPT und ähnlichen Modellen entspringt dieser Undurchsichtigkeit. Da das Modell keine Fakten speichert, sondern Wahrscheinlichkeiten von Wortfolgen berechnet, kann es mit absoluter Überzeugung falsche Informationen generieren. Für das neuronale Netz ist die falsche Antwort mathematisch genauso valide wie die richtige, solange sie den statistischen Mustern der Sprache entspricht.

Kurz gesagt (TL;DR)

Moderne KI-Systeme treffen komplexe Entscheidungen, deren interne Prozesse aufgrund der Black-Box-Architektur selbst für Experten oft unerklärlich bleiben.

Das Wissen dieser neuronalen Netze speichert sich nicht in lesbarem Code, sondern in Milliarden abstrakter und verteilter Parameterbindungen.

Wegen der hochdimensionalen Datenverarbeitung fehlt uns die kognitive Kapazität, die rein mathematischen Lösungswege der künstlichen Intelligenz intuitiv zu erfassen.

Fazit

Das „Black Box“-Phänomen ist der Preis, den wir für die Leistungsfähigkeit moderner Künstlicher Intelligenz zahlen. Wir haben die starren, verständlichen Regeln der klassischen Programmierung gegen die flexible, aber undurchsichtige Intuition neuronaler Netze eingetauscht. Dass selbst die Erfinder oft nicht wissen, wie ihre KI zur Lösung kam, liegt nicht an mangelnder Kompetenz, sondern an der fundamentalen Natur des Deep Learning: Wir bauen nicht den Verstand, wir bauen nur das Gehirn – das Lernen geschieht ohne uns. Während wir im Jahr 2026 Fortschritte im Bereich der „Explainable AI“ machen, bleibt ein Teil der maschinellen Intelligenz im Dunkeln verborgen. Vielleicht müssen wir akzeptieren, dass wir Intelligenz erschaffen können, ohne sie vollständig zu durchdringen.

Häufig gestellte Fragen

Das Black Box Phänomen beschreibt den Umstand, dass selbst Entwickler oft nicht nachvollziehen können, wie moderne KI-Systeme zu ihren Ergebnissen kommen. Anders als bei klassischer Software, die festen Regeln folgt, basieren Entscheidungen beim Deep Learning auf komplexen mathematischen Gewichtungen innerhalb verborgener Schichten, die für Menschen nicht intuitiv lesbar sind.

Dies liegt daran, dass beim maschinellen Lernen keine expliziten Wenn-Dann-Regeln mehr programmiert werden, sondern die KI ihre Parameter durch Training selbstständig optimiert. Das Wissen ist dabei nicht an einem zentralen Ort gespeichert, sondern über Billionen von Verbindungen in einem hochdimensionalen Raum verteilt, was eine Rückverfolgung einzelner Entscheidungspfade für das menschliche Gehirn unmöglich macht.

Während in der klassischen Entwicklung Menschen deterministische Regeln schreiben, definieren Ingenieure beim Deep Learning lediglich die Architektur eines neuronalen Netzes, das eigenständig aus Daten lernt. Statt linearer Logik nutzt die KI abstrakte Vektorräume und Wahrscheinlichkeiten, um Muster zu erkennen, die weit über menschliche Semantik und Begrifflichkeiten hinausgehen.

Emergenz bezeichnet das faszinierende Phänomen, dass KI-Modelle ab einer gewissen Komplexität Fähigkeiten entwickeln, auf die sie nie explizit trainiert wurden, wie etwa das Lösen logischer Rätsel. Diese neuen Kompetenzen entstehen durch interne Heuristiken in den verborgenen Schichten des Netzwerks, ohne dass die Entwickler diese Ziele vorgegeben haben.

Da der Entscheidungsweg verborgen bleibt, lassen sich Fehler oder das Scheitern des Systems schwer vorhersagen, was besonders in kritischen Bereichen wie der Medizin gefährlich ist. Zudem können sogenannte Halluzinationen auftreten, bei denen die KI falsche Informationen mit hoher Überzeugung generiert, weil diese lediglich statistisch plausibel erscheinen, aber nicht auf echten Fakten basieren.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.