In der digitalen Landschaft des Jahres 2026, in der künstliche Intelligenz und Large Language Models (LLM) zunehmend beeinflussen, wie Suchmaschinen Informationen verarbeiten, bleibt die Informationsarchitektur der Grundpfeiler für Websites mit hohem Traffic-Aufkommen. Für große Aggregatoren liegt die größte Herausforderung im Technischen SEO für Vergleichsportale: Management der Facettennavigation (Faceted Navigation). Dieser technische Leitfaden richtet sich an CTOs, SEO-Manager und Entwickler, die an Fintech-Portalen (wie dem Fallbeispiel MutuiperlaCasa.com) oder Immobilienportalen arbeiten, wo Millionen von Filterkombinationen zum schlimmsten Albtraum für das Crawl Budget werden können.

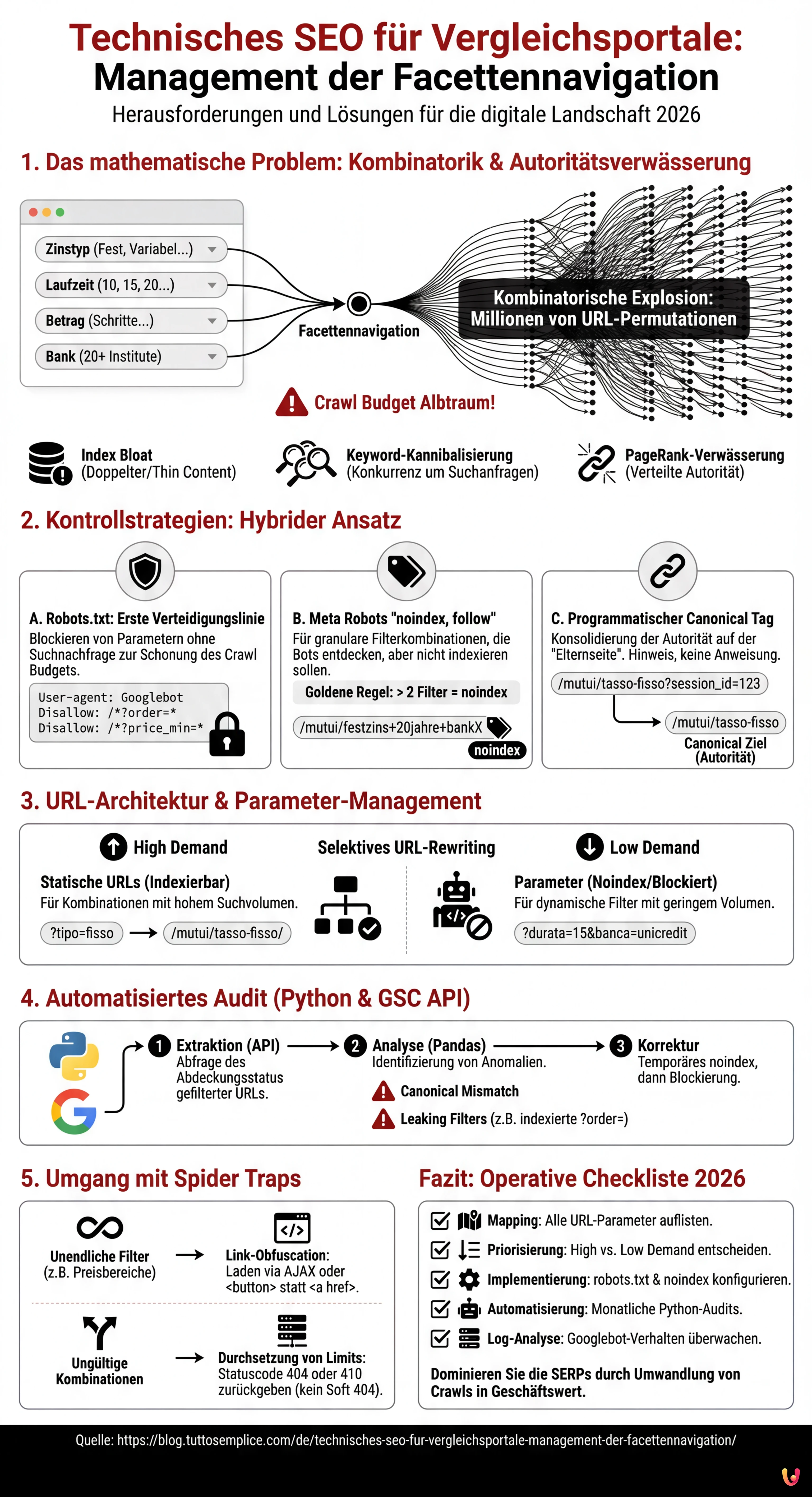

1. Das mathematische Problem: Kombinatorik und Autoritätsverwässerung

Die Facettennavigation ermöglicht es Benutzern, Ergebnisse basierend auf mehreren Attributen zu filtern. In einem Hypothekenportal könnte ein Benutzer Folgendes auswählen:

- Zinstyp: Fest, Variabel, Gemischt.

- Laufzeit: 10, 15, 20, 25, 30 Jahre.

- Betrag: Schritte von 5.000 €.

- Bank: 20+ Institute.

Mathematisch gesehen erzeugt dies eine kombinatorische Explosion. Wenn der Googlebot versuchen würde, jede mögliche URL-Permutation zu crawlen, die durch diese Filter generiert wird, würde das Crawl Budget durch das Scannen von Seiten mit geringem Wert (z. B. „Hypothek Mischzins, 13 Jahre, Bank X, Betrag 125.000 €“) aufgebraucht, wodurch Kernseiten mit hoher Conversion-Rate nicht im Index landen. Dieses Phänomen führt zu:

- Index Bloat: Der Google-Index füllt sich mit doppelten Inhalten oder „Thin Content“.

- Keyword-Kannibalisierung: Tausende von Seiten konkurrieren um dieselben Suchanfragen.

- PageRank-Verwässerung: Die Domain-Autorität wird auf nutzlose URLs verteilt.

2. Kontrollstrategien: Robots.txt, Noindex und Canonical

Es gibt keine Universallösung. Das richtige Management erfordert einen hybriden Ansatz, der auf der Priorisierung von Crawling und Indexierung basiert.

A. Die Robots.txt-Datei: Die erste Verteidigungslinie

Für Vergleichsportale ist die robots.txt unerlässlich, um Crawling-Ressourcen zu schonen. Es ist notwendig, Parameter zu blockieren, die keine Suchnachfrage (Search Demand) generieren oder Duplicate Content erzeugen.

Praxisbeispiel: In einem Hypothekenportal ändert die Sortierung (Preis aufsteigend/absteigend) nicht den Inhalt, sondern nur die Reihenfolge. Dies muss blockiert werden.

User-agent: Googlebot

Disallow: /*?order=*

Disallow: /*?price_min=*

Disallow: /*?price_max=*Hinweis: Das Blockieren via robots.txt verhindert das Crawling, entfernt die Seiten aber nicht zwangsläufig aus dem Index, wenn sie extern verlinkt sind. Es ist jedoch die effektivste Methode, um Crawl Budget zu sparen.

B. Meta Robots “noindex, follow”

Für Filterkombinationen, die der Googlebot entdecken soll (um Produktlinks zu folgen), die aber nicht indexiert werden sollen, verwenden wir das Tag noindex.

Goldene Regel: Wenden Sie noindex an, wenn der Benutzer mehr als 2 Filter gleichzeitig anwendet. Eine Seite „Hypotheken Festzins“ hat SEO-Wert. Eine Seite „Hypotheken Festzins + 20 Jahre + Intesa Sanpaolo“ ist wahrscheinlich zu granular und sollte aus dem Index ausgeschlossen werden.

C. Programmatischer Canonical Tag

Das Canonical-Tag ist ein Hinweis, keine Anweisung. In Vergleichsportalen muss es programmatisch verwaltet werden, um die Autorität auf der „Elternseite“ zu konsolidieren.

Wenn ein Benutzer auf /mutui/tasso-fisso?session_id=123 landet, muss der Canonical zwingend auf /mutui/tasso-fisso zeigen. Die übermäßige Verwendung des Canonicals auf sehr unterschiedlichen Seiten (z. B. Canonicalisierung einer gefilterten Seite auf die allgemeine Kategorie) kann jedoch von Google ignoriert werden, wenn der Inhalt zu stark abweicht.

3. URL-Architektur und Parameter-Management

Gemäß den Best Practices von Google Search Central ist die Verwendung von Standardparametern (?key=value) für die Facettennavigation oft simulierten statischen URLs (/wert1/wert2) vorzuziehen, da Google so die dynamische Struktur besser verstehen kann.

Die Logik von MutuiperlaCasa.com

In unserem operativen Szenario haben wir eine Logik des Selektiven URL-Rewritings implementiert:

- SEO-Landingpage (High Demand): Wir wandeln Parameter in statische URLs um.

Bsp:?tipo=fissowird zu/mutui/tasso-fisso/. Diese Seiten sind in der XML-Sitemap enthalten und indexierbar. - Dynamische Filter (Low Demand): Bleiben Parameter.

Bsp:?durata=15&banca=unicredit. Diese Seiten habennoindexoder werden je nach Volumen via robots.txt blockiert.

4. Automatisiertes Audit mit Python und GSC API

Millionen von URLs manuell zu verwalten ist unmöglich. Im Jahr 2026 ist die Verwendung von Python zur Abfrage der Google Search Console APIs ein Standard für Technical SEOs. Nachfolgend stellen wir ein Skript vor, um „Spider Traps“ und verwaiste Seiten zu identifizieren, die durch Filter verursacht werden.

Voraussetzungen

- Google Cloud Platform Konto mit aktivierter Search Console API.

- Python-Bibliotheken:

pandas,google-auth,google-searchconsole.

Das Analyseskript

Dieses Skript extrahiert den Abdeckungsstatus gefilterter URLs, um Anomalien zu identifizieren (z. B. Parameter, die blockiert sein sollten, aber indexiert werden).

import pandas as pd

import websearch_google_search_console as gsc

# Authentifizierung (durch eigene Anmeldedaten ersetzen)

account = gsc.authenticate(client_config='client_secrets.json')

webproperty = account['https://www.mutuiperlacasa.com/']

# 1. Extraktion der Abdeckungsdaten (Inspection API)

# Hinweis: Die API hat Quotenlimits, sparsam oder stichprobenartig verwenden

urls_to_check = [

'https://www.mutuiperlacasa.com/mutui?tasso=fisso&durata=30',

'https://www.mutuiperlacasa.com/mutui?tasso=variabile&order=asc',

# ... Liste verdächtiger URLs aus den Server-Logs

]

results = []

for url in urls_to_check:

try:

inspection = webproperty.inspect(url)

results.append({

'url': url,

'index_status': inspection.index_status_result.status,

'robots_txt_state': inspection.index_status_result.robots_txt_state,

'indexing_state': inspection.index_status_result.indexing_state,

'user_canonical': inspection.index_status_result.user_canonical,

'google_canonical': inspection.index_status_result.google_canonical

})

except Exception as e:

print(f"Fehler bei {url}: {e}")

# 2. Datenanalyse mit Pandas

df = pd.DataFrame(results)

# URLs identifizieren, bei denen Google einen anderen Canonical gewählt hat als deklariert

canonical_mismatch = df[df['user_canonical'] != df['google_canonical']]

print("Canonical Mismatch Found:")

print(canonical_mismatch)

# Indizierte URLs identifizieren, die blockiert werden sollten

leaking_filters = df[(df['url'].str.contains('order=')) & (df['index_status'] == 'INDEXED')]

print("Fälschlicherweise indexierte 'order'-Filter:")

print(leaking_filters)

Interpretation der Ergebnisse

Wenn das Skript erkennt, dass URLs mit order=asc den Status INDEXED haben, bedeutet dies, dass die Regeln der robots.txt nicht rückwirkend angewendet wurden oder dass es massive interne Links gibt, die auf diese Ressourcen verweisen. In diesem Fall ist die Korrekturmaßnahme die Implementierung eines temporären noindex-Tags, um sie zu entfernen, bevor sie erneut blockiert werden.

5. Umgang mit Spider Traps und Endlosschleifen

Eines der größten Risiken bei Vergleichsportalen ist die Generierung von Kalendern oder unendlichen Preisfiltern (z. B. /prezzo/100-200, /prezzo/101-201). Um dieses Problem zu lösen:

- Link-Obfuscation: Verwenden Sie Techniken wie das Laden von Filtern via AJAX oder

<button>-Schaltflächen (statt<a href>) für Filter, denen Bots nicht folgen sollen. Obwohl der Googlebot JavaScript ausführen kann, neigt er dazu, nicht mit Elementen zu interagieren, die nicht wie Standard-Navigationslinks aussehen, sofern er nicht dazu gezwungen wird. - Durchsetzung von Limits: Serverseitig muss eine URL, die ungültige Parameter oder unlogische Kombinationen enthält, einen Statuscode

404oder410zurückgeben, keine leere Seite mit Status200(Soft 404).

Fazit und operative Checkliste

Das Management der Facettennavigation für Vergleichsportale ist keine Aufgabe, die man einmal erledigt und dann vergisst. Es erfordert ständige Überwachung. Hier ist die definitive Checkliste für 2026:

- Mapping: Listen Sie alle vom CMS generierten URL-Parameter auf.

- Priorisierung: Entscheiden Sie, welche Kombinationen Suchvolumen haben (Index) und welche nicht (Noindex/Block).

- Implementierung: Konfigurieren Sie die

robots.txtzur Budgeteinsparung undnoindexzur Bereinigung des Index. - Automatisierung: Führen Sie monatliche Python-Skripte aus, um zu überprüfen, ob Google die Anweisungen respektiert.

- Log-Analyse: Analysieren Sie die Server-Logs, um zu sehen, wo der Googlebot seine Zeit verbringt. Wenn 40 % der Hits auf

?order=-Seiten entfallen, haben Sie ein Budgetproblem.

Durch die Anwendung dieser technischen Strategien können komplexe Portale wie MutuiperlaCasa.com die SERPs dominieren und sicherstellen, dass jeder Crawl des Googlebots in echten Geschäftswert umgewandelt wird.

Häufig gestellte Fragen

Die Facettennavigation erzeugt eine exponentielle Anzahl von URL-Kombinationen, was oft zur Erschöpfung des Crawl Budgets und zum Phänomen des «Index Bloat» führt. Dies hindert Google daran, wichtige Seiten mit hoher Conversion-Rate zu crawlen, verwässert den PageRank auf nutzlose Ressourcen und erzeugt Keyword-Kannibalisierung zwischen tausenden ähnlicher Seiten.

Das optimale Management erfordert einen hybriden Ansatz: Die robots.txt-Datei muss Parameter blockieren, die keine Suchnachfrage generieren, wie die Sortierung nach Preis, um Crawling-Ressourcen zu sparen. Das Meta-Tag noindex hingegen sollte auf Seiten angewendet werden, die wir Bots entdecken lassen wollen, um Links zu folgen, die aber zu granular sind, um indexiert zu werden, wie solche mit mehr als zwei aktiven Filtern.

Das hängt vom Suchvolumen ab. Die beste Strategie ist das selektive URL-Rewriting: Kombinationen mit hoher Nachfrage (High Demand) müssen in statische URLs umgewandelt und in die Sitemap aufgenommen werden, um das Ranking zu maximieren. Filter mit geringer Nachfrage (Low Demand) sollten als Standardparameter (?key=value) verbleiben und mit noindex verwaltet oder blockiert werden, um keine Autorität zu verlieren.

Um zu verhindern, dass der Googlebot in Endlosschleifen wie unbegrenzten Preisfiltern oder Kalendern gefangen bleibt, ist es entscheidend, Link-Obfuscation zu verwenden. Es wird empfohlen, diese Filter über AJAX zu laden oder Button-Elemente anstelle der klassischen a-href-Tags zu verwenden. Zudem muss der Server Statuscodes 404 oder 410 für unlogische Parameterkombinationen zurückgeben.

Um große Mengen an URLs zu verwalten, ist es notwendig, Python-Skripte zu verwenden, die die APIs der Google Search Console abfragen. Dies ermöglicht es, den Abdeckungsstatus programmatisch zu extrahieren, Diskrepanzen zwischen dem deklarierten Canonical und dem von Google gewählten zu identifizieren und Parameter zu erkennen, die trotz Blockierregeln fälschlicherweise indexiert werden.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.