En Breve (TL;DR)

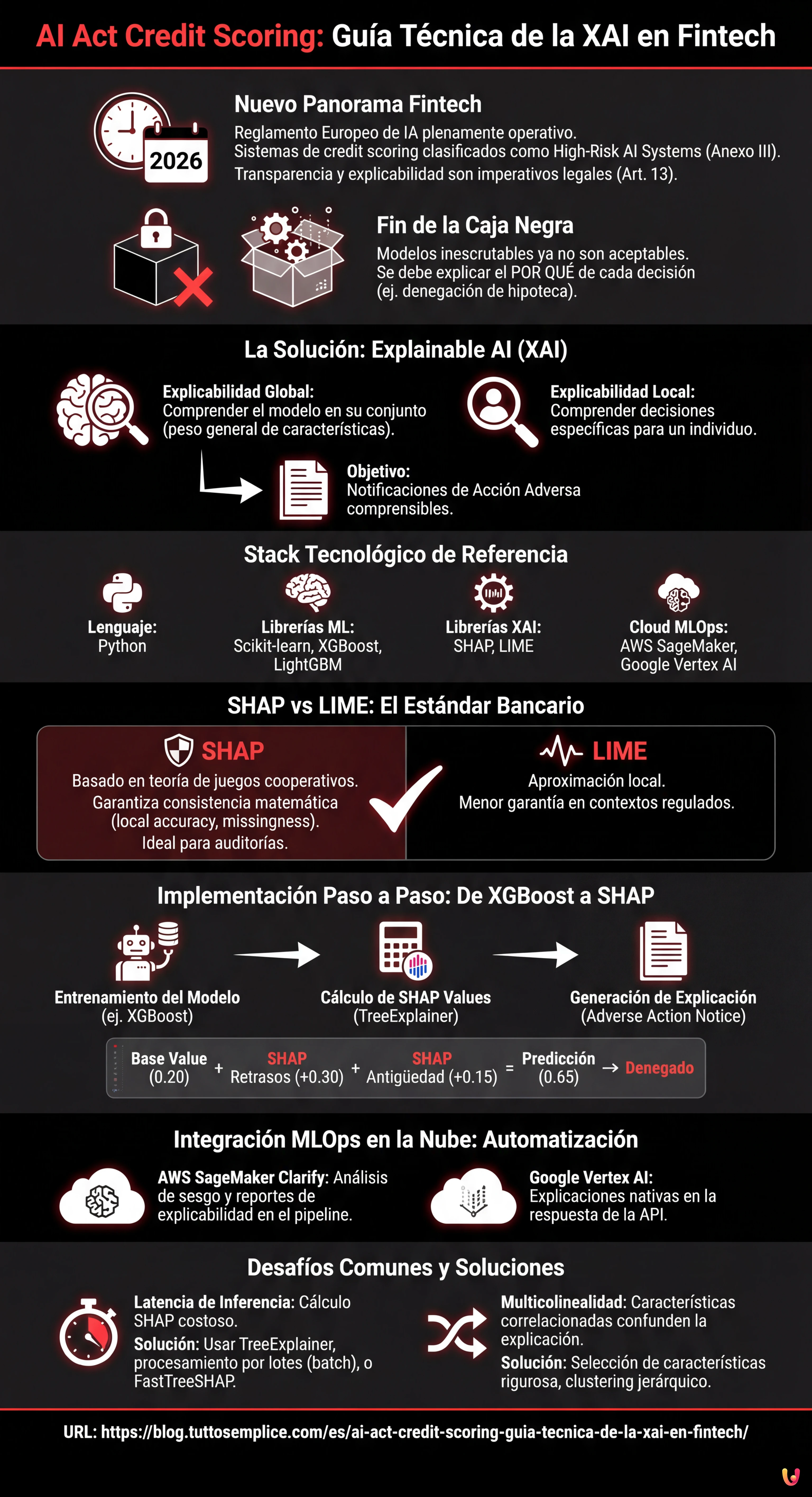

El Reglamento Europeo de Inteligencia Artificial clasifica el credit scoring como sistema de alto riesgo, imponiendo obligaciones rigurosas de transparencia y explicabilidad.

Los Data Scientists deben abandonar los modelos black-box adoptando librerías de Explainable AI como SHAP para garantizar decisiones interpretables y matemáticamente consistentes.

La integración de herramientas como AWS SageMaker Clarify en los pipelines MLOps permite automatizar el cumplimiento normativo monitorizando sesgos y explicabilidad en producción.

El diablo está en los detalles. 👇 Sigue leyendo para descubrir los pasos críticos y los consejos prácticos para no equivocarte.

Estamos en 2026 y el panorama del Fintech europeo ha cambiado radicalmente. Con la plena operatividad del Reglamento Europeo de Inteligencia Artificial, la adaptación de los sistemas de ai act credit scoring ya no es un diferencial competitivo, sino un imperativo legal. Los sistemas de evaluación de la solvencia crediticia se clasifican como High-Risk AI Systems (Sistemas de Alto Riesgo) según el Anexo III de la AI Act. Esto impone obligaciones rigurosas en términos de transparencia y explicabilidad (Artículo 13).

Para los CTO, los Data Scientists y los ingenieros de MLOps, esto significa el fin de los modelos “caja negra” inescrutables. Ya no basta con que un modelo XGBoost o una Red Neuronal tengan un AUC (Area Under Curve) de 0.95; deben ser capaces de explicar por qué se ha denegado una hipoteca a un cliente específico. Esta guía técnica explora la implementación de la Explainable AI (XAI) en los pipelines de producción, cerrando la brecha entre el cumplimiento normativo y la ingeniería de software.

El Requisito de Transparencia en la AI Act para el Fintech

La AI Act establece que los sistemas de alto riesgo deben diseñarse de modo que su funcionamiento sea lo suficientemente transparente para permitir a los usuarios interpretar la salida del sistema. En el contexto del credit scoring, esto se traduce en dos niveles de explicabilidad:

- Explicabilidad Global: Comprender cómo funciona el modelo en su conjunto (qué características tienen más peso en general).

- Explicabilidad Local: Comprender por qué el modelo ha tomado una decisión específica para un individuo (ej. “La hipoteca ha sido denegada porque la relación deuda/ingresos supera el 40%”).

El objetivo técnico es transformar vectores matemáticos complejos en notificaciones de acción adversa (Adverse Action Notices) comprensibles y legalmente defendibles.

Prerrequisitos y Stack Tecnológico

Para seguir esta guía de implementación, se presupone el conocimiento de Python y de los principios básicos de Machine Learning. El stack de referencia incluye:

- Librerías ML: Scikit-learn, XGBoost o LightGBM (estándar de facto para datos tabulares en credit scoring).

- Librerías XAI: SHAP (SHapley Additive exPlanations) y LIME.

- Cloud Provider: AWS SageMaker o Google Vertex AI (para la orquestación MLOps).

Abandonar la Caja Negra: SHAP vs LIME

Aunque existen modelos intrínsecamente interpretables (como las regresiones logísticas o los Decision Trees poco profundos), a menudo sacrifican la precisión predictiva. La solución moderna es el uso de modelos complejos (ensemble methods) combinados con métodos de interpretación model-agnostic.

Por qué elegir SHAP para el Credit Scoring

Entre las diversas opciones, SHAP se ha convertido en el estándar industrial para el sector bancario. A diferencia de LIME, que aproxima el modelo localmente, SHAP se basa en la teoría de juegos cooperativos y garantiza tres propiedades matemáticas fundamentales: local accuracy, missingness y consistency. En un contexto regulado como el del ai act credit scoring, la consistencia matemática de SHAP ofrece una mayor garantía en caso de auditoría.

Implementación Paso a Paso: De XGBoost a SHAP

A continuación, un ejemplo práctico de cómo integrar SHAP en un modelo de scoring de riesgo.

1. Entrenamiento del Modelo

Supongamos que hemos entrenado un clasificador XGBoost en un dataset de solicitudes de préstamo.

import xgboost as xgb

import shap

import pandas as pd

# Carga de datos y entrenamiento (simplificado)

X, y = shap.datasets.adult() # Dataset de ejemplo

model = xgb.XGBClassifier().fit(X, y)2. Cálculo de los SHAP Values

En lugar de limitarnos a la predicción, calculamos los valores de Shapley para cada instancia. Estos valores indican cuánto ha contribuido cada característica a desplazar la predicción respecto a la media del dataset (base value).

# Inicialización del explainer

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X)

# Ejemplo: Explicación para el cliente ID 0

print(f"Base Value: {explainer.expected_value}")

print(f"SHAP Values Cliente 0: {shap_values[0]}")Si el Base Value (probabilidad media de impago) es 0.20 y la predicción para el cliente es 0.65, los valores SHAP nos dirán exactamente qué variables han añadido ese +0.45 de riesgo (ej. +0.30 por retrasos pasados, +0.15 por baja antigüedad laboral).

Integración MLOps en la Nube: Automatizar el Cumplimiento

Ejecutar SHAP en un notebook es sencillo, pero la AI Act requiere monitorización continua y procesos escalables. Así es como se integra la XAI en pipelines en la nube.

AWS SageMaker Clarify

AWS ofrece SageMaker Clarify, un servicio nativo que se integra en el ciclo de vida del modelo. Para configurarlo:

- Configuración del Procesador: Durante la definición del training job, se configura un

SageMakerClarifyProcessor. - Análisis del Sesgo: Clarify calcula métricas de sesgo pre-training (ej. desequilibrios de clase) y post-training (ej. disparidad de precisión entre grupos demográficos), esencial para la equidad requerida por la AI Act.

- Explainability Report: Se define una configuración SHAP (ej.

SHAPConfig) que genera automáticamente informes JSON para cada endpoint de inferencia.

Google Vertex AI Explainable AI

De manera similar, Vertex AI permite configurar la explanationSpec durante la carga del modelo. Google soporta nativamente Sampled Shapley e Integrated Gradients. La ventaja aquí es que la explicación se devuelve directamente en la respuesta de la API junto con la predicción, reduciendo la latencia.

Generación Automática de las “Adverse Action Notices”

El paso final es traducir los valores numéricos de SHAP a lenguaje natural para el cliente final, cumpliendo con la obligación de notificación.

Imaginemos una función Python que procesa la salida:

def generar_explicacion(shap_values, feature_names, threshold=0.1):

explicaciones = []

for value, name in zip(shap_values, feature_names):

if value > threshold: # Contribución positiva al riesgo

if name == "num_retrasos_pago":

explicaciones.append("La presencia de retrasos en los pagos recientes ha influido negativamente.")

elif name == "relacion_deuda_ingreso":

explicaciones.append("La relación entre tus deudas y tus ingresos es elevada.")

return explicacionesEsta capa de traducción semántica es lo que hace que el sistema cumpla con el artículo 13 de la AI Act, haciendo que el algoritmo sea transparente para el usuario no técnico.

Solución de Problemas y Desafíos Comunes

Al implementar sistemas de ai act credit scoring explicables, a menudo se encuentran obstáculos técnicos:

1. Latencia de Inferencia

El cálculo de los valores SHAP, especialmente el método exacto en árboles de decisión profundos, es computacionalmente costoso.

Solución: Utilizar TreeExplainer (optimizado para árboles) en lugar de KernelExplainer. En producción, calcular las explicaciones de forma asíncrona (batch processing) si no se requiere una respuesta en tiempo real inmediata al usuario, o utilizar versiones aproximadas como FastTreeSHAP.

2. Multicolinealidad

Si dos características están altamente correlacionadas (ej. “Ingreso Anual” e “Ingreso Mensual”), SHAP podría dividir la importancia entre las dos, haciendo que la explicación sea confusa.

Solución: Ejecutar una rigurosa Selección de Características (Feature Selection) y eliminación de características redundantes antes del entrenamiento. Utilizar técnicas de clustering jerárquico para agrupar características correlacionadas.

Conclusiones

La adaptación a la AI Act en el sector del credit scoring no es solo un ejercicio burocrático, sino un desafío de ingeniería que eleva la calidad del software financiero. Implementando arquitecturas basadas en XAI como SHAP e integrándolas en pipelines MLOps robustos en SageMaker o Vertex AI, las empresas Fintech pueden garantizar no solo el cumplimiento legal, sino también una mayor confianza por parte de los consumidores. La transparencia algorítmica es la nueva moneda del crédito digital.

Preguntas frecuentes

El reglamento AI clasifica los sistemas de evaluación de la solvencia crediticia como sistemas de alto riesgo según el Anexo III. Esta definición impone a las empresas Fintech obligaciones severas de transparencia y explicabilidad, obligando a abandonar los modelos de «caja negra». Ahora es necesario que los algoritmos proporcionen motivaciones comprensibles para cada decisión tomada, especialmente en caso de denegación de un préstamo.

La explicabilidad global permite entender el funcionamiento del modelo en su conjunto, identificando qué variables tienen más peso en general. La explicabilidad local, en cambio, es fundamental para el cumplimiento normativo ya que aclara por qué el modelo ha tomado una decisión específica para un solo cliente, permitiendo generar notificaciones precisas sobre las causas de un resultado negativo.

SHAP se ha convertido en el estándar industrial porque se basa en la teoría de juegos cooperativos y garantiza propiedades matemáticas como la consistencia, esencial en fase de auditoría. A diferencia de LIME que proporciona aproximaciones locales, SHAP calcula la contribución exacta de cada característica respecto a la media, ofreciendo una justificación del puntaje de crédito legalmente más sólida.

Para automatizar el cumplimiento es posible utilizar servicios gestionados como AWS SageMaker Clarify o Google Vertex AI. Estas herramientas se integran en el ciclo de vida del modelo para calcular métricas de sesgo y generar automáticamente informes de explicabilidad SHAP para cada inferencia, garantizando una monitorización continua sin intervención manual excesiva.

El cálculo de los valores SHAP puede ser computacionalmente costoso y ralentizar las respuestas. Para mitigar el problema se recomienda utilizar TreeExplainer que está optimizado para los árboles de decisión, o desplazar el cálculo a procesos asíncronos por lotes si no se necesita una respuesta inmediata. Otra solución eficaz es el uso de aproximaciones rápidas como FastTreeSHAP.

Fuentes y Profundización

- Texto oficial del Reglamento (UE) 2024/1689 (Ley de Inteligencia Artificial) en EUR-Lex

- Comisión Europea: Marco regulador sobre la Inteligencia Artificial

- Agencia Española de Protección de Datos (AEPD): Recursos y guías sobre Inteligencia Artificial

- Autoridad Bancaria Europea (EBA): Informe sobre Machine Learning en modelos de riesgo de crédito

- Wikipedia: Valor de Shapley (Fundamento matemático de SHAP)

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.