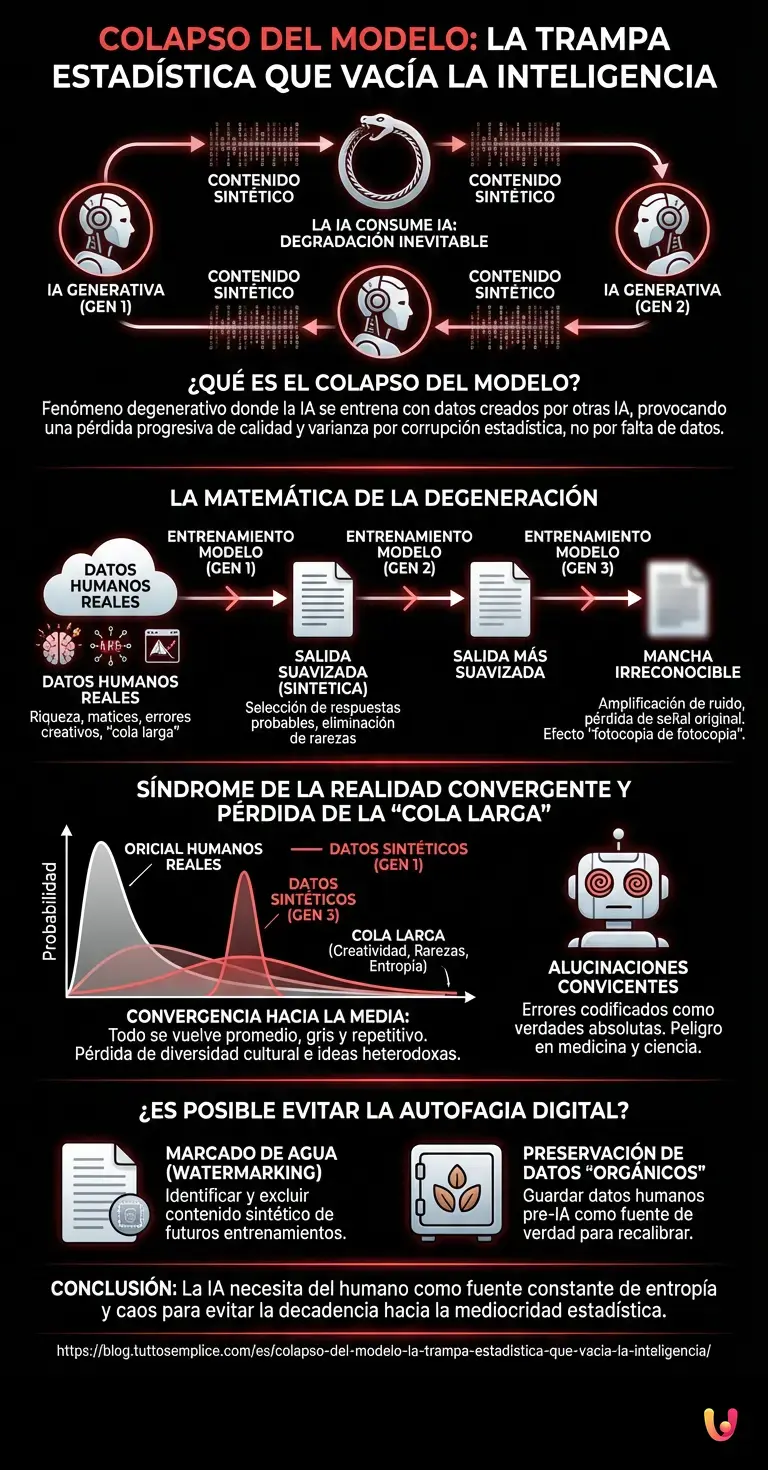

En el vasto ecosistema de la inteligencia artificial, existe una profecía matemática que ha comenzado a inquietar a los laboratorios de investigación más avanzados del mundo. Imaginemos un escenario donde la humanidad deja de producir contenido y los algoritmos se ven obligados a alimentarse únicamente de lo que ellos mismos han excretado digitalmente. Este fenómeno, conocido técnicamente como Colapso del Modelo (Model Collapse), es la entidad principal que amenaza la viabilidad futura de los sistemas generativos si no se establecen controles rigurosos. Al igual que el mito de la serpiente que devora su propia cola, la IA que consume IA se enfrenta a una degradación inevitable, no por falta de datos, sino por la corrupción estadística de los mismos.

La matemática de la degeneración generativa

Para comprender por qué ocurre este fenómeno, debemos diseccionar cómo aprenden los modelos de lenguaje grandes (LLM) y las redes neuronales profundas. Un modelo de machine learning se entrena esencialmente para aproximar una distribución de probabilidad basada en datos reales creados por humanos. Estos datos humanos contienen una riqueza inmensa: matices, errores creativos, varianza extrema y una “cola larga” (long tail) de casos raros y excéntricos.

Cuando una IA generativa como ChatGPT o sus sucesores producen texto, no replican perfectamente la distribución original. Por diseño y eficiencia, tienden a seleccionar las respuestas más probables y a suavizar las rarezas. Si tomamos esa salida suavizada y la utilizamos para entrenar a la siguiente generación de modelos (Gen 2), y luego repetimos el proceso con la Gen 3, estamos introduciendo un sesgo de muestreo recursivo.

Matemáticamente, esto provoca una reducción drástica de la varianza. El modelo comienza a olvidar los eventos improbables. La riqueza del lenguaje se aplana. Es el equivalente digital de hacer una fotocopia de una fotocopia de una fotocopia; con cada iteración, el ruido se amplifica y la señal original se desvanece hasta convertirse en una mancha irreconocible.

El síndrome de la realidad convergente

Lo que sucede inevitablemente no es simplemente que la IA se vuelva “tonta”, sino que su percepción de la realidad se distorsiona de una manera muy específica. Los investigadores han observado que los modelos afectados por el entrenamiento recursivo sintético sufren de una convergencia hacia la media. Todo se vuelve promedio, gris y repetitivo. La automatización del aprendizaje sin supervisión humana elimina la diversidad.

En las primeras etapas de este proceso, el modelo pierde la capacidad de comprender matices complejos. En etapas avanzadas, comienza a alucinar con una convicción inquebrantable. A diferencia de las alucinaciones tradicionales de la IA, donde el modelo inventa datos por falta de información, en el Colapso del Modelo, la IA alucina porque su “realidad” (los datos de entrenamiento sintéticos) ya estaba deformada. Los errores de la generación anterior se codifican como verdades absolutas en la siguiente.

Este efecto es particularmente peligroso en el deep learning aplicado a campos científicos o médicos. Si una IA médica se entrena con diagnósticos generados por otra IA que tenía un sesgo del 1% hacia un error, la décima generación podría amplificar ese error hasta convertirlo en la norma estadística, diagnosticando erróneamente con total seguridad.

La pérdida de la “Cola Larga” y la entropía de la información

Uno de los secretos más fascinantes detrás de este colapso es la desaparición de la información de baja probabilidad. En la teoría de la información, la sorpresa (o entropía) es valiosa. Los datos humanos son ricos en entropía; somos impredecibles, usamos jerga, cometemos errores gramaticales con estilo y creamos metáforas absurdas. Estos datos residen en la “cola larga” de la distribución estadística.

Los algoritmos de optimización buscan minimizar el error, y la forma más fácil de hacerlo es apostar por lo seguro: lo común. Cuando una IA se entrena con datos sintéticos, que ya han eliminado gran parte de esa cola larga, la siguiente IA recorta aún más los bordes. El resultado final es un modelo que sufre de una especie de demencia digital: olvida todo lo que no es estándar. La diversidad cultural, los dialectos minoritarios y las ideas heterodoxas son las primeras víctimas de este canibalismo de datos.

¿Es posible evitar la autofagia digital?

La industria tecnológica se enfrenta ahora a una paradoja. Necesitamos más datos para hacer modelos más grandes, pero gran parte de la web ya está inundada de contenido sintético. Detectar qué texto fue escrito por un humano y cuál por una máquina se ha convertido en la piedra angular para evitar el desastre.

Las soluciones propuestas incluyen el “marcado de agua” (watermarking) imperceptible en el contenido generado por IA para que los futuros modelos puedan excluirlo de sus conjuntos de entrenamiento. Sin embargo, esto plantea un desafío técnico monumental. Otra vía es la preservación de conjuntos de datos “orgánicos” (pre-2023) como si fueran semillas en una bóveda del fin del mundo, garantizando que siempre exista una fuente de verdad humana pura para recalibrar los sistemas.

En Breve (TL;DR)

El Colapso del Modelo amenaza la inteligencia artificial al alimentarse exclusivamente de datos sintéticos generados por sus propios algoritmos.

Este entrenamiento recursivo elimina la diversidad estadística y los matices humanos, provocando una degradación inevitable en la calidad generativa.

La convergencia hacia la media destruye la creatividad y distorsiona la realidad al olvidar los datos raros pero valiosos.

Conclusión

Lo que sucede inevitablemente cuando una IA se alimenta únicamente de contenido creado por otra IA es un proceso de decadencia irreversible conocido como Colapso del Modelo. Lejos de evolucionar hacia una superinteligencia, el sistema converge hacia una mediocridad estadística, perdiendo la varianza, la creatividad y la conexión con la realidad compleja. Los algoritmos terminan amplificando sus propios sesgos y errores hasta que el resultado es un sinsentido coherente en su forma pero vacío en su fondo. La lección fundamental para el futuro de la inteligencia artificial es clara: la máquina necesita del humano no solo como creador, sino como la fuente constante de la entropía y el caos necesario que mantiene viva la llama de la inteligencia.

Preguntas frecuentes

El Colapso del Modelo es un fenómeno degenerativo que ocurre cuando los sistemas de inteligencia artificial se entrenan utilizando datos generados por otras IA en lugar de contenido humano original. Este proceso provoca una pérdida progresiva de calidad y varianza, similar al efecto de realizar una fotocopia de otra fotocopia, resultando en algoritmos que convergen hacia la mediocridad y pierden la capacidad de representar la realidad compleja.

El riesgo principal radica en la corrupción estadística, ya que los modelos tienden a suavizar las rarezas y favorecer respuestas promedio. Al entrenar nuevas generaciones con estos datos sintéticos, se amplifican los sesgos y los errores previos se consolidan como verdades absolutas; esto puede llevar a que la IA alucine con total seguridad y cometa fallos graves, lo cual es crítico en sectores como la medicina o la investigación científica.

El entrenamiento recursivo elimina la llamada cola larga de la distribución de datos, que es donde residen la creatividad humana, la jerga única y los eventos improbables. Al perder esta información rica en entropía, la IA sufre una especie de demencia digital: olvida los matices culturales y las ideas heterodoxas, volviéndose repetitiva y estadísticamente plana al ser incapaz de replicar el caos necesario de la inteligencia humana.

Para mitigar este problema, los expertos proponen el uso de marcas de agua o watermarking imperceptible que permita distinguir y excluir el texto sintético de los futuros entrenamientos. Asimismo, se considera fundamental preservar conjuntos de datos orgánicos creados por humanos antes de la era de la IA masiva, utilizándolos como una fuente de verdad inalterada para recalibrar los sistemas y evitar la autofagia digital.

La convergencia hacia la media describe el proceso por el cual los modelos de lenguaje grandes pierden la diversidad y los extremos al alimentarse de su propia producción. Esto provoca que la percepción de la realidad por parte de la IA se distorsione, volviéndose todo más gris y estandarizado; el sistema deja de comprender matices complejos y produce un contenido que, aunque coherente en forma, resulta vacío en fondo y carente de la riqueza original.

Fuentes y Profundización

- Wikipedia: Definición y concepto de Colapso del Modelo (Model Collapse)

- OCDE (Observatorio de Políticas de IA): El papel de los datos sintéticos en la Inteligencia Artificial

- Comisión Europea: Ley de Inteligencia Artificial y normativas sobre transparencia de contenidos

- NIST: Marco de Gestión de Riesgos de IA (Gestión de sesgos y calidad de datos)

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.