En Breve (TL;DR)

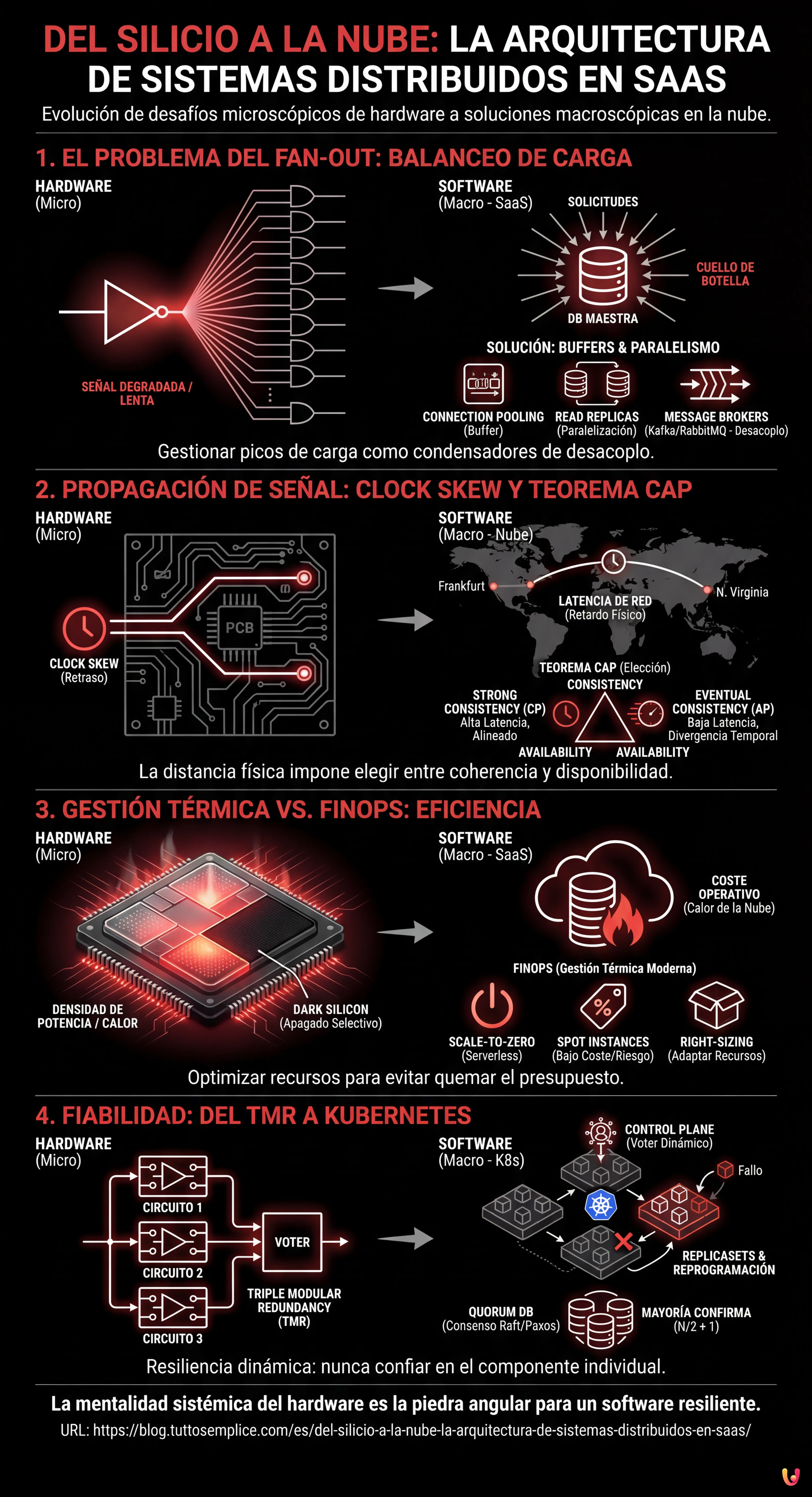

La arquitectura de los sistemas distribuidos en la nube refleja a escala macroscópica las leyes físicas fundamentales que gobiernan el diseño de los circuitos integrados.

Las limitaciones de hardware como el Fan-out y la propagación de la señal explican perfectamente los desafíos modernos de balanceo de carga y coherencia de datos.

La optimización térmica de los procesadores encuentra su equivalente en el FinOps, transformando la gestión energética del silicio en estrategias para reducir los costes de la nube.

El diablo está en los detalles. 👇 Sigue leyendo para descubrir los pasos críticos y los consejos prácticos para no equivocarte.

Estamos en 2026, y mientras la inteligencia artificial generativa ha reescrito las reglas de la interacción hombre-máquina, las leyes fundamentales de la física y la lógica permanecen inmutables. Para quien, como yo, comenzó su carrera con un soldador en la mano y el esquema de un circuito integrado (IC) sobre la mesa, el panorama actual del Cloud Computing no parece un mundo ajeno, sino una evolución a escala macroscópica de problemas que ya hemos resuelto a escala microscópica. En el centro de todo está la arquitectura de sistemas distribuidos: un concepto que hoy aplicamos a clústeres globales, pero que nace de las interconexiones entre transistores en una oblea de silicio.

En este ensayo técnico, exploraremos cómo la mentalidad sistémica necesaria para diseñar hardware fiable es la piedra angular para construir software resiliente. Analizaremos cómo las limitaciones físicas del silicio encuentran sus análogos perfectos en los desafíos inmateriales del SaaS moderno.

1. El Problema del Fan-out: De las Puertas Lógicas al Balanceo de Carga

En la ingeniería electrónica, el Fan-out define el número máximo de entradas lógicas que una salida puede pilotar de manera fiable. Si una puerta lógica intenta enviar una señal a demasiadas otras puertas, la corriente se divide excesivamente, la señal se degrada y la conmutación (0 a 1 o viceversa) se vuelve lenta o indefinida. Es un límite físico de capacidad de pilotaje.

El Análogo en el Software: El Cuello de Botella de la Base de Datos

En la arquitectura de sistemas distribuidos, el concepto de Fan-out se manifiesta brutalmente cuando un único servicio (ej. una base de datos maestra o un servicio de autenticación) es bombardeado por demasiadas solicitudes concurrentes desde los microservicios cliente. Al igual que un transistor no puede suministrar corriente infinita, una base de datos no tiene conexiones TCP o ciclos de CPU infinitos.

La solución hardware es la inserción de buffers para regenerar la señal y aumentar la capacidad de pilotaje. En el SaaS, aplicamos el mismo principio a través de:

- Connection Pooling: Que actúa como un buffer de corriente, manteniendo las conexiones activas y reutilizables.

- Read Replicas: Que paralelizan la carga de lectura, similar a la adición de etapas de amplificación en paralelo.

- Message Brokers (Kafka/RabbitMQ): Que desacoplan el productor del consumidor, gestionando los picos de carga (backpressure) exactamente como un condensador de desacoplo estabiliza la tensión durante los picos de absorción.

2. Propagación de la Señal: Clock Skew y Teorema CAP

En los circuitos de alta frecuencia, la velocidad de la luz (o mejor dicho, la velocidad de propagación de la señal en el cobre/oro) es una restricción tangible. Si una pista en el PCB es más larga que otra, la señal llega con retraso, causando problemas de sincronización conocidos como Clock Skew. El sistema se vuelve incoherente porque diferentes partes del chip ven la “realidad” en momentos diferentes.

La Tiranía de la Distancia en la Nube

En la nube, la latencia de red es el nuevo retardo de propagación. Cuando diseñamos una arquitectura de sistemas distribuidos georredundante, no podemos ignorar que la luz tarda tiempo en viajar desde Frankfurt hasta el Norte de Virginia. Este retraso físico es la raíz del Teorema CAP (Consistency, Availability, Partition tolerance).

Un ingeniero electrónico sabe que no puede tener una señal perfectamente síncrona en un chip enorme sin ralentizar el reloj (sacrificando el rendimiento por la coherencia). Del mismo modo, un arquitecto de software debe elegir entre:

- Strong Consistency (CP): Esperar a que todos los nodos estén alineados (como un reloj global lento), aceptando una latencia elevada.

- Eventual Consistency (AP): Permitir que los nodos diverjan temporalmente para mantener una alta disponibilidad y baja latencia, gestionando los conflictos a posteriori (similar a circuitos asíncronos o self-timed).

3. Gestión Térmica vs. FinOps: La Eficiencia como Restricción

La densidad de potencia es el enemigo número uno en los procesadores modernos. Si no se disipa el calor, el chip entra en thermal throttling (se ralentiza) o se quema. El diseño VLSI (Very Large Scale Integration) moderno gira en torno al concepto de “Dark Silicon”: no podemos encender todos los transistores simultáneamente porque el chip se fundiría. Debemos encender solo lo que se necesita, cuando se necesita.

El Coste es el Calor de la Nube

En el modelo SaaS, el “calor” es el coste operativo. Una arquitectura ineficiente no funde los servidores (de eso se encarga el proveedor de la nube), pero quema el presupuesto de la empresa. El FinOps es la gestión térmica moderna.

Al igual que un ingeniero de hardware utiliza el Clock Gating para apagar las partes del chip no utilizadas, un Cloud Architect debe implementar:

- Scale-to-Zero: Utilizando tecnologías Serverless (como AWS Lambda o Google Cloud Run) para apagar completamente los recursos cuando no hay tráfico.

- Spot Instances: Aprovechar la capacidad excedente a bajo coste, aceptando el riesgo de interrupción, similar al uso de componentes con tolerancias más amplias en circuitos no críticos.

- Right-sizing: Adaptar los recursos a la carga real, evitando el sobreaprovisionamiento (over-provisioning) que en el mundo del hardware equivaldría a usar un disipador de 1kg para un chip de 5W.

4. Fiabilidad: Del TMR a los Clústeres de Kubernetes

En los sistemas de aviónica o espaciales, donde la reparación es imposible y la radiación puede invertir aleatoriamente un bit (Single Event Upset), se utiliza la Triple Modular Redundancy (TMR). Tres circuitos idénticos realizan el mismo cálculo y un circuito de votación (voter) decide la salida basándose en la mayoría. Si uno falla, el sistema continúa funcionando.

La Orquestación de la Resiliencia

Esta es la esencia exacta de un clúster de Kubernetes o de una base de datos distribuida con consenso Raft/Paxos. En una arquitectura de sistemas distribuidos moderna:

- ReplicaSets: Mantienen múltiples copias (Pod) del mismo servicio. Si un nodo cae (fallo de hardware), el Control Plane (el “voter”) se da cuenta y reprograma el pod en otro lugar.

- Quorum en las Bases de Datos: Para confirmar una escritura en un clúster (ej. Cassandra o etcd), requerimos que la mayoría de los nodos (N/2 + 1) confirme la operación. Esto es matemáticamente idéntico a la lógica de votación del TMR hardware.

La diferencia sustancial es que en el hardware la redundancia es estática (cableada), mientras que en el software es dinámica y reconfigurable. Sin embargo, el principio básico permanece: nunca confiar en el componente individual.

Conclusiones: El Enfoque Sistémico Unificado

Pasar del silicio a la nube no significa cambiar de profesión, sino cambiar de escala. El diseño de una arquitectura de sistemas distribuidos eficaz requiere la misma disciplina necesaria para el tape-out de un microprocesador:

- Comprender las limitaciones físicas (ancho de banda, latencia, coste/calor).

- Diseñar para el fallo (el componente se romperá, el paquete se perderá).

- Desacoplar los sistemas para evitar la propagación de errores.

En 2026, las herramientas se han vuelto increíblemente abstractas. Escribimos YAML que describen infraestructuras efímeras. Pero bajo esos niveles de abstracción, todavía hay electrones que corren, relojes que hacen tictac y buffers que se llenan. Mantener la conciencia de esta realidad física es lo que distingue a un buen desarrollador de un verdadero Arquitecto de Sistemas.

Preguntas frecuentes

La arquitectura en la nube se considera una evolución a escala macroscópica de los desafíos microscópicos típicos de los circuitos integrados. Problemas físicos como la gestión del calor y la propagación de la señal en el silicio encuentran una correspondencia directa en la gestión de costes y en la latencia de red del software, requiriendo una mentalidad sistémica similar para garantizar resiliencia y eficiencia operativa.

El Fan-out en el software se manifiesta cuando un único servicio, como una base de datos maestra, recibe un número excesivo de solicitudes concurrentes, análogamente a una puerta lógica que pilota demasiadas entradas. Para mitigar este cuello de botella, se adoptan soluciones como el connection pooling, las réplicas de lectura y los message brokers, que actúan como buffers para estabilizar la carga y prevenir el degrado del rendimiento.

La latencia de red, comparable al retardo de propagación de la señal en los circuitos electrónicos, impide la sincronización instantánea entre nodos geográficamente distantes. Esta restricción física obliga a los arquitectos de software a elegir entre Strong Consistency, aceptando latencias mayores para esperar la alineación de los nodos, o Eventual Consistency, que privilegia la disponibilidad tolerando desalineaciones temporales de los datos.

En el modelo SaaS, el coste operativo representa el equivalente al calor generado en los procesadores: ambos son factores limitantes que deben ser controlados. Las estrategias FinOps como el Scale-to-Zero y el Right-sizing reflejan técnicas de hardware como el Clock Gating, apagando o redimensionando los recursos no utilizados para optimizar la eficiencia e impedir que el presupuesto se consuma inútilmente.

Los clústeres de Kubernetes aplican de forma dinámica los principios de la Triple Modular Redundancy utilizada en los sistemas críticos de hardware. A través del uso de ReplicaSets y algoritmos de consenso para las bases de datos distribuidas, el sistema monitoriza constantemente el estado de los servicios y sustituye los nodos fallidos basándose en mecanismos de votación y mayoría, asegurando la continuidad operativa sin puntos únicos de fallo.

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.