En el panorama actual de 2026, donde las transacciones financieras ocurren en microsegundos y la confianza del usuario es la moneda más valiosa, el concepto de disaster recovery cloud ha trascendido la simple idea de «backup». Para plataformas de alto tráfico y criticidad como MutuiperlaCasa.com, la resiliencia no es solo una especificación técnica, sino el fundamento mismo del negocio. Cuando gestionamos solicitudes de presupuestos de hipotecas en tiempo real, interactuando con múltiples instituciones bancarias, un tiempo de inactividad no planificado no solo conlleva una pérdida económica, sino un daño reputacional incalculable. Esta guía técnica explora cómo diseñar arquitecturas Multi-Region Active-Active, garantizando la continuidad operativa y la consistencia de los datos en un entorno híbrido.

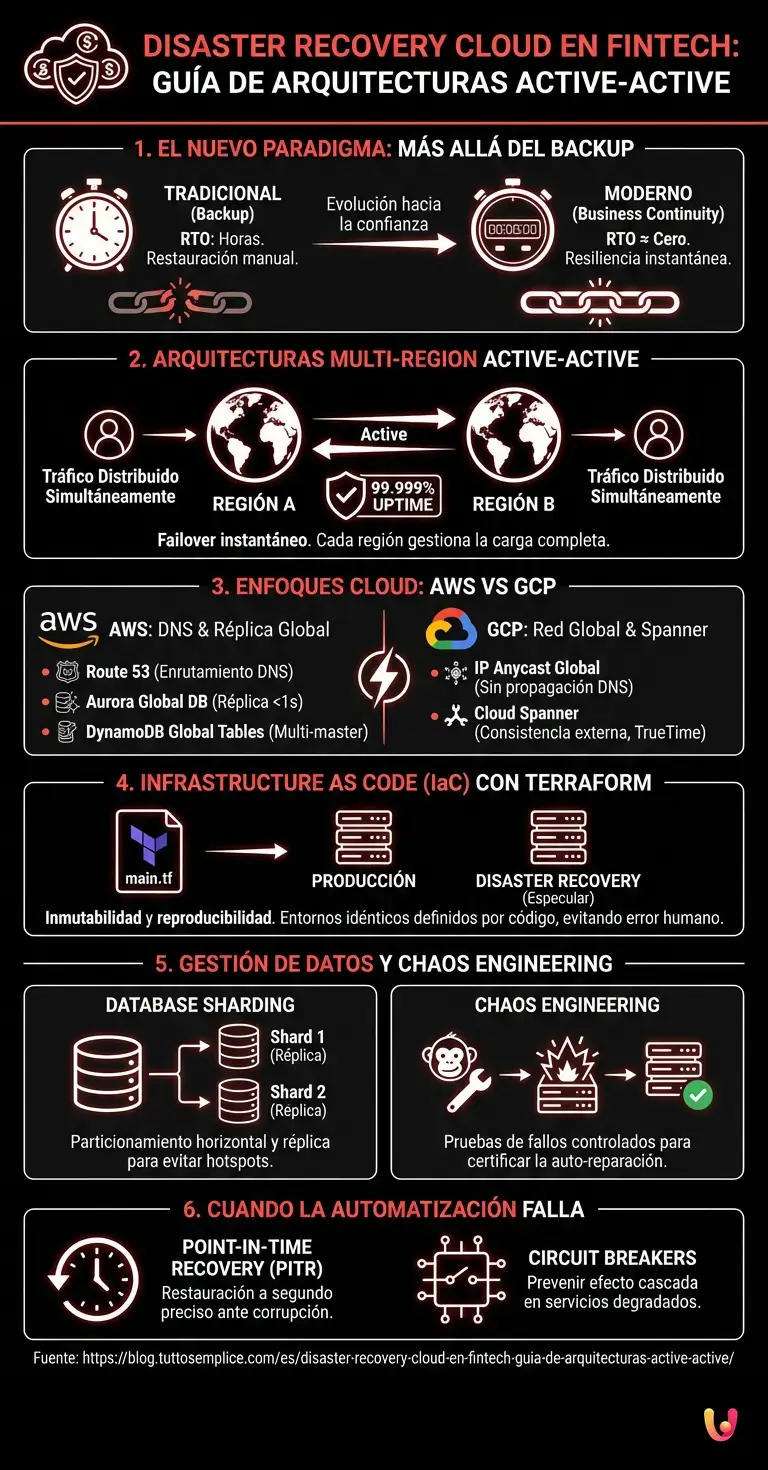

1. El Paradigma de la Resiliencia: Más allá del Backup Tradicional

La diferencia entre una empresa que sobrevive a un incidente catastrófico y una que fracasa reside en el paso del concepto de RTO (Recovery Time Objective) medido en horas, a un RTO próximo a cero. En el sector crediticio, el objetivo es la Business Continuity transparente.

Según el Teorema CAP (Consistency, Availability, Partition tolerance), un sistema distribuido no puede garantizar simultáneamente las tres propiedades. Sin embargo, las arquitecturas cloud modernas nos permiten acercarnos asintóticamente a este ideal. El desafío principal para plataformas como MutuiperlaCasa.com es equilibrar la consistencia fuerte de los datos transaccionales (esencial para evitar que una solicitud de hipoteca se duplique o se pierda) con la alta disponibilidad necesaria durante los picos de tráfico estacionales.

2. Arquitecturas Multi-Region Active-Active: AWS vs GCP

Para garantizar un uptime del 99.999% (los famosos «cinco nueves»), una estrategia Single-Region no es suficiente. Es necesario implementar una arquitectura Active-Active, donde el tráfico se distribuye simultáneamente en múltiples regiones geográficas y cada región es capaz de gestionar la carga completa en caso de conmutación por error (failover).

El Enfoque Amazon Web Services (AWS)

En el entorno AWS, la estrategia se basa en la combinación de servicios globales:

- Amazon Route 53: Utilizado para el enrutamiento basado en la latencia o la geolocalización, con comprobaciones de estado (health checks) agresivas para desviar el tráfico instantáneamente en caso de fallo en una región.

- Amazon Aurora Global Database: Para los datos relacionales, Aurora permite una réplica física del almacenamiento a través de las regiones con una latencia típica inferior al segundo. En un escenario de disaster recovery cloud, la promoción de una región secundaria a primaria ocurre en menos de un minuto.

- DynamoDB Global Tables: Para los datos de sesión y las preferencias del usuario, DynamoDB ofrece una réplica multi-master real, permitiendo escrituras en cualquier región con resolución automática de conflictos.

El Enfoque Google Cloud Platform (GCP)

GCP ofrece una ventaja arquitectónica nativa gracias a su red global de fibra óptica:

- Cloud Load Balancing: A diferencia de AWS que usa DNS, GCP utiliza una única dirección IP Anycast global. Esto permite mover el tráfico entre regiones instantáneamente sin esperar la propagación DNS, reduciendo drásticamente el RTO.

- Cloud Spanner: Es la joya de la corona para el FinTech. Spanner es una base de datos relacional distribuida globalmente que ofrece consistencia externa (gracias a los relojes atómicos TrueTime), combinando la semántica SQL con la escalabilidad horizontal NoSQL. Para una plataforma de crédito, esto elimina la complejidad de la gestión de la réplica asíncrona.

3. Infrastructure as Code (IaC): La Inmutabilidad con Terraform

No existe resiliencia sin reproducibilidad. La gestión manual de los recursos de disaster recovery es propensa al error humano. El uso de Terraform nos permite definir toda la infraestructura como código, garantizando que el entorno de DR sea especular al de producción.

Aquí un ejemplo conceptual de cómo definir una réplica multi-region para una base de datos RDS en Terraform, asegurando que la configuración sea idéntica entre las regiones:

module "primary_db" {

source = "./modules/rds"

region = "eu-south-1" # Milán

is_primary = true

# ... configuraciones de seguridad e instancia

}

module "secondary_db" {

source = "./modules/rds"

region = "eu-central-1" # Fráncfort

is_primary = false

source_db_arn = module.primary_db.arn

# La réplica hereda las configuraciones, garantizando coherencia

}

El enfoque IaC permite además implementar estrategias de Ephemeral Environments: en caso de desastre, podemos «hidratar» una nueva región desde cero en pocos minutos, en lugar de mantener costosos recursos inactivos (estrategia Pilot Light).

4. Gestión de Datos: Sharding y Consistencia Distribuida

La gestión de millones de solicitudes de presupuestos requiere una estrategia de base de datos robusta. El simple escalado vertical no basta. Implementamos técnicas de Database Sharding para particionar los datos horizontalmente.

Estrategia de Sharding para el Crédito

En MutuiperlaCasa.com, los datos pueden ser fragmentados (sharded) por ID de Expediente o por Área Geográfica. Sin embargo, para el disaster recovery, el sharding basado en ID es preferible para evitar «puntos calientes» (hotspots) regionales.

- Sharding Lógico: La aplicación debe ser consciente de la topología de los datos. Utilizamos middleware inteligentes que enrutan la consulta al shard correcto.

- Resiliencia del Shard: Cada shard debe tener su réplica en la región de failover. Si el Shard A cae en la Región 1, el tráfico para esos usuarios se redirige al Shard A (Réplica) en la Región 2, sin impactar a los usuarios del Shard B.

5. Construir la Confianza (Trust) a través de la Ingeniería

La resiliencia técnica se traduce directamente en confianza institucional. Los bancos socios requieren SLA (Service Level Agreements) rigurosos. Una arquitectura de disaster recovery cloud bien diseñada no sirve solo para «salvar los datos», sino para garantizar que el flujo de aprobación del crédito nunca se interrumpa.

Chaos Engineering: Probar lo Impredecible

No podemos confiar en un sistema de DR que nunca ha sido probado. Adoptamos prácticas de Chaos Engineering (similares a Chaos Monkey de Netflix) para inyectar fallos controlados en producción:

- Simulación de la pérdida de conectividad entre dos Availability Zones.

- Terminación forzada de instancias de base de datos primarias.

- Introducción de latencia artificial en las llamadas API hacia los socios bancarios.

Solo observando cómo el sistema reacciona (y se auto-repara) a estos estímulos podemos certificar nuestra resiliencia.

6. Troubleshooting: Qué hacer cuando la Automatización Falla

A pesar de la automatización, existen escenarios límite (ej. corrupción lógica de los datos replicada instantáneamente). En estos casos:

- Point-in-Time Recovery (PITR): Es vital tener backups incrementales continuos que permitan restaurar el estado de la base de datos a un segundo preciso antes del evento corruptivo.

- Circuit Breakers: Implementar patrones de circuit breaking en el código de la aplicación para prevenir que un servicio degradado cause un efecto cascada en toda la plataforma.

- War Rooms Virtuales: Procedimientos operativos estandarizados para el equipo DevOps, con roles preasignados para la gestión de la crisis.

En Breve (TL;DR)

La continuidad operativa en FinTech exige estrategias de disaster recovery cloud que eliminen los tiempos de inactividad y salvaguarden los datos.

La adopción de arquitecturas Multi-Region Active-Active en AWS y GCP asegura disponibilidad global y una gestión óptima de la conmutación por error instantánea.

El uso de Infrastructure as Code con Terraform garantiza la reproducibilidad de los entornos, eliminando el error humano en la gestión de recursos críticos.

Conclusiones

Diseñar una estrategia de disaster recovery cloud para el sector financiero en 2026 requiere un cambio de mentalidad: de tener un «plan de emergencia» a construir un sistema intrínsecamente resiliente. Ya sea que se elija AWS por su madurez en los servicios gestionados o GCP por su excelencia en el networking global, el imperativo sigue siendo el uso riguroso de Infrastructure as Code y una gestión obsesiva de la consistencia de los datos. Solo así plataformas como MutuiperlaCasa.com pueden garantizar esa estabilidad rocosa que usuarios y bancos exigen.

Preguntas frecuentes

En el contexto financiero moderno, el disaster recovery supera el simple guardado de datos para enfocarse en la Business Continuity con un RTO próximo a cero. Mientras que el backup tradicional implica tiempos de restauración que pueden durar horas, las arquitecturas cloud actuales apuntan a una resiliencia instantánea. Este enfoque garantiza que las transacciones críticas no se pierdan ni siquiera durante incidentes graves, equilibrando la consistencia de los datos con la alta disponibilidad necesaria para mantener la confianza de los usuarios y de las instituciones bancarias.

Esta configuración es fundamental para alcanzar un uptime del 99,999%, conocido como los cinco nueves, distribuyendo el tráfico simultáneamente sobre diferentes regiones geográficas. En caso de fallo en una zona, las otras regiones ya están activas y listas para gestionar la carga de trabajo completa instantáneamente. Es la estrategia ideal para plataformas críticas que no pueden permitirse interrupciones, protegiendo la operatividad y previniendo daños reputacionales debidos a tiempos de inactividad no planificados.

La elección varía según las prioridades arquitectónicas: AWS ofrece una madurez elevada con servicios como Route 53 y Aurora Global Database, ideales para réplicas rápidas y enrutamiento DNS avanzado. Google Cloud Platform, por otro lado, se distingue por su red global de fibra y el uso de IP Anycast, que permite mover el tráfico instantáneamente sin esperar la propagación DNS, además de ofrecer Cloud Spanner para una gestión simplificada de la consistencia distribuida de los datos.

El uso de herramientas como Terraform permite definir toda la infraestructura como código, garantizando que el entorno de disaster recovery sea una copia exacta e inmutable del de producción. Este enfoque elimina el error humano en la configuración manual y permite estrategias eficientes, como la posibilidad de recrear regiones enteras en pocos minutos solo cuando es necesario, optimizando los costes y asegurando la reproducibilidad técnica en caso de crisis.

El Chaos Engineering es una práctica que prevé la inyección voluntaria y controlada de fallos en el sistema, como la simulación de pérdida de conectividad o el bloqueo de una base de datos primaria. Sirve para probar la capacidad de la plataforma de auto-repararse y resistir a eventos imprevistos antes de que ocurran realmente. Solo observando la reacción del sistema a estas pruebas de estrés es posible certificar la resiliencia de la infraestructura y garantizar el cumplimiento de los SLA acordados con los socios.

¿Todavía tienes dudas sobre Disaster Recovery Cloud en FinTech: Guía de Arquitecturas Active-Active?

Escribe aquí tu pregunta específica para encontrar al instante la respuesta oficial de Google.

Fuentes y Profundización

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.