En Breve (TL;DR)

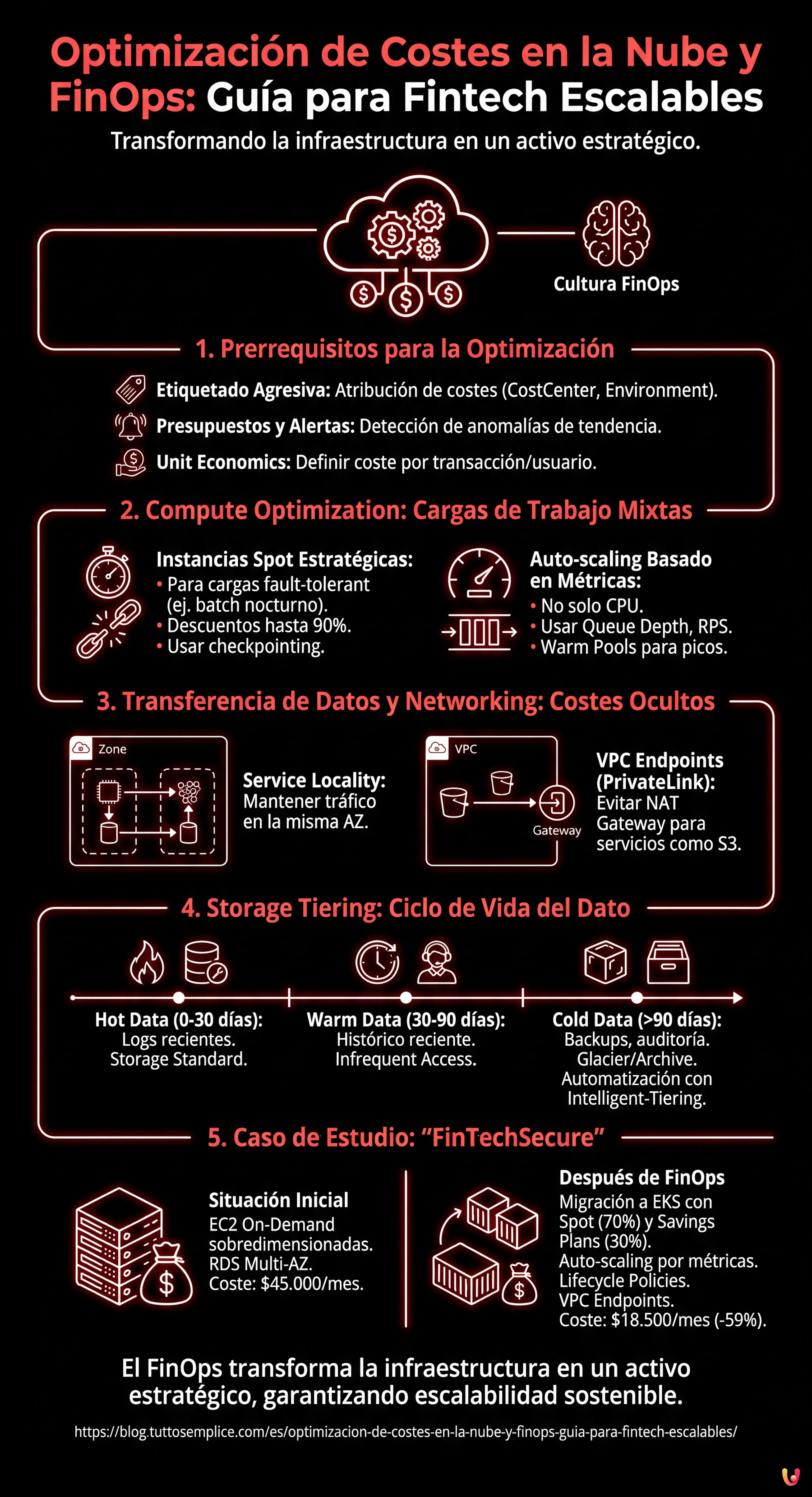

El enfoque FinOps transforma la infraestructura en la nube de centro de coste a recurso estratégico, centrándose en la sostenibilidad económica de las transacciones individuales.

El uso de instancias Spot y el auto-scaling basado en métricas personalizadas garantizan un alto rendimiento reduciendo drásticamente los gastos de computación.

Una gestión rigurosa del tráfico de datos y de las etiquetas permite identificar los costes invisibles y optimizar el margen empresarial.

El diablo está en los detalles. 👇 Sigue leyendo para descubrir los pasos críticos y los consejos prácticos para no equivocarte.

En el panorama tecnológico de 2026, para un emprendedor técnico o un CTO de una empresa Fintech, la infraestructura ya no es solo un centro de coste, sino un activo estratégico que determina el margen del negocio. La optimización de costes en la nube ya no trata simplemente de reducir la factura a fin de mes; es una disciplina de ingeniería compleja que requiere un enfoque cultural conocido como FinOps. En entornos de alta carga, donde la escalabilidad debe garantizar la continuidad operativa financiera (pensemos en el trading de alta frecuencia o la gestión de hipotecas en tiempo real), recortar costes sin criterio es un riesgo inaceptable.

Esta guía técnica explora cómo aplicar metodologías FinOps avanzadas en plataformas como AWS y Google Cloud, superando el concepto básico de rightsizing para abrazar arquitecturas elásticas, tiering inteligente del almacenamiento y gestión granular del tráfico de datos.

1. El Framework FinOps: Más allá del Ahorro, hacia la Eficiencia

Según la FinOps Foundation, el FinOps es un modelo operativo para la nube que combina sistemas, mejores prácticas y cultura para aumentar la capacidad de una organización de comprender los costes de la nube y tomar decisiones de negocio conscientes. En una Fintech, esto significa que cada ingeniero debe ser consciente del impacto económico de una línea de código o de una elección arquitectónica.

Prerrequisitos para la Optimización

Antes de implementar cambios técnicos, es necesario establecer una base de observabilidad:

- Estrategia de Etiquetado Agresiva: Cada recurso debe tener etiquetas obligatorias (ej.

CostCenter,Environment,ServiceOwner). Sin esto, la atribución de costes es imposible. - Presupuestos y Alertas: Configuración de AWS Budgets o GCP Budget Alerts no solo sobre umbrales fijos, sino sobre anomalías de tendencia (ej. un pico repentino de llamadas API).

- Unit Economics: Definir el coste por transacción o por usuario activo. El objetivo no es bajar el coste total si el negocio crece, sino bajar el coste unitario.

2. Compute Optimization: Estrategias para Cargas de Trabajo Mixtas

La partida de gasto mayor suele estar ligada a los recursos de cálculo (EC2 en AWS, Compute Engine en GCP). He aquí cómo optimizar en escenarios de alta carga.

Uso Estratégico de las Instancias Spot

Las Instancias Spot (o Preemptible VMs en GCP) ofrecen descuentos de hasta el 90%, pero pueden ser terminadas por el proveedor con poco preaviso. En el ámbito Fintech, el uso de las Spot es a menudo temido por la criticidad de los datos, pero es un miedo infundado si se gestiona arquitectónicamente.

Escenario de Aplicación: Procesamiento por Lotes Nocturno.

Consideremos el cálculo de los intereses sobre las hipotecas o la generación de informes normativos que ocurre cada noche. Esta es una carga de trabajo fault-tolerant (tolerante a fallos).

- Estrategia: Utilizar flotas de instancias Spot para los nodos worker que procesan los datos, manteniendo las instancias On-Demand solo para la orquestación (ej. el nodo maestro de un clúster Kubernetes o EMR).

- Implementación: Configurar la aplicación para gestionar el “checkpointing”. Si una instancia Spot es terminada, el trabajo debe reanudarse desde el último punto de control guardado en una base de datos o en S3/GCS, sin pérdida de datos.

- Diversificación: No apostar por un solo tipo de instancia. Utilizar Spot Fleets que soliciten diversas familias de instancias (ej. m5.large, c5.large, r5.large) para minimizar el riesgo de indisponibilidad simultánea.

Auto-scaling Basado en Métricas Personalizadas

El auto-scaling basado en la CPU es obsoleto para aplicaciones modernas. A menudo, una CPU al 40% esconde una latencia inaceptable para el usuario final.

Para una plataforma Fintech escalable, las políticas de scaling deben ser agresivas y predictivas:

- Métricas de Cola (Queue Depth): Si utilizáis Kafka o SQS/PubSub, escalad en base al número de mensajes en cola o al consumer lag. Es inútil añadir servidores si la cola está vacía, pero es vital añadirlos instantáneamente si la cola supera los 1000 mensajes, independientemente de la CPU.

- Peticiones por Segundo (RPS): Para las API Gateway, escalad en base al throughput de las peticiones.

- Warm Pools: Mantener un pool de instancias pre-inicializadas (en estado stopped o hibernate) para reducir los tiempos de arranque durante los picos de tráfico de mercado (ej. apertura de bolsa).

3. Transferencia de Datos y Networking: Los Costes Invisibles

Muchas empresas se concentran en el cálculo e ignoran el coste del movimiento de datos, que puede representar el 20-30% de la factura en arquitecturas de microservicios.

Optimización del Tráfico Inter-AZ e Inter-Región

En una arquitectura de alta disponibilidad, los datos viajan entre diferentes Availability Zones (AZ). AWS y GCP cobran este tráfico.

- Service Locality: Intentad mantener el tráfico dentro de la misma AZ cuando sea posible. Por ejemplo, aseguraos de que el microservicio A en la AZ-1 llame preferiblemente a la instancia del microservicio B en la AZ-1.

- VPC Endpoints (PrivateLink): Evitad pasar por el NAT Gateway para alcanzar servicios como S3 o DynamoDB. El uso de VPC Endpoints mantiene el tráfico en la red privada del proveedor, reduciendo los costes de procesamiento de datos del NAT Gateway (que son significativos para altos volúmenes) y mejorando la seguridad.

4. Storage Tiering: Gestión del Ciclo de Vida del Dato Financiero

Las normativas financieras (GDPR, PCI-DSS, MiFID II) imponen la conservación de los datos durante años. Mantener todo en almacenamiento de alto rendimiento (ej. S3 Standard) es un desperdicio enorme.

Intelligent Tiering y Políticas de Ciclo de Vida

La optimización de costes en la nube pasa por la automatización del ciclo de vida del dato:

- Hot Data (0-30 días): Logs transaccionales recientes, datos activos. Storage Standard.

- Warm Data (30-90 días): Histórico reciente para servicio al cliente. Infrequent Access (IA).

- Cold Data (90 días – 10 años): Copias de seguridad históricas, logs de auditoría. Utilizar clases como S3 Glacier Deep Archive o GCP Archive. El coste es una fracción del estándar, pero el tiempo de recuperación es de horas (aceptable para una auditoría).

- Automatización: Utilizar S3 Intelligent-Tiering para mover automáticamente los datos entre los niveles (tiers) en base a los patrones de acceso reales, sin tener que escribir scripts complejos.

5. Caso de Estudio: Optimización de Infraestructura “FinTechSecure”

Analicemos un caso teórico basado en escenarios reales de migración y optimización.

Situación Inicial:

La startup “FinTechSecure” gestiona pagos P2P. La infraestructura está en AWS, enteramente basada en instancias EC2 On-Demand sobredimensionadas para gestionar los picos del Black Friday, con base de datos RDS Multi-AZ. Coste mensual: $45.000.

Análisis FinOps:

1. Las instancias EC2 tienen una media de uso de CPU del 15%.

2. Los logs de acceso se conservan en S3 Standard indefinidamente.

3. El tráfico de datos a través del NAT Gateway es altísimo debido a las copias de seguridad hacia S3.

Intervenciones Ejecutadas:

- Compute: Migración de las cargas stateless a contenedores (EKS) utilizando Spot Instances para el 70% de los nodos y Savings Plans para el restante 30% (nodos base). Implementación de auto-scaling basado en métricas personalizadas (número de transacciones en cola).

- Storage: Activación de Lifecycle Policy para mover los logs a Glacier después de 30 días y borrarlos después de 7 años (compliance).

- Networking: Implementación de S3 Gateway Endpoint para eliminar los costes de NAT Gateway para el tráfico hacia el almacenamiento.

Resultado Final:

El coste mensual ha bajado a $18.500 (-59%), manteniendo el mismo SLA de disponibilidad (99.99%) y mejorando la velocidad de scaling durante los picos imprevistos.

Conclusiones

La optimización de costes en la nube en el ámbito Fintech no es una actividad puntual, sino un proceso continuo. Requiere equilibrar tres variables: coste, velocidad y calidad (redundancia/seguridad). Herramientas como las Instancias Spot, las políticas de Lifecycle y una monitorización granular permiten construir infraestructuras resilientes que escalan económicamente junto con el negocio. Para el emprendedor técnico, dominar el FinOps significa liberar recursos financieros para reinvertir en innovación y desarrollo de producto.

Preguntas frecuentes

El FinOps es un modelo operativo cultural que une ingeniería, finanzas y negocio para optimizar el gasto en la nube. En las empresas Fintech, este enfoque es crucial porque transforma la infraestructura de simple centro de coste a activo estratégico, permitiendo calcular el impacto económico de cada elección técnica (Unit Economics) y garantizando que la escalabilidad tecnológica sea sostenible financieramente incluso durante picos de mercado de alta carga.

Aunque las Instancias Spot pueden ser terminadas con poco preaviso, pueden utilizarse con seguridad en el ámbito financiero para cargas de trabajo tolerantes a fallos, como el cálculo nocturno de intereses o la generación de informes. La estrategia correcta prevé la implementación del checkpointing para guardar los progresos, el uso de flotas mixtas de instancias para diversificar el riesgo y el mantenimiento de nodos On-Demand para la orquestación del clúster.

El auto-scaling basado solo en el porcentaje de CPU es a menudo obsoleto para las modernas plataformas Fintech. Es preferible adoptar estrategias agresivas basadas en métricas personalizadas como la profundidad de las colas (Queue Depth) de los sistemas de mensajería o el número de peticiones por segundo (RPS). Además, el uso de Warm Pools con instancias pre-inicializadas ayuda a gestionar latencias cero durante la apertura de los mercados o eventos de tráfico repentino.

Los costes de networking pueden representar hasta el 30% de la factura en la nube. Para reducirlos, es necesario optimizar la Service Locality manteniendo el tráfico entre microservicios dentro de la misma Availability Zone. Además, es fundamental utilizar VPC Endpoints (PrivateLink) para conectarse a servicios gestionados como el almacenamiento, evitando así los costosos cargos de procesamiento de datos asociados al uso de los NAT Gateway públicos.

Para respetar normativas como GDPR o PCI-DSS sin desperdiciar presupuesto, es esencial implementar el tiering inteligente del almacenamiento. Los datos activos (Hot) permanecen en almacenamiento estándar, mientras que los logs históricos y las copias de seguridad (Cold) se mueven automáticamente mediante Lifecycle Policies a clases de archivo profundo como Glacier o Archive, que tienen costes extremadamente reducidos pero tiempos de recuperación más largos, ideales para auditorías poco frecuentes.

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.