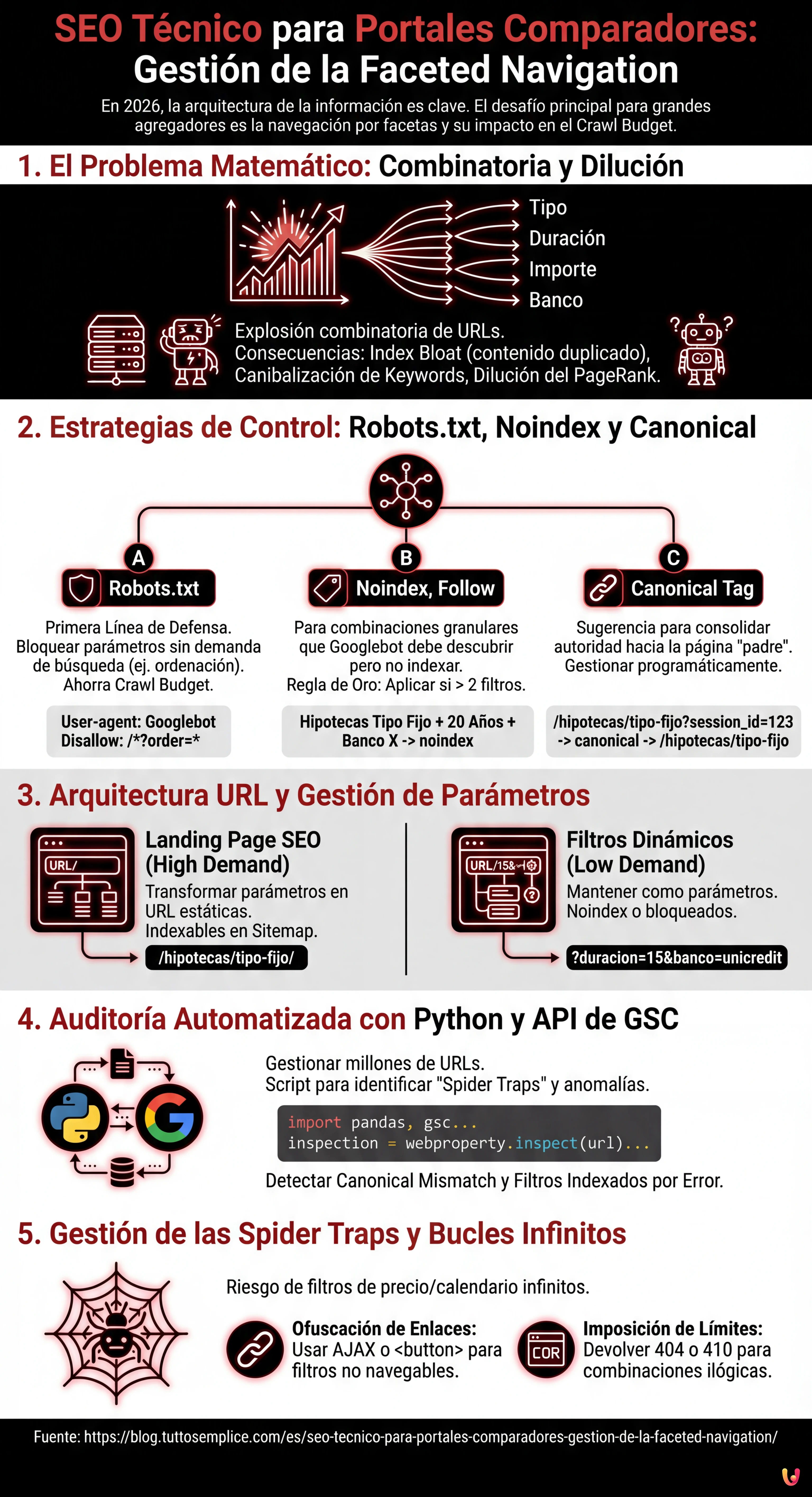

En el panorama digital de 2026, donde la inteligencia artificial y los Large Language Models (LLM) influyen cada vez más en la forma en que los motores de búsqueda procesan la información, la arquitectura de la información sigue siendo el pilar fundamental para los sitios con alto volumen de tráfico. Para los grandes agregadores, el principal desafío reside en el SEO Técnico para Portales Comparadores: Gestión de la Faceted Navigation (navegación por facetas). Esta guía técnica está diseñada para CTOs, SEO Managers y desarrolladores que operan en portales Fintech (como el caso de estudio de MutuiperlaCasa.com) o inmobiliarios, donde millones de combinaciones de filtros pueden transformarse en la peor pesadilla para el Crawl Budget.

1. El Problema Matemático: Combinatoria y Dilución de la Autoridad

La navegación por facetas permite a los usuarios filtrar los resultados basándose en múltiples atributos. En un portal de hipotecas, un usuario podría seleccionar:

- Tipo de interés: Fijo, Variable, Mixto.

- Duración: 10, 15, 20, 25, 30 años.

- Importe: Tramos de 5.000€.

- Banco: 20+ entidades.

Matemáticamente, esto genera una explosión combinatoria. Si Googlebot intentara rastrear cada posible permutación de URL generada por estos filtros, el Crawl Budget se agotaría rastreando páginas de bajo valor (ej. “Hipoteca tipo mixto, 13 años, Banco X, importe 125.000€”), dejando fuera del índice las páginas core de alta conversión. Este fenómeno conduce a:

- Index Bloat: El índice de Google se llena de páginas duplicadas o “thin content”.

- Canibalización de Keywords: Miles de páginas compiten por las mismas consultas.

- Dilución del PageRank: La autoridad del dominio se dispersa en URLs inútiles.

2. Estrategias de Control: Robots.txt, Noindex y Canonical

No existe una solución única. La gestión correcta requiere un enfoque híbrido basado en la prioridad de rastreo e indexación.

A. El Archivo Robots.txt: La Primera Línea de Defensa

Para los portales comparadores, el robots.txt es esencial para preservar los recursos de rastreo. Es necesario bloquear los parámetros que no generan demanda de búsqueda (search demand) o que crean contenido duplicado.

Ejemplo práctico: En un portal de hipotecas, la ordenación (precio ascendente/descendente) no cambia el contenido, solo el orden. Esto debe ser bloqueado.

User-agent: Googlebot

Disallow: /*?order=*

Disallow: /*?price_min=*

Disallow: /*?price_max=*Nota: Bloquear vía robots.txt impide el rastreo, pero no elimina necesariamente las páginas del índice si estas están enlazadas externamente. Sin embargo, es el método más eficaz para ahorrar Crawl Budget.

B. Meta Robots “noindex, follow”

Para las combinaciones de filtros que queremos que Googlebot descubra (para seguir los enlaces a los productos) pero no indexe, utilizamos la etiqueta noindex.

Regla de Oro: Aplicar noindex cuando el usuario aplica más de 2 filtros simultáneamente. Una página “Hipotecas Tipo Fijo” tiene valor SEO. Una página “Hipotecas Tipo Fijo + 20 Años + Banco Santander” es probablemente demasiado granular y debería ser excluida del índice.

C. Canonical Tag Programático

La etiqueta canonical es una sugerencia, no una directiva. En los portales comparadores, debe gestionarse programáticamente para consolidar la autoridad hacia la página “padre”.

Si un usuario aterriza en /hipotecas/tipo-fijo?session_id=123, el canonical debe apuntar taxativamente a /hipotecas/tipo-fijo. Sin embargo, el uso excesivo del canonical en páginas muy diferentes (ej. canonicalizar una página filtrada hacia la categoría general) puede ser ignorado por Google si el contenido difiere demasiado.

3. Arquitectura URL y Gestión de Parámetros

Según las mejores prácticas de Google Search Central, el uso de parámetros estándar (?key=value) es a menudo preferible para la faceted navigation frente a las URL estáticas simuladas (/valor1/valor2), porque permite a Google entender mejor la estructura dinámica.

La Lógica de MutuiperlaCasa.com

En nuestro escenario operativo, hemos implementado una lógica de Reescritura de URL Selectiva:

- Landing Page SEO (High Demand): Transformamos los parámetros en URL estáticas.

Ej:?tipo=fijose convierte en/hipotecas/tipo-fijo/. Estas páginas están presentes en el Sitemap XML y son indexables. - Filtros Dinámicos (Low Demand): Permanecen como parámetros.

Ej:?duracion=15&banco=unicredit. Estas páginas tienennoindexo están bloqueadas vía robots.txt dependiendo del volumen.

4. Auditoría Automatizada con Python y API de GSC

Gestionar millones de URL manualmente es imposible. En 2026, el uso de Python para consultar las API de Google Search Console es un estándar para los Technical SEO. A continuación, presentamos un script para identificar las “Spider Trap” y las páginas huérfanas causadas por los filtros.

Prerrequisitos

- Cuenta de Google Cloud Platform con API Search Console habilitada.

- Librerías Python:

pandas,google-auth,google-searchconsole.

El Script de Análisis

Este script extrae el estado de cobertura de las URL filtradas para identificar anomalías (ej. parámetros que deberían estar bloqueados pero están siendo indexados).

import pandas as pd

import websearch_google_search_console as gsc

# Autenticación (sustituir con las propias credenciales)

account = gsc.authenticate(client_config='client_secrets.json')

webproperty = account['https://www.mutuiperlacasa.com/']

# 1. Extracción datos de cobertura (Inspection API)

# Nota: La API tiene límites de cuota, usar con moderación o sobre muestras

urls_to_check = [

'https://www.mutuiperlacasa.com/hipotecas?tipo=fijo&duracion=30',

'https://www.mutuiperlacasa.com/hipotecas?tipo=variable&order=asc',

# ... lista de URL sospechosas generadas por los logs del servidor

]

results = []

for url in urls_to_check:

try:

inspection = webproperty.inspect(url)

results.append({

'url': url,

'index_status': inspection.index_status_result.status,

'robots_txt_state': inspection.index_status_result.robots_txt_state,

'indexing_state': inspection.index_status_result.indexing_state,

'user_canonical': inspection.index_status_result.user_canonical,

'google_canonical': inspection.index_status_result.google_canonical

})

except Exception as e:

print(f"Error en {url}: {e}")

# 2. Análisis de los Datos con Pandas

df = pd.DataFrame(results)

# Identificar URL que Google ha elegido como canonical diferente al declarado

canonical_mismatch = df[df['user_canonical'] != df['google_canonical']]

print("Canonical Mismatch Found:")

print(canonical_mismatch)

# Identificar URL indexadas que deberían estar bloqueadas

leaking_filters = df[(df['url'].str.contains('order=')) & (df['index_status'] == 'INDEXED')]

print("Filtros 'order' indexados por error:")

print(leaking_filters)

Interpretación de los Resultados

Si el script detecta que URL conteniendo order=asc están en el estado INDEXED, significa que las reglas del robots.txt no se han aplicado retroactivamente o que hay enlaces internos masivos apuntando a estos recursos. En este caso, la acción correctiva es implementar una etiqueta noindex temporal para eliminarlas, antes de bloquearlas nuevamente.

5. Gestión de las Spider Traps y Bucles Infinitos

Uno de los mayores riesgos en los portales comparadores es la generación de calendarios o filtros de precio infinitos (ej. /precio/100-200, /precio/101-201). Para resolver este problema:

- Ofuscación de Enlaces: Utilizar técnicas como la carga de filtros vía AJAX o botones

<button>(en lugar de<a href>) para los filtros que no deben ser seguidos por los bots. Aunque Googlebot puede ejecutar JavaScript, tiende a no interactuar con elementos que no parecen enlaces de navegación estándar si no es forzado. - Imposición de Límites: Del lado del servidor, si una URL contiene parámetros no válidos o combinaciones ilógicas, debe devolver un código de estado

404o410, no una página vacía con status200(Soft 404).

Conclusiones y Checklist Operativa

La gestión de la faceted navigation para portales comparadores no es una actividad de “configurar y olvidar”. Requiere una monitorización constante. Aquí está la checklist definitiva para 2026:

- Mapeo: Listar todos los parámetros URL generados por el CMS.

- Priorización: Decidir qué combinaciones tienen volumen de búsqueda (Index) y cuáles no (Noindex/Block).

- Implementación: Configurar

robots.txtpara el ahorro de presupuesto ynoindexpara la limpieza del índice. - Automatización: Ejecutar scripts Python mensuales para verificar que Google respeta las directivas.

- Análisis de Logs: Analizar los logs del servidor para ver dónde gasta Googlebot su tiempo. Si el 40% de los hits es en páginas

?order=, tenéis un problema de presupuesto.

Adoptando estas estrategias de ingeniería, portales complejos como MutuiperlaCasa.com pueden dominar las SERP, garantizando que cada rastreo de Googlebot se traduzca en valor real para el negocio.

Preguntas frecuentes

La navegación por facetas genera un número exponencial de combinaciones URL, llevando a menudo al agotamiento del Crawl Budget y al fenómeno del Index Bloat. Esto impide a Google rastrear las páginas importantes de alta conversión, diluye el PageRank en recursos inútiles y crea canibalización de keywords entre miles de páginas similares.

La gestión óptima requiere un enfoque híbrido: el archivo robots.txt debe bloquear los parámetros que no generan demanda de búsqueda, como la ordenación por precio, para ahorrar recursos de rastreo. La etiqueta meta noindex, en cambio, se debe aplicar a las páginas que queremos que los bots descubran para seguir los enlaces, pero que son demasiado granulares para ser indexadas, como aquellas con más de dos filtros activos.

Depende del volumen de búsqueda. La mejor estrategia es la Reescritura de URL Selectiva: las combinaciones de alta demanda (High Demand) deben transformarse en URL estáticas e incluirse en el Sitemap para maximizar el posicionamiento. Los filtros de baja demanda (Low Demand) deberían permanecer como parámetros estándar (?key=value) y gestionarse con noindex o bloquearse para no dispersar autoridad.

Para evitar que Googlebot quede atrapado en bucles infinitos, como filtros de precio ilimitados o calendarios, es fundamental usar la ofuscación de enlaces. Se recomienda cargar estos filtros mediante AJAX o utilizar elementos button en lugar de las clásicas etiquetas a href. Además, el servidor debe devolver códigos de estado 404 o 410 para combinaciones de parámetros ilógicas.

Para gestionar grandes volúmenes de URL es necesario utilizar scripts en Python que consulten las API de Google Search Console. Esto permite extraer programáticamente el estado de cobertura, identificar discrepancias entre el canonical declarado y el elegido por Google, y detectar parámetros que están siendo indexados por error a pesar de las reglas de bloqueo.

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.