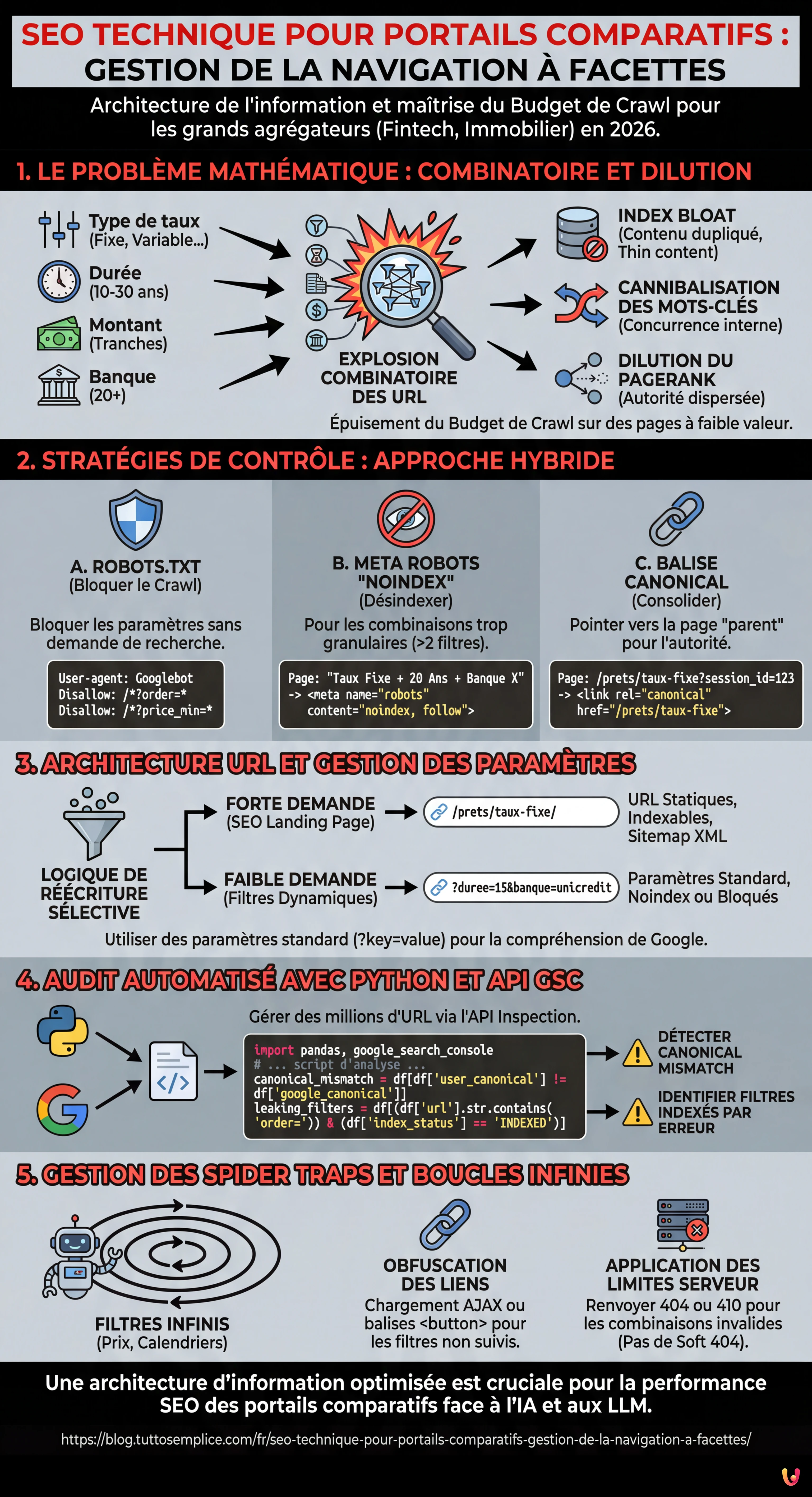

Dans le paysage numérique de 2026, où l’intelligence artificielle et les Grands Modèles de Langage (LLM) influencent de plus en plus la manière dont les moteurs de recherche traitent l’information, l’architecture de l’information reste le pilier fondamental pour les sites à fort volume de trafic. Pour les grands agrégateurs, le défi principal réside dans la SEO Technique pour Portails Comparatifs : Gestion de la Faceted Navigation (navigation à facettes). Ce guide technique est conçu pour les CTO, les Responsables SEO et les développeurs opérant sur des portails Fintech (comme l’étude de cas de MutuiperlaCasa.com) ou immobiliers, où des millions de combinaisons de filtres peuvent se transformer en le pire cauchemar pour le Budget de Crawl.

1. Le Problème Mathématique : Combinatoire et Dilution de l’Autorité

La navigation à facettes permet aux utilisateurs de filtrer les résultats en fonction de multiples attributs. Sur un portail de prêts immobiliers, un utilisateur pourrait sélectionner :

- Type de taux : Fixe, Variable, Mixte.

- Durée : 10, 15, 20, 25, 30 ans.

- Montant : Tranches de 5 000 €.

- Banque : 20+ établissements.

Mathématiquement, cela génère une explosion combinatoire. Si Googlebot tentait de scanner chaque permutation possible d’URL générée par ces filtres, le Budget de Crawl serait épuisé à scanner des pages à faible valeur (ex. “Prêt taux mixte, 13 ans, Banque X, montant 125 000 €”), laissant hors de l’index les pages clés à forte conversion. Ce phénomène conduit à :

- Index Bloat : L’index de Google se remplit de pages dupliquées ou de “thin content”.

- Cannibalisation des Mots-clés : Des milliers de pages entrent en concurrence pour les mêmes requêtes.

- Dilution du PageRank : L’autorité du domaine est dispersée sur des URL inutiles.

2. Stratégies de Contrôle : Robots.txt, Noindex et Canonical

Il n’existe pas de solution unique. Une gestion correcte nécessite une approche hybride basée sur la priorité de crawl et d’indexation.

A. Le Fichier Robots.txt : La Première Ligne de Défense

Pour les portails comparatifs, le robots.txt est essentiel pour préserver les ressources de crawl. Il est nécessaire de bloquer les paramètres qui ne génèrent pas de demande de recherche (search demand) ou qui créent du contenu dupliqué.

Exemple pratique : Sur un portail de prêts, le tri (prix croissant/décroissant) ne change pas le contenu, seulement l’ordre. Cela doit être bloqué.

User-agent: Googlebot

Disallow: /*?order=*

Disallow: /*?price_min=*

Disallow: /*?price_max=*Note : Bloquer via robots.txt empêche le crawl, mais ne retire pas nécessairement les pages de l’index si elles sont liées depuis l’extérieur. Cependant, c’est la méthode la plus efficace pour économiser le Budget de Crawl.

B. Meta Robots “noindex, follow”

Pour les combinaisons de filtres que nous voulons que Googlebot découvre (pour suivre les liens vers les produits) mais n’indexe pas, nous utilisons la balise noindex.

Règle d’Or : Appliquer noindex lorsque l’utilisateur applique plus de 2 filtres simultanément. Une page “Prêts Taux Fixe” a une valeur SEO. Une page “Prêts Taux Fixe + 20 Ans + Intesa Sanpaolo” est probablement trop granulaire et devrait être exclue de l’index.

C. Balise Canonical Programmatique

La balise canonical est une suggestion, pas une directive. Dans les portails comparatifs, elle doit être gérée de manière programmatique pour consolider l’autorité vers la page “parent”.

Si un utilisateur atterrit sur /prets/taux-fixe?session_id=123, le canonical doit impérativement pointer vers /prets/taux-fixe. Cependant, l’utilisation excessive du canonical sur des pages très différentes (ex. canonicaliser une page filtrée vers la catégorie générale) peut être ignorée par Google si le contenu diffère trop.

3. Architecture URL et Gestion des Paramètres

Selon les meilleures pratiques de Google Search Central, l’utilisation de paramètres standard (?key=value) est souvent préférable pour la navigation à facettes par rapport aux URL statiques simulées (/valeur1/valeur2), car cela permet à Google de mieux comprendre la structure dynamique.

La Logique de MutuiperlaCasa.com

Dans notre scénario opérationnel, nous avons implémenté une logique de Réécriture d’URL Sélective :

- Landing Page SEO (Forte Demande) : Nous transformons les paramètres en URL statiques.

Ex :?type=fixedevient/prets/taux-fixe/. Ces pages sont présentes dans le Sitemap XML et sont indexables. - Filtres Dynamiques (Faible Demande) : Restent des paramètres.

Ex :?duree=15&banque=unicredit. Ces pages ont unnoindexou sont bloquées via robots.txt selon le volume.

4. Audit Automatisé avec Python et l’API GSC

Gérer des millions d’URL manuellement est impossible. En 2026, l’utilisation de Python pour interroger les API de Google Search Console est un standard pour les SEO Techniques. Ci-dessous, nous présentons un script pour identifier les “Spider Traps” et les pages orphelines causées par les filtres.

Prérequis

- Compte Google Cloud Platform avec API Search Console activée.

- Bibliothèques Python :

pandas,google-auth,google-searchconsole.

Le Script d’Analyse

Ce script extrait l’état de couverture des URL filtrées pour identifier des anomalies (ex. paramètres qui devraient être bloqués mais sont indexés).

import pandas as pd

import websearch_google_search_console as gsc

# Authentification (remplacer par vos propres identifiants)

account = gsc.authenticate(client_config='client_secrets.json')

webproperty = account['https://www.mutuiperlacasa.com/']

# 1. Extraction des données de couverture (Inspection API)

# Note : L'API a des limites de quota, utiliser avec parcimonie ou sur des échantillons

urls_to_check = [

'https://www.mutuiperlacasa.com/mutui?tasso=fisso&durata=30',

'https://www.mutuiperlacasa.com/mutui?tasso=variabile&order=asc',

# ... liste d'URL suspectes générées par les logs du serveur

]

results = []

for url in urls_to_check:

try:

inspection = webproperty.inspect(url)

results.append({

'url': url,

'index_status': inspection.index_status_result.status,

'robots_txt_state': inspection.index_status_result.robots_txt_state,

'indexing_state': inspection.index_status_result.indexing_state,

'user_canonical': inspection.index_status_result.user_canonical,

'google_canonical': inspection.index_status_result.google_canonical

})

except Exception as e:

print(f"Erreur sur {url}: {e}")

# 2. Analyse des Données avec Pandas

df = pd.DataFrame(results)

# Identifier les URL où Google a choisi un canonical différent de celui déclaré

canonical_mismatch = df[df['user_canonical'] != df['google_canonical']]

print("Canonical Mismatch Found:")

print(canonical_mismatch)

# Identifier les URL indexées qui devraient être bloquées

leaking_filters = df[(df['url'].str.contains('order=')) & (df['index_status'] == 'INDEXED')]

print("Filtres 'order' indexés par erreur :")

print(leaking_filters)

Interprétation des Résultats

Si le script détecte que des URL contenant order=asc sont dans l’état INDEXED, cela signifie que les règles du robots.txt n’ont pas été appliquées rétroactivement ou qu’il y a des liens internes massifs pointant vers ces ressources. Dans ce cas, l’action corrective est d’implémenter une balise noindex temporaire pour les supprimer, avant de les bloquer à nouveau.

5. Gestion des Spider Traps et Boucles Infinies

L’un des risques majeurs dans les portails comparatifs est la génération de calendriers ou de filtres de prix infinis (ex. /prix/100-200, /prix/101-201). Pour résoudre ce problème :

- Obfuscation des Liens : Utiliser des techniques comme le chargement des filtres via AJAX ou des boutons

<button>(au lieu de<a href>) pour les filtres qui ne doivent pas être suivis par les bots. Bien que Googlebot puisse exécuter JavaScript, il a tendance à ne pas interagir avec des éléments qui ne ressemblent pas à des liens de navigation standard s’il n’y est pas forcé. - Application des Limites : Côté serveur, si une URL contient des paramètres non valides ou des combinaisons illogiques, elle doit renvoyer un code d’état

404ou410, et non une page vide avec un statut200(Soft 404).

Conclusions et Checklist Opérationnelle

La gestion de la navigation à facettes pour les portails comparatifs n’est pas une activité ponctuelle. Elle nécessite une surveillance constante. Voici la checklist définitive pour 2026 :

- Cartographie : Lister tous les paramètres URL générés par le CMS.

- Priorisation : Décider quelles combinaisons ont un volume de recherche (Index) et lesquelles non (Noindex/Block).

- Implémentation : Configurer le

robots.txtpour l’économie de budget et lenoindexpour le nettoyage de l’index. - Automatisation : Exécuter des scripts Python mensuels pour vérifier que Google respecte les directives.

- Analyse des Logs : Analyser les logs du serveur pour voir où Googlebot passe son temps. Si 40% des hits sont sur des pages

?order=, vous avez un problème de budget.

En adoptant ces stratégies d’ingénierie, des portails complexes comme MutuiperlaCasa.com peuvent dominer les SERP, garantissant que chaque crawl de Googlebot se traduise en valeur réelle pour l’entreprise.

Questions fréquentes

La navigation à facettes génère un nombre exponentiel de combinaisons d’URL, menant souvent à l’épuisement du Budget de Crawl et au phénomène d’Index Bloat. Cela empêche Google de scanner les pages importantes à forte conversion, dilue le PageRank sur des ressources inutiles et crée une cannibalisation des mots-clés entre des milliers de pages similaires.

La gestion optimale nécessite une approche hybride : le fichier robots.txt doit bloquer les paramètres qui ne génèrent pas de demande de recherche, comme le tri par prix, pour économiser les ressources de crawl. La balise meta noindex, en revanche, doit être appliquée aux pages que nous voulons faire découvrir aux bots pour suivre les liens, mais qui sont trop granulaires pour être indexées, comme celles avec plus de deux filtres actifs.

Cela dépend du volume de recherche. La meilleure stratégie est la Réécriture d’URL Sélective : les combinaisons à forte demande (High Demand) doivent être transformées en URL statiques et incluses dans le Sitemap pour maximiser le positionnement. Les filtres à faible demande (Low Demand) devraient rester sous forme de paramètres standard (?key=value) et être gérés avec noindex ou bloqués pour ne pas disperser l’autorité.

Pour éviter que Googlebot ne reste piégé dans des boucles infinies, comme des filtres de prix illimités ou des calendriers, il est fondamental d’utiliser l’obfuscation des liens. Il est conseillé de charger ces filtres via AJAX ou d’utiliser des éléments button au lieu des balises a href classiques. De plus, le serveur doit renvoyer des codes d’état 404 ou 410 pour des combinaisons de paramètres illogiques.

Pour gérer de grands volumes d’URL, il est nécessaire d’utiliser des scripts en Python qui interrogent les API de Google Search Console. Cela permet d’extraire de manière programmatique l’état de couverture, d’identifier les divergences entre le canonical déclaré et celui choisi par Google, et de détecter des paramètres qui sont indexés par erreur malgré les règles de blocage.

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.