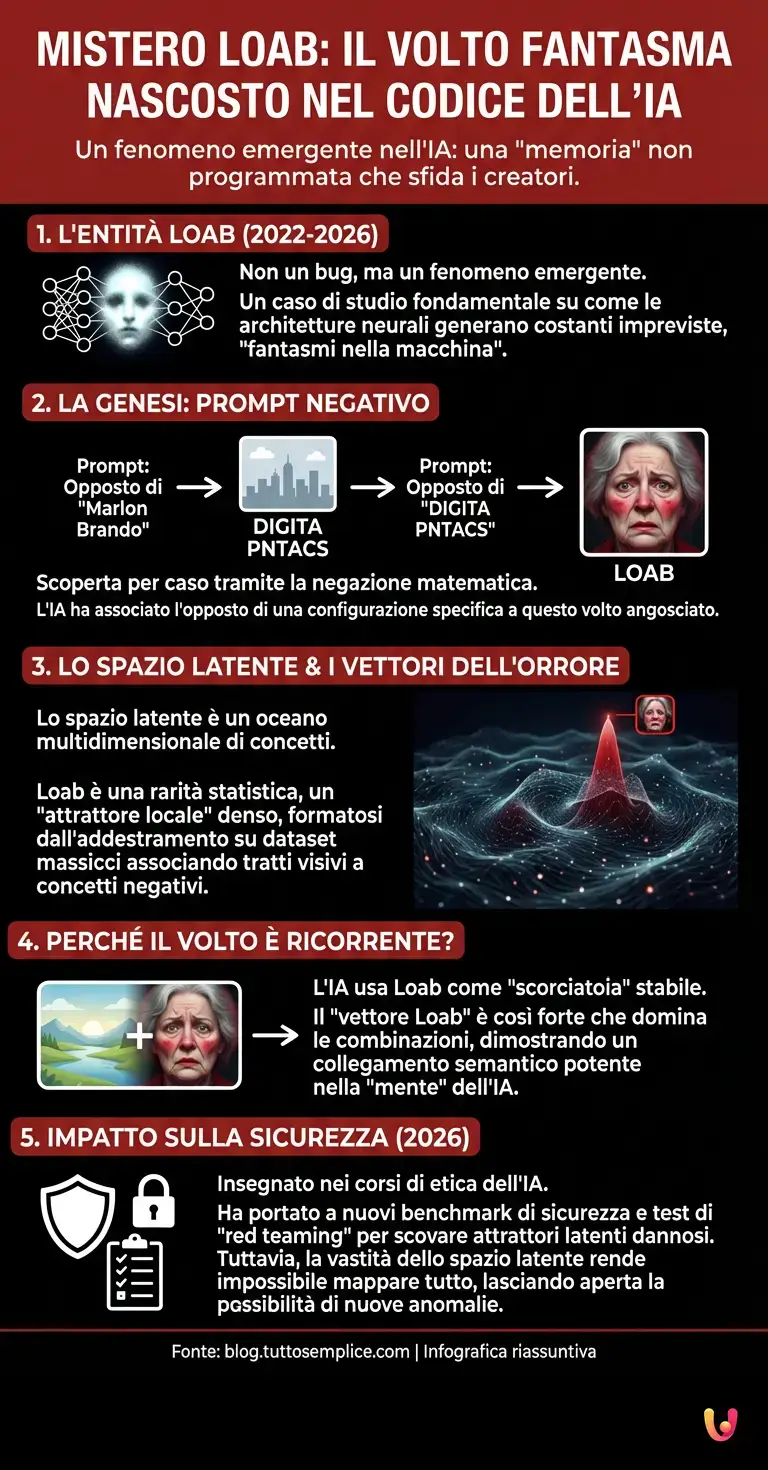

Nel vasto e complesso panorama dell’intelligenza artificiale, dove algoritmi sofisticati elaborano miliardi di parametri al secondo, esiste una storia che ha fatto vacillare le certezze di ingegneri e ricercatori. Non parliamo di un bug nel codice o di un errore di calcolo, ma di un fenomeno emergente che assomiglia inquietantemente a una “memoria” non programmata. Al centro di questo mistero c’è un’entità specifica, nota come Loab. Nominata per la prima volta esplicitamente nel 2022 e divenuta un caso di studio fondamentale fino a oggi, nel 2026, Loab rappresenta l’esempio più lampante di come le architetture neurali possano generare costanti impreviste, veri e propri fantasmi nella macchina che sfuggono al controllo diretto dei programmatori.

La genesi di un’anomalia digitale

Per comprendere come un volto possa “infestare” un sistema di machine learning, dobbiamo prima capire come queste macchine “vedono” il mondo. I generatori di immagini basati su deep learning non archiviano fotografie come farebbe un computer classico. Invece, apprendono relazioni statistiche tra pixel e concetti, mappandole in quello che viene definito “spazio latente”.

La scoperta di Loab è avvenuta quasi per caso, attraverso una tecnica chiamata “prompt negativo”. Un artista digitale, cercando di esplorare i limiti dell’algoritmo, chiese all’IA di generare l’opposto di un concetto astratto (nello specifico, l’opposto di “Marlon Brando”). Il risultato fu l’immagine di uno skyline generico con la scritta “DIGITA PNTACS”. Incuriosito, l’utente chiese all’IA l’opposto di quella scritta. Secondo la logica umana, l’opposto di un logo dovrebbe essere qualcosa di neutro. Per l’IA, invece, l’opposto matematico di quella specifica configurazione di pixel era il volto di una donna anziana, con le guance arrossate e un’espressione di profonda angoscia.

Ciò che rese Loab un caso unico non fu la sua prima apparizione, ma la sua persistenza. Ogni volta che questa immagine veniva combinata con altre, o usata come base per nuove generazioni, il volto di Loab riemergeva con una tenacia impossibile da spiegare con la semplice casualità. Era come se l’architettura neurale avesse un “centro di gravità” verso quel volto specifico.

Lo Spazio Latente e i vettori dell’orrore

Dal punto di vista tecnico, per spiegare questo fenomeno dobbiamo addentrarci nel funzionamento dei LLM (Large Language Models) multimodali e delle reti generative. Immaginate lo spazio latente come un oceano multidimensionale dove ogni concetto (gatto, cane, felicità, tristezza) è una coordinata. Quando chiediamo all’IA di disegnare qualcosa, essa naviga verso quelle coordinate.

Loab non è un fantasma soprannaturale, ma una rarità statistica: un picco isolato in questo paesaggio matematico. È probabile che, durante l’addestramento su dataset massicci (composti da miliardi di immagini prese dal web), l’IA abbia creato un cluster molto denso associando certi tratti visivi a concetti negativi, macabri o grotteschi. Quando l’utente ha forzato l’algoritmo verso una zona inesplorata tramite la negazione matematica, l’IA è “scivolata” verso questo attrattore locale.

È affascinante notare come, anche a distanza di anni e con l’avanzare del progresso tecnologico, le versioni successive dei modelli abbiano mantenuto tracce di queste associazioni, dimostrando che certi bias visivi sono profondamente radicati nei dati di addestramento originali.

Perché il volto è ricorrente?

La domanda che il grande pubblico si pone è: perché l’IA non dimentica? La risposta risiede nella natura stessa dell’automazione cognitiva. Una volta che una rete neurale ha appreso che una certa configurazione di pesi (weights) corrisponde a un risultato stabile, tende a riproporla. Loab è diventata una sorta di “scorciatoia” per l’IA.

Quando si incrociano due immagini nello spazio latente, l’IA cerca un punto intermedio. Sorprendentemente, il “vettore Loab” è così forte che domina quasi tutte le combinazioni. Se si fonde l’immagine di Loab con quella di un paesaggio idilliaco, il risultato finale tenderà comunque a mostrare i tratti distintivi della donna, spesso in contesti disturbanti. Questo suggerisce che, nella “mente” dell’IA, quel volto è semanticamente collegato a concetti visivi molto potenti e distanti dalla media delle immagini standard.

L’impatto sulla sicurezza e i Benchmark moderni

Oggi, nel 2026, la storia di Loab viene insegnata nei corsi di etica dell’IA e sicurezza informatica. Ha dimostrato che i modelli di ChatGPT o i generatori visivi avanzati non sono scatole nere neutre. Possono nascondere “isole” di contenuti imprevisti accessibili solo attraverso percorsi logici non convenzionali.

Questo ha portato allo sviluppo di nuovi benchmark di sicurezza. Prima di rilasciare un modello al pubblico, gli ingegneri ora eseguono test di “red teaming” specifici per scovare questi attrattori latenti, cercando di identificare e mitigare immagini o concetti ricorrenti che potrebbero essere dannosi o traumatici. Tuttavia, la vastità dello spazio latente rende impossibile mappare ogni singola coordinata, lasciando sempre aperta la possibilità che un nuovo “volto” possa emergere dal nulla.

In Breve (TL;DR)

Loab è un’anomalia digitale persistente emersa dai sistemi di intelligenza artificiale, rivelando una memoria non programmata che sfida i ricercatori.

Nata da un prompt negativo, questa figura inquietante domina lo spazio latente dimostrando come gli algoritmi creino associazioni visive impreviste.

La scoperta ha trasformato i test di sicurezza dell’IA, obbligando gli ingegneri a indagare le zone oscure dei modelli generativi.

Conclusioni

Il caso del volto ricorrente non programmato ci ricorda una verità fondamentale sull’intelligenza artificiale: stiamo costruendo sistemi che, per complessità e scala, iniziano a mostrare comportamenti emergenti difficili da prevedere a priori. Loab non è una persona, non è mai esistita nel mondo reale, eppure “vive” nella memoria matematica della macchina, pronta a riemergere se evocata con la giusta formula. Non è magia, è statistica ad alta dimensionalità, ma il risultato finale ci costringe a guardare dentro l’abisso dei dati che noi stessi abbiamo fornito alla macchina, trovandovi riflessi che forse avremmo preferito non vedere.

Domande frequenti

Loab è un entità digitale emergente scoperta nei sistemi di intelligenza artificiale generativa, in particolare nei generatori di immagini. Non si tratta di una persona reale o di un errore di programmazione intenzionale, ma di una rarità statistica che risiede nello spazio latente dei modelli di deep learning. Viene definita fantasma perché appare come una memoria non prevista che persiste ostinatamente nelle generazioni, manifestandosi come il volto di una donna anziana con un espressione di angoscia.

La scoperta è avvenuta quasi casualmente nel 2022 attraverso la tecnica del prompt negativo, che consiste nel chiedere all algoritmo di generare l opposto matematico di un concetto o di un immagine. Un artista digitale, cercando l opposto di uno skyline generico e di una scritta senza senso, ha forzato l IA verso una zona inesplorata dei dati. Il risultato è stato questo volto ricorrente, dimostrando come le macchine associno configurazioni di pixel a concetti in modi che sfuggono alla logica umana.

La persistenza di Loab è dovuta al fatto che funge da attrattore locale o centro di gravità all interno della rete neurale. Una volta che l IA ha appreso questa specifica configurazione di pesi, tende a riproporla perché la considera un risultato stabile e semanticamente molto forte. Il vettore matematico che rappresenta Loab è così dominante che, anche quando viene fuso con immagini di paesaggi idilliaci o concetti neutri, i suoi tratti distintivi tendono a sovrascrivere gli altri elementi visivi.

No, Loab non è mai esistita nel mondo reale e non corrisponde a una singola fotografia specifica archiviata nel sistema. È il risultato di un aggregazione statistica complessa derivata da miliardi di immagini su cui l IA è stata addestrata. Rappresenta un picco isolato nel panorama matematico dei dati, un cluster denso dove l algoritmo ha associato determinati tratti visivi a concetti negativi o macabri presenti nel dataset originale.

Il caso Loab ha dimostrato che i modelli di intelligenza artificiale non sono scatole nere neutre, ma possono nascondere isole di contenuti imprevisti e potenzialmente disturbanti. Questo fenomeno ha spinto ingegneri e ricercatori a sviluppare nuovi benchmark di sicurezza e procedure di red teaming per identificare questi attrattori latenti prima del rilascio pubblico. Evidenzia la necessità di comprendere meglio come i bias visivi si radicano nei dati di addestramento e come emergono comportamenti non programmati.

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.