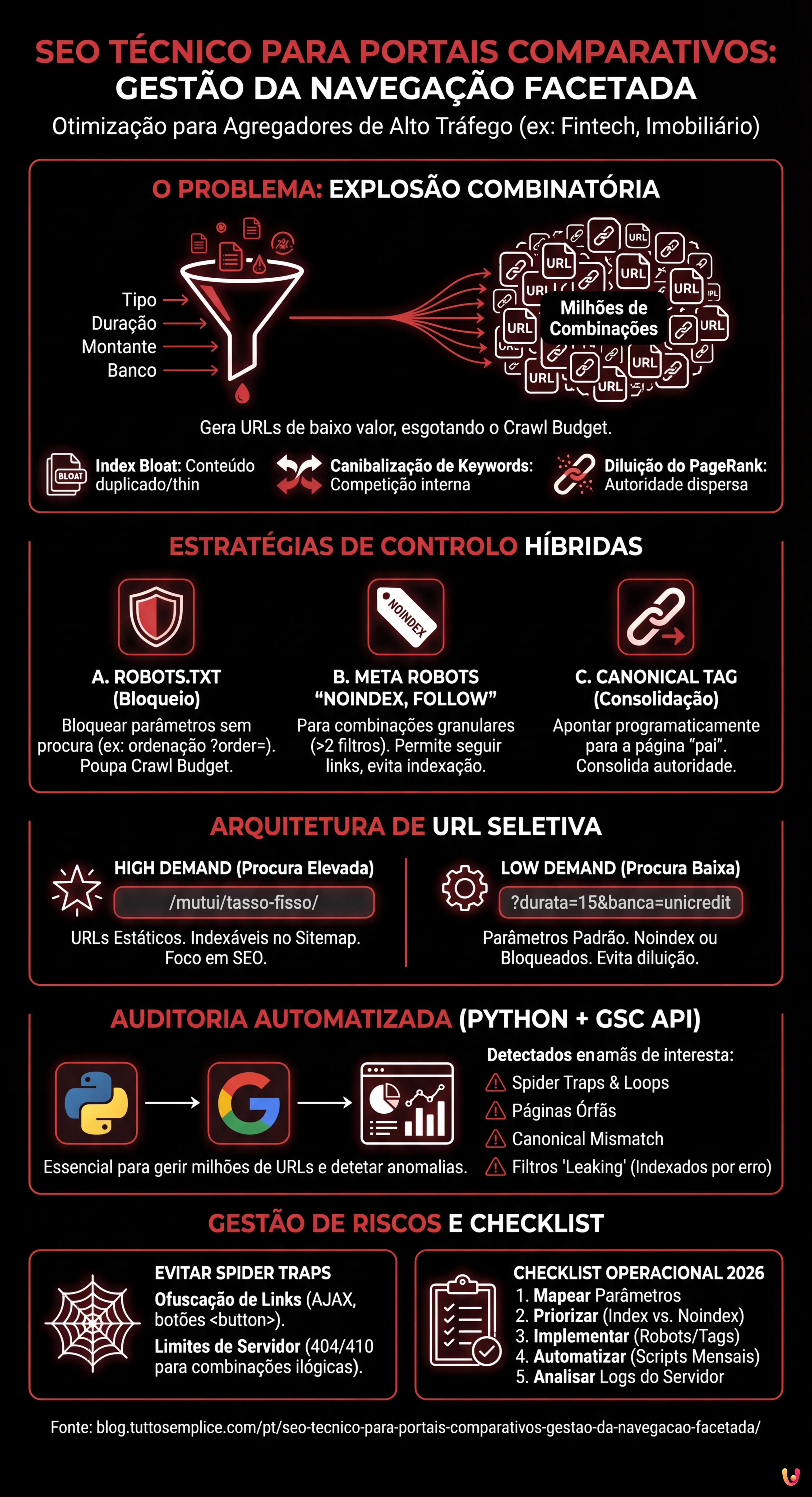

No panorama digital de 2026, onde a inteligência artificial e os Large Language Models (LLM) influenciam cada vez mais a forma como os motores de pesquisa processam a informação, a arquitetura da informação permanece o pilar fundamental para sites com elevado volume de tráfego. Para os grandes agregadores, o principal desafio reside na SEO Técnico para Portais Comparativos: Gestão da Faceted Navigation (navegação facetada). Este guia técnico foi concebido para CTOs, Gestores de SEO e programadores que operam em portais Fintech (como o caso de estudo de MutuiperlaCasa.com) ou imobiliários, onde milhões de combinações de filtros podem transformar-se no pior pesadelo para o Crawl Budget.

1. O Problema Matemático: Combinatória e Diluição da Autoridade

A navegação facetada permite aos utilizadores filtrar os resultados com base em múltiplos atributos. Num portal de crédito habitação, um utilizador poderia selecionar:

- Tipo de taxa: Fixa, Variável, Mista.

- Duração: 10, 15, 20, 25, 30 anos.

- Montante: Escalões de 5.000€.

- Banco: 20+ instituições.

Matematicamente, isto gera uma explosão combinatória. Se o Googlebot tentasse rastrear cada permutação possível de URL gerada por estes filtros, o Crawl Budget seria esgotado a rastrear páginas de baixo valor (ex: “Crédito taxa mista, 13 anos, Banco X, montante 125.000€”), deixando fora do índice as páginas core de alta conversão. Este fenómeno leva a:

- Index Bloat: O índice da Google enche-se de páginas duplicadas ou “thin content”.

- Canibalização de Keywords: Milhares de páginas competem pelas mesmas queries.

- Diluição do PageRank: A autoridade do domínio é dispersa por URLs inúteis.

2. Estratégias de Controlo: Robots.txt, Noindex e Canonical

Não existe uma solução única. A gestão correta requer uma abordagem híbrida baseada na prioridade de rastreio e indexação.

A. O Ficheiro Robots.txt: A Primeira Linha de Defesa

Para os portais comparativos, o robots.txt é essencial para preservar os recursos de rastreio. É necessário bloquear os parâmetros que não geram procura de pesquisa (search demand) ou que criam conteúdo duplicado.

Exemplo prático: Num portal de crédito habitação, a ordenação (preço crescente/decrescente) não altera o conteúdo, apenas a ordem. Isto deve ser bloqueado.

User-agent: Googlebot

Disallow: /*?order=*

Disallow: /*?price_min=*

Disallow: /*?price_max=*Nota: Bloquear via robots.txt impede o rastreio, mas não remove necessariamente as páginas do índice se estas tiverem links externos. No entanto, é o método mais eficaz para poupar Crawl Budget.

B. Meta Robots “noindex, follow”

Para as combinações de filtros que queremos que o Googlebot descubra (para seguir os links para os produtos) mas não indexe, utilizamos a tag noindex.

Regra de Ouro: Aplicar noindex quando o utilizador aplica mais de 2 filtros simultaneamente. Uma página “Crédito Taxa Fixa” tem valor SEO. Uma página “Crédito Taxa Fixa + 20 Anos + Intesa Sanpaolo” é provavelmente demasiado granular e deve ser excluída do índice.

C. Canonical Tag Programática

A tag canonical é uma sugestão, não uma diretiva. Nos portais comparativos, deve ser gerida programaticamente para consolidar a autoridade para a página “pai”.

Se um utilizador aterra em /mutui/tasso-fisso?session_id=123, o canonical deve apontar taxativamente para /mutui/tasso-fisso. No entanto, o uso excessivo do canonical em páginas muito diferentes (ex: canonicalizar uma página filtrada para a categoria geral) pode ser ignorado pela Google se o conteúdo diferir demasiado.

3. Arquitetura de URL e Gestão de Parâmetros

De acordo com as melhores práticas do Google Search Central, a utilização de parâmetros padrão (?key=value) é frequentemente preferível para a navegação facetada em comparação com URLs estáticos simulados (/valor1/valor2), porque permite à Google compreender melhor a estrutura dinâmica.

A Lógica de MutuiperlaCasa.com

No nosso cenário operacional, implementámos uma lógica de URL Rewriting Seletivo:

- Landing Page SEO (High Demand): Transformamos os parâmetros em URLs estáticos.

Ex:?tipo=fissotorna-se/mutui/tasso-fisso/. Estas páginas estão presentes no Sitemap XML e são indexáveis. - Filtros Dinâmicos (Low Demand): Permanecem parâmetros.

Ex:?durata=15&banca=unicredit. Estas páginas têmnoindexou são bloqueadas via robots.txt dependendo do volume.

4. Auditoria Automatizada com Python e GSC API

Gerir milhões de URLs manualmente é impossível. Em 2026, o uso de Python para interrogar as APIs da Google Search Console é um padrão para os Technical SEOs. Abaixo, apresentamos um script para identificar as “Spider Trap” e as páginas órfãs causadas pelos filtros.

Pré-requisitos

- Conta Google Cloud Platform com API Search Console ativada.

- Bibliotecas Python:

pandas,google-auth,google-searchconsole.

O Script de Análise

Este script extrai o estado de cobertura dos URLs filtrados para identificar anomalias (ex: parâmetros que deveriam ser bloqueados mas estão a ser indexados).

import pandas as pd

import websearch_google_search_console as gsc

# Autenticação (substituir pelas próprias credenciais)

account = gsc.authenticate(client_config='client_secrets.json')

webproperty = account['https://www.mutuiperlacasa.com/']

# 1. Extração de dados de cobertura (Inspection API)

# Nota: A API tem limites de quota, usar com parcimónia ou em amostras

urls_to_check = [

'https://www.mutuiperlacasa.com/mutui?tasso=fisso&durata=30',

'https://www.mutuiperlacasa.com/mutui?tasso=variabile&order=asc',

# ... lista de URLs suspeitos gerados pelos logs do servidor

]

results = []

for url in urls_to_check:

try:

inspection = webproperty.inspect(url)

results.append({

'url': url,

'index_status': inspection.index_status_result.status,

'robots_txt_state': inspection.index_status_result.robots_txt_state,

'indexing_state': inspection.index_status_result.indexing_state,

'user_canonical': inspection.index_status_result.user_canonical,

'google_canonical': inspection.index_status_result.google_canonical

})

except Exception as e:

print(f"Erro em {url}: {e}")

# 2. Análise dos Dados com Pandas

df = pd.DataFrame(results)

# Identificar URLs que a Google escolheu como canonical diferente do declarado

canonical_mismatch = df[df['user_canonical'] != df['google_canonical']]

print("Canonical Mismatch Found:")

print(canonical_mismatch)

# Identificar URLs indexados que deveriam ser bloqueados

leaking_filters = df[(df['url'].str.contains('order=')) & (df['index_status'] == 'INDEXED')]

print("Filtros 'order' indexados por erro:")

print(leaking_filters)

Interpretação dos Resultados

Se o script detetar que URLs contendo order=asc estão no estado INDEXED, significa que as regras do robots.txt não foram aplicadas retroativamente ou que existem links internos massivos a apontar para estes recursos. Neste caso, a ação corretiva é implementar uma tag noindex temporária para removê-los, antes de bloqueá-los novamente.

5. Gestão de Spider Traps e Loops Infinitos

Um dos maiores riscos nos portais comparativos é a geração de calendários ou filtros de preço infinitos (ex: /prezzo/100-200, /prezzo/101-201). Para resolver este problema:

- Ofuscação de Links: Utilizar técnicas como o carregamento dos filtros via AJAX ou botões

<button>(em vez de<a href>) para os filtros que não devem ser seguidos pelos bots. Embora o Googlebot possa executar JavaScript, tende a não interagir com elementos que não parecem links de navegação padrão se não for forçado. - Imposição de Limites: Do lado do servidor, se um URL contém parâmetros inválidos ou combinações ilógicas, deve devolver um código de estado

404ou410, e não uma página vazia com status200(Soft 404).

Conclusões e Checklist Operacional

A gestão da navegação facetada para portais comparativos não é uma atividade “set and forget”. Requer uma monitorização constante. Eis a checklist definitiva para 2026:

- Mapeamento: Listar todos os parâmetros de URL gerados pelo CMS.

- Priorização: Decidir quais as combinações que têm volume de pesquisa (Index) e quais não (Noindex/Block).

- Implementação: Configurar

robots.txtpara a poupança de budget enoindexpara a limpeza do índice. - Automação: Executar scripts Python mensais para verificar se a Google respeita as diretivas.

- Análise de Logs: Analisar os logs do servidor para ver onde o Googlebot gasta o seu tempo. Se 40% dos hits forem em páginas

?order=, tem um problema de budget.

Ao adotar estas estratégias de engenharia, portais complexos como MutuiperlaCasa.com podem dominar as SERPs, garantindo que cada rastreio do Googlebot se traduza em valor real para o negócio.

Perguntas frequentes

A navegação facetada gera um número exponencial de combinações de URL, levando frequentemente ao esgotamento do Crawl Budget e ao fenómeno do Index Bloat. Isto impede a Google de rastrear as páginas importantes de alta conversão, dilui o PageRank em recursos inúteis e cria canibalização de keywords entre milhares de páginas semelhantes.

A gestão ideal requer uma abordagem híbrida: o ficheiro robots.txt deve bloquear os parâmetros que não geram procura de pesquisa, como a ordenação por preço, para poupar recursos de rastreio. A meta tag noindex, por outro lado, deve ser aplicada às páginas que queremos que os bots descubram para seguir os links, mas que são demasiado granulares para serem indexadas, como aquelas com mais de dois filtros ativos.

Depende do volume de pesquisa. A melhor estratégia é o URL Rewriting Seletivo: as combinações de alta procura (High Demand) devem ser transformadas em URLs estáticos e incluídas no Sitemap para maximizar o posicionamento. Os filtros de baixa procura (Low Demand) devem permanecer como parâmetros padrão («?key=value») e ser geridos com noindex ou bloqueados para não dispersar autoridade.

Para evitar que o Googlebot fique preso em loops infinitos, como filtros de preço ilimitados ou calendários, é fundamental usar a ofuscação de links. Recomenda-se carregar estes filtros via AJAX ou utilizar elementos button em vez das clássicas tags a href. Além disso, o servidor deve devolver códigos de estado 404 ou 410 para combinações de parâmetros ilógicas.

Para gerir grandes volumes de URLs é necessário utilizar scripts em Python que interrogam as APIs da Google Search Console. Isto permite extrair programaticamente o estado de cobertura, identificar discrepâncias entre o canonical declarado e o escolhido pela Google, e detetar parâmetros que estão a ser indexados por erro apesar das regras de bloqueio.

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.