Immagina di essere seduto alla tua scrivania, immerso in una videochiamata di lavoro su Zoom o Teams. Il microfono è acceso, la telecamera magari è spenta per comodità. Mentre il collega parla, tu approfitti di un momento di pausa per digitare rapidamente una password e accedere al portale aziendale, oppure per rispondere a una mail riservata. Ti senti al sicuro: nessuno può vedere il tuo schermo e nessuno sta guardando le tue dita. Eppure, in quel preciso istante, potresti aver appena consegnato le chiavi della tua vita digitale a un ascoltatore invisibile. L’entità responsabile di questa violazione non è un hacker umano appostato fuori dalla finestra, ma un sofisticato modello di Deep Learning capace di trasformare il banale ticchettio della tua tastiera in testo chiaro e leggibile.

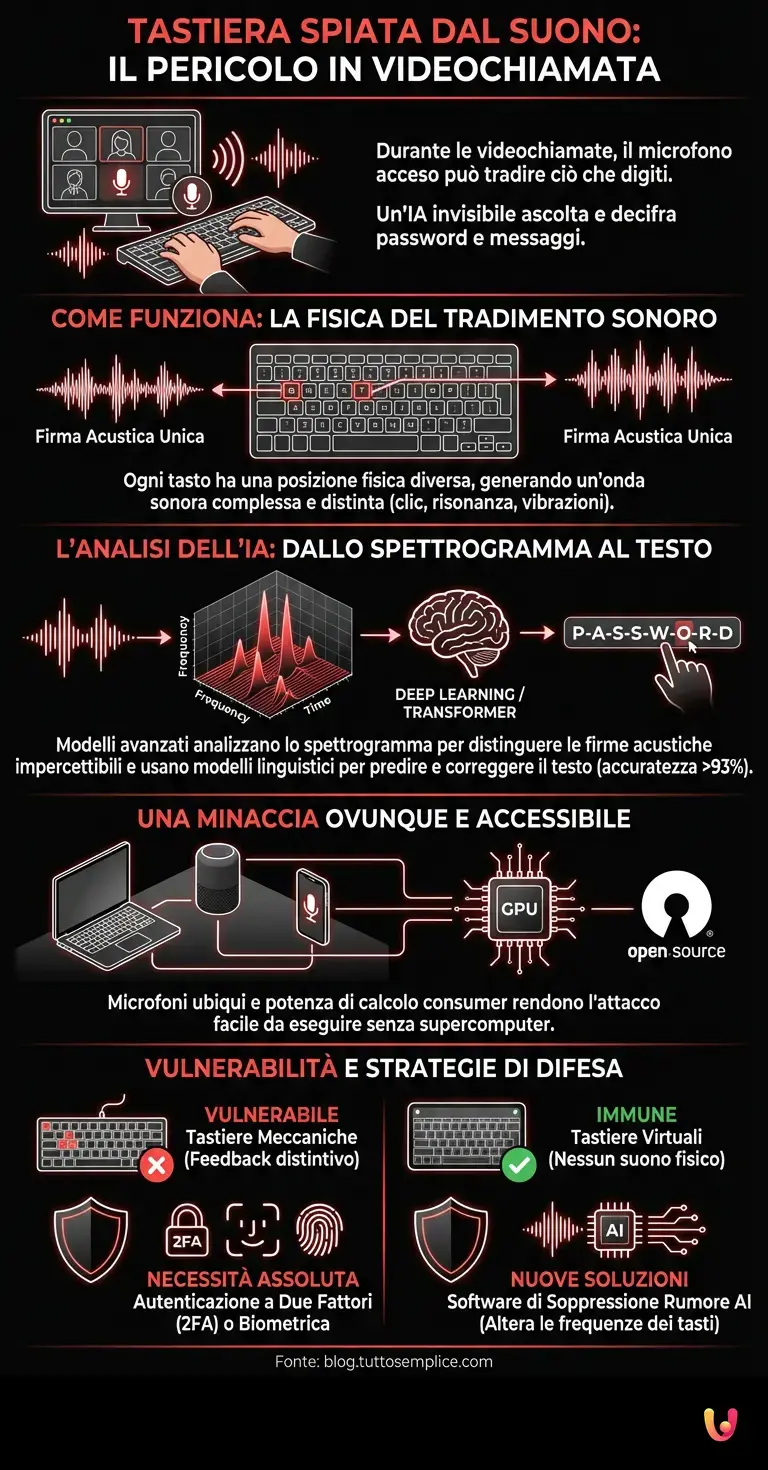

Siamo nel 2026, e il panorama della sicurezza informatica è mutato radicalmente. Se un tempo ci preoccupavamo di coprire la webcam con un pezzo di nastro adesivo, oggi la minaccia è diventata eterea, viaggiando attraverso le onde sonore. Questo fenomeno, noto tecnicamente come “attacco laterale acustico” (Acoustic Side-Channel Attack), rappresenta una delle frontiere più affascinanti e inquietanti del progresso tecnologico. Ma come è possibile che un semplice rumore meccanico possa tradire segreti complessi? La risposta risiede nella straordinaria capacità degli algoritmi moderni di rilevare pattern impercettibili all’orecchio umano, colmando quel divario tra il mondo fisico e quello digitale che credevamo invalicabile.

La fisica del tradimento sonoro

Per comprendere come funziona questa “spia acustica”, dobbiamo prima analizzare la meccanica del dispositivo che usiamo quotidianamente: la tastiera. Che si tratti di una tastiera meccanica di alta gamma o di quella a membrana di un laptop ultra-sottile, ogni tasto risiede in una posizione fisica diversa sulla piastra di supporto. Quando premiamo un tasto, generiamo un’onda sonora complessa. Questa non è costituita solo dal “clic” dell’interruttore, ma include la risonanza della scocca, il rumore dell’impatto del polpastrello e le micro-vibrazioni che si propagano attraverso il telaio del computer.

Per un orecchio umano, un tasto “T” e un tasto “Q” suonano praticamente identici. Tuttavia, per un sistema di intelligenza artificiale addestrato, questi due suoni sono distinti come il rosso e il blu. La posizione del tasto rispetto al microfono crea differenze infinitesimali nel tempo di arrivo del suono e nella sua intensità spettrale. L’architettura neurale dei moderni sistemi di ascolto non si limita a “sentire” il volume, ma analizza lo spettrogramma del suono: una rappresentazione visiva delle frequenze nel tempo. In questo grafico tridimensionale, la firma acustica della “T” possiede picchi di frequenza e decadimenti armonici unici, diversi da quelli della “Q”.

L’evoluzione degli algoritmi: dal Machine Learning ai Transformer

Fino a pochi anni fa, le tecniche di machine learning classico richiedevano condizioni di laboratorio per decifrare i tasti: microfoni ad alta fedeltà, silenzio assoluto e una fase di calibrazione specifica per ogni tastiera. Oggi, l’avvento dei modelli basati su architetture Transformer e l’evoluzione del Deep Learning hanno cambiato le regole del gioco. I modelli attuali, cugini lontani dei sistemi LLM come ChatGPT, non hanno bisogno di condizioni perfette.

Questi sistemi sono stati addestrati su vasti dataset di rumori di digitazione provenienti da migliaia di dispositivi diversi. Hanno imparato a filtrare il rumore di fondo, l’eco della stanza e persino la compressione audio aggressiva utilizzata dalle piattaforme di videoconferenza. Un recente benchmark condotto da ricercatori universitari ha dimostrato che un modello AI può indovinare i tasti premuti ascoltando l’audio di una chiamata Zoom con un’accuratezza superiore al 93%. Il sistema non si limita a riconoscere il singolo suono; utilizza modelli linguistici predittivi per correggere gli errori. Se l’AI sente qualcosa che assomiglia a “P-A-S-S-W-O-R…” e l’ultimo suono è ambiguo tra una “D” e una “S”, il modello probabilistico suggerirà “D”, completando la parola “PASSWORD” con una precisione spaventosa.

Il ruolo dell’automazione e dei dispositivi ubiqui

La pervasività di questa minaccia è amplificata dall’automazione e dalla diffusione capillare di microfoni nel nostro ambiente. Non è necessario che un attaccante installi un malware sul tuo computer. È sufficiente che abbia accesso a un flusso audio in cui si sente la tua tastiera. Questo può avvenire tramite una chiamata VoIP, un assistente vocale smart speaker posizionato sulla scrivania, o persino attraverso il giroscopio e l’accelerometro di uno smartphone appoggiato accanto alla tastiera, che possono rilevare le vibrazioni fisiche della digitazione.

La potenza di calcolo necessaria per eseguire questi attacchi è ormai alla portata di chiunque disponga di una GPU consumer di fascia media. Non servono supercomputer governativi. Un software open-source, alimentato da librerie di AI accessibili pubblicamente, può essere calibrato in pochi minuti. L’attaccante potrebbe registrare l’audio di una riunione pubblica, darlo in pasto all’algoritmo e ottenere la trascrizione non solo di ciò che è stato detto, ma di ciò che è stato digitato dai partecipanti che avevano il microfono aperto mentre prendevano appunti o chattavano privatamente.

Cosa succede se cambiamo il modo di digitare?

Una domanda sorge spontanea: possiamo ingannare l’AI cambiando il nostro stile di digitazione? In teoria, sì. Digitare in modo irregolare, variare la forza della pressione o utilizzare tastiere silenziose riduce l’efficacia dell’attacco. Tuttavia, l’intelligenza artificiale si adatta. I nuovi modelli di “Continuous Learning” possono aggiornare i loro parametri in tempo reale, imparando il nuovo stile dell’utente nel giro di pochi paragrafi. Inoltre, la ridondanza del linguaggio umano aiuta l’AI: anche se il riconoscimento acustico fallisce sul 20% dei tasti, i modelli linguistici (simili a quelli che alimentano i correttori automatici avanzati) possono ricostruire il testo mancante con estrema facilità.

È interessante notare come il progresso tecnologico abbia creato un paradosso: le tastiere meccaniche, amate da programmatori e gamer per il loro feedback tattile, sono le più vulnerabili a causa del loro profilo sonoro distintivo. Al contrario, le tastiere virtuali su touchscreen sono immuni a questo specifico vettore di attacco acustico, sebbene presentino altre vulnerabilità.

Strategie di difesa nell’era dell’ascolto digitale

Di fronte a questa “spia acustica”, la cybersecurity sta evolvendo. Le soluzioni non sono solo software, ma comportamentali. L’autenticazione a due fattori (2FA) o biometrica (impronta digitale, riconoscimento facciale) diventa non più un’opzione, ma una necessità assoluta, poiché rende inutile la sola password intercettata acusticamente. Inoltre, stanno emergendo software di soppressione del rumore basati su AI che non si limitano a cancellare il rumore di fondo, ma alterano specificamente le frequenze dei tasti in modo casuale, “avvelenando” i dati per chi ascolta senza disturbare l’orecchio umano.

In Breve (TL;DR)

Sofisticati modelli di Deep Learning trasformano il banale ticchettio della tastiera in testo perfettamente leggibile.

Gli algoritmi riconoscono la firma acustica unica di ogni tasto, ignorando rumori di fondo e disturbi.

Digitare durante le videochiamate espone le password a rischi elevati con un’accuratezza superiore al 93%.

Conclusioni

La curiosità verso la “spia acustica” ci svela una verità fondamentale sul nostro rapporto con la tecnologia nel 2026: ogni interazione fisica con una macchina lascia una traccia digitale, spesso invisibile ai nostri sensi ma lampante per un algoritmo. L’intelligenza artificiale e il Deep Learning hanno trasformato il suono ambientale in una miniera di dati sensibili. Non dobbiamo cedere alla paranoia, ma acquisire una nuova consapevolezza. Il rumore banale delle nostre dita non è più solo il sottofondo del nostro lavoro; è un flusso di informazioni che richiede protezione. In un mondo dove i muri hanno orecchie digitali, il silenzio – o almeno, la consapevolezza del rumore – è diventato la forma più sofisticata di sicurezza.

Domande frequenti

Questa tecnica di spionaggio utilizza algoritmi di Deep Learning per analizzare le onde sonore generate dalla pressione dei tasti. Poiché ogni tasto produce una risonanza unica in base alla sua posizione fisica sulla scocca, il software riesce a distinguere i suoni e a convertirli in testo scritto, permettendo di decifrare password e messaggi semplicemente ascoltando l audio ambientale.

Assolutamente sì, digitare credenziali mentre il microfono è attivo su piattaforme come Zoom o Teams espone a seri rischi di sicurezza. I moderni sistemi di intelligenza artificiale possono filtrare i rumori di fondo e ricostruire il testo digitato con una precisione superiore al 93 percento, rendendo il suono della tastiera un dato sensibile facilmente intercettabile.

La strategia difensiva migliore consiste nell adottare autenticazione a due fattori o biometrica, che rende inutile il solo possesso della password intercettata. È anche utile impiegare software che alterano le frequenze audio in uscita o semplicemente evitare di inserire dati riservati durante le chiamate VoIP con microfono aperto.

No, le tastiere meccaniche risultano essere le periferiche più vulnerabili a causa del loro profilo sonoro forte e distintivo, che facilita il riconoscimento da parte degli algoritmi. Per evitare questo specifico rischio, le tastiere virtuali su touchscreen rappresentano una soluzione più sicura poiché non emettono rumori meccanici analizzabili.

I modelli attuali basati su architetture Transformer sono estremamente sofisticati e non necessitano di silenzio assoluto. Essi sono in grado di isolare il suono della digitazione anche in ambienti rumorosi e utilizzano modelli linguistici predittivi per correggere gli errori e completare le parole, garantendo un alta efficacia anche in condizioni non ideali.

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.