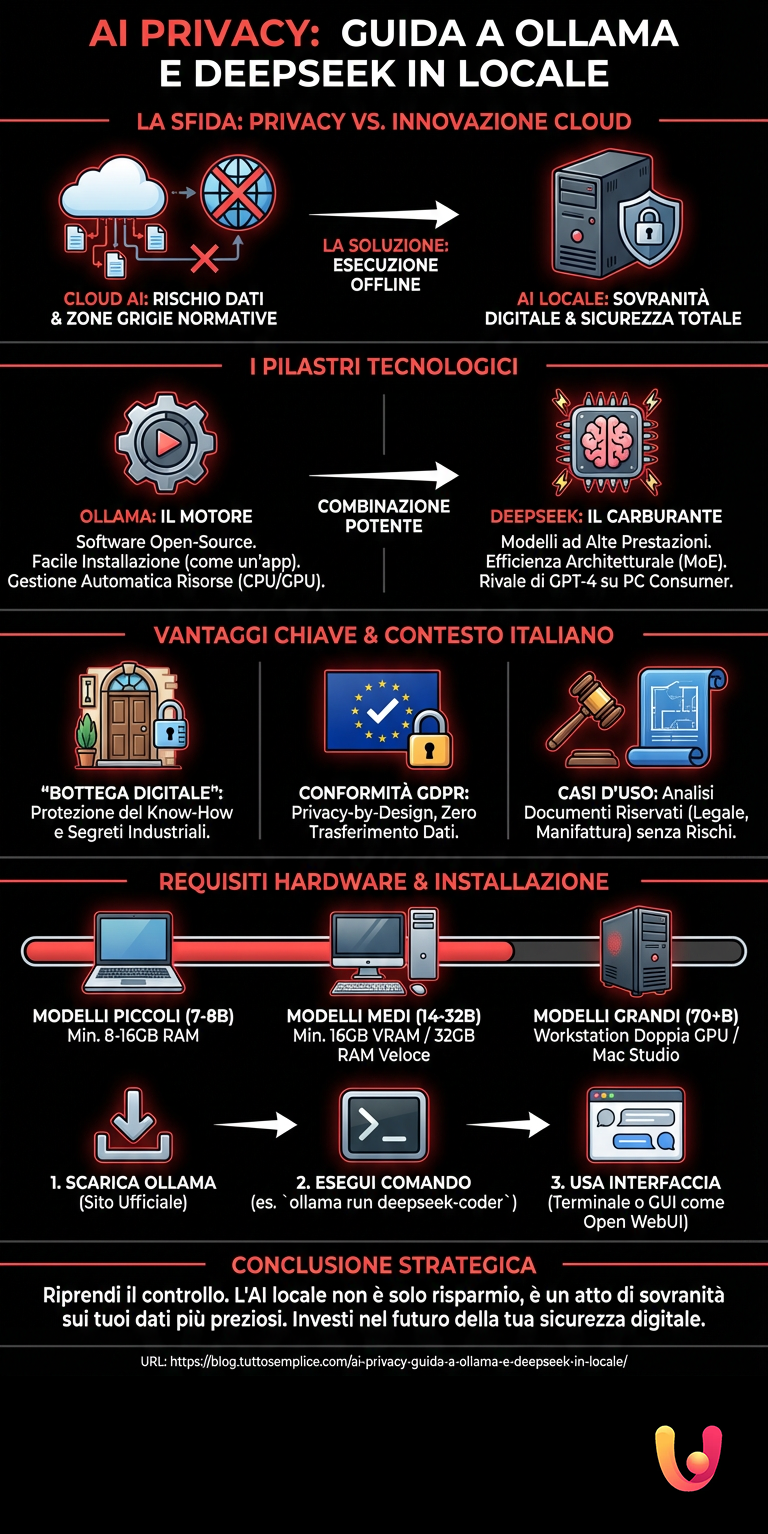

La privacy digitale è diventata la nuova frontiera della sicurezza personale e aziendale in Italia e in Europa. L’entusiasmo per l’intelligenza artificiale generativa si scontra spesso con il timore legittimo di condividere dati sensibili con server situati oltreoceano. Esiste però una soluzione che unisce innovazione tecnologica e la tradizionale riservatezza: l’AI locale.

Eseguire modelli linguistici direttamente sul proprio computer non è più un’esclusiva degli ingegneri informatici. Strumenti come Ollama e modelli avanzati come DeepSeek hanno democratizzato questa tecnologia. Ora è possibile avere un assistente virtuale potente quanto quelli commerciali, ma completamente offline e sotto il vostro controllo esclusivo.

Questo approccio risuona profondamente con la cultura imprenditoriale italiana e mediterranea. Pensiamo alla “bottega” artigiana, dove i segreti del mestiere vengono custoditi gelosamente tra le mura del laboratorio. L’AI locale permette di modernizzare questo concetto, portando l’innovazione nei processi produttivi senza mai esporre il proprio know-how a terze parti.

L’adozione di sistemi AI locali non è solo una scelta tecnica, ma un atto di sovranità digitale che protegge il valore unico del Made in Italy nell’era dei Big Data.

Il contesto europeo: GDPR e sovranità dei dati

L’Unione Europea si è distinta a livello globale per la sua attenzione alla protezione dei dati dei cittadini. Il GDPR e il recente AI Act impongono regole severe su come le informazioni vengono trattate. Utilizzare servizi in cloud comporta spesso il trasferimento di dati, creando zone grigie normative che preoccupano aziende e professionisti.

L’AI locale elimina questo problema alla radice. I dati non lasciano mai il vostro disco rigido. Non c’è cloud, non c’è trasferimento, non c’è rischio di intercettazione o di utilizzo dei vostri dati per l’addestramento di modelli altrui. È la massima espressione della conformità privacy-by-design.

Per le aziende italiane, questo significa poter analizzare bilanci, contratti legali o brevetti industriali con l’aiuto dell’AI, senza il timore che queste informazioni finiscano in mani sbagliate. È un ritorno alla gestione diretta delle risorse, un valore cardine della nostra tradizione economica.

Ollama: Il motore dell’AI sul tuo PC

Ollama rappresenta la svolta per l’accessibilità dell’intelligenza artificiale su hardware di consumo. Si tratta di un software open-source progettato per semplificare drasticamente il processo di installazione e gestione dei modelli linguistici (LLM) in locale. Prima di Ollama, configurare un’AI richiedeva competenze avanzate in Python e gestione delle dipendenze.

Oggi, con Ollama, l’esperienza è paragonabile all’installazione di una qualsiasi app. Supporta nativamente macOS, Linux e Windows, rendendolo versatile per ogni ambiente di lavoro. Funziona da “motore” che esegue i “modelli”, gestendo in autonomia l’allocazione delle risorse hardware, come la memoria RAM e la potenza della scheda video.

Se volete approfondire come configurare questo strumento specifico, vi consigliamo di leggere la guida su AI sul tuo PC gratis e offline con Ollama, che dettaglia i passaggi tecnici iniziali.

DeepSeek: L’innovazione che sfida i giganti

Se Ollama è il motore, DeepSeek è il carburante ad alte prestazioni. DeepSeek è una famiglia di modelli di linguaggio che ha scosso il mercato per la sua incredibile efficienza e capacità di ragionamento. In particolare, i modelli “Coder” e “MoE” (Mixture of Experts) offrono prestazioni paragonabili a GPT-4 in molti task, pur essendo eseguibili su computer domestici potenti.

La particolarità di DeepSeek risiede nella sua architettura. Invece di attivare l’intero “cervello” digitale per ogni domanda, attiva solo gli esperti necessari per quella specifica richiesta. Questo riduce il consumo di risorse e velocizza le risposte, rendendolo ideale per l’uso in locale dove l’hardware è limitato rispetto ai data center.

Per capire come si posiziona questo modello rispetto ai concorrenti cloud, è utile consultare il confronto nella guida pratica alla migliore AI del 2025.

Tradizione e Innovazione: Casi d’uso in Italia

L’integrazione di AI locale si sposa perfettamente con il tessuto economico italiano, fatto di PMI e studi professionali. Immaginate uno studio legale che deve analizzare centinaia di documenti riservati. Caricarli su una piattaforma pubblica violerebbe il segreto professionale. Con DeepSeek che gira su un server locale sicuro, l’analisi avviene in casa, velocizzando il lavoro senza rischi.

Anche nel settore manifatturiero e artigianale c’è spazio per questa tecnologia. Un’azienda di design può utilizzare l’AI per generare descrizioni di prodotti o traduzioni tecniche, mantenendo i cataloghi inediti al sicuro fino al lancio ufficiale. È l’equivalente digitale del chiudere la porta della bottega a chiave.

Inoltre, l’indipendenza dalla connessione internet garantisce continuità operativa. In molte aree d’Italia dove la banda larga può avere interruzioni, avere un’intelligenza artificiale residente sulla macchina assicura che il lavoro non si fermi mai.

Requisiti Hardware: Cosa serve davvero

Eseguire un modello come DeepSeek in locale richiede risorse. Non basta un vecchio portatile da ufficio. Il componente critico è la memoria RAM, e più specificamente la VRAM della scheda video se si vuole velocità. I modelli di linguaggio devono essere “caricati” nella memoria per funzionare.

Ecco una stima indicativa delle risorse necessarie:

- Modelli piccoli (7-8 Miliardi di parametri): Minimo 8GB di RAM (16GB consigliati). Girano bene su molti laptop moderni.

- Modelli medi (14-32 Miliardi di parametri): Minimo 16GB di VRAM o 32GB di RAM di sistema veloce (es. Apple Silicon).

- Modelli grandi (70+ Miliardi di parametri): Richiedono workstation professionali con doppia GPU o Mac Studio con molta memoria unificata.

Investire nell’hardware giusto oggi significa risparmiare sui costi di abbonamento mensili delle API domani, garantendosi al contempo la totale proprietà dei dati.

Per una panoramica dettagliata sulle specifiche tecniche per supportare questi carichi di lavoro, consultate la nostra guida completa hardware e software per AI.

Installazione passo dopo passo: Una sintesi

Il processo per avviare il vostro sistema di AI locale è sorprendentemente lineare. La barriera tecnica si è abbassata notevolmente nell’ultimo anno. Ecco la logica di base per iniziare a sperimentare subito.

Primo, scaricate e installate Ollama dal sito ufficiale. Una volta installato, aprite il terminale del vostro computer. Non abbiate paura della riga di comando: i comandi sono semplici e intuitivi. Digitando un comando come ollama run deepseek-coder, il software scaricherà automaticamente il modello e aprirà una chat.

Da quel momento, tutto ciò che scrivete rimane sulla vostra macchina. Potete staccare il cavo di rete e l’AI continuerà a rispondervi. Per chi cerca una sicurezza a 360 gradi, suggeriamo di leggere anche come proteggere privacy e dati online in modo più ampio.

Interfacce Utente: Rendere l’AI amichevole

Sebbene il terminale sia potente, molti utenti preferiscono un’interfaccia grafica simile a ChatGPT. Fortunatamente, l’ecosistema open source offre molteplici soluzioni che si collegano a Ollama. Software come “Open WebUI” o “LM Studio” offrono un’esperienza visiva curata e familiare.

Queste interfacce permettono di organizzare le chat, salvare la cronologia e persino caricare documenti (PDF, Word) affinché l’AI li analizzi. Tutto questo avviene sempre in locale. È possibile creare un “Knowledge Base” aziendale dove l’AI risponde basandosi sui vostri manuali interni, senza che questi escano mai dall’ufficio.

Questa configurazione è ideale per chi deve gestire dati sensibili ma vuole la comodità delle moderne chat AI. Per approfondire le implicazioni di sicurezza dei chatbot, vi rimandiamo alla nostra guida sicura ai chatbot e privacy.

In Breve (TL;DR)

Impara a installare ed eseguire modelli AI in locale con Ollama e DeepSeek per garantire la massima privacy delle tue informazioni.

Scopri come installare ed eseguire modelli di linguaggio sul tuo computer per garantire la massima privacy dei tuoi dati.

Scopri come eseguire modelli AI direttamente sul tuo computer per garantire la massima protezione e riservatezza dei tuoi dati.

Conclusioni

L’adozione di AI locale tramite strumenti come Ollama e modelli come DeepSeek rappresenta un punto di svolta per il mercato italiano ed europeo. Offre una sintesi perfetta tra la necessità di innovazione tecnologica e la cultura della riservatezza e della protezione dei dati che ci contraddistingue.

Non si tratta solo di risparmiare sui costi di abbonamento o di operare offline. Si tratta di riprendere il controllo delle proprie informazioni in un’epoca in cui i dati sono il bene più prezioso. Che siate professionisti, creativi o imprenditori, investire tempo nella configurazione di un’AI locale è un passo strategico verso il futuro.

La tecnologia è pronta e accessibile. La sfida ora è culturale: passare dall’essere consumatori passivi di servizi cloud a custodi attivi della propria intelligenza digitale. La tradizione della “bottega” italiana può rivivere nel digitale, più forte e sicura che mai.

Domande frequenti

No, l’installazione è semplice e guidata come per qualsiasi altro software. Richiede solo l’uso di un comando base nel terminale per scaricare e avviare il modello desiderato.

Non necessariamente. I modelli più leggeri funzionano su laptop standard con 8-16GB di RAM, mentre per le versioni più avanzate è consigliata una scheda video dedicata o un processore Apple Silicon.

Sì, la privacy è totale perché il modello funziona offline direttamente sul tuo hardware. Nessun dato viene inviato a server esterni o cloud, garantendo la massima riservatezza.

Sì, DeepSeek è un modello multilingue con ottime capacità in italiano, adatto per la stesura di testi, l’analisi e la conversazione nel nostro contesto linguistico.

L’utilizzo è completamente gratuito. Sia il software Ollama che i modelli DeepSeek sono open-source o liberamente scaricabili; l’unico costo è quello dell’hardware utilizzato.

Hai ancora dubbi su AI Privacy: Guida a Ollama e DeepSeek in Locale?

Digita qui la tua domanda specifica per trovare subito la risposta ufficiale di Google.

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.