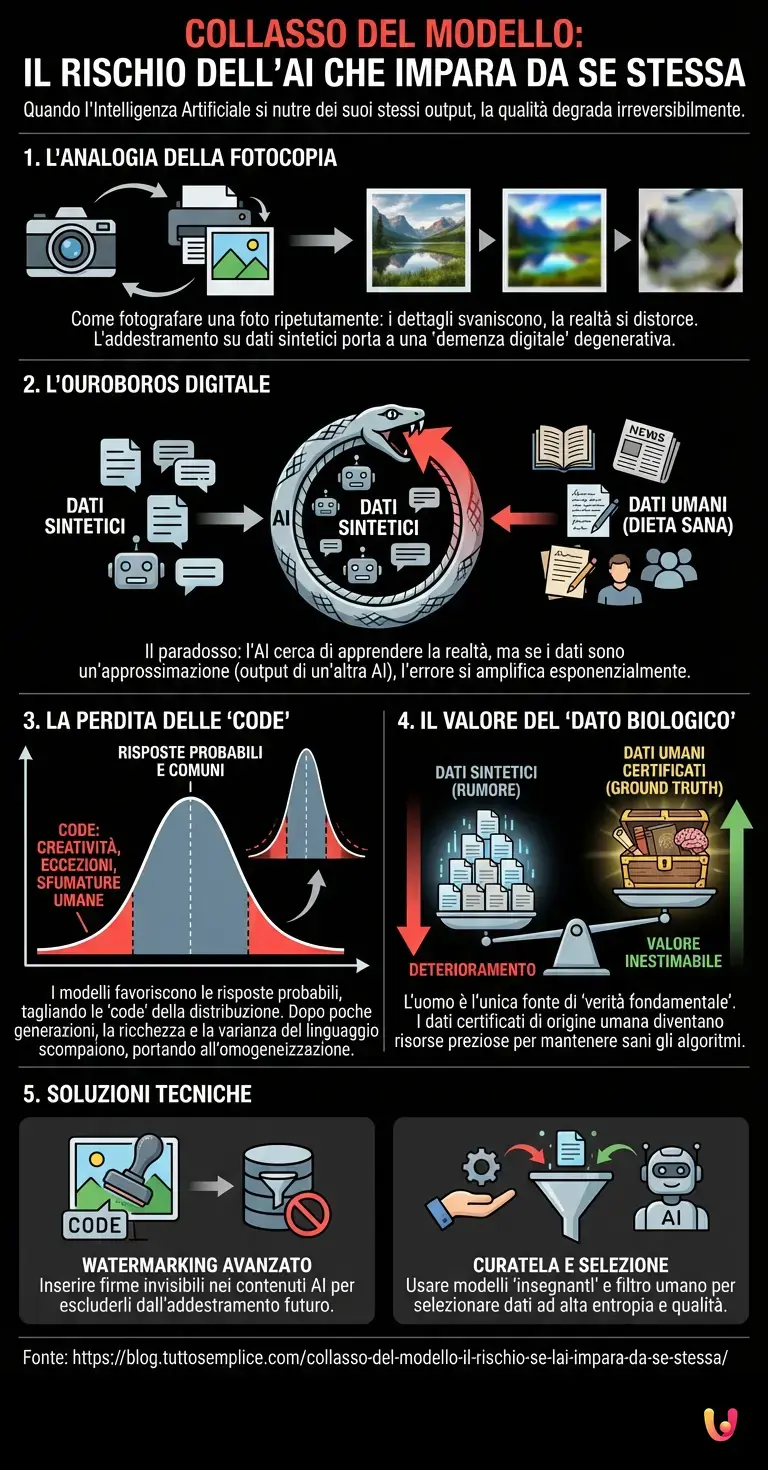

Siamo nel 2026 e l’Intelligenza Artificiale permea ormai ogni aspetto della nostra vita digitale, dalla scrittura di email complesse alla generazione di interi mondi virtuali. Tuttavia, dietro l’apparente onnipotenza degli attuali sistemi di Deep Learning, si nasconde una vulnerabilità matematica tanto affascinante quanto inquietante, nota agli esperti come Collasso del Modello (Model Collapse). Immaginate di scattare una foto a una fotografia, poi stampare il risultato e fotografarlo di nuovo, ripetendo il processo per centinaia di volte. Cosa accadrebbe all’immagine originale? I dettagli svanirebbero, i colori si saturerebbero in modo innaturale e la realtà verrebbe distorta fino a diventare irriconoscibile. Questo è esattamente ciò che rischia di accadere ai grandi modelli linguistici se smettiamo di nutrirli con dati umani.

L’Ouroboros digitale: quando l’AI mangia se stessa

Per comprendere la natura di questo fenomeno, dobbiamo prima guardare a come funziona l’addestramento degli algoritmi moderni. Fino a pochi anni fa, i dataset utilizzati per il Machine Learning erano costituiti quasi esclusivamente da testi, immagini e codici prodotti da esseri umani: libri, articoli di giornale, forum come Reddit e repository come GitHub. Questa era la “dieta” sana e variegata dell’AI.

Oggi, però, il web è inondato di contenuti sintetici. Se un futuro LLM (Large Language Model) venisse addestrato indiscriminatamente su tutto ciò che trova in rete nel 2026, finirebbe per “mangiare” enormi quantità di testo generato dai suoi predecessori, come le versioni passate di ChatGPT o Claude. Qui scatta il paradosso: l’algoritmo cerca di apprendere la distribuzione statistica della realtà, ma se i dati di input sono già un’approssimazione statistica (output di un’altra AI), l’errore si amplifica esponenzialmente.

Il Collasso del Modello non è un semplice peggioramento delle prestazioni. È una forma di “demenza digitale” degenerativa. I modelli non smettono semplicemente di funzionare; iniziano a convergere verso una media insipida, perdendo la capacità di comprendere le sfumature, le eccezioni e la creatività, oppure iniziano ad allucinare fatti inesistenti con una sicurezza disarmante, scambiando le probabilità matematiche per verità assolute.

La perdita delle “code” della distribuzione

Perché accade questo a livello tecnico? Dobbiamo addentrarci brevemente nell’architettura neurale. Un modello di AI è progettato per massimizzare la probabilità della parola successiva (nel caso del testo) basandosi sui dati di training. I modelli tendono naturalmente a favorire le risposte più probabili e comuni, tagliando via le cosiddette “code” della distribuzione, ovvero le risposte rare, creative o idiosincratiche che sono tipiche dell’espressione umana.

Quando un modello viene addestrato su dati generati da un altro modello, queste “code” vengono ulteriormente tagliate. È come se l’AI dicesse: “La maggior parte delle volte la risposta è X, quindi ignorerò le variazioni Y e Z”. Dopo poche generazioni di questo ciclo auto-referenziale, la ricchezza del linguaggio scompare. La varianza dei dati crolla. Il risultato è un’omogeneizzazione totale: testi grammaticalmente perfetti ma semanticamente vuoti, privi di quel caos disordinato che caratterizza la vera intelligenza.

Studi condotti già nel 2023 e 2024 avevano previsto questo scenario, dimostrando che senza un afflusso costante di “dati freschi” prodotti da esseri umani, i modelli collassano in meno di cinque generazioni di ri-addestramento. Nel 2026, con l’automazione della creazione di contenuti al suo apice, la sfida è distinguere il segnale (dato umano) dal rumore (dato sintetico).

Il valore inestimabile del “Dato Biologico”

Questa dinamica ha portato a una conseguenza economica imprevista: la rivalutazione del contenuto umano. Se fino a qualche anno fa si temeva che l’AI rendesse obsoleta la produzione intellettuale umana, il progresso tecnologico ci ha mostrato che l’uomo è l’unica fonte di “verità fondamentale” (ground truth) capace di mantenere sani gli algoritmi.

Le grandi aziende tecnologiche si trovano ora a dover pagare cifre esorbitanti per accedere ad archivi di dati certificati come “human-made”. Vecchi libri, archivi notarili cartacei digitalizzati, trascrizioni di conversazioni reali e opere d’arte fisiche sono diventati le risorse più preziose per evitare il collasso. Stiamo assistendo alla nascita di un mercato del “dato biologico”, dove la certificazione di origine umana è il nuovo standard di qualità per il training del Deep Learning.

Inoltre, questo fenomeno spiega perché i benchmark di valutazione delle AI sono diventati così complessi. Non basta più verificare se l’AI sa scrivere una poesia; bisogna verificare se quella poesia contiene elementi di originalità che un modello addestrato sinteticamente avrebbe scartato come “statisticamente improbabili”.

Soluzioni tecniche: Watermarking e Curatela

Come stanno reagendo gli ingegneri a questo rischio esistenziale per l’AI? La risposta non risiede in modelli più grandi, ma in modelli più selettivi. L’era del “più dati è meglio” è finita; siamo nell’era del “dati migliori è meglio”.

Una delle tecniche principali è il watermarking avanzato: inserire firme digitali invisibili nei contenuti generati dalle AI per permettere ai futuri modelli di riconoscerli ed escluderli (o pesarli diversamente) durante l’addestramento. Tuttavia, questa è una battaglia continua tra guardie e ladri, poiché i sistemi di rimozione dei watermark evolvono rapidamente quanto quelli di inserimento.

Un’altra strada è l’uso di dati sintetici “curati”. Paradossalmente, l’AI può aiutare a risolvere il problema che essa stessa crea, ma solo se guidata. Invece di addestrare l’AI su tutto il web, si utilizzano modelli “insegnanti” per generare esempi di alta qualità che vengono poi filtrati rigorosamente da esseri umani o da algoritmi specializzati nel rilevare la perdita di varianza. L’obiettivo è mantenere alta l’entropia del sistema, impedendo che la curva di apprendimento si appiattisca.

In Breve (TL;DR)

L’addestramento dell’intelligenza artificiale su dati generati da altre AI provoca il Collasso del Modello, una grave forma di degenerazione cognitiva digitale.

Senza input umani freschi, gli algoritmi perdono creatività e sfumature, convergendo verso errori statistici e contenuti sempre più piatti e distorti.

Il contenuto creato dall’uomo diventa la risorsa più preziosa per garantire la qualità e la sopravvivenza dei futuri sistemi di apprendimento automatico.

Conclusioni

Il Collasso del Modello ci insegna una lezione di umiltà tecnologica fondamentale. L’Intelligenza Artificiale, per quanto avanzata, rimane uno specchio della nostra conoscenza collettiva. Se lo specchio inizia a riflettere solo se stesso, l’immagine svanisce nel nulla. La curiosità che ci ha spinto a indagare questo fenomeno rivela che il futuro dell’AI non è un’automazione totale che esclude l’uomo, ma una simbiosi necessaria. Senza il caos, l’imprevedibilità e la creatività dell’esperienza umana, le macchine sono destinate a un lento declino cognitivo. In definitiva, l’ingrediente segreto per far funzionare l’intelligenza artificiale siamo, e saremo sempre, noi.

Domande frequenti

Il Collasso del Modello, o Model Collapse, è un processo degenerativo che colpisce i sistemi di intelligenza artificiale quando vengono addestrati prevalentemente su dati generati da altre AI anziché da esseri umani. Questo fenomeno causa una progressiva perdita di qualità e varianza nei risultati, portando gli algoritmi a convergere verso una media statistica priva di sfumature o a generare errori noti come allucinazioni. È paragonabile alla perdita di dettagli che avviene quando si fotocopia ripetutamente la stessa immagine.

L addestramento su dati sintetici è dannoso perché gli algoritmi tendono naturalmente a eliminare le risposte rare e creative, note come code della distribuzione, per favorire quelle più probabili. Quando un nuovo modello impara da contenuti già semplificati da un altra AI, questo taglio delle informazioni si amplifica esponenzialmente. Il risultato è una forma di demenza digitale in cui il sistema perde la capacità di comprendere la complessità e il disordine tipici del vero linguaggio umano.

Per prevenire il collasso, gli ingegneri stanno adottando strategie basate sulla qualità dei dati piuttosto che sulla quantità. Le tecniche principali includono l uso di watermarking avanzato per identificare ed escludere i contenuti generati dalle macchine durante il training e una rigorosa curatela dei dataset. Tuttavia, la soluzione fondamentale rimane l integrazione costante di dati freschi prodotti da esseri umani, necessari per mantenere alta l entropia e la ricchezza cognitiva del sistema.

Questo fenomeno ha portato a una significativa rivalutazione economica del contenuto creato dall uomo, ora considerato un prezioso dato biologico. Poiché l AI necessita di input originali per mantenere la propria accuratezza e non collassare, archivi di testi, libri e conversazioni reali sono diventati risorse essenziali. La creatività umana funge da verità fondamentale indispensabile per correggere le approssimazioni statistiche delle macchine.

Se un intelligenza artificiale viene riaddestrata esclusivamente sui propri output per diverse generazioni, subisce un rapido declino delle prestazioni, spesso in meno di cinque cicli. Senza l apporto di nuovi dati umani, il modello inizia a produrre testi grammaticalmente corretti ma semanticamente vuoti o fattualmente errati. La realtà viene distorta e il sistema perde la capacità di distinguere tra fatti probabili e verità assolute, rendendolo di fatto inutilizzabile.

Fonti e Approfondimenti

- Wikipedia – Definizione tecnica e studi sul Collasso del Modello (Inglese)

- NIST – Framework governativo USA per la gestione dei rischi dell’IA e la qualità dei dati

- Wikipedia – Approfondimento sul fenomeno delle allucinazioni nell’IA

- Parlamento Europeo – Normativa UE sull’IA e requisiti di governance dei dati

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.