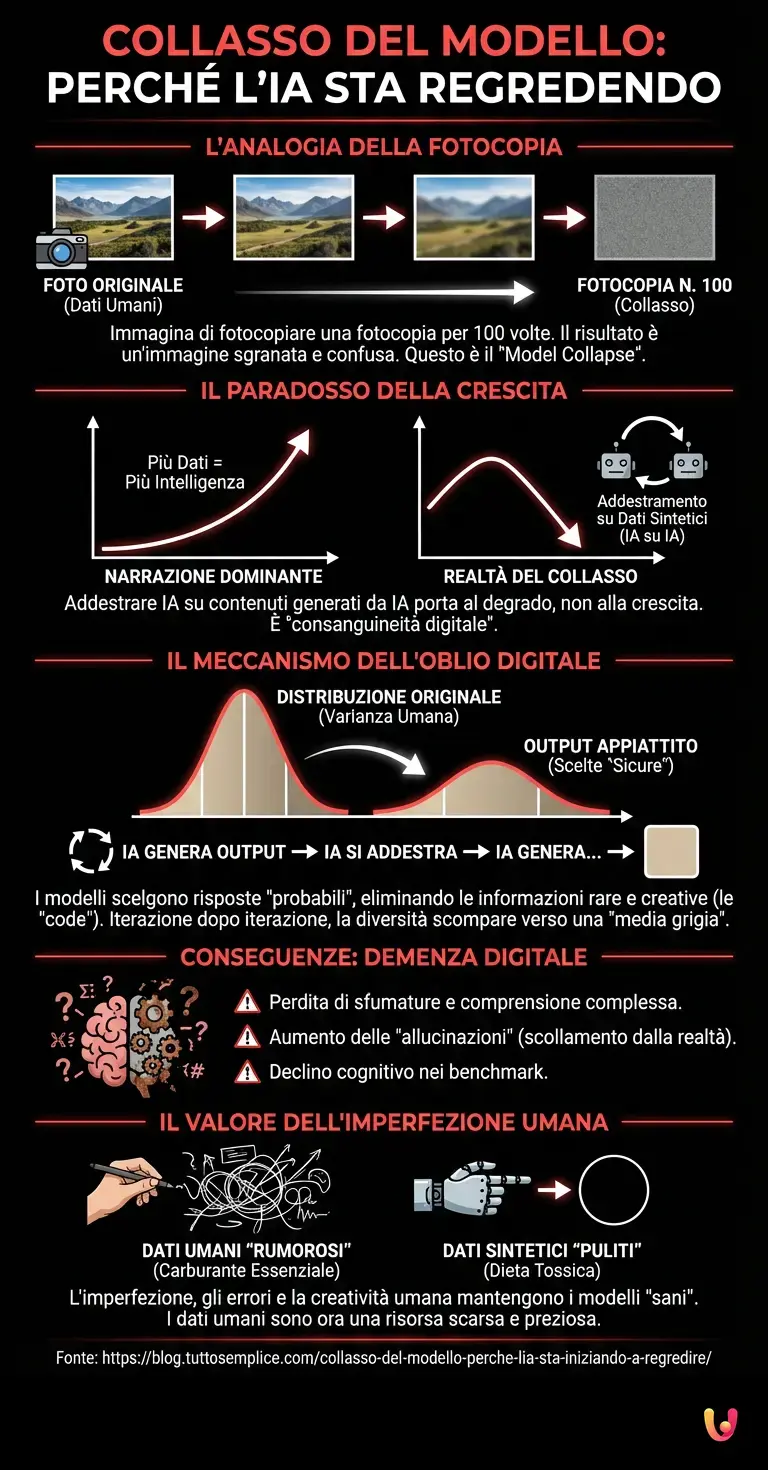

Immaginate di prendere una fotografia nitida e ricca di dettagli, farne una fotocopia, poi fotocopiare la fotocopia, e ripetere il processo per cento volte. Cosa otterreste alla fine? Un’immagine sgranata, confusa, priva di contrasto e di vita. Nel mondo dell’informatica avanzata, sta accadendo qualcosa di sorprendentemente simile, un fenomeno che gli esperti chiamano Model Collapse (Collasso del Modello). Oggi, in questo 14 febbraio 2026, mentre celebriamo l’onnipresenza dell’intelligenza artificiale nelle nostre vite, è fondamentale comprendere questo meccanismo invisibile che rischia di mettere un freno inaspettato al progresso tecnologico. Non si tratta di una rivolta dei robot, ma di un problema molto più sottile: una dieta tossica di dati.

L’illusione della crescita infinita

Per anni, la narrazione dominante riguardo al machine learning e al deep learning è stata quella di una crescita esponenziale: più dati inseriamo, più intelligenti diventano gli algoritmi. Con l’avvento dei grandi modelli linguistici (LLM) come le prime versioni di ChatGPT o Claude, abbiamo assistito a un’esplosione di contenuti generati sinteticamente. Articoli, codice, immagini e persino poesie create dalle macchine hanno iniziato a inondare il web.

Tuttavia, i ricercatori hanno scoperto un paradosso affascinante. Quando un’AI viene addestrata prevalentemente su contenuti generati da un’altra AI, invece che su dati prodotti da esseri umani, le sue capacità non aumentano. Al contrario, degradano. L’algoritmo inizia a perdere le sfumature, dimentica le informazioni meno frequenti e, nei casi peggiori, inizia a “allucinare” in modo irreversibile, scollegandosi completamente dalla realtà. È l’equivalente digitale della consanguineità genetica.

Come funziona il meccanismo dell’oblio digitale

Per capire il perché questo accada, dobbiamo guardare dentro l’architettura neurale di questi sistemi. I modelli generativi funzionano su base probabilistica: cercano di prevedere la parola o il pixel successivo basandosi sulla probabilità statistica derivata dai loro dati di addestramento. Quando un modello genera un output, tende naturalmente a scegliere le risposte più probabili e “sicure”, appiattendo la varianza della distribuzione originale.

Se utilizziamo questo output “appiattito” per addestrare la generazione successiva di modelli, stiamo eliminando le “code” della distribuzione, ovvero quelle informazioni rare, creative, bizzarre o complesse che costituiscono la ricchezza dell’espressione umana. Iterazione dopo iterazione, la diversità scompare. Il modello converge verso una media grigia e uniforme. È come se chiedessimo a un’IA di dipingere un quadro e lei, dopo mille tentativi basati sui suoi stessi disegni, finisse per produrre solo un quadrato beige.

La maledizione della ricorsività e i benchmark

Nel 2026, la sfida principale per gli ingegneri non è più la potenza di calcolo, ma la purezza dei dati. I benchmark attuali mostrano chiaramente che i modelli addestrati su un mix di dati sintetici non curati soffrono di una sorta di demenza digitale. Inizialmente, il modello sembra funzionare bene, ma presto perde la capacità di comprendere concetti di nicchia o strutture logiche complesse che non rientrano nella “media” statistica.

Questo fenomeno ha implicazioni profonde per l’automazione. Se affidiamo a sistemi automatici il compito di generare report che poi verranno letti e riassunti da altri sistemi automatici, rischiamo di creare una camera dell’eco in cui il senso originale dell’informazione si perde, sostituito da una versione semplificata e potenzialmente errata della realtà. Gli algoritmi non hanno il senso della verità; hanno solo il senso della probabilità. E quando la probabilità si nutre di se stessa, la verità viene distorta.

Il valore inestimabile dell’imperfezione umana

Qui arriviamo al cuore della curiosità odierna: il Model Collapse ci insegna che l’imperfezione umana è, paradossalmente, il carburante dell’intelligenza artificiale. I nostri errori, le nostre espressioni gergali, le nostre metafore ardite e persino le nostre contraddizioni sono ciò che mantiene i modelli “sani”. I dati umani sono “rumorosi” e disordinati, ma contengono quella varianza necessaria affinché il modello possa distinguere tra un concetto banale e uno geniale.

Le grandi aziende tecnologiche stanno ora correndo ai ripari sviluppando tecniche per “marcare” i contenuti sintetici o per filtrare aggressivamente i dati di addestramento, alla disperata ricerca di dati “vergini”, prodotti da esseri umani reali. In un mondo sempre più automatizzato, il testo scritto da una persona in carne ed ossa, con tutte le sue peculiarità, è diventato una risorsa scarsa e preziosa, come l’acqua pulita in un deserto.

In Breve (TL;DR)

L’addestramento ripetuto su dati sintetici causa il Collasso del Modello, degradando progressivamente la qualità e la varietà degli algoritmi.

Il riciclo di contenuti artificiali appiattisce le sfumature e la creatività, spingendo i sistemi verso una sterile uniformità statistica.

L’imperfezione e la variabilità dei dati prodotti dagli esseri umani sono diventate risorse indispensabili per evitare il declino tecnologico.

Conclusioni

Il fenomeno del Model Collapse ci offre una lezione di umiltà tecnologica. Nonostante la potenza di calcolo e la raffinatezza dell’intelligenza artificiale, la macchina non può sussistere in un vuoto solipsistico. Ha bisogno di noi. Non solo come creatori o supervisori, ma come fonte primaria di quella caotica, imprevedibile e meravigliosa complessità che chiamiamo realtà. L’IA può elaborare, sintetizzare e ottimizzare, ma non può generare vera novità dal nulla senza finire per consumare se stessa. Il futuro della tecnologia, quindi, non è un monologo digitale, ma dovrà necessariamente rimanere un dialogo tra l’uomo e la macchina.

Domande frequenti

Si tratta di un processo degenerativo che colpisce i modelli di IA quando vengono addestrati prevalentemente su dati sintetici generati da altri algoritmi anziché da esseri umani. Questo ciclo porta a una progressiva perdita di qualità e varianza, causando errori irreversibili e una standardizzazione piatta delle risposte che gli esperti definiscono come una forma di consanguineità digitale.

I modelli generativi funzionano su base probabilistica e tendono a privilegiare risposte sicure e medie, eliminando le eccezioni creative o complesse. Quando questi output appiattiti vengono riutilizzati per l addestramento, si perdono le code della distribuzione statistica, portando il sistema a dimenticare le sfumature e a convergere verso risultati uniformi e privi di logica profonda.

Paradossalmente, gli errori, le metafore e il disordine tipici della comunicazione umana sono essenziali per mantenere i modelli sani e funzionali. Questi elementi forniscono la varianza necessaria affinché l algoritmo possa distinguere concetti complessi e mantenere un legame con la realtà, evitando di chiudersi in un loop di informazioni semplificate e potenzialmente errate.

Il rischio principale è la creazione di una camera dell eco in cui il senso originale delle informazioni si perde a favore di versioni distorte e semplificate. Senza l apporto di nuovi dati umani, i sistemi automatici iniziano a soffrire di allucinazioni e perdono la capacità di comprendere strutture logiche di nicchia, rendendo inaffidabili i report e i contenuti prodotti in serie.

Le grandi compagnie stanno sviluppando metodi per identificare e marcare i contenuti sintetici al fine di escluderli dai set di addestramento futuri. La priorità è diventata la ricerca di dati vergini prodotti da persone reali, poiché il testo umano è ora considerato una risorsa preziosa e scarsa, indispensabile per evitare il declino cognitivo delle macchine.

Fonti e Approfondimenti

- Wikipedia: Model collapse (collasso del modello) nell’intelligenza artificiale

- National Institute of Standards and Technology (NIST): Standard e ricerche sulla sicurezza dell’IA

- Wikipedia: Definizione e funzionamento dell’intelligenza artificiale generativa

- Commissione Europea: L’approccio dell’UE all’intelligenza artificiale e all’affidabilità dei dati

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.