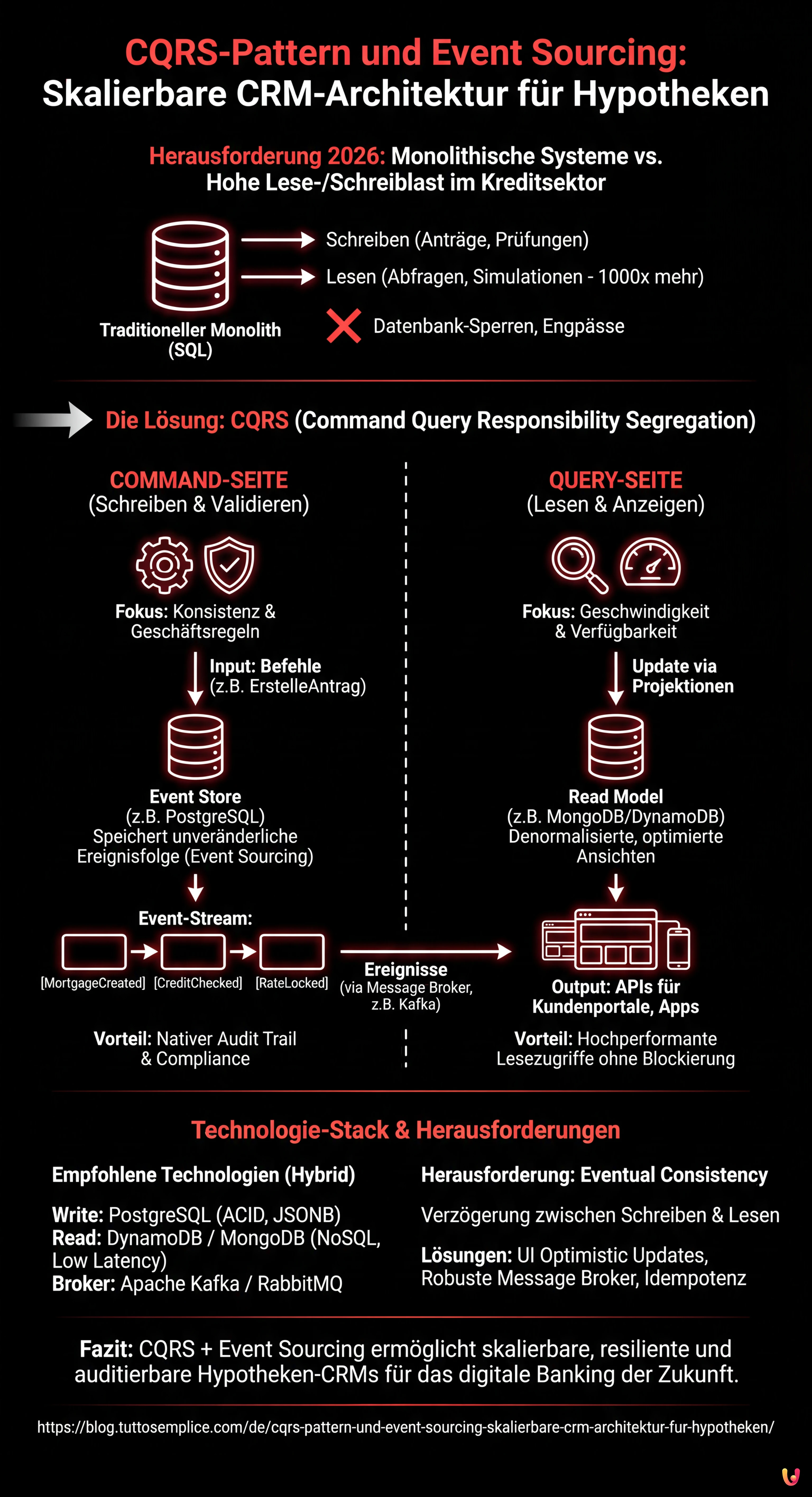

In der Software-Engineering-Landschaft des Jahres 2026 erfordert der Aufbau von CRM-Systemen (Customer Relationship Management) für den Kreditsektor einen Paradigmenwechsel weg von traditionellen monolithischen Architekturen. Die größte Herausforderung besteht nicht mehr nur in der Datenverwaltung, sondern in der Fähigkeit, Millionen von Leseanfragen (Zinsabfragen, Simulationen) zu bedienen, ohne die transaktionale Integrität der Schreibvorgänge (Antragserfassung, Kreditprüfung) zu beeinträchtigen. Genau hier wird das CQRS-Pattern (Command Query Responsibility Segregation) nicht nur nützlich, sondern unverzichtbar.

In diesem technischen Artikel untersuchen wir, wie Lese- und Schreibvorgänge entkoppelt werden können, um eine resiliente, auditierbare und hochleistungsfähige Infrastruktur speziell für das Hypothekenmanagement aufzubauen.

Was ist das CQRS-Pattern und warum ist es im Fintech vital?

Das CQRS-Pattern basiert auf einem von Bertrand Meyer definierten Grundprinzip: Eine Methode sollte entweder ein Befehl (Command) sein, der eine Aktion ausführt, oder eine Abfrage (Query), die Daten an den Aufrufer zurückgibt, aber niemals beides. In einem modernen Architekturkontext bedeutet dies die physische und logische Trennung des Schreibmodells (Command) vom Lesemodell (Query).

Das Problem des einheitlichen Modells bei Hypotheken

Stellen wir uns ein traditionelles Banken-CRM vor, das auf einer einzigen relationalen Datenbank basiert (z. B. SQL Server oder Oracle). Die Tabelle HypothekenAntraege ist zwei Arten von Belastungen ausgesetzt:

- Schreiben (Write): Back-Office-Mitarbeiter aktualisieren den Status des Antrags, laden Dokumente hoch und ändern die angewandten Zinssätze. Diese Operationen erfordern strikte ACID-Transaktionen.

- Lesen (Read): Kundenportale, mobile Apps und externe Vergleichsportale fragen das System kontinuierlich ab, um den Status des Antrags oder aktuelle Zinssätze zu erhalten. Das Verhältnis Lesen/Schreiben kann leicht 1000:1 überschreiten.

Die Verwendung desselben Datenmodells für beide Zwecke führt zu Datenbank-Sperren (Locks), Leistungsengpässen und Komplexität bei der Verwaltung komplexer Abfragen. CQRS löst dieses Problem durch die Schaffung von zwei getrennten Stacks.

CQRS-Architektur + Event Sourcing: Das Herzstück des Systems

Für ein Hypothekenverwaltungssystem entfaltet CQRS sein volles Potenzial, wenn es mit Event Sourcing kombiniert wird. Anstatt nur den aktuellen Status eines Antrags zu speichern (z. B. “Status: Genehmigt”), speichern wir die Abfolge der Ereignisse, die zu diesem Status geführt haben.

Die Command-Seite (Schreiben)

Das Schreibmodell ist für die Validierung der Geschäftsregeln verantwortlich. Es kümmert sich nicht darum, wie die Daten angezeigt werden, sondern nur darum, dass sie korrekt sind.

- Input: Befehle (z. B.

ErstelleHypothekenAntrag,GenehmigeEinkommen,FixiereZinssatz). - Persistenz: Event Store. Hier speichern wir keine aktualisierbaren Datensätze, sondern eine unveränderliche Reihe von Ereignissen.

- Empfohlene Technologie: Robuste relationale Datenbanken wie PostgreSQL oder spezifische Datenbanken für Time-Series/Events wie EventStoreDB.

Beispiel eines Ereignisflusses für einen einzelnen Antrag:

MortgageApplicationCreated(Payload: Stammdaten, beantragter Betrag)CreditCheckPassed(Payload: Kredit-Score)InterestRateLocked(Payload: Zinssatz 2,5%, Ablauf 30 Tage)

Dieser Ansatz garantiert einen nativen Audit Trail, eine grundlegende Anforderung für die Banken-Compliance (EZB/BaFin). Der Status des Antrags kann zu jedem beliebigen Zeitpunkt in der Vergangenheit rekonstruiert werden, indem einfach die Ereignisse bis zu diesem Datum erneut abgespielt werden.

Die Query-Seite (Lesen)

Das Lesemodell ist auf Geschwindigkeit und einfachen Zugriff optimiert. Die Daten sind denormalisiert und bereit, von APIs konsumiert zu werden.

- Aktualisierung: Erfolgt über “Projektionen”. Eine Komponente lauscht auf die von der Command-Seite ausgegebenen Ereignisse und aktualisiert die Leseansichten.

- Empfohlene Technologie: NoSQL-Datenbanken wie MongoDB oder Amazon DynamoDB.

Dank dieser Trennung fragt das Kundenportal, wenn es die Liste der aktiven Anträge anfordert, eine vorberechnete MongoDB-Collection ab, ohne jemals die transaktionale Datenbank zu berühren, in der die kritischen Schreibvorgänge stattfinden.

Technologie-Stack: Relational vs. NoSQL im CQRS-Kontext

Die Wahl des Stacks im Jahr 2026 ist nicht mehr “entweder oder”, sondern “das Beste für den spezifischen Zweck”.

Für das Write Model (Consistency First)

Hier haben referenzielle Integrität und starke Konsistenz Priorität. PostgreSQL bleibt aufgrund seiner Zuverlässigkeit und der nativen Unterstützung für JSONB, die das Speichern komplexer Event-Payloads unter Beibehaltung der ACID-Garantien ermöglicht, die erste Wahl.

Für das Read Model (Availability & Partition Tolerance)

Hier hat niedrige Latenz Priorität. DynamoDB (oder Cassandra für On-Premise-Installationen) zeichnet sich hier aus. Wir können verschiedene “Ansichten” (Materialized Views) basierend auf denselben Daten erstellen:

- Ansicht Sachbearbeiter: Optimiert für die Suche nach Nachname/Steuernummer.

- Ansicht Management-Dashboard: Vorberechnete Aggregate über Auszahlungsvolumina pro Region.

Ingenieurstechnische Herausforderungen: Synchronisation und Eventual Consistency

Die Implementierung des CQRS-Patterns führt eine nicht zu vernachlässigende Komplexität ein: die Eventual Consistency (schlussendliche Konsistenz). Da es eine Verzögerung (oft im Millisekundenbereich, potenziell aber Sekunden) zwischen dem Schreiben des Ereignisses und der Aktualisierung der Leseansicht gibt, sieht der Benutzer die Änderungen möglicherweise nicht sofort.

Mitigationsstrategien

1. Verwaltung der Benutzeroberfläche (UI Optimistic Updates)

Warten Sie nicht darauf, dass der Server die Aktualisierung der Leseansicht bestätigt. Wenn der Befehl 200 OK zurückgibt, sollte das Frontend den lokalen Status aktualisieren und den Erfolg der Operation annehmen.

2. Zuverlässige Message Broker

Um Command und Query zu synchronisieren, ist ein robuster Message Bus erforderlich. Apache Kafka oder RabbitMQ sind Industriestandards. Die Architektur muss die Reihenfolge der Ereignisse garantieren (um zu vermeiden, dass ein “Genehmigungs”-Ereignis vor der “Erstellung” verarbeitet wird) und Idempotenz sicherstellen (die doppelte Verarbeitung desselben Ereignisses darf die Daten nicht korrumpieren).

3. Versionierung von Ereignissen

Im Lebenszyklus einer CRM-Software ändert sich die Datenstruktur. Was passiert, wenn wir dem Ereignis PropertyDetailsUpdated ein Feld “Energieeffizienzklasse” hinzufügen? Es müssen Upcasting-Strategien implementiert werden, bei denen das System in der Lage ist, alte Versionen von Ereignissen zu lesen und sie on-the-fly in das neue Format zu konvertieren, bevor sie auf die Projektionen angewendet werden.

Praktische Implementierung: Beispiel eines Command Handlers

Hier ist ein logischer Pseudocode, wie ein Command Handler eine Zinsänderungsanfrage in einer CQRS-Architektur verarbeitet:

class ChangeRateHandler {

public void Handle(ChangeRateCommand command) {

// 1. Lädt den Event-Stream für diese Hypotheken-ID

var eventStream = _eventStore.LoadStream(command.MortgageId);

// 2. Rekonstruiert den aktuellen Status (Replay)

var mortgage = new MortgageAggregate(eventStream);

// 3. Führt die Domänenlogik aus (Validierung)

// Wirft eine Ausnahme, wenn der Status keine Zinsänderung erlaubt

mortgage.ChangeRate(command.NewRate);

// 4. Speichert die neu generierten Ereignisse

_eventStore.Append(command.MortgageId, mortgage.GetUncommittedChanges());

// 5. Veröffentlicht das Ereignis auf dem Bus, um die Read Models zu aktualisieren

_messageBus.Publish(mortgage.GetUncommittedChanges());

}

}

Kurz gesagt (TL;DR)

Die CQRS-Architektur überwindet die Grenzen monolithischer Systeme durch die logische und physische Trennung von Abfrageflüssen und Änderungsoperationen.

Die Integration von Event Sourcing sichert die vollständige Rückverfolgbarkeit von Hypothekenanträgen und garantiert regulatorische Compliance sowie Resilienz der historischen Daten.

Der strategische Einsatz differenzierter Technologien für Lesen und Schreiben bietet hohe Leistung und Skalierbarkeit, die für den modernen Fintech-Sektor unverzichtbar sind.

Der Teufel steckt im Detail. 👇 Lesen Sie weiter, um die kritischen Schritte und praktischen Tipps zu entdecken, um keine Fehler zu machen.

Fazit

Die Einführung des CQRS-Patterns in einem Hypotheken-CRM ist angesichts der erhöhten infrastrukturellen Komplexität keine Entscheidung, die leichtfertig getroffen werden sollte. Für Finanzinstitute, die jedoch über die Grenzen monolithischer relationaler Datenbanken hinaus skalieren wollen und unangreifbare Audit Trails mittels Event Sourcing benötigen, stellt dies den Stand der Technik im Software-Engineering dar.

Die klare Trennung zwischen dem Schreiben und dem Lesen von Daten ermöglicht es, jede Seite der Anwendung mit den am besten geeigneten Technologien zu optimieren (PostgreSQL für Sicherheit, NoSQL für Geschwindigkeit), und garantiert so ein System, das bereit für die Zukunft des digitalen Bankings ist.

Häufig gestellte Fragen

CQRS trennt das Schreibmodell strikt vom Lesemodell, im Gegensatz zu monolithischen Systemen, die eine einzige Datenbank für alles verwenden. Dies ermöglicht die Bewältigung hoher Volumina an Zins- und Antragsabfragen, ohne kritische Dateneingabeoperationen zu blockieren, was die Leistung des Banken-CRM drastisch verbessert.

Anstatt nur den Endstatus eines Antrags zu speichern, zeichnet die Event-Sourcing-Methodik jedes einzelne Ereignis in zeitlicher Abfolge auf. Dies garantiert eine vollständige und unveränderliche Nachverfolgung aller Operationen, eine oft unverzichtbare Anforderung für die regulatorische Compliance und zur Rekonstruktion der exakten Historie jeder Hypothek.

Es wird ein hybrider Ansatz empfohlen, der das Beste aus jeder Technologie nutzt. Für die Schreibseite ist eine robuste relationale Datenbank wie PostgreSQL ideal, die Datenintegrität sichert, während für die Leseseite NoSQL-Lösungen wie MongoDB oder DynamoDB bevorzugt werden, um sofortige Antworten auf API-Abfragen zu gewährleisten.

Die Verzögerung, bekannt als Eventual Consistency, wird durch optimistische Aktualisierungen der Benutzeroberfläche und die Verwendung robuster Message Broker wie Apache Kafka gemildert. Diese Tools synchronisieren die Lese- und Schreibmodelle und stellen sicher, dass die Daten korrekt und in chronologischer Reihenfolge ohne Informationsverlust abgeglichen werden.

Diese Architektur ermöglicht es, die Ressourcen für Lesen und Schreiben unabhängig voneinander basierend auf der tatsächlichen Last zu skalieren. Zudem erleichtert sie die Erstellung personalisierter Ansichten für verschiedene Nutzer, wie Back-Office-Mitarbeiter und Endkunden, ohne dass komplexe Abfragen das transaktionale Hauptsystem verlangsamen.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.