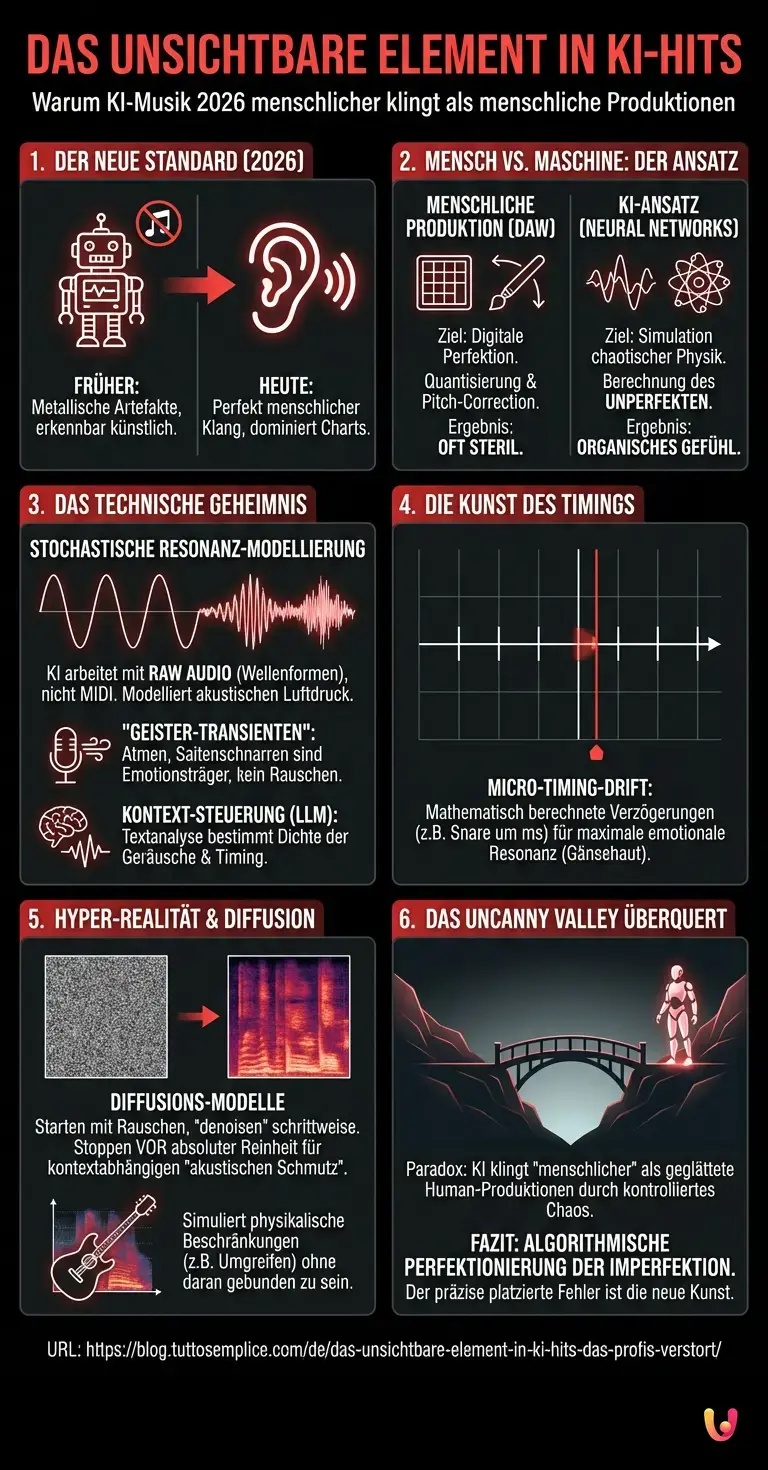

Wir schreiben den 17. Februar 2026. Ein Blick auf die globalen Streaming-Charts offenbart ein Bild, das vor wenigen Jahren noch als Science-Fiction galt: Drei der Top-5-Songs stammen nicht von menschlichen Künstlern, sondern wurden vollständig von Algorithmen komponiert, produziert und gemischt. Doch anders als in den frühen Tagen der Künstlichen Intelligenz, als Artefakte und metallische Verzerrungen die Herkunft verrieten, klingen diese Stücke heute nicht nur perfekt – sie klingen zu menschlich. Musikproduzenten und Komponisten weltweit stehen vor einem Rätsel. Sie analysieren die Spuren, zerlegen die Frequenzen und stoßen dabei auf ein spezifisches, technisches Detail, das sich jeder traditionellen Musiktheorie entzieht. Die Hauptentität dieses Phänomens, moderne Generative Audio-Modelle, hat eine Schwelle überschritten, die wir lange für unüberwindbar hielten: die Berechnung des Unperfekten.

Die Abkehr von der digitalen Perfektion

Um zu verstehen, was erfahrene Toningenieure derzeit in den Wahnsinn treibt, muss man zunächst verstehen, wie wir bisher Musikproduktion definiert haben. Seit der Einführung digitaler Audio-Workstations (DAWs) haben Menschen versucht, Perfektion zu erreichen. Wir nutzten Quantisierung, um Schlagzeugschläge exakt auf das Raster zu setzen, und Pitch-Correction, um jede gesungene Note auf die exakte Frequenz zu zwingen. Das Ergebnis war oft steril.

Die Ironie der Geschichte ist, dass Maschinelles Lernen und moderne Neural Networks genau den entgegengesetzten Weg eingeschlagen haben. Während Menschen versuchten, wie Maschinen zu klingen, lernten die Maschinen, die chaotische Physik der Realität zu simulieren. Das unheimliche Detail, das aktuelle KI-Hits auszeichnet, ist nicht die Melodie oder der Text – es ist die algorithmisch generierte Mikro-Inkonsistenz.

Das Geheimnis: Stochastische Resonanz-Modellierung

Das Detail, das menschliche Komponisten ratlos macht, ist die Fähigkeit der KI, sogenannte „Geister-Transienten“ zu erzeugen. In der technischen Analyse zeigt sich, dass aktuelle Generative AI-Systeme nicht mehr auf der Basis von Noten (MIDI) arbeiten, sondern auf der Ebene roher Wellenformen (Raw Audio). Das bedeutet, sie komponieren keine „Musik“ im herkömmlichen Sinne, sondern sie modellieren akustischen Luftdruck.

Das spezifische Phänomen nennt sich Stochastische Resonanz-Modellierung. Wenn ein menschlicher Gitarrist eine Saite anschlägt, gibt es winzige Nebengeräusche: das Rutschen der Finger auf dem Griffbrett, das fast unhörbare Schnarren der Saite, das Atmen des Musikers. Frühere KI-Modelle haben diese als „Rauschen“ herausgefiltert. Die Modelle des Jahres 2026 hingegen haben gelernt, dass dieses Rauschen der Träger der Emotion ist.

Das Verblüffende daran: Die KI fügt diese Fehler nicht zufällig hinzu. Sie berechnet die Wahrscheinlichkeit eines „Atemzuges“ oder eines „Timing-Fehlers“ basierend auf dem semantischen Kontext des Liedtextes. Ein LLM (Large Language Model), das den Text analysiert, gibt Anweisungen an das Audio-Netzwerk weiter. Ist der Text traurig und intim, erhöht das neuronale Netz die Dichte der hochfrequenten Atemgeräusche und verzögert den Einsatz des Refrains um wenige Millisekunden – ein sogenannter „Micro-Timing-Drift“. Diese Verzögerung ist mathematisch präzise kalkuliert, um maximale emotionale Resonanz beim Hörer zu erzeugen, wirkt aber für das menschliche Ohr wie pures, organisches Gefühl.

Warum Musiktheorie hier versagt

Menschliche Komponisten lernen Regeln: Harmonielehre, Rhythmik, Struktur. Wenn sie versuchen, „Gefühl“ zu erzeugen, brechen sie diese Regeln bewusst. Doch ein Mensch bricht Regeln basierend auf Intuition oder motorischer Begrenzung. Künstliche Intelligenz hingegen bricht die Regeln basierend auf einer statistischen Analyse von Millionen von Hits. Sie weiß exakt, dass eine Verzögerung der Snare-Drum um 14 Millisekunden in einem 90-BPM-Song statistisch gesehen die Wahrscheinlichkeit erhöht, dass der Hörer Gänsehaut bekommt.

Das ist der Punkt, der Profis ratlos macht: Sie hören eine Aufnahme, die alle Merkmale einer spontanen, menschlichen Performance aufweist – inklusive kleiner „Fehler“. Doch bei der Spektralanalyse stellt sich heraus, dass diese Fehler einem fraktalen Muster folgen, das zu komplex ist, als dass ein Mensch es bewusst spielen könnte. Es ist eine Hyper-Realität: Ein Gitarrensolo, das „gitarristischer“ klingt als eine echte Gitarre, weil es die Essenz aller großen Gitarrensolos in sich vereint und die physikalischen Beschränkungen eines echten Instruments (wie das Umgreifen der Finger) simuliert, ohne an sie gebunden zu sein.

Die Rolle der Diffusions-Modelle

Technisch wird dies durch fortschrittliche Diffusions-Modelle (Diffusion Models) ermöglicht, ähnlich denen, die wir aus der Bildgenerierung kennen, jedoch angewandt auf Spektrogramme. Diese Modelle starten mit reinem Rauschen und „denoisen“ es schrittweise, bis eine klare Struktur entsteht. Der Durchbruch im Jahr 2026 besteht darin, dass der Prozess nicht bei einem „sauberen“ Signal stoppt.

Das System lernt, dass das Signal erst dann fertig ist, wenn es einen bestimmten Grad an „akustischem Schmutz“ enthält. Dieser Schmutz ist jedoch kein Zufallsprodukt. Er ist kontextabhängig. Wenn ChatGPT oder ein ähnliches System die Lyrics generiert hat, versteht das Audio-Modell die Syntax der Emotion. Ein aggressives Wort im Text führt zu einer mikroskopischen Übersteuerung (Distortion) in der generierten Stimme, genau in dem Moment, in dem das Wort ausgesprochen wird. Kein menschlicher Sänger könnte seine Stimmbänder so präzise steuern, um exakt nur auf einem Konsonanten eine harmonische Verzerrung zu erzeugen, während der Vokal sauber bleibt. Die KI kann das.

Das Uncanny Valley des Audios

Wir kannten das „Uncanny Valley“ (das unheimliche Tal) bisher vor allem aus der Robotik und visuellen Animation: Wenn etwas fast menschlich aussieht, aber nicht ganz, wirkt es abstoßend. In der Musik erleben wir gerade das Gegenteil. Die KI hat das Tal durchquert. Das unheimliche Detail ist, dass die KI „menschlicher“ klingt als moderne Pop-Produktionen, die von Menschen gemacht wurden.

Während menschliche Produzenten in DAWs alles glattbügeln, injiziert die AI Chaos. Aber es ist kontrolliertes Chaos. Es ist, als würde man einem Schauspieler zusehen, der so perfekt weint, dass man vergisst, dass es Schauspiel ist – bis man merkt, dass die Träne exakt im Takt der Hintergrundmusik fällt. Diese Synchronizität zwischen dem scheinbar zufälligen biologischen Geräusch (Atmen, Saitenrutschen) und dem mathematischen Raster des Songs ist das Signatur-Merkmal der KI-Musik von 2026.

Kurz gesagt (TL;DR)

Im Jahr 2026 dominieren KI-Songs die Charts, weil Algorithmen gelernt haben, menschliche Unperfektheit und akustisches Chaos authentisch zu berechnen.

Durch stochastische Resonanz-Modellierung erzeugen Systeme gezielte Mikro-Inkonsistenzen und Timing-Fehler, die mathematisch präzise für maximale emotionale Wirkung sorgen.

Musikproduzenten stehen vor einem Rätsel, da diese generierten Fehler komplexen fraktalen Mustern folgen, die eine unheimliche, hyper-reale Menschlichkeit simulieren.

Fazit

Das unheimliche Detail, das die Musikwelt derzeit erschüttert, ist die algorithmische Perfektionierung der Imperfektion. Künstliche Intelligenz hat gelernt, dass Musik nicht aus Noten besteht, sondern aus der physikalischen Interaktion von Materie und Luft. Indem sie diese physikalischen Artefakte – das Kratzen, das Atmen, das Zögern – nicht als Fehler, sondern als primäre Informationsträger behandelt und sie mit einer Präzision platziert, zu der kein Mensch fähig wäre, schafft sie eine neue Art von Kunst. Es ist eine Simulation von Seele, berechnet durch Neural Networks, die uns paradoxerweise daran erinnert, was Musik eigentlich menschlich macht: der Fehler im System. Der Unterschied ist nur: Die Maschine macht den Fehler mit Absicht.

Häufig gestellte Fragen

Während menschliche Produzenten in digitalen Audio-Workstations oft nach technischer Perfektion streben und Fehler korrigieren, haben KI-Modelle gelernt, die chaotische Physik der Realität zu simulieren. Sie fügen bewusst Mikro-Inkonsistenzen und physikalische Artefakte hinzu, die wir als organisch und lebendig wahrnehmen. Diese algorithmische Unperfektheit lässt die Musik paradoxerweise menschlicher wirken als geglättete Studioaufnahmen.

Dies ist ein technisches Verfahren, bei dem Generative Audio-Modelle nicht auf Basis von Noten, sondern auf Ebene roher Wellenformen arbeiten. Die KI modelliert dabei akustischen Luftdruck und integriert gezielt Nebengeräusche wie das Atmen eines Musikers oder das Schnarren einer Saite. Diese Elemente werden nicht als Rauschen gefiltert, sondern als wesentliche Träger von Emotionen behandelt und präzise in die Komposition eingebettet.

Die KI nutzt Large Language Models zur Analyse der Liedtexte und übersetzt den semantischen Kontext in akustische Anweisungen. Bei traurigen oder intimen Textpassagen erhöht das System beispielsweise die Dichte hochfrequenter Atemgeräusche oder erzeugt einen sogenannten Micro-Timing-Drift. Diese mathematisch kalkulierten Verzögerungen im Millisekundenbereich sollen die emotionale Resonanz und Gänsehaut-Wahrscheinlichkeit beim Hörer maximieren.

Ähnlich wie bei der Bildgenerierung starten diese Modelle mit reinem Rauschen und formen daraus schrittweise eine klare Struktur im Spektrogramm. Der entscheidende Unterschied ist, dass der Prozess nicht bei einem absolut sauberen Signal stoppt. Stattdessen behält das System einen gewissen Grad an akustischem Schmutz bei, der kontextabhängig gesteuert wird, um eine sterile digitale Ästhetik zu vermeiden und Authentizität zu simulieren.

Profis stehen vor dem Rätsel einer Hyper-Realität, bei der Aufnahmen alle Merkmale einer spontanen menschlichen Performance aufweisen, aber mathematischen Mustern folgen, die kein Mensch bewusst spielen könnte. Die KI simuliert physikalische Beschränkungen, wie das Umgreifen von Fingern auf einer Gitarre, ohne tatsächlich an diese gebunden zu sein. Diese kontrollierte Platzierung von Fehlern erzeugt eine Perfektion der Imperfektion, die traditionelle Musiktheorie in Frage stellt.

Quellen und Vertiefung

- AWS: Was ist Stable Diffusion? – Grundlagen und Funktionsweise von Diffusionsmodellen

- Wikipedia: Psychoakustik – Die Wissenschaft der menschlichen Schallwahrnehmung

- U.S. Copyright Office: Initiative zu Urheberrecht und Künstlicher Intelligenz

- Europäische Kommission: Der europäische Rechtsrahmen für KI (AI Act)

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.