In der heutigen Business-Intelligence-Landschaft hat die Marketing-Datenanalyse einen Sättigungspunkt erreicht, an dem traditionelle Metriken nicht mehr ausreichen, um den wahren Wert vom Hintergrundrauschen zu unterscheiden. Während uns das Jahr 2026 fortschrittliche KI-Tools bietet, liegt die wahre Revolution in der Rückkehr zu den Grundlagen der Ingenieurwissenschaften: der Digitalen Signalverarbeitung (Digital Signal Processing, DSP). Die Behandlung eines Lead-Stroms als elektrisches Signal ermöglicht es uns, mathematische Strenge auf die Bereinigung von Datenbanken anzuwenden und das Chaos von Big Data in handlungsrelevante Informationen zu verwandeln. In diesem Artikel werden wir untersuchen, wie Prinzipien der Telekommunikation und Elektronik direkt auf Strategien zur Kundenakquise übertragen werden können.

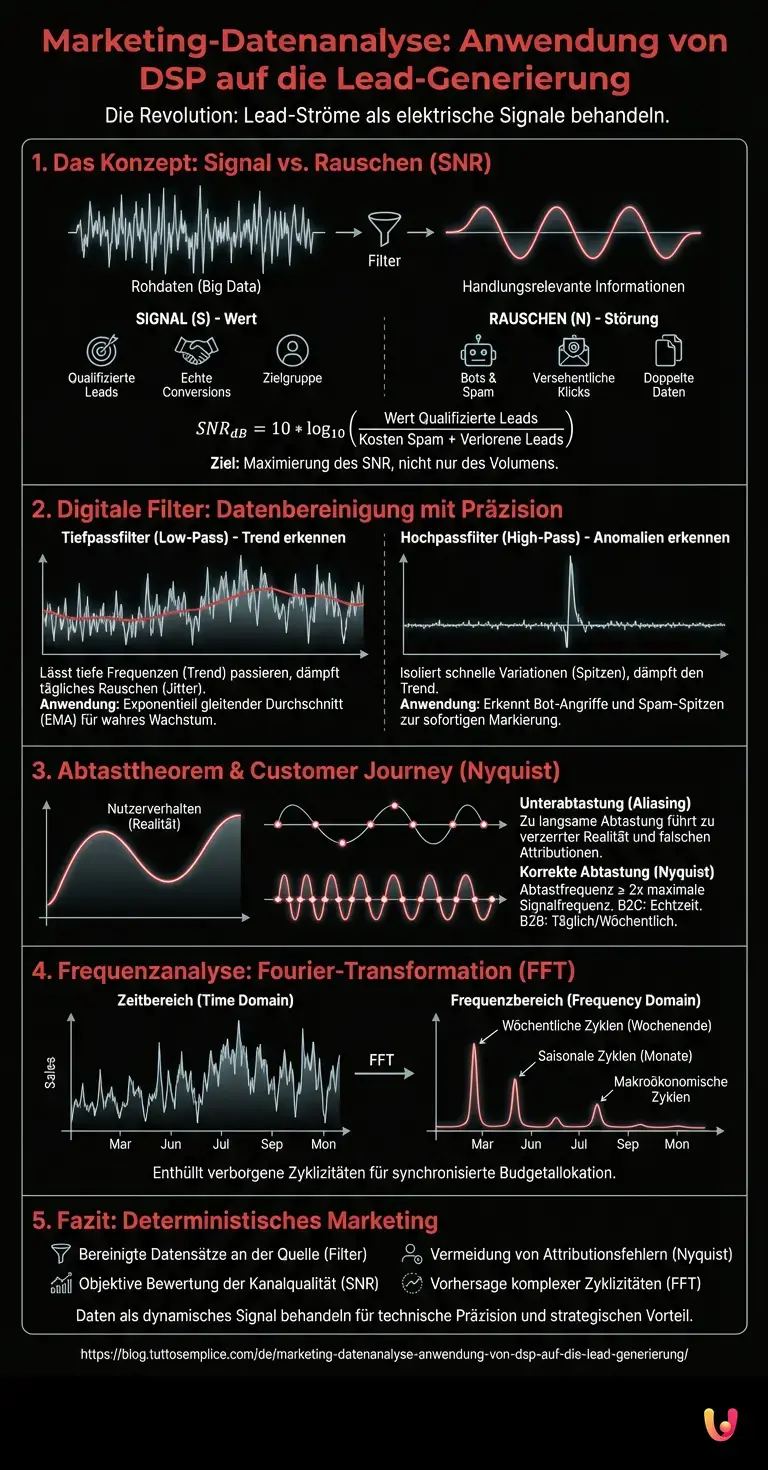

Das Konzept des Signal-Rausch-Verhältnisses (SNR) im Marketing

In der Elektroniktechnik misst das Signal-Rausch-Verhältnis (Signal-to-Noise Ratio, SNR) die Leistung eines Nutzsignals im Vergleich zu der des Hintergrundrauschens, das es verfälscht. Im Ökosystem des digitalen Marketings ist diese Analogie perfekt:

- Signal (S): Qualifizierte Leads, echte Conversions, Nutzer in der Zielgruppe.

- Rauschen (N): Bots, Spam-Traffic, versehentliche Klicks, Leads außerhalb der Zielgruppe, doppelte Daten.

Ein wissenschaftlicher Ansatz für die Marketing-Datenanalyse erfordert die Maximierung dieses Verhältnisses. Mathematisch gesehen: Wenn in einem Datensatz von 10.000 Kontakten (dem “Kanal”) nur 1.500 qualifizierte Leads (SQL) sind, ist unser SNR niedrig. Das Ziel ist nicht nur die Erhöhung des Volumens (Verstärkung), was auch das Rauschen erhöhen würde, sondern das Filtern des Kanals.

Berechnung des SNR für Traffic-Quellen

Wir können die Qualität einer PPC-Kampagne oder einer organischen Quelle mithilfe einer angepassten logarithmischen Formel quantifizieren:

SNR_dB = 10 * log10( (Wert_Qualifizierte_Leads) / (Kosten_Spam_Management + Kosten_Verlorene_Leads) )

Wenn das Ergebnis negativ oder nahe null ist, führt die Traffic-Quelle mehr Entropie als Wert in Ihr CRM ein, unabhängig vom generierten Traffic-Volumen.

Anwendung digitaler Filter auf Datensätze

Das Herzstück von DSP liegt in der Verwendung von Filtern zur Manipulation des Signals. Wir können Algorithmen in Python oder SQL schreiben, die als digitale Filter auf unseren Kontaktdatenbanken fungieren.

1. Tiefpassfilter (Low-Pass Filter): Den Trend identifizieren

Ein Tiefpassfilter lässt Frequenzen unterhalb einer bestimmten Grenzfrequenz passieren und dämpft höhere Frequenzen. In der Analyse von Marketing-Zeitreihen werden die “hohen Frequenzen” durch tägliche Volatilität, durch Bots verursachte Spitzen oder zufällige Ereignisse dargestellt.

Praktische Anwendung: Verwendung eines Exponentiell gleitenden Durchschnitts (EMA) oder eines Butterworth-Filters auf tägliche Verkehrsdaten. Dies eliminiert den “Jitter” (das tägliche Rauschen) und enthüllt den wahren Trend des Wachstums oder Rückgangs der Marktnachfrage (das niederfrequente Signal).

import pandas as pd

# Konzeptionelles Beispiel für Tiefpassfilter auf Verkehrsdaten

data['Traffic_Clean'] = data['Traffic_Raw'].ewm(span=7, adjust=False).mean()

2. Hochpassfilter (High-Pass Filter): Erkennung von Anomalien und Spam

Im Gegensatz dazu dämpft ein Hochpassfilter die langsamen Komponenten (den Trend) und lässt schnelle Variationen passieren. Dies ist entscheidend für die Datensicherheit und -bereinigung.

Praktische Anwendung: Wenn ein Kontaktformular normalerweise 1 Lead pro Stunde erhält (niedrige Frequenz), stellt ein plötzlicher Anstieg von 50 Leads in einer Minute ein Signal mit sehr hoher Frequenz dar. Durch Anwendung eines digitalen Hochpassfilters können wir diese Spitzen isolieren und automatisch als wahrscheinliche Bot-Angriffe oder Spam markieren, um sie von der Hauptdatenbank zu trennen, bevor sie die Konversionsstatistiken verfälschen.

Abtasttheorem und Customer Journey

Das Nyquist-Shannon-Abtasttheorem besagt, dass zur originalgetreuen Rekonstruktion eines analogen Signals die Abtastfrequenz mindestens doppelt so hoch sein muss wie die maximale Frequenz des Signals selbst. Wie lässt sich dies auf die Marketing-Datenanalyse anwenden?

Viele Marketer begehen den Fehler, das Nutzerverhalten “unterzuabtasten” (Undersampling). Wenn ein Nutzer innerhalb von 24 Stunden über mehrere Touchpoints mit der Marke interagiert, Ihr Attributionssystem die Daten jedoch nur einmal täglich aufzeichnet (oder schlimmer noch, ein vereinfachtes Last-Click-Modell verwendet), leiden Sie unter einem Phänomen namens Aliasing.

Aliasing im Marketing schafft eine verzerrte Realität: Sie ordnen die Conversion dem falschen Kanal zu, weil Sie die zwischenzeitlichen Schwankungen des Nutzerverhaltens “verpasst” haben. Um dies zu vermeiden, muss die Tracking-Frequenz (Sampling Rate) an die Geschwindigkeit des Verkaufszyklus angepasst sein:

- B2C (Schneller Impuls): Erfordert Echtzeit- oder Nahezu-Echtzeit-Abtastung.

- B2B (Langer Zyklus): Eine tägliche oder wöchentliche Abtastung kann ausreichend sein, ohne Nyquist zu verletzen.

Analyse im Frequenzbereich: Fourier-Transformationen (FFT)

Eines der mächtigsten und am wenigsten genutzten Werkzeuge im Marketing ist die Spektralanalyse. Durch die Transformation einer Zeitreihe von Leads aus dem Zeitbereich in den Frequenzbereich mittels der Fast Fourier Transform (FFT) können wir Zyklizitäten entdecken, die mit bloßem Auge unsichtbar sind.

Case Study: Die Nachfrage nach Hypotheken

Stellen wir uns vor, wir analysieren die Nachfrage nach Hypotheken. Im Zeitbereich sehen wir nur eine gezackte Linie, die auf und ab geht. Durch Anwendung der FFT könnten wir spezifische Frequenzspitzen entdecken, die Folgendem entsprechen:

- Wöchentliche Zyklen: Suchspitzen am Wochenende.

- Saisonale Zyklen: Anstiege, die mit bestimmten Monaten des Jahres korrelieren.

- Makroökonomische Zyklen: Korrelationen mit Zinsankündigungen der Zentralbanken.

Die Identifizierung dieser “dominanten Frequenzen” ermöglicht es, die Nachfrage zu antizipieren und das Werbebudget in Phase (synchron) mit der Nachfragewelle zuzuweisen, anstatt gegenphasig (Budgetverschwendung, wenn die natürliche Nachfrage gering ist).

Fazit: Hin zu einem deterministischen Marketing

Die Einführung digitaler Filter und DSP-Konzepte in die Marketing-Datenanalyse ist keine bloße akademische Übung. Es ist eine operative Notwendigkeit für diejenigen, die im Jahr 2026 große Datenmengen verwalten. Der Übergang von einer rein statistischen Sichtweise zu einer auf Signalverarbeitung basierenden Sichtweise ermöglicht:

- Bereinigung der Datensätze an der Quelle (Filter).

- Objektive Bewertung der Kanalqualität (SNR).

- Vermeidung von Attributionsfehlern (Nyquist-Abtastung).

- Vorhersage komplexer Zyklizitäten (FFT).

Die Zukunft des Marketings gehört denen, die Daten nicht als statische Zahl, sondern als dynamisches Signal behandeln, das mit technischer Präzision verarbeitet, bereinigt und interpretiert werden muss.

Häufig gestellte Fragen

Die Verwendung von DSP im Marketing bedeutet, Lead-Ströme als elektrische Signale zu behandeln, die mit mathematischer Strenge verarbeitet werden. Dieser technische Ansatz ermöglicht es, qualifizierte Kontakte, verstanden als nützliches Signal, von Spam-Traffic oder Bots zu unterscheiden, die das Hintergrundrauschen darstellen, und gewährleistet so strategische Entscheidungen auf der Grundlage sauberer Daten und nicht auf Eitelkeitsmetriken.

Das Signal-Rausch-Verhältnis, oder SNR, misst die tatsächliche Qualität einer Traffic-Quelle, indem es das Volumen qualifizierter Leads mit dem nutzloser Daten wie versehentlichen Klicks und Bots vergleicht. Ein hoher SNR-Wert zeigt an, dass die Kampagne konkreten Wert generiert, während ein niedriges Ergebnis darauf hindeutet, dass die Unordnung und die Kosten für das Spam-Management den Nutzen der neu gewonnenen Kontakte übersteigen.

Digitale Filter wirken auf Algorithmen ein, um reale Trends von momentanen Anomalien zu trennen. Ein Tiefpassfilter eliminiert die tägliche Volatilität, um den wahren Wachstumstrend aufzuzeigen, während ein Hochpassfilter plötzliche Traffic-Spitzen isoliert, die oft auf Bot-Angriffe hinweisen, und es ermöglicht, diese aus den Konversionsstatistiken auszuschließen, bevor sie das CRM verunreinigen.

Das Nyquist-Theorem legt nahe, dass die Tracking-Frequenz an die Geschwindigkeit der Kundeninteraktionen angepasst sein muss, um das Phänomen des Aliasing zu vermeiden. Wenn das Nutzerverhalten im Vergleich zur Realität zu langsam abgetastet wird, insbesondere im B2C-Bereich, erhält man eine verzerrte Sicht auf den Kaufpfad und ordnet Verkäufe fälschlicherweise den falschen Kanälen zu.

Die Fast Fourier Transform, bekannt als FFT, ermöglicht den Übergang von der zeitlichen Untersuchung zur Frequenzanalyse und enthüllt verborgene Zyklizitäten in den Verkaufsdaten. Dieses Tool hilft dabei, wiederkehrende wöchentliche oder saisonale Muster zu identifizieren, die mit bloßem Auge unsichtbar sind, und ermöglicht es Marketern, Werbebudgets mit den natürlichen Spitzen der Marktnachfrage zu synchronisieren.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.