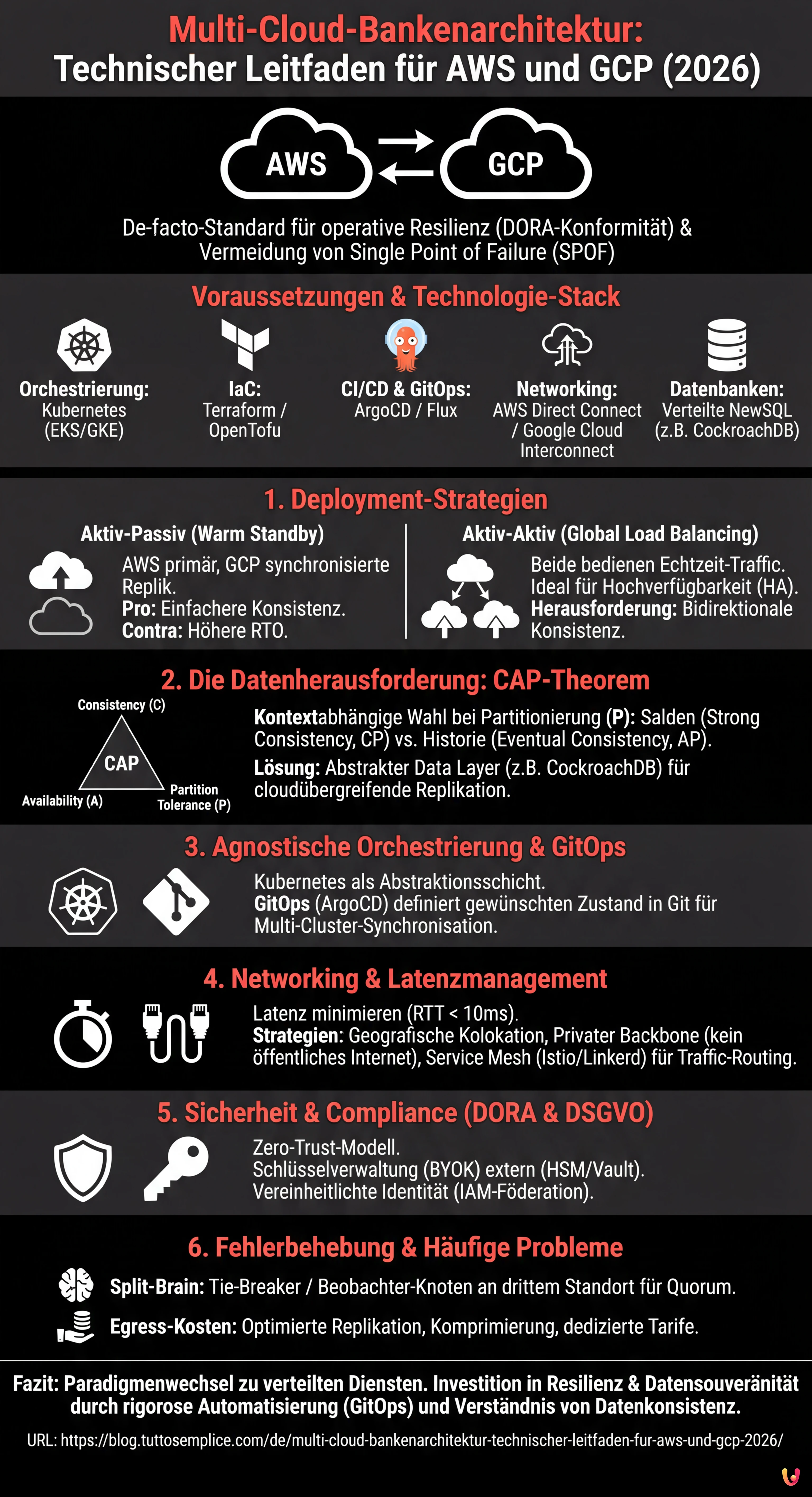

Kurz gesagt (TL;DR)

Die Einführung hybrider Architekturen auf AWS und GCP gewährleistet die operative Resilienz, die von Vorschriften wie der DORA-Verordnung gefordert wird.

Das Datenmanagement erfordert eine strategische Balance zwischen Konsistenz und Verfügbarkeit durch Anwendung des CAP-Theorems auf Aktiv-Aktiv- oder Aktiv-Passiv-Konfigurationen.

Die Orchestrierung mittels Kubernetes und der GitOps-Ansatz stellen ein agnostisches und effizientes Deployment sicher und mindern Latenzrisiken zwischen verschiedenen Anbietern.

Der Teufel steckt im Detail. 👇 Lesen Sie weiter, um die kritischen Schritte und praktischen Tipps zu entdecken, um keine Fehler zu machen.

In der Fintech-Landschaft des Jahres 2026 ist die Multi-Cloud-Bankenarchitektur keine exotische Option mehr, sondern ein De-facto-Standard, um die von internationalen Vorschriften (wie der DORA-Verordnung in der EU) geforderte operative Resilienz zu gewährleisten. Die Abhängigkeit von einem einzigen Cloud-Anbieter stellt heute einen inakzeptablen Single Point of Failure (SPOF) für kritische Dienste wie Echtzeit-Hypothekenvergleiche oder Core-Banking-Systeme dar.

Dieser technische Leitfaden untersucht, wie eine hybride Infrastruktur, die zwischen Amazon Web Services (AWS) und Google Cloud Platform (GCP) verteilt ist, entworfen, implementiert und gewartet wird. Wir analysieren die technischen Herausforderungen im Zusammenhang mit der Datensynchronisation, der Orchestrierung über Kubernetes und der Anwendung fundamentaler Theoreme verteilter Systeme, um Konsistenz und Verfügbarkeit auszubalancieren.

Voraussetzungen und Technologie-Stack

Zur Umsetzung der beschriebenen Strategien wird die Kenntnis und Nutzung folgender Komponenten vorausgesetzt:

- Orchestrierung: Kubernetes (EKS auf AWS, GKE auf GCP).

- IaC (Infrastructure as Code): Terraform oder OpenTofu für das agnostische Provisioning.

- CI/CD & GitOps: ArgoCD oder Flux für die Synchronisation des Cluster-Status.

- Networking: AWS Direct Connect und Google Cloud Interconnect, verwaltet über BGP.

- Datenbanken: Verteilte NewSQL-Lösungen (z. B. CockroachDB) oder benutzerdefinierte Replikationsstrategien.

1. Deployment-Strategien: Aktiv-Aktiv vs. Aktiv-Passiv

Die Wahl zwischen einer Aktiv-Aktiv- und einer Aktiv-Passiv-Konfiguration definiert die gesamte Multi-Cloud-Bankenarchitektur. Im Finanzkontext, wo das RPO (Recovery Point Objective) gegen Null tendieren muss, ändern sich die Herausforderungen drastisch.

Szenario Aktiv-Passiv (Warm Standby)

In diesem Szenario könnte AWS den primären Datenverkehr verwalten, während GCP eine synchronisierte Replik der Infrastruktur bereithält, die im Falle eines Failovers skalieren kann. Dies ist die konservative Wahl, um Kosten und die Komplexität des Schreibkonflikt-Managements zu reduzieren.

- Pro: Einfachheit bei der Verwaltung der Datenkonsistenz (Schreiben auf nur einen Master).

- Contra: Höhere RTO-Zeiten (Recovery Time Objective) aufgrund der Zeit für das “Aufwärmen” der sekundären Region.

Szenario Aktiv-Aktiv (Global Load Balancing)

Beide Anbieter bedienen den Datenverkehr in Echtzeit. Dies ist die ideale Konfiguration für Hochverfügbarkeit (HA), führt jedoch die komplexe Herausforderung der bidirektionalen Datenkonsistenz ein.

2. Die Datenherausforderung: CAP-Theorem und Eventual Consistency

Gemäß dem CAP-Theorem (Consistency, Availability, Partition Tolerance) muss sich ein Bankensystem bei einer Netzwerkpartitionierung (P) zwischen AWS und GCP zwischen Konsistenz (C) und Verfügbarkeit (A) entscheiden.

Für ein Bankensystem ist die Wahl nicht binär, sondern kontextabhängig:

- Salden und Transaktionen (Strong Consistency): Wir können nicht zulassen, dass ein Benutzer dasselbe Geld zweimal in zwei verschiedenen Clouds ausgibt. Hier opfern wir Latenz oder Verfügbarkeit, um Konsistenz (CP) zu gewährleisten. Es werden verteilte Konsensus-Protokolle wie Raft oder Paxos verwendet.

- Transaktionshistorie oder Hypothekenanalyse (Eventual Consistency): Es ist akzeptabel, dass die Historie mit einigen Millisekunden Verzögerung in der sekundären Region erscheint. Hier priorisieren wir die Verfügbarkeit (AP).

Technische Implementierung der Synchronisation

Um Risiken durch Latenz und Split-Brain zu mindern, sieht der moderne Ansatz die Verwendung eines abstrakten Data Layers vor. Anstatt RDS (AWS) und Cloud SQL (GCP) nativ zu nutzen, werden geografisch verteilte Datenbank-Cluster wie CockroachDB oder YugabyteDB implementiert, die cloudübergreifend arbeiten und Replikation (synchron und asynchron) nativ verwalten.

3. Agnostische Orchestrierung mit Kubernetes

Um einen Vendor-Lock-in zu vermeiden, muss die Anwendung containerisiert und agnostisch gegenüber der zugrunde liegenden Infrastruktur sein. Kubernetes fungiert hierbei als Abstraktionsschicht.

Multi-Cluster-Management mit GitOps

Wir verwalten die Cluster nicht imperativ. Durch die Verwendung eines GitOps-Ansatzes mit ArgoCD können wir den gewünschten Zustand der Anwendung in einem Git-Repository definieren. ArgoCD kümmert sich darum, die Konfigurationen gleichzeitig auf EKS (AWS) und GKE (GCP) anzuwenden.

# Konzeptionelles Beispiel eines ApplicationSet in ArgoCD

apiVersion: argoproj.io/v1alpha1

kind: ApplicationSet

metadata:

name: banking-core-app

spec:

generators:

- list:

elements:

- cluster: aws-eks-prod

region: eu-central-1

- cluster: gcp-gke-prod

region: europe-west3

template:

# Deployment-Konfiguration...4. Networking und Latenzmanagement

Die Latenz zwischen Cloud-Anbietern ist der Feind Nummer eins verteilter Architekturen. Eine Transaktion, die einen synchronen Commit auf zwei verschiedenen Clouds erfordert, unterliegt zwangsläufig der Latenz der “Round-Trip-Time” (RTT) zwischen den Rechenzentren.

Minderungsstrategien

- Geografische Kolokation: Auswahl von AWS-Regionen (z. B. Frankfurt) und GCP-Regionen (z. B. Frankfurt), die physisch nahe beieinander liegen, um die RTT auf < 10ms zu minimieren.

- Privater Backbone: Vermeidung des öffentlichen Internets für die Datenbanksynchronisation. Nutzung von Site-to-Site-VPNs oder dedizierten Verbindungslösungen über Carrier-neutrale Partner (z. B. Equinix Fabric), die AWS Direct Connect und Google Cloud Interconnect verbinden.

- Service Mesh (Istio/Linkerd): Implementierung eines föderierten Service Mesh zur Verwaltung von intelligentem Traffic-Routing, automatischem Failover von API-Aufrufen und mTLS (Mutual TLS) über Cloud-Grenzen hinweg für die Sicherheit.

5. Sicherheit und Compliance (DORA & DSGVO)

In einer Multi-Cloud-Bankenarchitektur vergrößert sich die Angriffsfläche. Die Sicherheit muss nach dem Zero-Trust-Modell verwaltet werden.

- Schlüsselverwaltung (BYOK): Verwendung eines externen Schlüsselverwaltungssystems (HSM in Kolokation oder Dienste wie HashiCorp Vault), um die Kontrolle über die Verschlüsselungsschlüssel unabhängig vom Cloud-Anbieter zu behalten.

- Vereinheitlichte Identität: Föderierung von Identitäten (IAM) unter Verwendung eines zentralen Identity Providers (z. B. Okta oder Azure AD), um sicherzustellen, dass Berechtigungen auf AWS und GCP konsistent sind.

6. Fehlerbehebung und Lösung häufiger Probleme

Problem: Split-Brain in der Datenbank

Symptom: Die beiden Clouds verlieren die Verbindung zueinander und beide akzeptieren divergierende Schreibvorgänge.

Lösung: Implementierung eines “Tie-Breakers” oder eines Beobachter-Knotens an einem dritten Standort (z. B. Azure oder ein On-Premise-Rechenzentrum), um das für Konsensus-Protokolle erforderliche ungerade Quorum aufrechtzuerhalten.

Problem: Egress-Kosten (Datenausgang)

Symptom: Hohe Rechnungen aufgrund der kontinuierlichen Datensynchronisation zwischen AWS und GCP.

Lösung: Optimierung der Datenreplikation. Nur kritische Transaktionsdaten in Echtzeit replizieren. Nutzung von Komprimierung und Deduplizierung. Aushandlung dedizierter Egress-Tarife mit den Anbietern für Inter-Region-Traffic.

Fazit

Der Aufbau einer Multi-Cloud-Bankenarchitektur erfordert einen Paradigmenwechsel: Man geht von der Verwaltung von Servern zur Verwaltung verteilter Dienste über. Obwohl die operative Komplexität steigt, rechtfertigen der Gewinn an Resilienz, Datensouveränität und Verhandlungsmacht gegenüber den Anbietern die Investition für moderne Finanzinstitute. Der Schlüssel zum Erfolg liegt in der rigorosen Automatisierung (GitOps) und einem tiefen Verständnis der Datenkonsistenzmodelle.

Häufig gestellte Fragen

Die Einführung einer Multi-Cloud-Architektur ist für Finanzinstitute zu einem De-facto-Standard geworden, hauptsächlich um die operative Resilienz und die Einhaltung gesetzlicher Vorschriften zu gewährleisten. Verordnungen wie DORA in der Europäischen Union verlangen die Minderung von Risiken, die mit der Abhängigkeit von einem einzigen Technologielieferanten verbunden sind. Durch die Nutzung mehrerer Anbieter wie AWS und GCP eliminieren Banken den Single Point of Failure und stellen sicher, dass kritische Dienste wie Core-Banking-Systeme auch bei schweren Ausfällen eines gesamten Cloud-Anbieters betriebsbereit bleiben, was die Datensouveränität und die Servicekontinuität erhöht.

Die Wahl zwischen diesen beiden Strategien definiert das Gleichgewicht zwischen Kosten, Komplexität und Wiederherstellungszeiten. In der Aktiv-Passiv-Konfiguration verwaltet eine Cloud den Datenverkehr, während die andere eine Replik bereithält, die bereit ist, einzuspringen, was eine einfachere Verwaltung der Datenkonsistenz, aber höhere Wiederherstellungszeiten bietet. Im Gegensatz dazu verteilt das Aktiv-Aktiv-Szenario den Datenverkehr in Echtzeit auf beide Anbieter; diese Lösung ist ideal für Hochverfügbarkeit und um Ausfallzeiten auf null zu reduzieren, erfordert jedoch ein komplexes Management der bidirektionalen Datensynchronisation, um Schreibkonflikte zu vermeiden.

Das Datenmanagement in einer verteilten Umgebung basiert auf dem CAP-Theorem, das im Falle einer Netzwerkpartitionierung eine kontextabhängige Wahl zwischen Konsistenz und Verfügbarkeit erzwingt. Für kritische Daten wie Salden und Transaktionen muss die starke Konsistenz unter Inkaufnahme von Latenz priorisiert werden, wobei verteilte Konsensus-Protokolle zum Einsatz kommen. Für weniger sensible Daten, wie die Transaktionshistorie, kann man sich für eine Eventual Consistency entscheiden. Technologisch wird dies oft durch die Abstraktion der Datenschicht mit geografisch verteilten Datenbanken wie CockroachDB gelöst, die die Replikation zwischen verschiedenen Anbietern nativ verwalten.

Latenz ist die größte Herausforderung in verteilten Architekturen. Um sie zu mindern, ist die geografische Kolokation entscheidend, d. h. die Auswahl von Regionen der verschiedenen Anbieter, die physisch nahe beieinander liegen, wie z. B. Frankfurt für beide, um die Antwortzeit unter 10 Millisekunden zu halten. Darüber hinaus wird davon abgeraten, das öffentliche Internet für die Datensynchronisation zu nutzen; stattdessen werden private Backbones oder dedizierte Verbindungslösungen über neutrale Partner bevorzugt. Der Einsatz eines föderierten Service Mesh hilft schließlich dabei, das intelligente Traffic-Routing zu verwalten, um die Leistung zu optimieren.

Ein Split-Brain tritt auf, wenn zwei Clouds die Verbindung zueinander verlieren und beginnen, unabhängig voneinander divergierende Schreibvorgänge zu akzeptieren. Die technische Standardlösung sieht die Implementierung eines Beobachter-Knotens oder Tie-Breakers an einem dritten neutralen Standort vor, was ein anderer Cloud-Anbieter wie Azure oder ein On-Premise-Rechenzentrum sein kann. Dieser dritte Knoten dient dazu, das für Konsensus-Protokolle erforderliche ungerade Quorum aufrechtzuerhalten, wodurch das System entscheiden kann, welche Version der Daten die korrekte ist, und eine Korruption der Datenbank verhindert wird.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.