Es ist ein Vorgang, der mittlerweile so alltäglich geworden ist wie das Einschalten des Lichts: Sie öffnen ein Chat-Fenster, tippen eine komplexe Frage ein und erhalten in Sekundenschnelle eine eloquente Antwort. Die Benutzeroberfläche wirkt sauber, minimalistisch und immateriell. Doch diese digitale Leichtigkeit ist eine Illusion. Im Hintergrund, verborgen in gigantischen Serverfarmen, ist Generative AI (Generative KI) eine physische Gewalt, die Ressourcen in einem Ausmaß verschlingt, das der breiten Öffentlichkeit kaum bewusst ist. Während wir uns oft auf die intellektuellen Fähigkeiten von Systemen wie ChatGPT konzentrieren, übersehen wir die thermodynamische Realität: Jede Berechnung erzeugt Hitze, und diese Hitze fordert einen Tribut.

Wir leben im Jahr 2026, und die Integration von Künstliche Intelligenz in unseren Alltag ist nahezu lückenlos. Doch die Frage, die wir uns heute stellen müssen, ist nicht philosophischer, sondern rein technischer Natur. Was passiert physikalisch, wenn ein neuronales Netz feuert? Welche Ressource wird unwiederbringlich verbraucht, um die Silizium-Gehirne vor dem Hitzetod zu bewahren? Die Antwort führt uns weg von der Software, hinein in die Infrastruktur der Rechenzentren, wo Wasser und Strom in einem ständigen Kampf gegen die Thermodynamik stehen.

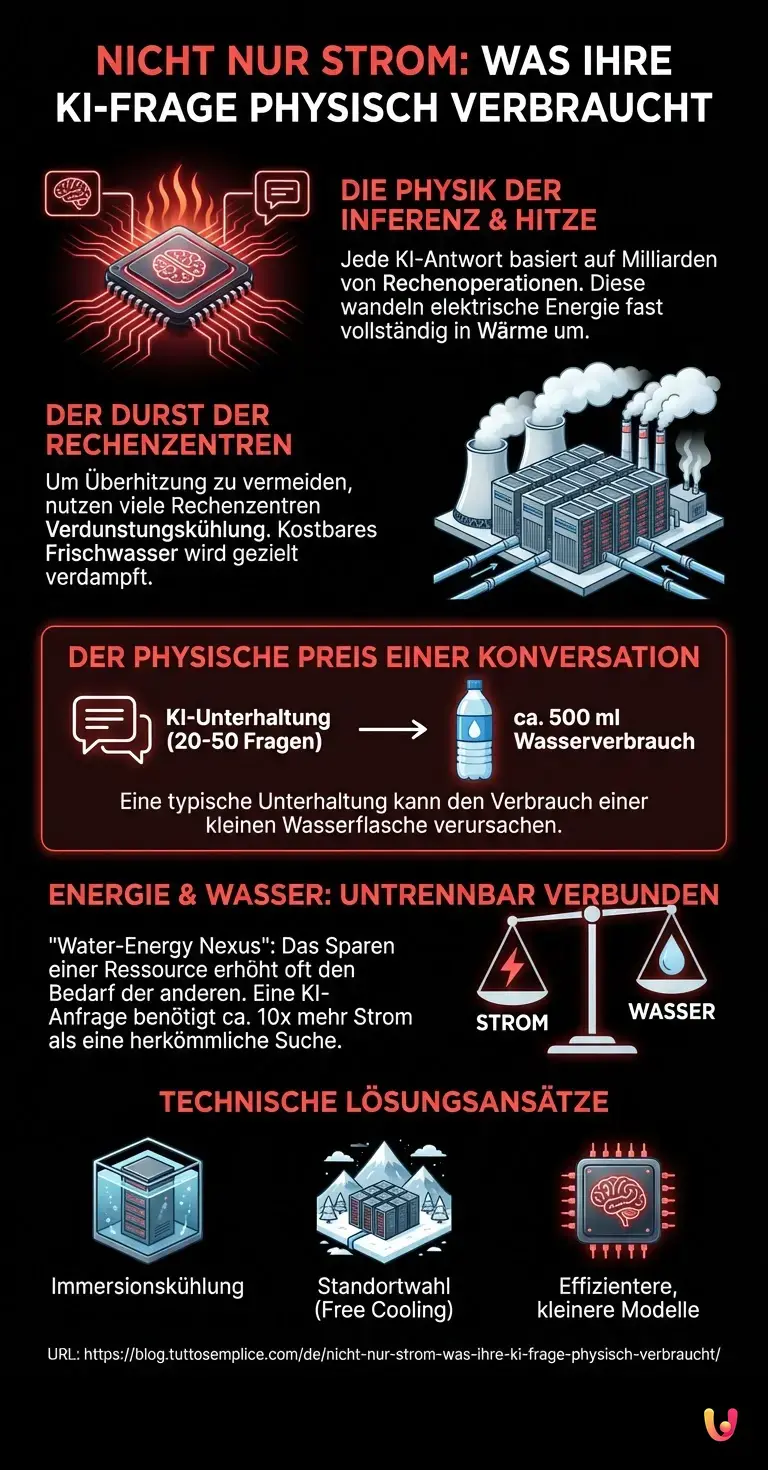

Die Physik der Inferenz: Warum Denken Hitze erzeugt

Um zu verstehen, warum Ressourcen verbraucht werden, müssen wir zunächst den Prozess der sogenannten „Inferenz“ betrachten. Wenn Sie eine Anfrage an ein LLM (Large Language Model) senden, durchläuft Ihre Eingabe Milliarden von Parametern. Technisch gesehen handelt es sich dabei um massive Matrizenmultiplikationen. Milliarden von Transistoren auf den Grafikprozessoren (GPUs) schalten milliardenfach pro Sekunde um. Jeder dieser Schaltvorgänge erfordert einen winzigen Stromstoß.

Nach den Gesetzen der Thermodynamik verpufft diese elektrische Energie nicht einfach; sie wird fast vollständig in thermische Energie – also Wärme – umgewandelt. Moderne KI-Beschleunigerchips haben eine enorme Leistungsdichte. Ein einzelnes Server-Rack, vollgestopft mit Hochleistungs-GPUs für Maschinelles Lernen, kann so viel Wärme produzieren wie mehrere Dutzend Haartrockner, die permanent auf höchster Stufe laufen. Ohne sofortige und massive Kühlung würden diese Chips innerhalb von Sekundenbruchteilen überhitzen und sich selbst zerstören (Thermal Throttling oder Hardware-Defekt).

Der Durst der Rechenzentren: Wasser als Kühlmittel

Hier kommen wir zum Kern des Geheimnisses. Um diese enorme Wärmemenge abzuführen, reicht einfache Luftkühlung bei modernen High-Performance-Computing (HPC) Clustern oft nicht mehr aus oder ist energetisch ineffizient. Rechenzentren greifen daher auf eine Ressource zurück, die wir als selbstverständlich, aber kostbar erachten: Frischwasser.

Viele Hyperscale-Rechenzentren nutzen Kühltürme, die auf dem Prinzip der Verdunstungskühlung basieren. Wasser wird über Wärmetauscher geleitet, nimmt die Hitze der Server auf und wird dann teilweise verdunstet, um die verbleibende Flüssigkeit abzukühlen. Dieser Prozess ist physikalisch extrem effizient, um Wärme loszuwerden, hat aber einen entscheidenden Nachteil: Das verdunstete Wasser ist für den lokalen Wasserkreislauf oft verloren oder wird als „verbrauchtes“ Wasser klassifiziert, da es nicht unmittelbar in das System zurückgeführt wird.

Es handelt sich hierbei nicht um das Wasser, das in einem geschlossenen Kreislauf durch die Rohre fließt (wie in der Heizung zu Hause), sondern um Wasser, das gezielt verdampft wird („Evaporative Cooling“), um die Temperatur zu senken. Dieser Verbrauch ist der direkte physische Preis Ihrer KI-Konversation.

Die Quantifizierung: Eine Flasche Wasser pro Gespräch

Wie viel Wasser kostet nun eine einzelne Interaktion? Studien und technische Analysen der letzten Jahre haben versucht, diesen Wert, bekannt als „Water Usage Effectiveness“ (WUE), zu quantifizieren. Während die Zahlen je nach Standort des Rechenzentrums und der Außentemperatur variieren, hat sich eine Faustregel etabliert, die die Dimension verdeutlicht.

Eine typische Konversation mit einem fortschrittlichen Generative AI Modell – bestehend aus etwa 20 bis 50 Fragen und Antworten – kann den „Verbrauch“ von etwa 500 Millilitern Wasser verursachen. Das entspricht einer kleinen Standard-Wasserflasche. Wenn man bedenkt, dass täglich Milliarden von Anfragen weltweit gestellt werden, summiert sich dies zu einem gigantischen Volumen. In Regionen, die ohnehin unter Wasserknappheit leiden, wird der Betrieb von KI-Rechenzentren somit zu einem ethischen und logistischen Problem.

Es ist wichtig zu betonen, dass dieser Wasserverbrauch nicht nur beim Training der Modelle (einem einmaligen, aber extrem intensiven Prozess) anfällt, sondern kontinuierlich während der Inferenzphase – also genau dann, wenn Sie das Tool nutzen.

Energiehunger: Der unsichtbare Partner des Wassers

Neben dem Wasserverbrauch darf der Energiebedarf nicht ignoriert werden. Neural Networks sind energieintensiv. Eine einzelne Suchanfrage über ein LLM verbraucht schätzungsweise zehnmal mehr Strom als eine herkömmliche Google-Suche. Dieser Strom muss erzeugt werden, was je nach Energiemix (Kohle, Gas, Erneuerbare) einen entsprechenden CO2-Fußabdruck hinterlässt.

Wasser und Energie sind in Rechenzentren untrennbar verbunden. Man spricht vom „Water-Energy Nexus“. Will man Wasser sparen, muss man oft mehr Strom für elektrische Kühler (Chiller) aufwenden. Will man Strom sparen, nutzt man oft mehr Wasser für die effizientere Verdunstungskühlung. Die Betreiber der großen KI-Modelle balancieren ständig zwischen diesen beiden Ressourcen, oft abhängig davon, was am jeweiligen Standort billiger oder verfügbarer ist.

Technische Lösungsansätze und die Zukunft

Die Industrie ist sich dieses Problems bewusst, nicht zuletzt aus Kostengründen und wegen der zunehmenden regulatorischen Kontrolle. Welche technischen Lösungen werden entwickelt, um den Durst der KI zu stillen?

- Immersionskühlung: Hierbei werden die Server direkt in eine nicht leitende Flüssigkeit getaucht. Dies ist wesentlich effizienter als Luftkühlung und eliminiert den Bedarf an Wasserverdunstung fast vollständig, erfordert aber komplett neue Hardware-Architekturen.

- Standortwahl: Rechenzentren werden zunehmend in kühleren Klimazonen (z. B. Skandinavien) gebaut, wo die Außenluft zur Kühlung genutzt werden kann („Free Cooling“), ohne Wasser zu verdampfen.

- Kleinere Modelle: Der Trend geht weg von gigantischen „Alles-Könner“-Modellen hin zu spezialisierten, kleineren LLMs, die weniger Rechenleistung und damit weniger Kühlung für die gleiche Aufgabe benötigen.

Kurz gesagt (TL;DR)

Hinter der sauberen Benutzeroberfläche von KI-Chats verbirgt sich ein massiver, oft übersehener Verbrauch physischer Ressourcen in Rechenzentren.

Komplexe Berechnungen während der Inferenz erzeugen enorme Hitze, die Rechenzentren zu einem ständigen Kampf gegen die Thermodynamik zwingt.

Um die Hardware zu kühlen, verbraucht eine typische KI-Konversation etwa einen halben Liter kostbares Frischwasser durch Verdunstung.

Fazit

Jedes Mal, wenn der Cursor blinkt und eine Antwort generiert wird, findet im Hintergrund ein massiver thermodynamischer Austausch statt. Die kostbare Ressource, die dabei vernichtet wird, ist sauberes Trinkwasser, das durch Verdunstung in die Atmosphäre entweicht, um die Silizium-Chips vor dem Hitzetod zu bewahren. In Kombination mit dem hohen Strombedarf macht dies jede KI-Interaktion zu einem physischen Ereignis mit realen ökologischen Kosten. Das Verständnis dieser technischen Zusammenhänge ist entscheidend, um die Technologie verantwortungsvoll zu nutzen und den Druck auf die Entwicklung nachhaltigerer Kühlsysteme und effizienterer Algorithmen aufrechtzuerhalten. KI ist nicht nur Code; sie ist Wasser und Energie.

Häufig gestellte Fragen

Eine Standard-Konversation mit einem generativen KI-Modell, die etwa 20 bis 50 Fragen und Antworten umfasst, kann den Verbrauch von rund 500 Millilitern Wasser verursachen. Dies geschieht primär durch die notwendige Verdunstungskühlung in den Rechenzentren, um die enorme Hitze der Prozessoren abzuführen. Der Wasserverbrauch findet also nicht digital, sondern physisch in der Infrastruktur der Serverfarmen statt, wo das Wasser oft unwiederbringlich verdampft.

Jede Anfrage an ein Large Language Model löst Milliarden von Rechenoperationen und Schaltvorgängen in den Transistoren der Grafikprozessoren aus. Nach den Gesetzen der Thermodynamik wird die hierfür benötigte elektrische Energie fast vollständig in thermische Energie umgewandelt. Ohne massive Kühlung würden diese Chips durch die entstehende Hitze innerhalb von Sekundenbruchteilen überhitzen und ausfallen, weshalb eine leistungsstarke Wärmeabfuhr zwingend erforderlich ist.

Eine einzelne Anfrage über ein KI-Sprachmodell benötigt schätzungsweise zehnmal mehr Strom als eine klassische Websuche bei Anbietern wie Google. Dieser erhöhte Energiebedarf resultiert aus der komplexen Inferenz-Berechnung durch neuronale Netze, die wesentlich rechenintensiver ist als das bloße Abrufen indexierter Datenbankeinträge. Dies führt je nach lokalem Strommix zu einem signifikant höheren CO2-Fußabdruck pro einzelner Interaktion.

Um den Wasserbedarf zu reduzieren, setzen Betreiber zunehmend auf Immersionskühlung, bei der Server direkt in nicht leitende Flüssigkeiten getaucht werden, oder verlagern Standorte in kältere Klimazonen für sogenanntes Free Cooling mittels Außenluft. Zudem geht der Trend hin zu kleineren, spezialisierten Modellen, die weniger Rechenleistung benötigen als gigantische Allzweck-Modelle und somit die Kühlanforderungen und den Ressourcenverbrauch senken.

Der Begriff beschreibt die untrennbare Verbindung und Wechselwirkung zwischen Wasser- und Energieverbrauch in der Kühlungsinfrastruktur von Serverfarmen. Oft muss mehr Strom für elektrische Kühler aufgewendet werden, um Wasser zu sparen, oder umgekehrt mehr Wasser verdunstet werden, um Strom zu sparen. Betreiber müssen ständig zwischen diesen beiden Ressourcen balancieren, abhängig von lokalen Kosten, Verfügbarkeit und ökologischen Rahmenbedingungen.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.