Kurz gesagt (TL;DR)

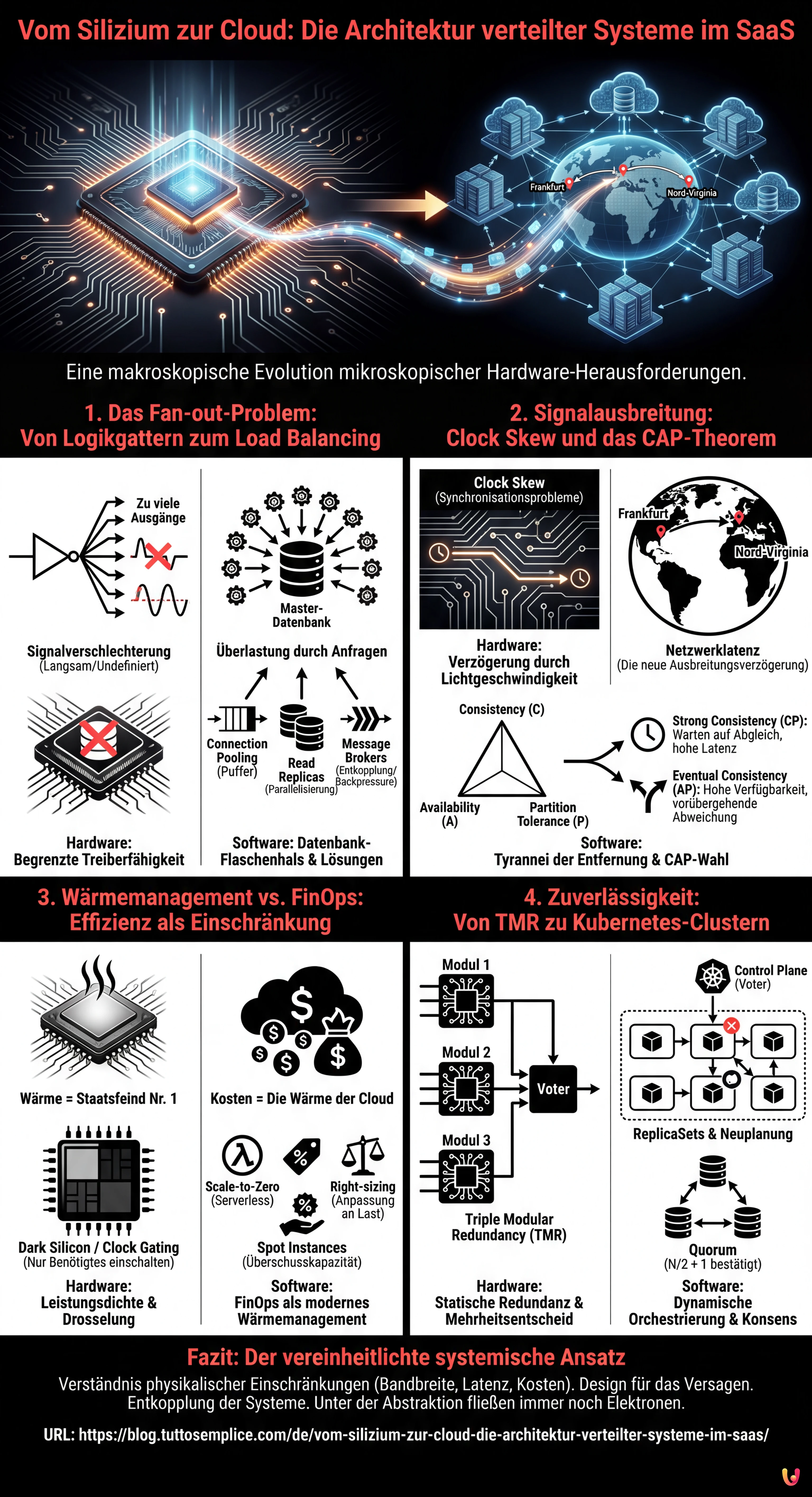

Die Architektur verteilter Systeme in der Cloud spiegelt auf makroskopischer Ebene die fundamentalen physikalischen Gesetze wider, die das Design integrierter Schaltkreise bestimmen.

Hardware-Einschränkungen wie Fan-out und Signalausbreitung erklären perfekt die modernen Herausforderungen von Load Balancing und Datenkonsistenz.

Die thermische Optimierung von Prozessoren findet ihr Äquivalent in FinOps, indem das Energiemanagement des Siliziums in Strategien zur Reduzierung von Cloud-Kosten transformiert wird.

Der Teufel steckt im Detail. 👇 Lesen Sie weiter, um die kritischen Schritte und praktischen Tipps zu entdecken, um keine Fehler zu machen.

Wir schreiben das Jahr 2026, und während generative künstliche Intelligenz die Regeln der Mensch-Maschine-Interaktion neu geschrieben hat, bleiben die fundamentalen Gesetze der Physik und Logik unverändert. Für jemanden wie mich, der seine Karriere mit einem Lötkolben in der Hand und dem Schaltplan eines integrierten Schaltkreises (IC) auf dem Tisch begann, erscheint die aktuelle Landschaft des Cloud Computing nicht als eine fremde Welt, sondern als eine Evolution auf makroskopischer Ebene von Problemen, die wir bereits auf mikroskopischer Ebene gelöst haben. Im Mittelpunkt steht die Architektur verteilter Systeme: ein Konzept, das wir heute auf globale Cluster anwenden, das aber aus den Verbindungen zwischen Transistoren auf einem Silizium-Wafer stammt.

In diesem technischen Essay werden wir untersuchen, wie die systemische Denkweise, die für das Design zuverlässiger Hardware erforderlich ist, der Schlüssel zum Aufbau robuster Software ist. Wir werden analysieren, wie die physikalischen Einschränkungen des Siliziums ihre perfekten Analogien in den immateriellen Herausforderungen moderner SaaS-Lösungen finden.

1. Das Fan-out-Problem: Von Logikgattern zum Load Balancing

In der Elektronik definiert das Fan-out die maximale Anzahl logischer Eingänge, die ein Ausgang zuverlässig ansteuern kann. Wenn ein Logikgatter versucht, ein Signal an zu viele andere Gatter zu senden, teilt sich der Strom übermäßig auf, das Signal verschlechtert sich und das Umschalten (0 auf 1 oder umgekehrt) wird langsam oder undefiniert. Es ist eine physikalische Grenze der Treiberfähigkeit.

Die Analogie in der Software: Der Datenbank-Flaschenhals

In der Architektur verteilter Systeme manifestiert sich das Konzept des Fan-out brutal, wenn ein einzelner Dienst (z. B. eine Master-Datenbank oder ein Authentifizierungsdienst) von zu vielen gleichzeitigen Anfragen von Client-Microservices bombardiert wird. Genau wie ein Transistor keinen unendlichen Strom liefern kann, hat eine Datenbank keine unendlichen TCP-Verbindungen oder CPU-Zyklen.

Die Hardware-Lösung ist das Einfügen von Puffern, um das Signal zu regenerieren und die Treiberfähigkeit zu erhöhen. Im SaaS wenden wir dasselbe Prinzip an durch:

- Connection Pooling: Dies wirkt wie ein Strompuffer, der Verbindungen aktiv und wiederverwendbar hält.

- Read Replicas: Diese parallelisieren die Leselast, ähnlich dem Hinzufügen von Verstärkerstufen in Parallelschaltung.

- Message Brokers (Kafka/RabbitMQ): Diese entkoppeln den Produzenten vom Konsumenten und bewältigen Lastspitzen (Backpressure) genau so, wie ein Entkopplungskondensator die Spannung während Lastspitzen stabilisiert.

2. Signalausbreitung: Clock Skew und das CAP-Theorem

Bei Hochfrequenzschaltungen ist die Lichtgeschwindigkeit (oder besser gesagt, die Ausbreitungsgeschwindigkeit des Signals in Kupfer/Gold) eine spürbare Einschränkung. Wenn eine Leiterbahn auf der Platine länger ist als eine andere, kommt das Signal verspätet an, was zu Synchronisationsproblemen führt, die als Clock Skew bekannt sind. Das System wird inkohärent, weil verschiedene Teile des Chips die “Realität” zu unterschiedlichen Zeitpunkten sehen.

Die Tyrannei der Entfernung in der Cloud

In der Cloud ist die Netzwerklatenz die neue Ausbreitungsverzögerung. Wenn wir eine geo-redundante Architektur verteilter Systeme entwerfen, können wir nicht ignorieren, dass das Licht Zeit benötigt, um von Frankfurt nach Nord-Virginia zu reisen. Diese physikalische Verzögerung ist die Wurzel des CAP-Theorems (Consistency, Availability, Partition tolerance).

Ein Elektronikingenieur weiß, dass er auf einem riesigen Chip kein perfekt synchrones Signal haben kann, ohne den Takt zu verlangsamen (Leistung zugunsten der Kohärenz opfern). Ebenso muss ein Softwarearchitekt wählen zwischen:

- Strong Consistency (CP): Warten, bis alle Knoten abgeglichen sind (wie ein langsamer globaler Takt), wobei eine hohe Latenz in Kauf genommen wird.

- Eventual Consistency (AP): Den Knoten erlauben, vorübergehend abzuweichen, um eine hohe Verfügbarkeit und niedrige Latenz aufrechtzuerhalten, wobei Konflikte im Nachhinein gelöst werden (ähnlich wie bei asynchronen oder self-timed Schaltungen).

3. Wärmemanagement vs. FinOps: Effizienz als Einschränkung

Die Leistungsdichte ist der Staatsfeind Nummer eins bei modernen Prozessoren. Wenn die Wärme nicht abgeführt wird, geht der Chip ins Thermal Throttling (verlangsamt sich) oder brennt durch. Das moderne VLSI-Design (Very Large Scale Integration) dreht sich um das Konzept des “Dark Silicon”: Wir können nicht alle Transistoren gleichzeitig einschalten, weil der Chip schmelzen würde. Wir müssen nur das einschalten, was benötigt wird, und zwar genau dann, wenn es benötigt wird.

Kosten sind die Wärme der Cloud

Im SaaS-Modell ist die “Wärme” gleichbedeutend mit den Betriebskosten. Eine ineffiziente Architektur lässt zwar nicht die Server schmelzen (darum kümmert sich der Cloud-Provider), aber sie verbrennt das Unternehmensbudget. FinOps ist das moderne Wärmemanagement.

So wie ein Hardware-Ingenieur Clock Gating verwendet, um nicht genutzte Teile des Chips abzuschalten, muss ein Cloud Architect Folgendes implementieren:

- Scale-to-Zero: Nutzung von Serverless-Technologien (wie AWS Lambda oder Google Cloud Run), um Ressourcen vollständig abzuschalten, wenn kein Datenverkehr vorhanden ist.

- Spot Instances: Nutzung überschüssiger Kapazitäten zu niedrigen Kosten unter Inkaufnahme des Unterbrechungsrisikos, ähnlich der Verwendung von Komponenten mit größeren Toleranzen in unkritischen Schaltkreisen.

- Right-sizing: Anpassung der Ressourcen an die tatsächliche Last, um Überprovisionierung zu vermeiden, was in der Hardware-Welt der Verwendung eines 1-kg-Kühlkörpers für einen 5-W-Chip entspräche.

4. Zuverlässigkeit: Von TMR zu Kubernetes-Clustern

In Avionik- oder Raumfahrtsystemen, wo eine Reparatur unmöglich ist und Strahlung zufällig ein Bit umkehren kann (Single Event Upset), wird die Triple Modular Redundancy (TMR) verwendet. Drei identische Schaltkreise führen dieselbe Berechnung durch, und ein Abstimmungsschaltkreis (Voter) entscheidet über den Ausgang basierend auf der Mehrheit. Wenn einer ausfällt, funktioniert das System weiter.

Die Orchestrierung der Resilienz

Dies ist genau die Essenz eines Kubernetes-Clusters oder einer verteilten Datenbank mit Raft/Paxos-Konsens. In einer modernen Architektur verteilter Systeme:

- ReplicaSets: Halten mehrere Kopien (Pods) desselben Dienstes vor. Wenn ein Knoten ausfällt (Hardwarefehler), bemerkt dies die Control Plane (der “Voter”) und plant den Pod woanders neu ein.

- Quorum in Datenbanken: Um einen Schreibvorgang in einem Cluster (z. B. Cassandra oder etcd) zu bestätigen, verlangen wir, dass die Mehrheit der Knoten (N/2 + 1) die Operation bestätigt. Dies ist mathematisch identisch mit der Abstimmungslogik der Hardware-TMR.

Der wesentliche Unterschied besteht darin, dass die Redundanz in der Hardware statisch (fest verdrahtet) ist, während sie in der Software dynamisch und rekonfigurierbar ist. Das Grundprinzip bleibt jedoch bestehen: Vertraue niemals der einzelnen Komponente.

Fazit: Der vereinheitlichte systemische Ansatz

Der Übergang vom Silizium zur Cloud bedeutet nicht, den Beruf zu wechseln, sondern den Maßstab zu ändern. Das Design einer effektiven Architektur verteilter Systeme erfordert dieselbe Disziplin, die für das Tape-out eines Mikroprozessors notwendig ist:

- Verständnis der physikalischen Einschränkungen (Bandbreite, Latenz, Kosten/Wärme).

- Design für das Versagen (die Komponente wird kaputtgehen, das Paket wird verloren gehen).

- Entkopplung der Systeme, um die Ausbreitung von Fehlern zu vermeiden.

Im Jahr 2026 sind die Werkzeuge unglaublich abstrakt geworden. Wir schreiben YAML, das flüchtige Infrastrukturen beschreibt. Aber unter diesen Abstraktionsebenen gibt es immer noch Elektronen, die fließen, Takte, die ticken, und Puffer, die sich füllen. Das Bewusstsein für diese physikalische Realität zu bewahren, unterscheidet einen guten Entwickler von einem wahren Systemarchitekten.

Häufig gestellte Fragen

Die Cloud-Architektur wird als eine Evolution mikroskopischer Herausforderungen typischer integrierter Schaltkreise auf makroskopischer Ebene betrachtet. Physikalische Probleme wie das Wärmemanagement und die Signalausbreitung im Silizium finden eine direkte Entsprechung im Kostenmanagement und in der Netzwerklatenz der Software, was eine ähnliche systemische Denkweise erfordert, um Resilienz und betriebliche Effizienz zu gewährleisten.

Das Fan-out in der Software manifestiert sich, wenn ein einzelner Dienst, wie eine Master-Datenbank, eine übermäßige Anzahl gleichzeitiger Anfragen erhält, analog zu einem Logikgatter, das zu viele Eingänge ansteuert. Um diesen Engpass zu mildern, werden Lösungen wie Connection Pooling, Leserepliken und Message Broker eingesetzt, die als Puffer fungieren, um die Last zu stabilisieren und einen Leistungsabfall zu verhindern.

Die Netzwerklatenz, vergleichbar mit der Signalausbreitungsverzögerung in elektronischen Schaltkreisen, verhindert die sofortige Synchronisation zwischen geografisch entfernten Knoten. Diese physikalische Einschränkung zwingt Softwarearchitekten zur Wahl zwischen Strong Consistency, wobei höhere Latenzen akzeptiert werden, um auf den Abgleich der Knoten zu warten, oder Eventual Consistency, die die Verfügbarkeit priorisiert und vorübergehende Datenabweichungen toleriert.

Im SaaS-Modell stellen die Betriebskosten das Äquivalent zur in Prozessoren erzeugten Wärme dar: Beide sind limitierende Faktoren, die kontrolliert werden müssen. FinOps-Strategien wie Scale-to-Zero und Right-sizing spiegeln Hardware-Techniken wie Clock Gating wider, indem ungenutzte Ressourcen abgeschaltet oder skaliert werden, um die Effizienz zu optimieren und zu verhindern, dass das Budget unnötig verbraucht wird.

Kubernetes-Cluster wenden die Prinzipien der Triple Modular Redundancy, die in kritischen Hardware-Systemen verwendet wird, dynamisch an. Durch die Verwendung von ReplicaSets und Konsensalgorithmen für verteilte Datenbanken überwacht das System ständig den Status der Dienste und ersetzt ausgefallene Knoten basierend auf Abstimmungs- und Mehrheitsmechanismen, wodurch die betriebliche Kontinuität ohne Single Points of Failure sichergestellt wird.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.