Il telefono squilla durante il pranzo della domenica. Il numero è sconosciuto o nascosto, ma dall’altra parte del filo c’è una voce inconfondibile. È vostro figlio, o forse vostro nipote. Sembra spaventato, agitato. Dice di aver avuto un incidente, di essere nei guai con la legge o di aver bisogno urgente di denaro per un’emergenza medica. L’istinto di protezione scatta immediatamente. Il cuore batte forte. Non c’è tempo per pensare, bisogna agire.

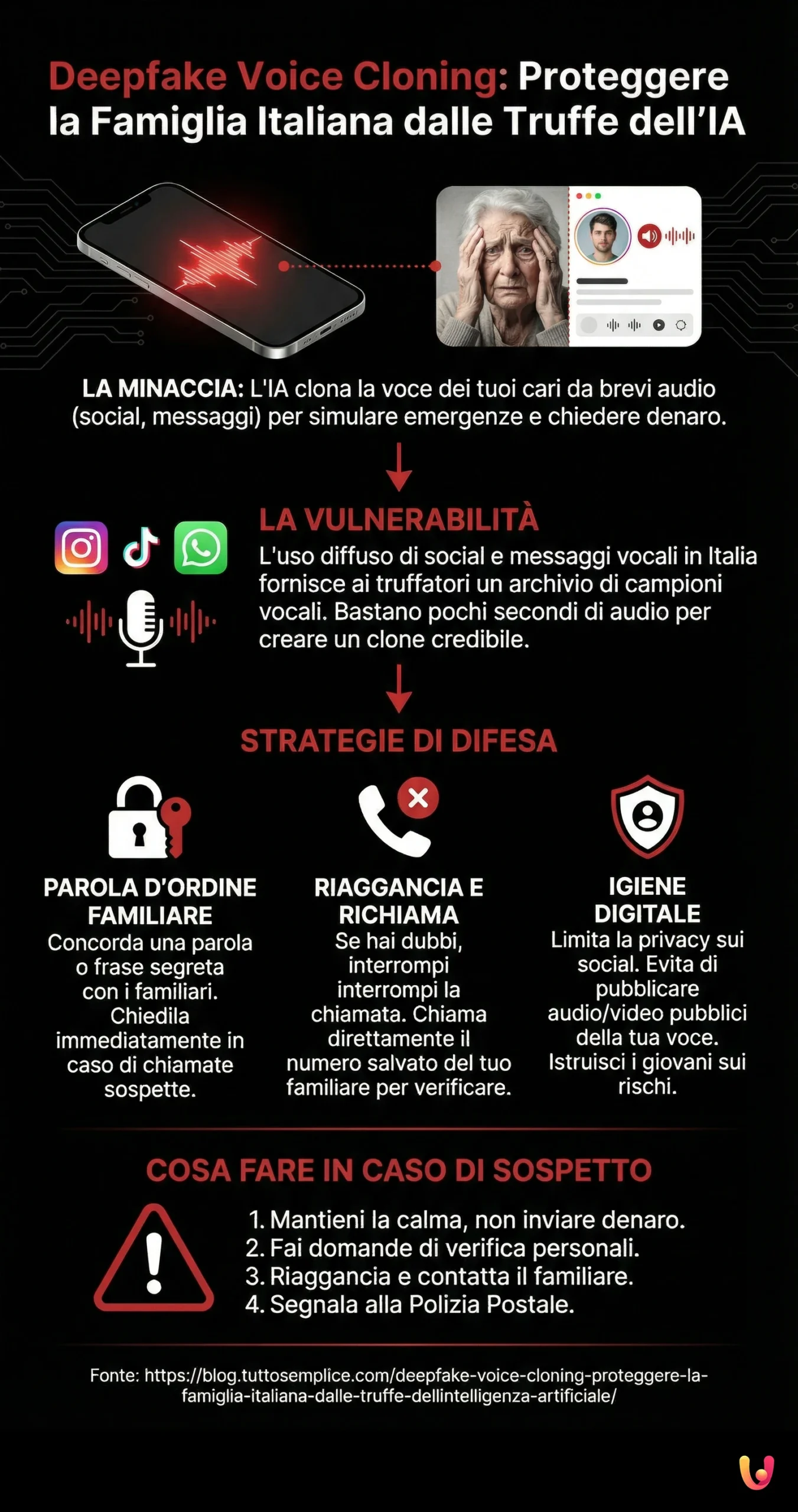

Fermatevi. Respirate. Quella che avete appena sentito potrebbe non essere la voce del vostro caro, ma un clone generato dall’intelligenza artificiale. Questa non è la trama di un film di fantascienza, ma una realtà crescente che minaccia la tranquillità delle famiglie italiane ed europee. La tecnologia di clonazione vocale è diventata così sofisticata che bastano pochi secondi di audio, magari presi da una storia su Instagram o un messaggio vocale, per replicare fedelmente timbro, accento e pause di una persona.

In un contesto culturale come quello mediterraneo, dove i legami familiari sono sacri e la fiducia nella parola data è radicata nella tradizione, questa minaccia è particolarmente insidiosa. I truffatori sfruttano il nostro affetto per colpirci dove siamo più vulnerabili. Capire come funziona questa tecnologia e come difendersi è diventato un dovere per proteggere non solo i nostri risparmi, ma l’integrità del nostro nucleo familiare.

La fiducia è un bene prezioso, ma nell’era digitale, la verifica è l’unica vera forma di protezione per chi amiamo.

L’evoluzione della truffa: dal “finto nipote” al clone digitale

La truffa del “finto nipote” esiste da anni. Un tempo, i malviventi si affidavano a linee disturbate e alla confusione emotiva dell’anziano per farsi passare per un parente in difficoltà. Oggi, l’intelligenza artificiale ha eliminato la necessità di recitare. I software di Deepfake Audio possono analizzare una breve campionatura vocale e generare nuove frasi che la vittima non ha mai pronunciato, mantenendo un realismo agghiacciante.

Secondo recenti studi sulla sicurezza informatica, l’intelligenza artificiale può ingannare anche l’orecchio più attento. Una ricerca condotta da McAfee ha rivelato che il 70% delle persone non è sicuro di saper distinguere una voce clonata da quella reale. Questo dato è allarmante se consideriamo l’uso massiccio che facciamo dei social media in Italia, condividendo quotidianamente video e audio che diventano materia prima per i truffatori.

Il mercato europeo sta assistendo a un incremento di questi attacchi, complice la facilità di accesso a strumenti di AI generativa. Non servono più competenze da hacker esperto: molte applicazioni sono disponibili online a costi irrisori. La barriera tecnologica è crollata, lasciando le famiglie esposte a rischi che fino a pochi anni fa erano inimmaginabili.

Come funziona la clonazione vocale e perché siamo vulnerabili

La tecnologia alla base del Voice Cloning utilizza reti neurali profonde. Il software “ascolta” l’audio originale, ne mappa le caratteristiche biometriche uniche e crea un modello digitale. Più audio viene fornito, più il risultato sarà perfetto. Tuttavia, le versioni più moderne necessitano di soli tre secondi di parlato per creare un clone credibile.

La nostra vulnerabilità nasce dalle nostre abitudini. L’Italia è uno dei paesi con il più alto utilizzo di WhatsApp e messaggi vocali. Amiamo raccontare, condividere, far sentire la nostra presenza. Questa espansività digitale è un tratto bellissimo della nostra cultura, ma offre ai criminali un archivio infinito di campioni vocali. Un video pubblico su Facebook, una storia su TikTok o un vocale inoltrato possono finire nelle mani sbagliate.

La vostra voce è diventata una password biometrica che lasciate incustodita ogni volta che pubblicate un video pubblico senza restrizioni.

Inoltre, la qualità delle chiamate VoIP (quelle fatte tramite internet) spesso maschera le piccole imperfezioni che potrebbero tradire un deepfake. Se la voce sembra un po’ metallica, tendiamo a dare la colpa alla connessione, non a pensare a un’intelligenza artificiale. Questo bias cognitivo è il miglior alleato dei truffatori.

Strategie di difesa: tra innovazione e vecchie tradizioni

Per difendersi da una minaccia iper-tecnologica, la soluzione più efficace è, paradossalmente, molto analogica e tradizionale. Dobbiamo recuperare vecchie abitudini di sicurezza familiare e adattarle al mondo moderno. Non serve essere esperti informatici, basta stabilire protocolli di comunicazione chiari all’interno della famiglia.

La “Parola d’Ordine” familiare

Questa è la difesa più potente in assoluto. Concordate con i vostri familiari (genitori, figli, nonni) una parola di sicurezza o una frase segreta. Deve essere qualcosa di semplice da ricordare ma impossibile da indovinare per un estraneo. Se ricevete una chiamata di emergenza da un “figlio” che chiede soldi, chiedete immediatamente la parola d’ordine. L’intelligenza artificiale non può saperla.

La regola del “Riaggancia e Richiama”

Se ricevete una chiamata sospetta da un numero sconosciuto, o anche dal numero di un familiare che sembra comportarsi in modo strano, non agite d’impulso. Riagganciate. Poi, chiamate voi stessi il numero del familiare che avete salvato in rubrica. Se il telefono del vostro caro è libero o vi risponde tranquillamente, avrete sventato la truffa. I truffatori contano sul panico per impedirvi di verificare.

Igiene digitale sui Social Media

È tempo di rivedere le impostazioni di privacy. Limitate la visibilità dei vostri profili social solo agli amici stretti. Evitate di pubblicare video in cui parlate chiaramente per lunghi periodi se il profilo è pubblico. Istruite i più giovani, spesso meno attenti alla privacy, sui rischi di esporre la propria voce e quella dei familiari online. La riservatezza è la prima linea di difesa.

Il ruolo delle Istituzioni e la normativa europea

L’Unione Europea sta lavorando attivamente per regolamentare l’uso dell’intelligenza artificiale. L’AI Act europeo è un passo avanti fondamentale, classificando certi usi dell’AI come ad alto rischio e imponendo obblighi di trasparenza. Le piattaforme dovrebbero, in teoria, etichettare i contenuti generati artificialmente, ma i truffatori operano nell’illegalità e ignorano queste regole.

In Italia, la Polizia Postale è molto attiva nel monitorare questi fenomeni e nel fare campagna di sensibilizzazione. Tuttavia, la velocità con cui la tecnologia evolve supera spesso i tempi della burocrazia e delle indagini. Per questo motivo, la prevenzione individuale rimane l’arma più efficace. Segnalare ogni tentativo di truffa alle autorità è cruciale per aiutare le forze dell’ordine a mappare e contrastare le nuove tecniche criminali.

In Breve (TL;DR)

I truffatori utilizzano l’intelligenza artificiale per clonare la voce dei propri cari e ingannare le famiglie italiane con false richieste di aiuto.

Bastano pochi secondi di audio presi dai social media per replicare fedelmente timbro e accento, rendendo le truffe telefoniche difficili da riconoscere.

Per difendersi da queste minacce digitali è fondamentale verificare l’identità del chiamante e stabilire protocolli di sicurezza come una parola d’ordine familiare.

Conclusioni

Il fenomeno del Deepfake Voice Cloning rappresenta una sfida complessa che colpisce al cuore la nostra fiducia nelle interazioni umane. In un paese come l’Italia, dove la voce di un familiare è sinonimo di casa e sicurezza, l’impatto emotivo di queste truffe è devastante. Tuttavia, non dobbiamo cedere alla paura o rifiutare il progresso tecnologico.

La chiave per proteggere le nostre famiglie risiede in un equilibrio tra innovazione e prudenza. Adottare semplici accorgimenti, come la “parola d’ordine” familiare, e mantenere un sano scetticismo digitale ci permette di costruire uno scudo efficace. L’intelligenza artificiale è uno strumento potente, ma l’intelligenza umana, unita all’istinto e alla comunicazione sincera, rimane insuperabile. Informarsi e parlarne in famiglia è il primo, fondamentale passo per disinnescare questa minaccia invisibile.

Domande frequenti

La truffa del voice cloning è una tecnica criminale che utilizza l’intelligenza artificiale per replicare fedelmente la voce di una persona, analizzandone le caratteristiche biometriche. I truffatori usano software di deepfake audio per generare frasi mai pronunciate dalla vittima, simulando situazioni di emergenza (come incidenti o arresti) per estorcere denaro ai familiari, sfruttando l’impatto emotivo e la somiglianza quasi perfetta con la voce reale.

I criminali reperiscono i campioni vocali necessari principalmente dai social media e dalle app di messaggistica. Video pubblici su Facebook, storie su Instagram, TikTok o messaggi vocali inoltrati su WhatsApp forniscono materiale sufficiente per l’addestramento dell’AI. Le tecnologie più recenti necessitano di appena tre secondi di parlato per creare un clone digitale credibile, rendendo rischiosa la condivisione pubblica di contenuti audio senza restrizioni di privacy.

La strategia di difesa più efficace consiste nello stabilire una ‘parola d’ordine’ o una frase di sicurezza nota solo ai membri della famiglia, da richiedere immediatamente in caso di telefonate di emergenza insolite. È inoltre fondamentale adottare una rigorosa igiene digitale, limitando la visibilità dei profili social agli amici stretti ed evitando di pubblicare video in cui la voce è chiaramente udibile per lunghi periodi su piattaforme pubbliche.

Se ricevi una richiesta di aiuto urgente, non agire d’impulso e non inviare denaro. La regola d’oro è ‘Riaggancia e Richiama’: interrompi la comunicazione e chiama tu stesso il numero del familiare salvato nella tua rubrica. Spesso i truffatori usano numeri sconosciuti o mascherati; richiamando il contatto reale potrai verificare immediatamente se la persona è al sicuro, sventando il tentativo di raggiro basato sul panico.

Distinguere una voce clonata è sempre più difficile, poiché l’AI moderna replica accenti e pause con grande precisione; studi indicano che il 70% delle persone non riesce a notare la differenza. Tuttavia, si può prestare attenzione a piccoli segnali come un suono leggermente metallico o innaturale, spesso mascherato dalla bassa qualità delle chiamate VoIP. A causa di questa difficoltà, la verifica tramite contro-chiamata o parola d’ordine rimane più sicura dell’affidarsi al proprio udito.

Fonti e Approfondimenti

- Garante per la protezione dei dati personali: Scheda informativa e rischi dei Deepfake

- Federal Trade Commission: Allerta consumatori sulle truffe familiari tramite clonazione vocale AI

- Wikipedia: Definizione tecnica e storia della tecnologia Deepfake

- Parlamento Europeo: Approfondimento sulle minacce dei contenuti sintetici

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.