En Breve (TL;DR)

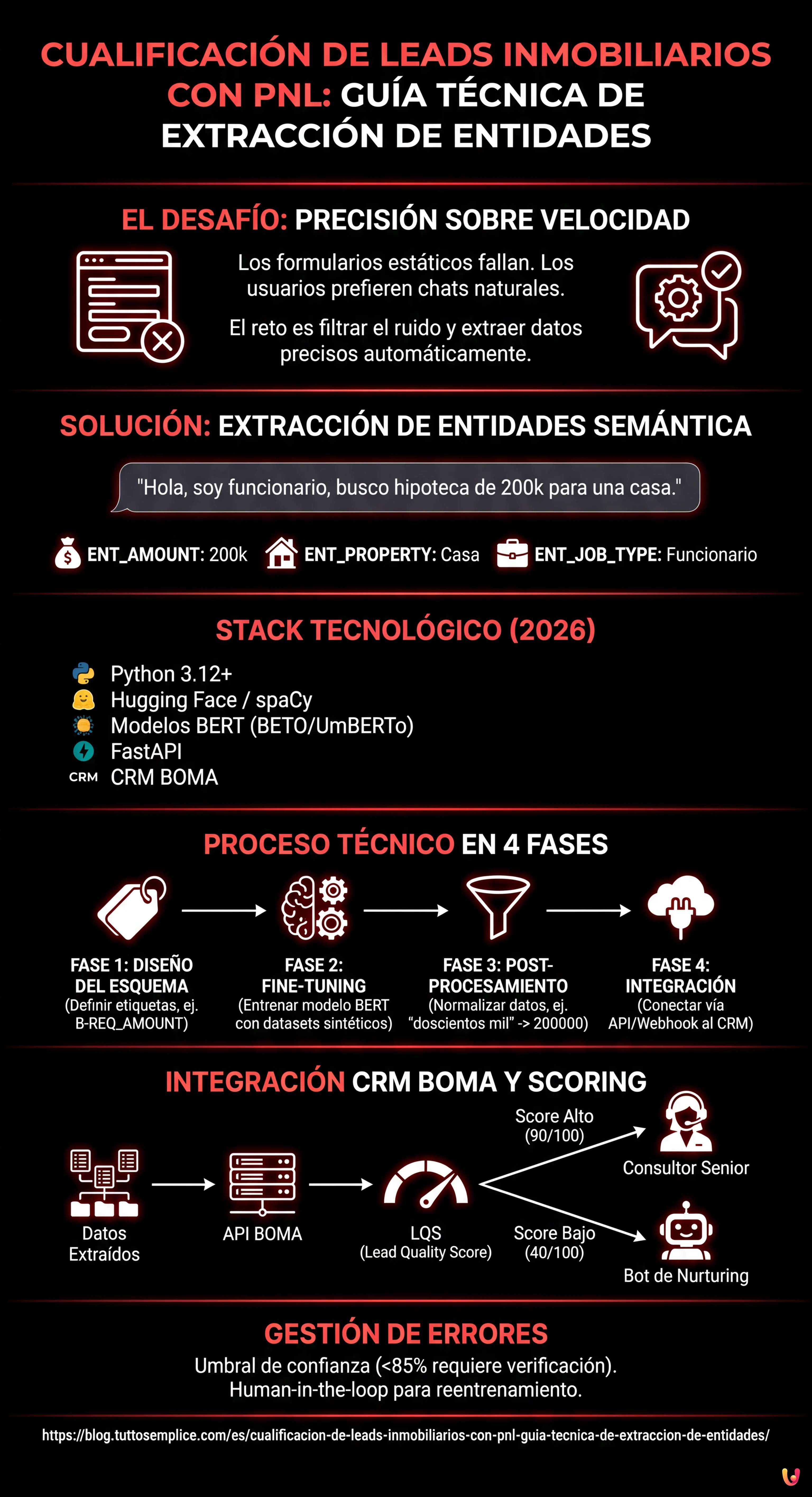

La automatización mediante PNL transforma la cualificación de leads inmobiliarios, superando los formularios estáticos para extraer datos precisos de conversaciones naturales.

El fine-tuning de modelos BERT permite crear sistemas NER personalizados capaces de identificar importes, profesiones y tipologías inmobiliarias.

La normalización de los datos extraídos y la integración directa en el CRM BOMA optimizan el cálculo del rating crediticio y la gestión comercial.

El diablo está en los detalles. 👇 Sigue leyendo para descubrir los pasos críticos y los consejos prácticos para no equivocarte.

En el panorama competitivo de 2026, la velocidad de respuesta ya no es el único factor determinante en el sector del crédito y del real estate. El verdadero desafío reside en la precisión y en la capacidad de filtrar el ruido. La cualificación de leads inmobiliarios ha pasado de ser una tarea manual realizada por call centers a un proceso automatizado guiado por algoritmos de Procesamiento del Lenguaje Natural (PNL). En esta guía técnica, exploraremos cómo construir un sistema de Named Entity Recognition (NER) personalizado para extraer datos estructurados de conversaciones no estructuradas e integrarlos directamente en el CRM BOMA.

Por qué la Extracción de Entidades cambia la Cualificación de Leads Inmobiliarios

Los formularios estáticos en los sitios web (Nombre, Apellidos, Teléfono) tienen tasas de conversión cada vez más bajas. Los usuarios prefieren interactuar a través de chats naturales o mensajes de voz. Sin embargo, esto genera datos no estructurados difíciles de procesar. Aquí entra en juego la Extracción de Entidades Semántica.

El objetivo no es solo entender la intención (ej. “quiero una hipoteca”), sino extraer slots específicos de información necesarios para el cálculo del rating crediticio o la viabilidad de la compra. Un sistema bien diseñado debe identificar:

- ENT_AMOUNT: El importe solicitado (ej. “necesito 200k”).

- ENT_LTV: El Loan-to-Value implícito o el valor del inmueble.

- ENT_JOB_TYPE: El tipo de contrato (ej. “indefinido”, “autónomo”).

- ENT_PROPERTY: Tipología del inmueble y certificación energética.

Requisitos previos y Stack Tecnológico

Para seguir esta guía, es necesario un conocimiento intermedio de Python y de los principios de Machine Learning. Utilizaremos el siguiente stack, estandarizado para 2026:

- Lenguaje: Python 3.12+

- Framework PNL: Hugging Face Transformers, spaCy 4.x

- Modelos Base:

UmBERTo(para italiano) o versiones cuantizadas deLlama-3-8B-Instructpara tareas generativas. - Backend: FastAPI para la exposición del modelo.

- Target CRM: BOMA (vía API REST/Webhook).

Fase 1: Diseño del Esquema de Entidades

Antes de escribir código, debemos definir qué debe buscar nuestro modelo. En el contexto de las hipotecas, la jerga es específica. Un modelo genérico fallaría al distinguir entre “entrada” y “cuota”.

Definimos las etiquetas para nuestro dataset de entrenamiento:

NER_TAGS = [

"O", # Outside (ninguna entidad)

"B-REQ_AMOUNT", # Inicio importe solicitado

"I-REQ_AMOUNT", # Interno importe solicitado

"B-JOB_STATUS", # Inicio estado laboral

"I-JOB_STATUS", # Interno estado laboral

"B-PROPERTY_VAL", # Valor inmueble

"B-INTENT_TIME" # Plazo deseado (ej. "escritura antes de marzo")

]

Fase 2: Preparación del Dataset y Fine-Tuning

Para obtener una cualificación de leads inmobiliarios precisa, no podemos confiar en modelos generalistas zero-shot para la extracción masiva, ya que son costosos y lentos. La mejor solución es el fine-tuning de un modelo basado en BERT.

1. Creación del Dataset Sintético

Si no disponéis de históricos de chat que cumplan con el RGPD, podéis generar un dataset sintético utilizando un LLM (como Meta AI Llama 3) para crear miles de variaciones de frases típicas:

“Soy funcionario y busco una hipoteca para una casa de 250.000 euros, tengo 50k de entrada.”

Anotad estas frases en el formato JSONL estándar para el entrenamiento (formato BIO).

2. Fine-Tuning con Hugging Face

Utilizaremos dbmdz/bert-base-italian-xxl-cased como base, siendo uno de los modelos con mejor rendimiento en sintaxis italiana (nota: adaptar al modelo español correspondiente si el target es ES, ej. BETO). Aquí un snippet simplificado para el bucle de entrenamiento:

from transformers import AutoTokenizer, AutoModelForTokenClassification, TrainingArguments, Trainer

model_name = "dbmdz/bert-base-italian-xxl-cased"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForTokenClassification.from_pretrained(model_name, num_labels=len(NER_TAGS))

args = TrainingArguments(

output_dir="./boma-ner-v1",

evaluation_strategy="epoch",

learning_rate=2e-5,

per_device_train_batch_size=16,

num_train_epochs=5,

weight_decay=0.01,

)

# Suponiendo que 'tokenized_datasets' ya esté preparado

trainer = Trainer(

model=model,

args=args,

train_dataset=tokenized_datasets["train"],

eval_dataset=tokenized_datasets["validation"],

tokenizer=tokenizer,

)

trainer.train()

Este proceso adapta los pesos del modelo para reconocer específicamente términos como “subrogación”, “tipo fijo” o “asesor” en el contexto de la frase.

Fase 3: Post-Procesamiento y Normalización

El modelo NER devuelve tokens y etiquetas. Para la cualificación de leads inmobiliarios, debemos transformar "doscientos mil euros" en 200000 (Integer). Esta fase de normalización es crítica para poblar la base de datos.

Utilizamos librerías como word2number o regex personalizadas para limpiar la salida del modelo antes del envío al CRM.

Fase 4: Integración en el CRM BOMA

Una vez que el modelo está expuesto vía API (ej. en un contenedor Docker), debemos conectarlo al flujo de entrada de los leads. La integración con BOMA se realiza habitualmente mediante webhooks que se activan al recibir un nuevo mensaje.

Lógica de Scoring y Enrutamiento

No todos los leads son iguales. Utilizando los datos extraídos, podemos calcular un Lead Quality Score (LQS) en tiempo real:

- Lead A (Score 90/100): Datos completos (Trabajo, Importe, Inmueble), LTV Enrutamiento inmediato al Consultor Senior.

- Lead B (Score 40/100): Datos parciales, LTV > 95%, Contrato Temporal. -> Enrutamiento al Bot de Nurturing automático.

Aquí un ejemplo de payload JSON para enviar a las API de BOMA:

{

"lead_source": "Whatsapp_Business",

"message_body": "Hola, quisiera info para hipoteca primera vivienda, soy enfermero",

"extracted_data": {

"job_type": "enfermero",

"job_category": "empleado_publico",

"intent": "compra_primera_vivienda"

},

"ai_score": 75,

"routing_action": "assign_to_human"

}

Troubleshooting: Gestión de Alucinaciones y Ambigüedad

Incluso los mejores modelos pueden fallar. Así es como mitigamos los riesgos:

- Confidence Threshold (Umbral de Confianza): Si el modelo extrae una entidad con una confianza inferior al 85%, el sistema debe marcar el campo como “A verificar” en el CRM BOMA, requiriendo la intervención humana.

- Human-in-the-loop: Implementar un mecanismo de feedback donde los agentes inmobiliarios puedan corregir el etiquetado en el CRM. Estos datos corregidos deben reincorporarse al dataset de entrenamiento para el reentrenamiento mensual del modelo.

- Gestión del Dialecto: Entrenar el modelo con datasets que incluyan expresiones coloquiales regionales usadas a menudo en chats informales.

Conclusiones

La implementación de un sistema de Extracción de Entidades para la cualificación de leads inmobiliarios ya no es un ejercicio académico, sino una necesidad operativa. Automatizando la extracción de datos críticos (LTV, trabajo, presupuesto) e integrándolos directamente en BOMA, las agencias pueden reducir el tiempo de primer contacto de horas a segundos, asignando los expedientes más complejos a los mejores consultores y dejando a la IA la gestión del filtrado inicial.

Preguntas frecuentes

Se trata de un proceso basado en PNL que identifica y extrae datos específicos, como el importe de la hipoteca o el tipo de contrato, a partir de conversaciones naturales y no estructuradas. A diferencia de los formularios estáticos, esta tecnología permite comprender la intención del usuario y rellenar automáticamente los campos necesarios para el cálculo del rating crediticio directamente en el CRM.

Para obtener un alto rendimiento en sintaxis compleja, la mejor opción recae en el fine-tuning de modelos basados en BERT como UmBERTo (para italiano) o BETO (para español). Estos modelos son superiores a las soluciones generalistas zero-shot porque pueden ser entrenados para reconocer la jerga específica del sector crediticio, distinguiendo términos técnicos como cuota, entrada o subrogación.

Integrando un modelo de extracción de entidades vía API o Webhook, BOMA puede recibir datos ya limpios y normalizados. Esto permite asignar una puntuación de calidad al lead en tiempo real y enrutar automáticamente los contactos: los perfiles completos van a los consultores senior, mientras que los parciales son gestionados por bots de nurturing, optimizando el tiempo del equipo de ventas.

Un sistema bien diseñado extrae entidades críticas como el importe solicitado, el valor del inmueble para el cálculo del Loan-to-Value, la tipología contractual laboral y la certificación energética de la casa. Estos datos, definidos como slots informativos, son esenciales para determinar inmediatamente la viabilidad del expediente sin largas entrevistas preliminares.

Es necesario implementar un umbral de confianza, por ejemplo al 85 por ciento, por debajo del cual el sistema señala el dato como pendiente de verificar manualmente. Además, se adopta un enfoque human-in-the-loop donde las correcciones aportadas por los agentes inmobiliarios se guardan y reutilizan para el reentrenamiento periódico del modelo, mejorando su precisión con el tiempo.

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.