En Breve (TL;DR)

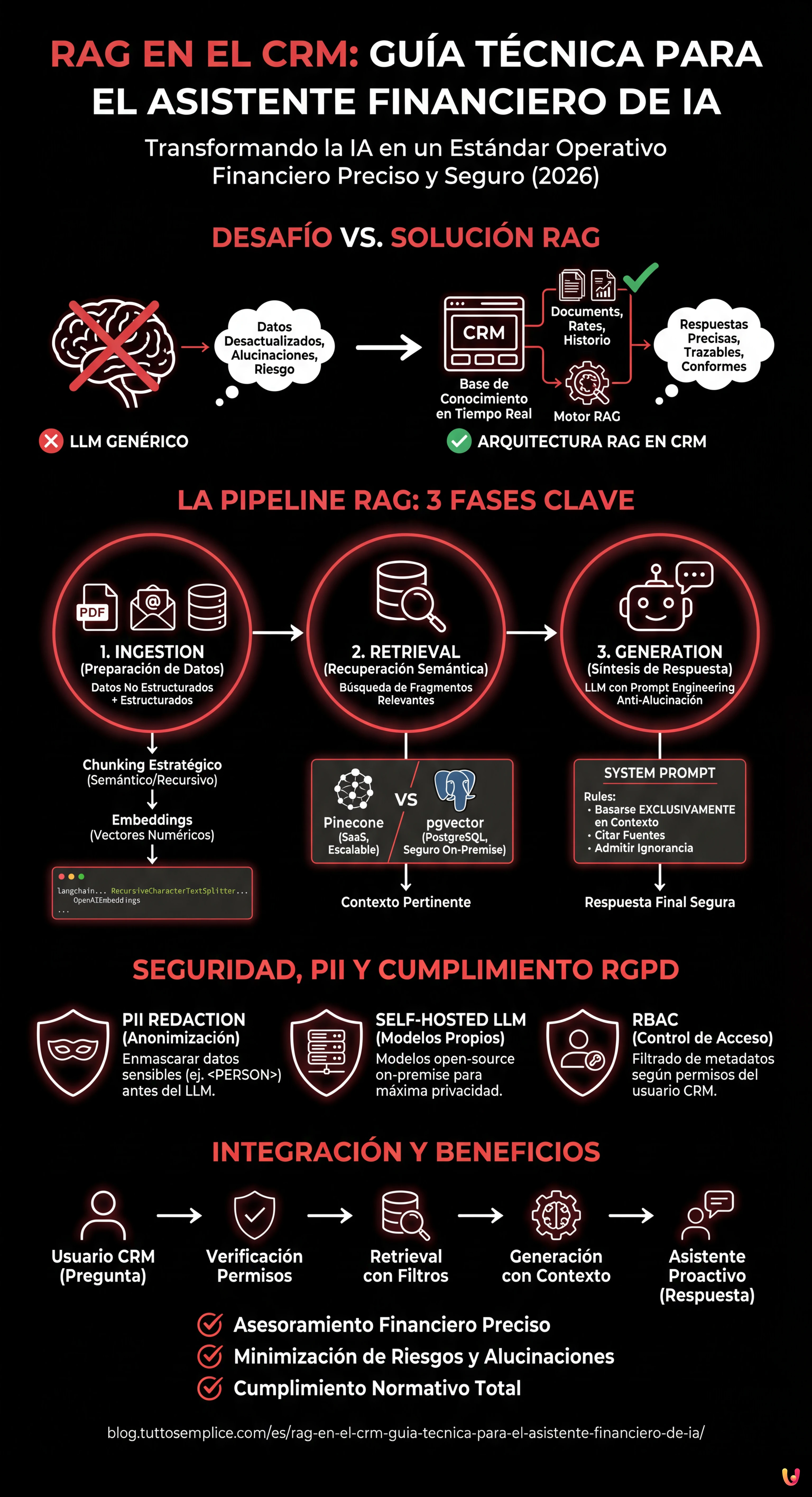

La arquitectura RAG potencia los CRM financieros consultando normativas y datos de clientes en tiempo real para generar respuestas precisas y libres de alucinaciones.

La pipeline técnica integra ingestión semántica, bases de datos vectoriales y prompt engineering para transformar documentos complejos en asesoramiento financiero seguro y totalmente trazable.

El uso estratégico de pgvector y chunking avanzado permite construir asistentes virtuales capaces de precalificar leads y gestionar hipotecas garantizando el cumplimiento normativo.

El diablo está en los detalles. 👇 Sigue leyendo para descubrir los pasos críticos y los consejos prácticos para no equivocarte.

Estamos en 2026 y la integración de la Inteligencia Artificial en los sistemas empresariales ya no es una novedad, sino un estándar operativo. Sin embargo, en el sector fintech e inmobiliario, el desafío no es solo generar texto, sino generar respuestas precisas, trazables y conformes. Aquí es donde entra en juego la arquitectura RAG en el CRM (Retrieval-Augmented Generation). A diferencia de un LLM genérico que se basa solo en su conjunto de entrenamiento (a menudo desactualizado), un sistema RAG permite a vuestro CRM propietario (como BOMA o soluciones personalizadas) consultar en tiempo real la documentación normativa, los tipos de interés actuales y el historial del cliente antes de formular una respuesta.

En este análisis técnico en profundidad, exploraremos cómo construir un asistente financiero inteligente capaz de precalificar leads y ofrecer asesoramiento sobre hipotecas, minimizando las alucinaciones y garantizando la máxima seguridad de los datos.

La Arquitectura RAG en el Contexto Financiero

La implementación de RAG en el CRM requiere una pipeline robusta compuesta por tres fases principales: Ingestion (preparación de datos), Retrieval (recuperación semántica) y Generation (síntesis de la respuesta). En el contexto de un CRM financiero, los datos no son solo texto libre, sino una combinación de:

- Datos No Estructurados: PDF de normativas bancarias, políticas de crédito, transcripciones de correos electrónicos.

- Datos Estructurados: Fichas de clientes, scoring crediticio, ratios LTV (Loan-to-Value) presentes en la base de datos SQL.

El objetivo es transformar estos datos en vectores numéricos (embeddings) que el LLM pueda “comprender” e interrogar.

Paso 1: Data Ingestion y Chunking Estratégico

El primer paso es la transformación de la documentación (ej. “Guía de Hipotecas 2026.pdf”) en fragmentos manejables. No podemos pasar un manual entero de 500 páginas en la ventana de contexto del LLM. Debemos dividir el texto en chunks (fragmentos).

Para documentos financieros, un chunking basado puramente en caracteres es arriesgado porque podría cortar una cláusula legal por la mitad. Utilizamos un enfoque semántico o recursivo.

Ejemplo de Código: Pipeline de Ingestion con LangChain

Aquí se muestra cómo implementar una función en Python para procesar los documentos y crear embeddings utilizando OpenAI (o modelos open-source equivalentes).

from langchain_community.document_loaders import PyPDFLoader

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_openai import OpenAIEmbeddings

import os

# Configuración API Key (gestionada vía variables de entorno por seguridad)

os.environ["OPENAI_API_KEY"] = "sk-..."

def process_financial_docs(file_path):

# 1. Carga del documento

loader = PyPDFLoader(file_path)

docs = loader.load()

# 2. Chunking Estratégico

# Tamaño de chunk de 1000 tokens con solapamiento de 200 para mantener el contexto entre fragmentos

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000,

chunk_overlap=200,

separators=["nn", "n", " ", ""]

)

splits = text_splitter.split_documents(docs)

# 3. Creación de los Embeddings

# Utilizamos text-embedding-3-small para un buen equilibrio coste/rendimiento

embeddings = OpenAIEmbeddings(model="text-embedding-3-small")

return splits, embeddingsPaso 2: Elección y Gestión de la Base de Datos Vectorial

Una vez creados los embeddings, ¿dónde los archivamos? La elección de la base de datos vectorial es crítica para el rendimiento de RAG en el CRM.

- Pinecone: Solución gestionada (SaaS). Excelente para escalabilidad y velocidad, pero los datos residen en nubes de terceros. Ideal si la política de la empresa lo permite.

- pgvector (PostgreSQL): La opción preferida para los CRM propietarios que ya usan Postgres. Permite ejecutar consultas híbridas (ej. “encuentra documentos semánticamente similares” AND “pertenecientes al cliente ID=123”).

Si estamos construyendo un asistente financiero interno, pgvector ofrece la ventaja de mantener los datos vectoriales dentro del mismo perímetro de seguridad que los datos financieros estructurados.

Paso 3: Retrieval y Prompt Engineering Anti-Alucinación

El corazón del sistema es la recuperación de la información pertinente. Cuando un operador pregunta al CRM: “¿Puede el cliente García acceder a la Hipoteca Joven con un ISEE de 35k?”, el sistema debe recuperar las políticas relativas a la “Hipoteca Joven” y los límites ISEE.

Sin embargo, recuperar los datos no es suficiente. Debemos instruir al LLM para que no invente. Esto se consigue mediante un System Prompt riguroso.

Ejemplo de Prompt Engineering Avanzado

Utilizamos una plantilla que fuerza al modelo a citar las fuentes o a admitir su ignorancia.

SYSTEM_PROMPT = """

Eres un Asistente Financiero Senior integrado en el CRM BOMA.

Tu tarea es responder a las preguntas basándote EXCLUSIVAMENTE en el contexto proporcionado a continuación.

REGLAS OPERATIVAS:

1. Si la respuesta no está presente en el contexto, debes responder: "Lo siento, las políticas actuales no cubren este caso específico."

2. No inventes tipos de interés o reglas no escritas.

3. Cita siempre el documento de referencia (ej. [Política Hipotecas v2.4]).

4. Mantén un tono profesional y formal.

CONTEXTO:

{context}

PREGUNTA USUARIO:

{question}

"""Paso 4: Seguridad, PII y Cumplimiento RGPD

Integrar RAG en el CRM financiero conlleva riesgos enormes relacionados con la privacidad. No podemos enviar datos sensibles (PII – Personally Identifiable Information) como NIF, nombres completos o saldos bancarios directamente a las API de OpenAI o Anthropic sin precauciones, especialmente bajo el RGPD.

Estrategias de Protección (Guardrails)

- PII Redaction (Anonimización): Antes de enviar el prompt al LLM, utilizar librerías como Microsoft Presidio para identificar y enmascarar los datos sensibles. “Mario Rossi” se convierte en “<PERSON>”.

- Self-Hosted LLM: Para la máxima seguridad, evaluar el uso de modelos open-source como Llama 3 o Mistral, alojados en servidores propietarios (on-premise o VPC privada). Esto garantiza que ningún dato salga nunca de la infraestructura empresarial.

- Role-Based Access Control (RBAC): El sistema RAG debe respetar los permisos del CRM. Un agente junior no debe poder consultar vectores relativos a documentos reservados de la dirección. Este filtro se aplica a nivel de consulta en la base de datos vectorial (Metadata Filtering).

Paso 5: Orquestación e Integración en el CRM

La última pieza es la integración en el frontend del CRM. El asistente no debe ser solo un chat, sino un agente proactivo. Aquí un ejemplo lógico de cómo estructurar la llamada:

def get_crm_answer(user_query, user_id):

# 1. Verificación permisos usuario

user_permissions = db.get_permissions(user_id)

# 2. Recuperación documentos pertinentes (Retrieval) con filtros de seguridad

docs = vector_store.similarity_search(

user_query,

k=3,

filter={"access_level": {"$in": user_permissions}}

)

# 3. Construcción del contexto

context_text = "nn".join([d.page_content for d in docs])

# 4. Generación Respuesta (Generation)

response = llm_chain.invoke({"context": context_text, "question": user_query})

return responseConclusiones: El Futuro del CRM Financiero

Implementar RAG en el CRM transforma una base de datos estática en un consultor dinámico. Para las instituciones financieras, esto significa reducir los tiempos de onboarding de los nuevos empleados (que tienen acceso instantáneo a toda la base de conocimiento corporativa) y garantizar que cada respuesta dada al cliente cumpla con las últimas normativas vigentes.

La clave del éxito no reside en el modelo más potente, sino en la calidad de la pipeline de datos y en la rigidez de los protocolos de seguridad. En 2026, la confianza es el activo más valioso, y una arquitectura RAG bien diseñada es la mejor herramienta para preservarla.

Preguntas frecuentes

Mientras que un LLM genérico se basa en datos de entrenamiento estáticos y a menudo desactualizados, una arquitectura RAG (Retrieval-Augmented Generation) integrada en el CRM permite consultar en tiempo real documentos corporativos, tipos de interés actuales e historial de clientes. Este enfoque garantiza respuestas basadas en datos propietarios actualizados, reduciendo el riesgo de información obsoleta y mejorando el cumplimiento normativo en las consultas financieras.

La protección de los datos personales se realiza a través de diversas estrategias defensivas. Es esencial aplicar técnicas de PII Redaction para anonimizar nombres y códigos fiscales antes de que lleguen al modelo de IA. Además, el uso de modelos open-source alojados en servidores propietarios y la implementación de controles de acceso basados en roles (RBAC) aseguran que la información sensible nunca salga de la infraestructura empresarial y sea accesible solo al personal autorizado.

Para documentos legales y financieros, la división del texto basada puramente en caracteres está desaconsejada, ya que corre el riesgo de romper cláusulas importantes. La estrategia óptima prevé un chunking semántico o recursivo, que mantiene unidos los párrafos lógicos y utiliza un sistema de solapamiento (overlap) entre los fragmentos. Este método preserva el contexto necesario para que la inteligencia artificial pueda interpretar correctamente las normativas durante la fase de recuperación.

El uso de pgvector sobre PostgreSQL es a menudo preferible para los CRM propietarios porque permite mantener los datos vectoriales (embeddings) dentro del mismo perímetro de seguridad que los datos estructurados de los clientes. A diferencia de las soluciones SaaS externas, esta configuración facilita la ejecución de consultas híbridas que combinan la búsqueda semántica con filtros SQL tradicionales, ofreciendo un mayor control sobre la privacidad y reduciendo la latencia de red.

El Prompt Engineering avanzado actúa como un filtro de seguridad instruyendo al modelo para basarse exclusivamente en el contexto proporcionado. A través de un System Prompt riguroso, se impone al asistente citar las fuentes documentales específicas para cada afirmación y admitir explícitamente la ignorancia si la respuesta no está presente en las políticas de la empresa, impidiendo así la generación de tipos o reglas financieras inexistentes.

¿Te ha resultado útil este artículo? ¿Hay otro tema que te gustaría que tratara?

¡Escríbelo en los comentarios aquí abajo! Me inspiro directamente en vuestras sugerencias.