In Breve (TL;DR)

Per garantire un’intelligenza artificiale generativa sicura e responsabile, Google integra nei suoi modelli di punta come Gemini, Imagen e Veo rigorose misure di sicurezza, che includono filtri avanzati e il watermarking digitale SynthID.

Un’analisi delle strategie di sicurezza, dei filtri e dell’innovativo sistema di watermarking SynthID, volti a garantire un uso etico e sicuro dei nuovi modelli generativi.

L’approfondimento analizza le misure di sicurezza implementate, dai filtri per i contenuti ai watermark invisibili di SynthID, per garantire un uso etico e trasparente di questi potenti strumenti.

Il diavolo è nei dettagli. 👇 Continua a leggere per scoprire i passaggi critici e i consigli pratici per non sbagliare.

L’intelligenza artificiale generativa (GenAI) sta trasformando il nostro modo di creare, lavorare e interagire. Dalla scrittura di testi complessi alla generazione di immagini fotorealistiche e video, le possibilità sembrano infinite. Tuttavia, con grande potere derivano grandi responsabilità. Google, con il lancio dei suoi modelli più avanzati come Gemini 2.5, Imagen 4 e Veo 2, pone l’accento su un aspetto fondamentale: l’etica e la sicurezza. Questo approccio è cruciale, specialmente in un contesto come quello italiano ed europeo, dove la tutela dei dati, il rispetto della cultura e l’equilibrio tra innovazione e tradizione sono valori profondamente radicati.

In un mondo digitale in rapida evoluzione, la fiducia è la valuta più preziosa. Per questo, l’impegno di Google non si limita a creare strumenti potenti, ma si estende a garantirne un uso responsabile. Attraverso filtri di sicurezza avanzati, principi etici rigorosi e tecnologie innovative come il watermarking digitale, l’azienda cerca di costruire un ecosistema di IA affidabile. Questo è particolarmente rilevante per il mercato europeo, che con normative come il GDPR e l’AI Act, guida la conversazione globale su come l’innovazione tecnologica debba sempre procedere di pari passo con la protezione dei diritti dei cittadini.

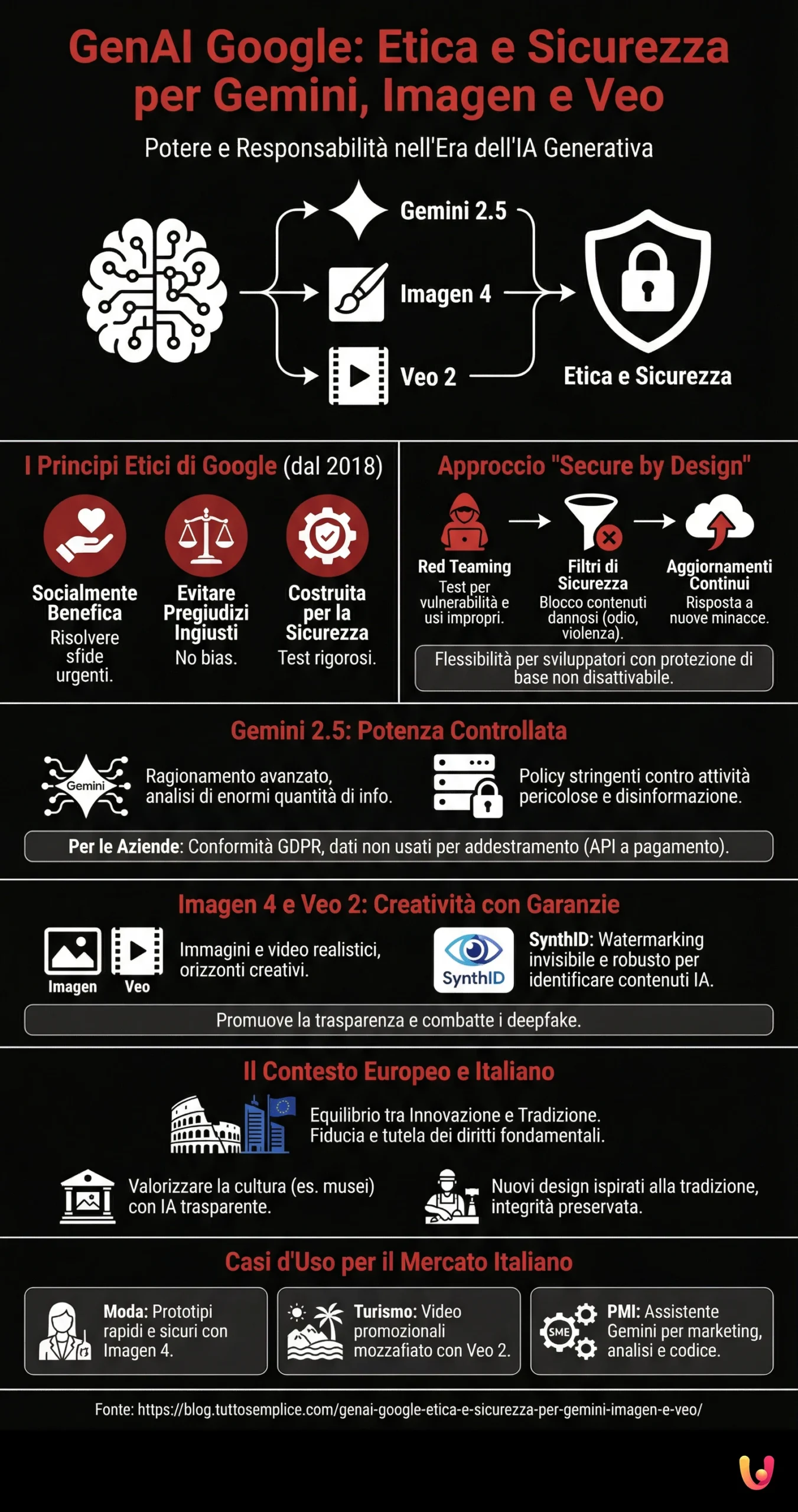

I Principi Etici di Google per l’IA

Alla base dell’approccio di Google c’è una solida struttura di principi etici, stabiliti fin dal 2018. Questi principi non sono semplici dichiarazioni di intenti, ma linee guida operative che indirizzano lo sviluppo di ogni tecnologia. L’obiettivo primario è che l’IA sia socialmente benefica, contribuendo a risolvere le sfide più urgenti dell’umanità. Altri pilastri includono l’impegno a non creare o rafforzare pregiudizi ingiusti (bias), a costruire e testare sistemi per la sicurezza, e a essere responsabili verso le persone. Questo significa progettare IA che siano trasparenti e forniscano opportunità di controllo agli utenti, un aspetto fondamentale per guadagnare la fiducia del pubblico.

Questi principi si traducono in azioni concrete. Ad esempio, Google evita di perseguire applicazioni dell’IA in settori come le armi o le tecnologie che violano le norme internazionali sui diritti umani. L’azienda si impegna attivamente in un processo di revisione etica per ogni nuovo progetto, valutandone rischi e opportunità. Questo approccio proattivo è essenziale per navigare la complessità dell’impatto sociale dell’IA e per assicurare che l’impatto dell’IA generativa in Italia e nel mondo sia positivo e costruttivo.

Sicurezza Integrata: L’Approccio “Secure by Design”

La sicurezza nell’IA di Google non è un’aggiunta finale, ma una componente integrata fin dalla fase di progettazione. Questo approccio, noto come “Secure by Design”, prevede più livelli di protezione per mitigare i rischi. Uno degli elementi chiave è il “red teaming”, un processo in cui team interni ed esterni mettono alla prova i modelli per scoprire potenziali vulnerabilità, usi impropri o capacità di generare contenuti dannosi. Questi test rigorosi aiutano a perfezionare i filtri di sicurezza prima che una tecnologia raggiunga il pubblico.

Oltre al red teaming, i modelli sono dotati di filtri di sicurezza specifici che bloccano la generazione di contenuti pericolosi, come quelli che incitano all’odio, alla violenza o che riguardano la sicurezza dei minori. Questi filtri sono costantemente aggiornati per rispondere a nuove minacce. Per gli sviluppatori che utilizzano le API di Gemini, Google offre la possibilità di regolare questi filtri, consentendo una personalizzazione basata sul contesto dell’applicazione, pur mantenendo un livello di protezione di base non disattivabile. Questo garantisce un equilibrio tra flessibilità e sicurezza.

Gemini 2.5: Potenza Controllata e Responsabile

Gemini 2.5 rappresenta un salto qualitativo nelle capacità di ragionamento e comprensione del contesto dell’IA. Può analizzare enormi quantità di informazioni, dal codice ai documenti, e fornire risposte complesse e articolate. Proprio per questa sua potenza, le misure di sicurezza sono ancora più stringenti. Google ha implementato policy specifiche per evitare che Gemini venga utilizzato per attività pericolose o per generare disinformazione dannosa. Le linee guida vietano esplicitamente la creazione di contenuti che possano causare danni reali alla salute, alla sicurezza o alle finanze delle persone.

Nel contesto aziendale, la sicurezza di Gemini assume un’importanza ancora maggiore. Per le imprese europee, Google garantisce che l’uso delle API a pagamento di Gemini sia conforme al GDPR. I dati forniti dalle aziende non vengono utilizzati per addestrare i modelli generali, assicurando così la massima riservatezza delle informazioni sensibili. Questa netta separazione tra versioni gratuite e a pagamento è una garanzia fondamentale per le aziende che desiderano sfruttare la potenza dell’IA senza compromettere la privacy. Affrontare le sfide per un’IA davvero affidabile è una priorità per la sua adozione su larga scala.

Imagen 4 e Veo 2: Creatività con Garanzie

La capacità di generare immagini e video realistici con Imagen 4 e Veo 2 apre orizzonti creativi straordinari, ma solleva anche interrogativi sulla possibile creazione di “deepfake” e disinformazione visiva. Per affrontare questa sfida, Google ha sviluppato e integrato SynthID, una tecnologia all’avanguardia per il watermarking (o filigrana digitale). SynthID incorpora un marcatore invisibile direttamente nei pixel di un’immagine o nei fotogrammi di un video. Questo watermark è progettato per essere robusto e resistere a modifiche come compressione, filtri o ritagli, permettendo di identificare un contenuto come generato dall’IA.

L’implementazione di SynthID è un passo cruciale verso la trasparenza. Permette a utenti, creatori e piattaforme di distinguere i contenuti sintetici da quelli reali, promuovendo un ecosistema informativo più sano. Ogni immagine prodotta da Imagen 4 e ogni video da Veo 2 include questa filigrana. Questo strumento non è solo una misura tecnica, ma un segnale dell’impegno di Google a fornire strumenti creativi potenti e, allo stesso tempo, a promuovere un loro uso etico e responsabile, una vera rivoluzione AI per il marketing e la creatività.

L’Equilibrio tra Innovazione e Tradizione nel Contesto Europeo

Il mercato europeo, e in particolare la cultura mediterranea e italiana, pone un’enfasi unica sulla protezione del patrimonio culturale e sull’autenticità. L’introduzione di strumenti come Imagen e Veo potrebbe essere vista con scetticismo se percepita come una minaccia alla tradizione. Tuttavia, l’approccio responsabile di Google, basato su sicurezza e trasparenza, offre una prospettiva diversa: l’IA come strumento per valorizzare e reinterpretare la tradizione, non per sostituirla. La cautela europea, talvolta vista come un freno, può diventare un vantaggio se spinge verso un’innovazione più etica e sostenibile.

Pensiamo a un museo italiano che utilizza Imagen 4 per creare visualizzazioni interattive di opere d’arte, o a un artigiano che sperimenta nuovi design ispirati alla tradizione ma generati con l’aiuto dell’IA. La presenza di SynthID garantisce che queste creazioni siano sempre riconoscibili come tali, preservando l’integrità delle opere originali. L’approccio europeo, incentrato sulla fiducia e sul rispetto dei diritti fondamentali, spinge le aziende tecnologiche come Google a sviluppare soluzioni che non siano solo innovative, ma anche culturalmente consapevoli e rispettose.

Casi d’Uso: L’IA Generativa al Servizio del Mercato Italiano

L’adozione sicura della GenAI può portare vantaggi concreti alle imprese italiane. Una casa di moda, ad esempio, può utilizzare Imagen 4 per generare rapidamente prototipi di design, esplorando nuove tendenze in modo efficiente e a basso costo, sapendo che le immagini prodotte sono protette da watermark. Allo stesso modo, un’azienda del settore turistico può sfruttare Veo 2 per creare video promozionali mozzafiato di paesaggi italiani, personalizzandoli per diversi mercati internazionali. La capacità di generare contenuti multimodali in modo sicuro apre infinite possibilità.

Per le piccole e medie imprese, che costituiscono la spina dorsale dell’economia italiana, Gemini può agire come un potente assistente. Può aiutare a redigere comunicazioni di marketing, analizzare i feedback dei clienti o persino a generare bozze di codice per migliorare il proprio sito e-commerce. L’integrazione di questi strumenti nei processi aziendali, supportata da garanzie di privacy e sicurezza, permette anche alle realtà più piccole di competere in un mercato globale. In questo modo, l’IA che vede, parla e crea diventa un motore di crescita e innovazione accessibile a tutti.

Conclusioni

L’avvento di modelli di intelligenza artificiale generativa come Gemini 2.5, Imagen 4 e Veo 2 segna un punto di svolta tecnologico. Tuttavia, la loro adozione di successo non dipenderà solo dalla loro potenza, ma dalla capacità di guadagnare la fiducia degli utenti. L’approccio di Google, fondato su principi etici, sicurezza integrata e strumenti di trasparenza come SynthID, rappresenta un modello di riferimento per un’innovazione responsabile. Questo impegno è particolarmente significativo nel contesto europeo e italiano, dove la richiesta di un equilibrio tra progresso tecnologico, privacy e rispetto della cultura è forte.

Affrontare le sfide etiche della GenAI è un percorso continuo, non una destinazione finale. Richiede un dialogo costante tra aziende tecnologiche, legislatori, esperti e la società civile. Le misure adottate da Google dimostrano una chiara volontà di guidare questo percorso in modo proattivo, costruendo un futuro in cui l’intelligenza artificiale possa essere uno strumento potente, creativo e sicuro per tutti. La vera innovazione, dopotutto, non risiede solo nel creare nuove tecnologie, ma nel garantire che esse contribuiscano a un mondo migliore e più giusto.

Domande frequenti

SynthID è una tecnologia sviluppata da Google DeepMind che inserisce un watermark (una filigrana digitale) impercettibile all’interno di contenuti generati dall’intelligenza artificiale, come testi, immagini e video. Questo strumento non altera la qualità del contenuto, ma permette di identificarne l’origine artificiale. L’obiettivo è aumentare la trasparenza e combattere la disinformazione, aiutando gli utenti a distinguere i contenuti originali da quelli creati da un’IA.

Google progetta i suoi modelli di IA, inclusi Gemini e Veo, con la sicurezza come priorità. Questo approccio include test approfonditi per prevenire la generazione di contenuti dannosi o distorti e l’integrazione di filtri di sicurezza. Inoltre, tutti i video generati con Veo includono un watermark SynthID per garantirne la tracciabilità e l’identificazione come contenuti artificiali, promuovendo un uso responsabile della tecnologia.

Sì, l’approccio di Google si allinea ai principi della regolamentazione europea, come l’AI Act, che promuove un’IA affidabile, etica e antropocentrica. L’AI Act classifica i sistemi di IA in base al rischio, vietando quelli inaccettabili e imponendo requisiti stringenti per quelli ad alto rischio. Le misure di Google, come i test di sicurezza, i principi di equità e trasparenza, e l’uso di watermark come SynthID, rispondono alla necessità di responsabilità e sicurezza richiesta dalla normativa europea.

Google adotta diverse strategie per mitigare pregiudizi e contenuti falsi. Uno dei suoi principi fondamentali è “evitare di creare o rafforzare pregiudizi ingiusti”. Questo si traduce nel fare attenzione ai dati usati per addestrare i modelli, cercando di renderli il più possibile rappresentativi della diversità globale per evitare distorsioni culturali o di altro tipo. Inoltre, l’azienda implementa filtri di sicurezza e sistemi di classificazione per bloccare la generazione di contenuti inappropriati.

Google utilizza la tecnologia SynthID per marcare i contenuti generati dai suoi modelli più recenti, come Imagen e Veo. Questa filigrana digitale è invisibile all’occhio umano ma può essere rilevata da strumenti specifici. Sebbene non sia sempre possibile per un utente verificarlo manualmente, questa tecnologia permette a piattaforme e ricercatori di identificare l’origine artificiale di un contenuto, contribuendo a un ecosistema digitale più trasparente.

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.