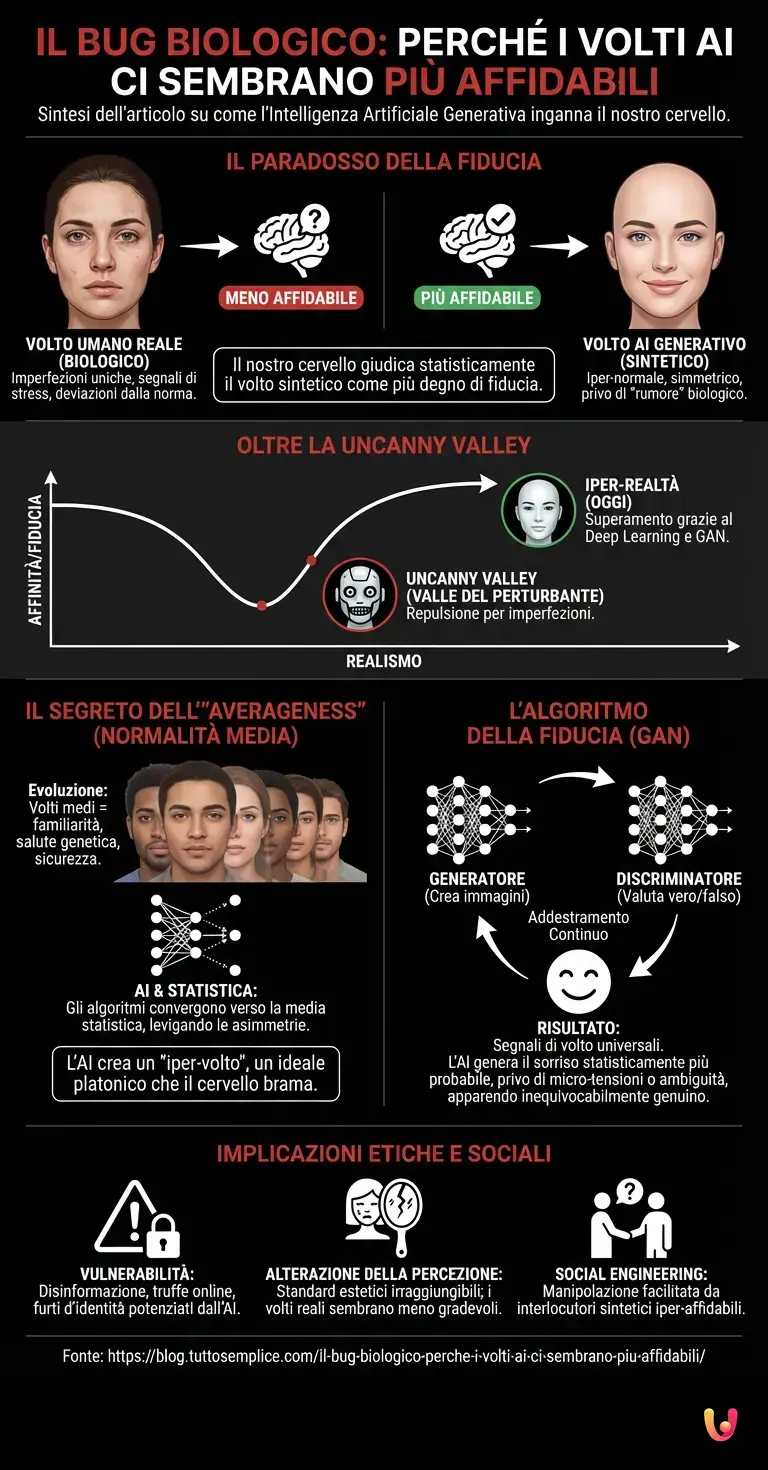

Siamo nel 2026 e la distinzione tra ciò che è biologico e ciò che è sintetico è diventata, agli occhi dell’osservatore comune, quasi impercettibile. Immaginate di scorrere i profili su un social network o di guardare le foto dei dipendenti sul sito di una nuova startup. Vedete un volto sorridente, dagli occhi gentili e dai lineamenti rassicuranti. Il vostro istinto vi dice immediatamente: "Di questa persona mi posso fidare". Eppure, quella persona non è mai nata, non ha mai respirato e non esiste in nessun luogo fisico. È il prodotto dell’Intelligenza Artificiale Generativa. La cosa più inquietante, tuttavia, non è la capacità tecnica della macchina di replicare un volto, ma la reazione del vostro cervello: statisticamente, è molto probabile che voi abbiate giudicato quel volto sintetico più affidabile di quello di un essere umano reale. Questo fenomeno, che stiamo osservando con crescente frequenza grazie al progresso tecnologico, nasconde un meccanismo psicologico e neurologico affascinante che gli algoritmi hanno involontariamente "hackerato".

Il superamento della Uncanny Valley

Per anni, gli esperti di robotica e computer grafica hanno temuto la cosiddetta "Uncanny Valley" (la valle del perturbante). Questa teoria suggeriva che, man mano che una replica artificiale si avvicinava al realismo umano, avrebbe suscitato un senso di repulsione e inquietudine nell’osservatore a causa delle piccole imperfezioni che il cervello percepiva come "sbagliate" o "cadaveriche". Oggi, grazie all’evoluzione del deep learning e delle architetture come le GAN (Generative Adversarial Networks), abbiamo saltato a piè pari quella valle. Siamo approdati sulla riva opposta: l’iper-realtà.

I moderni sistemi di machine learning non si limitano più a copiare; essi sintetizzano. Ma perché il risultato di questa sintesi ci appare più degno di fiducia rispetto alla realtà stessa? La risposta risiede in un cortocircuito tra l’evoluzione biologica millenaria e la matematica statistica degli algoritmi.

Il segreto dell’iper-normalità: perché il cervello viene ingannato

Il cuore del paradosso risiede nel concetto di "averageness" (l’essere nella media). Studi psicologici condotti ben prima dell’avvento dell’AI avanzata hanno dimostrato che gli esseri umani tendono a trovare i volti che rappresentano una media matematica delle caratteristiche della popolazione più attraenti e, soprattutto, più affidabili. Da un punto di vista evolutivo, un volto "medio" suggerisce familiarità, salute genetica e assenza di mutazioni o malattie rare. Il nostro cervello è cablato per cercare la normalità come segnale di sicurezza.

Qui entra in gioco l’architettura neurale delle intelligenze artificiali. Quando un algoritmo viene addestrato su milioni di volti umani per imparare a generarne di nuovi, esso tende intrinsecamente a convergere verso la media statistica. Anche quando l’AI crea un volto con caratteristiche specifiche, tende a levigare le asimmetrie, a bilanciare le proporzioni e a eliminare quel "rumore" biologico che caratterizza i volti veri.

Un volto umano reale è pieno di imperfezioni uniche: una leggera asimmetria nella mascella, una palpebra un po’ più calata dell’altra, una texture della pelle irregolare dovuta alla stanchezza o all’età. Questi dettagli, sebbene ci rendano unici, vengono elaborati dal nostro cervello inconscio come deviazioni dalla norma. L’intelligenza artificiale, invece, produce quello che potremmo definire un "iper-volto": un volto che è matematicamente più umano dell’umano stesso, perché incarna l’ideale platonico della media statistica che il nostro cervello brama.

Come funziona l’algoritmo della fiducia

Per comprendere appieno questo meccanismo, dobbiamo guardare sotto il cofano del deep learning. Le reti generative avversarie (GAN) funzionano mettendo due reti neurali l’una contro l’altra: un "generatore" che crea l’immagine e un "discriminatore" che cerca di capire se l’immagine è vera o falsa. In questo processo di addestramento continuo, il generatore impara a soddisfare i criteri del discriminatore alla perfezione.

Il risultato è che l’AI impara a produrre tratti che sono universalmente riconosciuti come "segnali di volto". Mentre un fotografo cattura la realtà così com’è, con tutte le sue stranezze, l’algoritmo costruisce l’immagine basandosi sulla probabilità. Se l’algoritmo deve generare un sorriso, genererà il sorriso statisticamente più probabile, quello che appare nella maggior parte dei dataset di persone felici. Questo sorriso "medio" è privo delle micro-tensioni muscolari che potrebbero tradire ambiguità in una persona reale. Di conseguenza, il volto generato appare inequivocabilmente genuino al nostro sistema limbico, privo di quelle sottili minacce o incertezze che talvolta percepiamo negli altri esseri umani.

Il ruolo dei Benchmark e l’evoluzione dei modelli

Nel 2026, i benchmark per valutare la qualità delle immagini generate non si basano più solo sulla risoluzione o sulla coerenza della luce, ma sulla "percepibilità umana". I modelli attuali, successori spirituali di sistemi come StyleGAN o dei generatori integrati nei moderni LLM multimodali (simili alle versioni avanzate di ChatGPT con capacità visive), hanno raggiunto un livello di dettaglio tale da ingannare anche gli esperti.

C’è un altro aspetto tecnico fondamentale: l’espressione emotiva. Le AI sono diventate maestre nel replicare le micro-espressioni associate alla gentilezza e all’apertura. Poiché i dataset di addestramento sono spesso curati per escludere immagini troppo aberranti o negative, l’AI ha un "bias di positività" nella generazione dei volti neutri o sorridenti. Questo bias si traduce in volti che sembrano sempre disponibili, calmi e, appunto, affidabili. La realtà biologica, fatta di stress, stanchezza e preoccupazioni che si riflettono sul volto, viene filtrata via dall’automazione creativa.

Le implicazioni etiche e sociali

Questa fiducia mal riposta ha conseguenze profonde. Se il nostro cervello si fida più di un volto falso che di uno vero, siamo estremamente vulnerabili a campagne di disinformazione, truffe online e furti d’identità potenziati dall’AI. Il "social engineering" diventa un gioco da ragazzi quando l’interlocutore ha l’aspetto della persona più affidabile che abbiate mai visto.

Inoltre, questo fenomeno rischia di alterare la nostra percezione della bellezza e della normalità. Se siamo costantemente esposti a volti sintetici "perfetti" e iper-affidabili, i volti reali, con le loro asimmetrie e difetti, potrebbero iniziare a sembrarci meno gradevoli o addirittura sospetti. È un paradosso crudele: la tecnologia creata a nostra immagine e somiglianza sta alzando uno standard estetico ed emotivo che la biologia non può raggiungere.

In Breve (TL;DR)

L’intelligenza artificiale genera volti sintetici che il nostro istinto giudica paradossalmente più degni di fiducia delle persone reali.

Questo inganno percettivo nasce dalla nostra evoluzione, che premia la media statistica perfettamente replicata dai moderni algoritmi generativi.

Eliminando il rumore biologico e le asimmetrie, la tecnologia produce un ideale di volto umano che supera la realtà stessa.

Conclusioni

Il paradosso dell’iper-realtà ci insegna che la nostra percezione non è uno strumento infallibile, ma un sistema calibrato su milioni di anni di evoluzione che non aveva previsto l’avvento dell’intelligenza artificiale. Ci fidiamo dei volti falsi non perché l’AI sia diventata senziente o manipolatrice nel senso umano del termine, ma perché ha imparato la matematica della nostra biologia meglio di quanto noi stessi la conosciamo. L’algoritmo ci restituisce una versione purificata, mediata e idealizzata dell’umanità, priva del caos e dell’imprevedibilità che rendono una persona reale. In questo 14 febbraio 2026, mentre osserviamo il progresso tecnologico accelerare, la lezione più importante è forse quella di reimparare a fidarci dell’imperfezione, perché è lì che risiede l’unica vera garanzia di umanità.

Domande frequenti

Il motivo principale risiede nel fenomeno psicologico della averageness. Il cervello umano è evolutivamente programmato per considerare i volti con caratteristiche medie come più sani e familiari. Le intelligenze artificiali, addestrate su vasti dataset, generano volti che convergono matematicamente verso questa media statistica, eliminando le asimmetrie e le imperfezioni biologiche. Questo processo crea un volto ideale che soddisfa i nostri bias inconsci di sicurezza meglio di quanto faccia un volto reale.

Questa tecnologia si basa sulle reti generative avversarie, o GAN, in cui due reti neurali competono per produrre immagini realistiche. A differenza di una fotografia che cattura le imperfezioni, la AI costruisce il volto basandosi sulla probabilità statistica. Il risultato è una espressione priva di tensioni muscolari ambigue e difetti cutanei, generando segnali di gentilezza e apertura che il nostro sistema limbico interpreta erroneamente come garanzia di genuinità assoluta.

La fiducia innata verso questi volti sintetici espone gli utenti a rischi elevati di disinformazione e truffe, dato che i criminali possono usare avatar rassicuranti per manipolare le vittime. Inoltre, esiste un pericolo sociale e culturale: la esposizione continua alla perfezione artificiale potrebbe alterare i nostri standard estetici. I volti umani reali, con i loro difetti naturali, potrebbero iniziare a sembrarci meno gradevoli o persino sospetti rispetto alla controparte sintetica.

La teoria della Uncanny Valley prevedeva un senso di repulsione per le repliche quasi umane, ma il deep learning moderno ha saltato questo ostacolo approdando alla iper realtà. I sistemi attuali non copiano semplicemente ma sintetizzano nuovi tratti levigando ogni irregolarità che il cervello percepirebbe come errore. In questo modo, la tecnologia offre una versione idealizzata e purificata della umanità che risulta più attraente della realtà biologica stessa.

Fonti e Approfondimenti

- NIH (National Institutes of Health): Studio sulla percezione di maggiore affidabilità nei volti sintetici

- Wikipedia: Approfondimento sulla teoria della Uncanny Valley (Valle del perturbante)

- NIST (Governo USA): Valutazione delle tecnologie di riconoscimento facciale (FRTE) e standard biometrici

- Wikipedia: Generative adversarial network (GAN)

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.