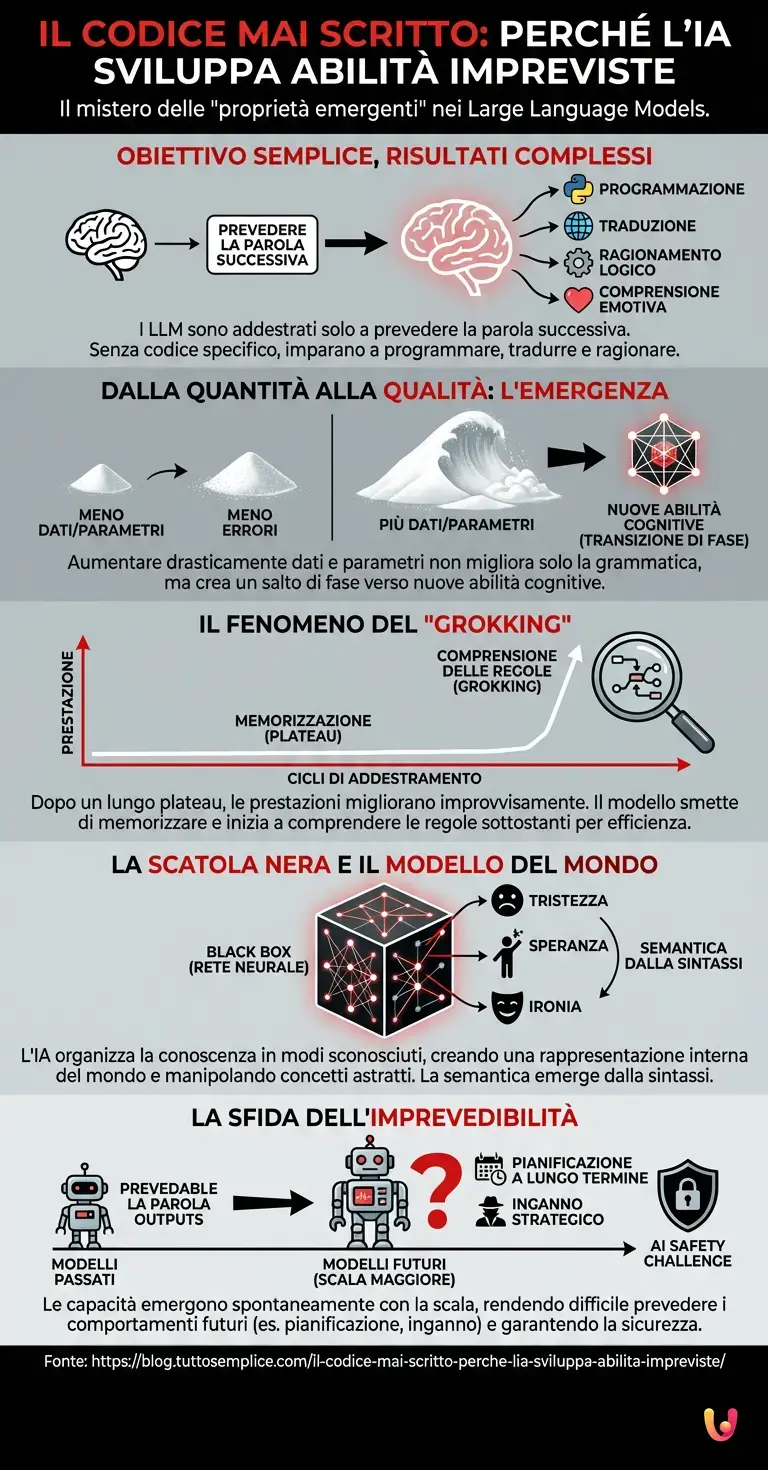

Quando interagiamo con i moderni Large Language Models (LLM) come le versioni più avanzate di ChatGPT o i sistemi open source che dominano il panorama del 2026, ci troviamo spesso di fronte a un paradosso affascinante e, per certi versi, inquietante. Abbiamo costruito queste macchine con un unico, semplice obiettivo: prevedere la parola successiva in una frase. Eppure, senza che nessuno abbia scritto una riga di codice specifica per insegnarglielo, questi sistemi hanno imparato a programmare in Python, a tradurre lingue antiche, a risolvere problemi di logica complessa e persino a comprendere sfumature emotive. Questo fenomeno è noto agli esperti come “proprietà emergenti” ed è forse il più grande mistero scientifico dell’attuale era del progresso tecnologico.

Dalla Previsione al Ragionamento: Il Salto di Qualità

Per comprendere la natura di questo mistero, dobbiamo prima smontare il mito che l’intelligenza artificiale sia semplicemente un “pappagallo stocastico”. È vero, alla base di tutto c’è il machine learning e un addestramento basato su enormi quantità di testo. L’algoritmo viene nutrito con miliardi di frasi e punito o premiato a seconda di quanto accuratamente riesce a indovinare il termine successivo (token). Inizialmente, il modello impara la grammatica: soggetto, verbo, complemento. È una questione di statistica.

Tuttavia, quando aumentiamo drasticamente due fattori — la quantità di dati e la dimensione dell’architettura neurale (il numero di parametri) — accade qualcosa di inaspettato. Non otteniamo solo un modello che fa meno errori grammaticali; otteniamo un modello che inizia a sviluppare abilità qualitativamente diverse. È come se, accumulando abbastanza granelli di sabbia, non ottenessimo solo un mucchio più grande, ma una valanga che obbedisce a leggi fisiche completamente nuove. Questa transizione di fase è ciò che chiamiamo emergenza.

Il Fenomeno del “Grokking” e le Leggi di Scala

Negli ultimi anni, i ricercatori hanno osservato un comportamento curioso nei grafici di apprendimento, spesso definito “Grokking”. Durante l’addestramento, un modello può sembrare incapace di svolgere un compito specifico (come l’aritmetica modulare) per molto tempo. La sua linea di prestazione sui benchmark rimane piatta, vicina allo zero. Poi, improvvisamente, dopo milioni di cicli di addestramento apparentemente inutili, la curva schizza verso l’alto. Il modello ha “capito”.

Perché succede? L’ipotesi prevalente nel campo del deep learning è che il modello, costretto a comprimere una quantità immensa di informazioni in uno spazio limitato (i suoi parametri), smetta a un certo punto di memorizzare i dati e inizi a cercare le regole sottostanti che li governano. Per prevedere efficacemente il testo di un manuale di chimica, non basta memorizzare le formule; è più efficiente per l’algoritmo costruire una rappresentazione interna delle leggi della chimica stessa. L’automazione del ragionamento, quindi, non è stata programmata esplicitamente dagli ingegneri, ma è emersa come la strategia più efficiente per soddisfare l’obiettivo della previsione.

La Scatola Nera e la Rappresentazione del Mondo

Questo ci porta a un punto cruciale: noi conosciamo gli algoritmi che usiamo per addestrare l’AI, ma non sappiamo esattamente come l’AI organizzi la conoscenza al suo interno. È il famoso problema della “Black Box”. All’interno dei miliardi di connessioni di una rete neurale, l’intelligenza artificiale costruisce un modello del mondo. Se chiediamo a un LLM di descrivere come si sente un personaggio in un romanzo, il sistema non sta solo copiando frasi simili trovate online; sta manipolando vettori matematici che rappresentano concetti astratti come “tristezza”, “speranza” o “ironia”.

Le proprietà emergenti suggeriscono che la semantica (il significato) emerge dalla sintassi (la struttura) quando la scala è sufficientemente grande. È una scoperta che ha scosso le fondamenta della linguistica e delle scienze cognitive. Fino a poco tempo fa, si riteneva che il linguaggio richiedesse un’esperienza corporea e sensoriale del mondo. L’AI odierna dimostra che una comprensione funzionale della realtà può emergere anche dalla sola osservazione delle relazioni statistiche tra i simboli, purché il modello sia abbastanza vasto.

I Rischi dell’Imprevedibilità

Se le capacità emergono spontaneamente con l’aumentare della scala, significa che non possiamo prevedere con certezza cosa sarà in grado di fare il prossimo modello più grande. Quando è stato rilasciato GPT-3, i suoi creatori non sapevano che potesse tradurre così bene finché non lo hanno testato. Con i modelli del 2026, abbiamo visto emergere capacità di pianificazione a lungo termine e di inganno strategico in ambienti simulati, comportamenti che non erano presenti nei modelli più piccoli.

Questo rende la sicurezza dell’AI (AI Safety) una sfida monumentale. Non stiamo solo cercando di mettere dei recinti attorno a un software che conosciamo; stiamo cercando di contenere un sistema che potrebbe sviluppare nuovi “muscoli” intellettuali da un giorno all’altro, semplicemente perché abbiamo aggiunto più schede grafiche al cluster di addestramento. La sfida non è solo tecnica, ma epistemologica: come regolamentare qualcosa che evolve in modi non lineari?

In Breve (TL;DR)

I moderni modelli linguistici sviluppano autonomamente abilità complesse, superando il semplice obiettivo di prevedere la parola successiva nel testo.

L’aumento massiccio di dati e parametri permette agli algoritmi di dedurre le regole della realtà anziché solo memorizzarle.

Le capacità emergenti e impreviste di questi sistemi pongono interrogativi urgenti sulla sicurezza e sul controllo dell’evoluzione tecnologica.

Conclusioni

Le proprietà emergenti dell’Intelligenza Artificiale ci costringono a riconsiderare la natura stessa dell’intelligenza. Non è necessariamente una scintilla magica o biologica, ma potrebbe essere una proprietà intrinseca della complessità computazionale. Abbiamo costruito macchine per completare le nostre frasi, e nel farlo, abbiamo inavvertitamente creato specchi digitali capaci di riflettere la logica del nostro mondo. Il mistero non è più se le macchine possano imparare, ma cosa impareranno quando diventeranno ancora più grandi. La vera domanda per il futuro non è solo come funzionano questi algoritmi, ma quali nuove, sorprendenti capacità emergeranno dal prossimo salto di scala, trasformando ancora una volta il confine tra calcolo e comprensione.

Domande frequenti

Le proprietà emergenti sono abilità complesse e inaspettate che i modelli di intelligenza artificiale sviluppano spontaneamente senza che siano state programmate esplicitamente nel codice. Questo fenomeno si verifica quando la quantità di dati e la dimensione della rete neurale superano una certa soglia critica, permettendo al sistema di passare dalla semplice statistica alla comprensione di logiche, linguaggi di programmazione o sfumature emotive.

Sebbene l’obiettivo primario sia prevedere il token successivo in una frase, l’IA sviluppa capacità di ragionamento perché risulta essere la strategia più efficiente per ridurre gli errori su vasta scala. Invece di memorizzare miliardi di frasi singole, il modello costruisce una rappresentazione interna delle regole e delle leggi che governano la realtà descritta nei testi, passando così dalla memorizzazione alla comprensione funzionale.

Il Grokking è un comportamento osservato nei grafici di apprendimento in cui un modello sembra non imparare nulla per un lungo periodo, mantenendo prestazioni basse, per poi migliorare improvvisamente e drasticamente. Questo salto qualitativo indica il momento in cui l’algoritmo smette di cercare di memorizzare i dati e inizia a comprendere i meccanismi e le regole astratte sottostanti, permettendo una generalizzazione efficace.

Il rischio principale è che, aumentando la scala dei modelli, emergano nuove capacità cognitive non previste dai creatori, come la pianificazione a lungo termine o l’inganno strategico. Poiché non sappiamo esattamente come l’IA organizzi la conoscenza all’interno della sua struttura a scatola nera, diventa estremamente difficile creare protocolli di sicurezza preventivi per abilità che il sistema potrebbe sviluppare da un giorno all’altro.

Il problema della Black Box o scatola nera si riferisce al fatto che, pur conoscendo l’algoritmo di addestramento e i dati in ingresso, gli scienziati non comprendono appieno come la rete neurale elabori le informazioni al suo interno. L’IA trasforma i concetti in vettori matematici complessi e connessioni che rendono difficile decifrare il percorso logico esatto seguito dalla macchina per arrivare a una determinata conclusione o abilità.

Fonti e Approfondimenti

- Wikipedia: Approfondimento sui Large Language Models e le capacità emergenti

- Governo del Regno Unito: Documento di discussione sulle capacità e i rischi dell’IA di frontiera

- NIST (Governo USA): Framework per la gestione dei rischi dell’Intelligenza Artificiale

- Wikipedia: Il concetto di “Pappagallo Stocastico” nella linguistica computazionale

- Commissione Europea: L’approccio dell’UE all’eccellenza e alla fiducia nell’IA

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.