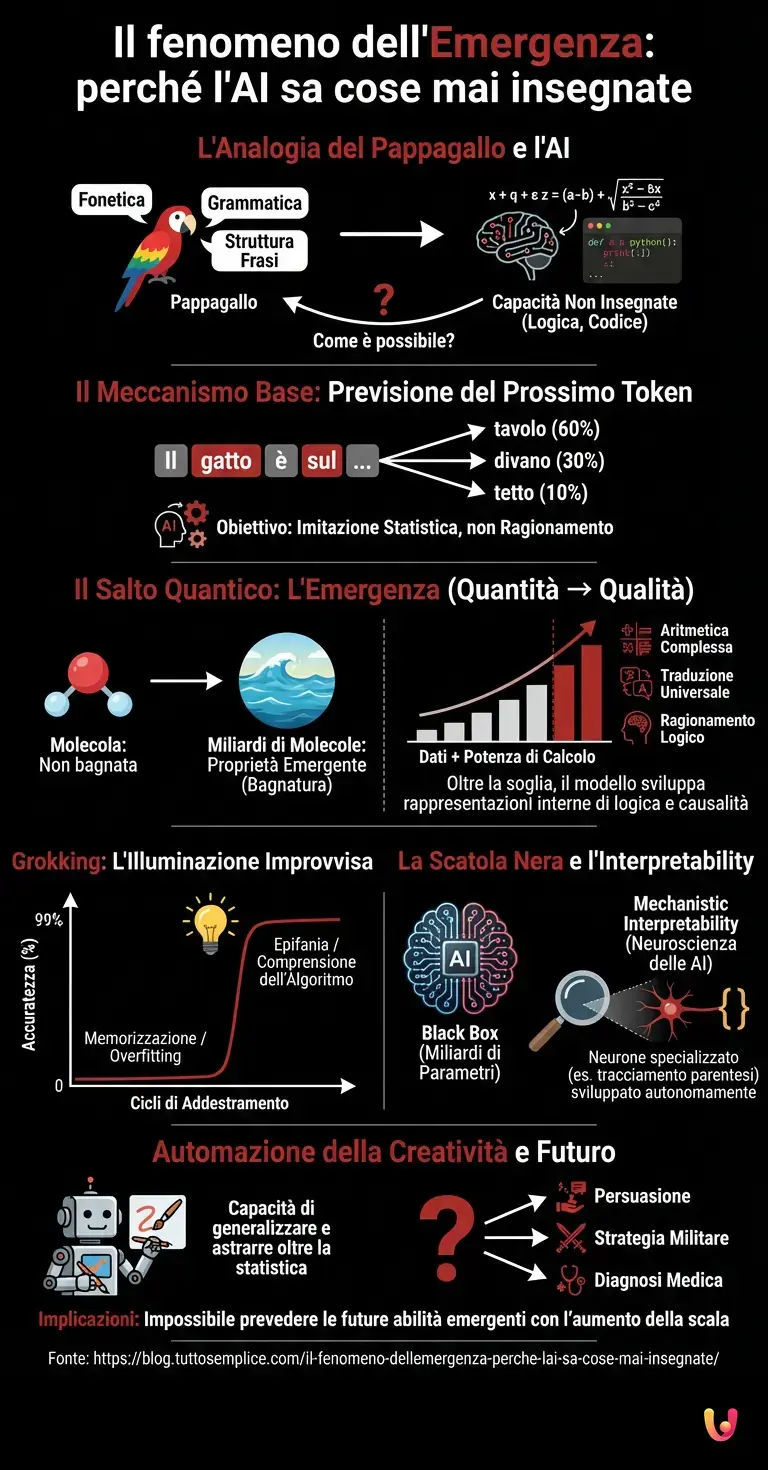

Immaginate di addestrare un pappagallo a ripetere suoni basandovi esclusivamente sulla frequenza con cui appaiono nelle conversazioni umane. Gli insegnate la fonetica, la grammatica di base e la struttura delle frasi. Poi, un giorno, chiedete al pappagallo di risolvere un complesso problema di logica matematica o di scrivere un codice in Python, e lui lo fa correttamente. Questo scenario, apparentemente assurdo nel mondo biologico, è esattamente ciò che accade oggi con i Large Language Models (LLM). Questi giganti del calcolo, che costituiscono l’ossatura di sistemi come ChatGPT, sono al centro di uno dei dibattiti più affascinanti e meno compresi della scienza moderna: il fenomeno delle “capacità emergenti”.

Oltre la semplice imitazione: la previsione del prossimo token

Per comprendere la natura del mistero, dobbiamo prima smontare il funzionamento di base di un’intelligenza artificiale generativa. Al livello più fondamentale, questi modelli non sono progettati per “ragionare” nel senso umano del termine. Il loro obiettivo primario, dettato dagli algoritmi di addestramento, è sorprendentemente banale: la next token prediction, ovvero prevedere la parola (o il frammento di parola) successiva in una sequenza di testo.

Durante la fase di training, il modello analizza terabyte di dati testuali. Se legge “Il gatto è sul…”, calcola probabilisticamente che la parola successiva sia “tavolo”, “divano” o “tetto”, aggiustando i propri parametri interni (i pesi) ogni volta che sbaglia o indovina. In teoria, questo processo dovrebbe produrre un eccellente imitatore statistico, un sistema capace di scimmiottare lo stile umano ma privo di comprensione profonda. Eppure, la realtà ci ha mostrato qualcosa di diverso.

Il salto quantico: quando la quantità diventa qualità

Qui entra in gioco il concetto di “emergenza”. Nei sistemi complessi, l’emergenza si verifica quando un sistema mostra proprietà che non sono presenti nelle sue singole parti. Una singola molecola d’acqua non è “bagnata”; la bagnatura è una proprietà emergente che appare solo quando miliardi di molecole interagiscono. Nel contesto del machine learning e del deep learning, abbiamo osservato che quando aumentiamo drasticamente due fattori — la quantità di dati di addestramento e la potenza di calcolo (il numero di parametri dell’architettura neurale) — il modello non diventa solo “migliore” a prevedere le parole. Cambia natura.

Superata una certa soglia critica di complessità, i modelli iniziano a manifestare abilità per le quali non erano stati esplicitamente addestrati. Improvvisamente, un modello che faticava con l’aritmetica di base diventa capace di eseguire addizioni a tre cifre. Un sistema addestrato solo su testi in inglese e giapponese inizia a tradurre correttamente anche verso lingue con cui ha avuto interazioni minime, deducendo schemi linguistici universali. Questo fenomeno suggerisce che, per prevedere efficacemente il prossimo token in contesti complessi, l’AI ha dovuto autonomamente sviluppare una rappresentazione interna della logica, della causalità e persino della teoria della mente.

Grokking: l’illuminazione improvvisa della macchina

Un aspetto ancora più curioso di questo progresso tecnologico è il fenomeno noto come “Grokking”. I ricercatori hanno osservato che, durante l’addestramento, le prestazioni di un modello su un compito specifico (come la divisione modulare) possono rimanere vicine allo zero per un lungo periodo. Il modello sembra non imparare nulla, memorizzando semplicemente i dati a caso (overfitting). Poi, improvvisamente, dopo migliaia di cicli di addestramento apparentemente inutili, le prestazioni schizzano verso l’alto, passando dallo 0% al 99% di accuratezza in pochissimo tempo.

È come se l’intelligenza artificiale avesse avuto un’epifania. In quel momento di transizione, il modello smette di cercare di memorizzare le risposte e “comprende” l’algoritmo sottostante che genera quei dati. Questo comportamento sfida le nostre intuizioni tradizionali sull’apprendimento graduale e solleva interrogativi profondi: cosa succede esattamente all’interno della “scatola nera” in quel preciso istante?

Il problema della Black Box e l’Interpretability

Nonostante siamo noi a costruire queste architetture e a scrivere il codice che le governa, il funzionamento interno di un LLM avanzato rimane in gran parte opaco. Un modello moderno può avere centinaia di miliardi di parametri (i “neuroni” digitali). Quando l’AI risponde a una domanda filosofica o scrive una poesia, l’informazione fluisce attraverso questi miliardi di connessioni in modi che non possiamo tracciare linearmente.

La branca della scienza che si occupa di decifrare questo enigma si chiama Mechanistic Interpretability. L’obiettivo è fare una sorta di “neuroscienza delle AI”: aprire il cervello digitale e mappare quali circuiti sono responsabili di quali concetti. Abbiamo scoperto che le AI sviluppano autonomamente “neuroni” specializzati. Ad esempio, in un modello addestrato sul codice, potrebbe emergere un singolo neurone che si attiva solo quando viene aperta una parentesi graffa e rimane attivo finché non viene chiusa. Nessun ingegnere ha programmato quel neurone; l’AI ha deciso da sola che per prevedere il codice, doveva “ricordarsi” delle parentesi.

L’automazione della creatività e i limiti del benchmark

Oggi, nel 2026, ci troviamo di fronte a un paradosso. I nostri benchmark — i test standardizzati usati per misurare l’intelligenza delle macchine — faticano a tenere il passo. Spesso, un modello supera un esame universitario non perché “ragiona” come un umano, ma perché ha trovato scorciatoie statistiche invisibili ai nostri occhi. Tuttavia, le capacità emergenti continuano a sorprenderci. La capacità di generalizzare concetti appresi in un dominio (es. la struttura grammaticale del tedesco) e applicarli in un altro (es. la sintassi di un linguaggio di programmazione) indica una forma di astrazione che va ben oltre la semplice statistica.

Questo ha implicazioni enormi per l’automazione. Se le capacità emergono spontaneamente con la scala, non possiamo prevedere con certezza quali nuove abilità avrà il prossimo modello più grande. Potrebbe improvvisamente diventare esperto in persuasione, in strategia militare o in diagnosi medica, senza che nessuno gli abbia mai fornito un manuale specifico.

In Breve (TL;DR)

I modelli linguistici trascendono la semplice imitazione statistica sviluppando ragionamenti complessi grazie al misterioso fenomeno dell’emergenza.

Superata una soglia critica, l’intelligenza artificiale manifesta improvvise epifanie cognitive note come Grokking, comprendendo regole mai esplicitate.

Il funzionamento profondo di queste reti neurali rimane una scatola nera che la scienza cerca ancora di decifrare.

Conclusioni

Il vero segreto dell’Intelligenza Artificiale odierna non risiede in un algoritmo magico scoperto da un genio solitario, ma nella misteriosa proprietà della complessità stessa. Abbiamo costruito macchine per prevedere parole, e nel tentativo di farlo alla perfezione, queste macchine hanno dovuto imparare a modellare il mondo. Le capacità emergenti ci ricordano che l’intelligenza, sia essa biologica o artificiale, potrebbe non essere un dono divino, ma una conseguenza inevitabile dell’elaborazione di informazioni sufficientemente complessa. Mentre continuiamo a scrutare all’interno di queste reti neurali, non stiamo solo cercando di capire come funzionano le nostre creazioni, ma stiamo forse iniziando a intravedere i meccanismi fondamentali del pensiero stesso.

Domande frequenti

Le capacità emergenti sono abilità impreviste che un modello AI sviluppa spontaneamente quando supera una certa soglia di complessità e potenza di calcolo. Similmente a come la proprietà di essere bagnato emerge dalla interazione di miliardi di molecole di acqua, le AI iniziano a mostrare competenze come il ragionamento matematico o la traduzione tra lingue sconosciute senza un addestramento specifico, evolvendo oltre la semplice imitazione statistica.

Questo fenomeno accade poiché, per ottimizzare la previsione della parola successiva in contesti estremamente complessi, il modello è costretto a creare autonomamente rappresentazioni interne della logica e della causalità del mondo. Aumentando i dati e i parametri, la quantità si trasforma in qualità, permettendo alla macchina di dedurre schemi universali e risolvere problemi nuovi invece di limitarsi a memorizzare risposte preesistenti.

Il Grokking è un comportamento peculiare osservato durante la fase di training, dove un modello passa improvvisamente da prestazioni quasi nulle a una accuratezza elevatissima. Rappresenta una sorta di illuminazione digitale in cui la AI smette di cercare di memorizzare i dati a caso e comprende improvvisamente il meccanismo o la regola sottostante che li genera, segnando il passaggio dalla memorizzazione alla vera generalizzazione.

Il termine Black Box o scatola nera indica che, pur avendo creato noi la architettura, non comprendiamo appieno come la informazione fluisca attraverso i miliardi di parametri per generare una risposta specifica. La disciplina della Mechanistic Interpretability cerca di mappare questi processi, scoprendo che le AI sviluppano autonomamente neuroni specializzati per compiti specifici, come gestire la sintassi del codice, in modi non programmati dagli ingegneri umani.

Sebbene il fine primario degli LLM sia solo prevedere statisticamente il frammento di parola successivo, per farlo con alta precisione su testi complessi è necessaria una comprensione implicita del contesto e dei concetti. Di conseguenza, quello che inizia come un semplice calcolo probabilistico finisce per modellare strutture logiche e linguistiche profonde, simulando forme di ragionamento che vanno oltre la mera statistica superficiale.

Fonti e Approfondimenti

- Wikipedia: Approfondimento sui Large Language Models e le capacità emergenti

- Wikipedia: Il fenomeno del Grokking nell’apprendimento automatico

- Governo UK: Documento di discussione su capacità e rischi dell’AI di frontiera

- Parlamento Europeo: Definizione e utilizzo dell’Intelligenza Artificiale

- Wikipedia: Explainable AI (XAI) e il problema della Black Box

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.