Siamo nel 2026 e l’Intelligenza Artificiale è ormai integrata in ogni aspetto della nostra vita digitale, eppure esiste un fenomeno che continua a lasciare perplessi persino i suoi creatori. Quando interagiamo con un Large Language Model (LLM), spesso diamo per scontato che le sue capacità siano state inserite manualmente da un programmatore, riga di codice dopo riga di codice. La realtà, tuttavia, è molto più affascinante e, per certi versi, inquietante: molte delle abilità più complesse di questi sistemi non sono state affatto “insegnate”. Sono emerse spontaneamente. Questo è il mistero delle proprietà emergenti, il segreto meglio custodito dietro l’apparente magia degli algoritmi moderni.

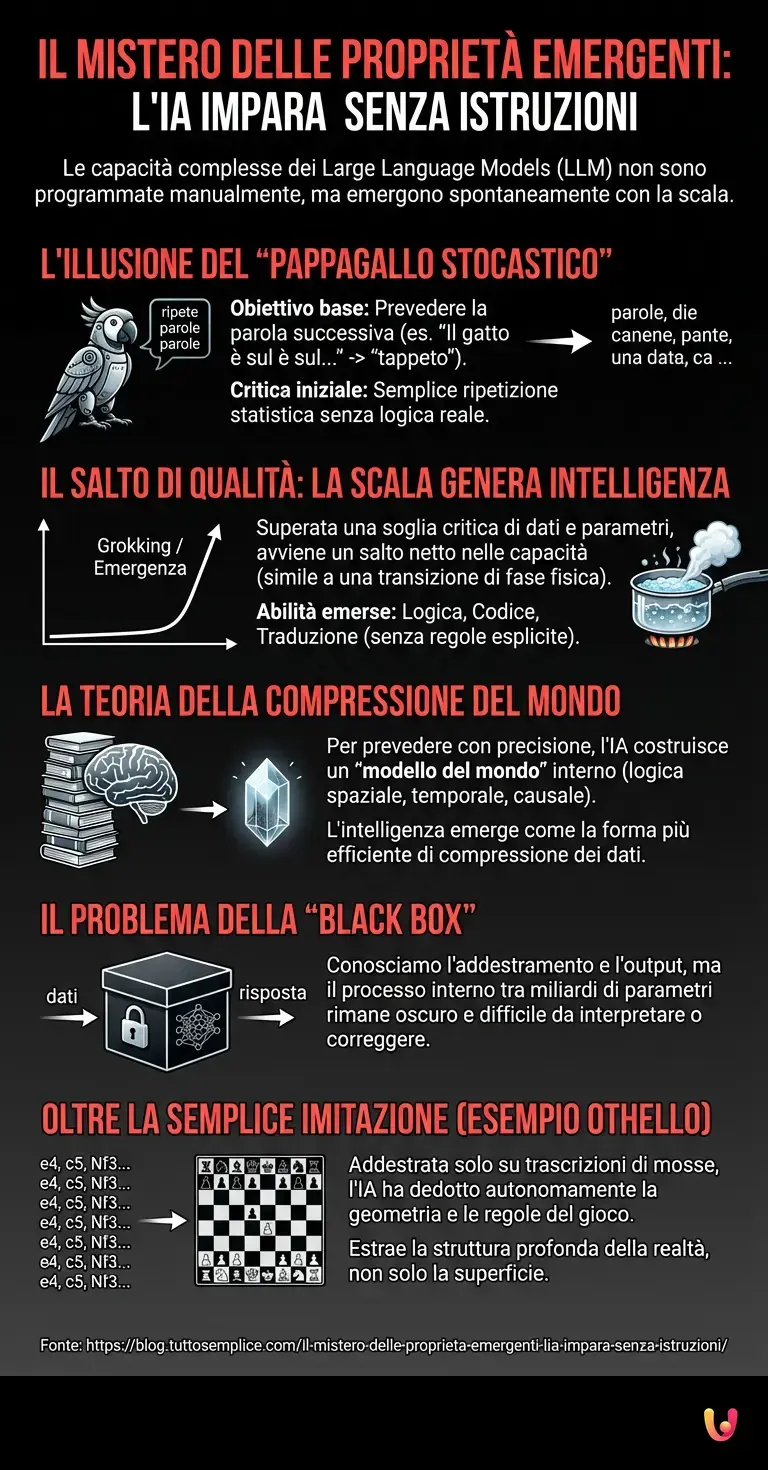

L’illusione del semplice “pappagallo stocastico”

Per comprendere la natura di questo mistero, dobbiamo fare un passo indietro e guardare cosa fa realmente un modello di machine learning alla base. Nella sua forma più pura, un LLM viene addestrato con un obiettivo incredibilmente banale: prevedere la parola successiva in una frase. Se gli forniamo l’input “Il gatto è sul…”, il modello calcola probabilisticamente che la parola “tappeto” o “divano” è molto più probabile di “asteroide”.

Per anni, i critici hanno definito questi sistemi come “pappagalli stocastici”: entità che si limitano a ripetere a pappagallo ciò che hanno visto nei dati di addestramento, mescolando le parole in modo statisticamente piacevole ma privo di logica reale. Tuttavia, con l’aumentare della potenza di calcolo e della dimensione dei dati, è successo qualcosa di inaspettato. Il “pappagallo” ha iniziato a risolvere problemi di logica, a scrivere codice informatico funzionante e a tradurre lingue con sfumature culturali, senza che nessuno avesse esplicitamente programmato le regole grammaticali o la sintassi di programmazione nel suo codice sorgente.

Il salto di qualità: la scala genera intelligenza?

Qui entra in gioco il concetto di progresso tecnologico legato alla “scala”. Immaginate di avere un modello con pochi parametri (i “neuroni” artificiali della rete). Se gli chiedete di sommare due numeri a tre cifre, fallirà miseramente. Aumentate leggermente la dimensione del modello: fallirà ancora. Continuate ad aumentare la complessità dell’architettura neurale e la quantità di dati, e improvvisamente, superata una certa soglia critica, il modello inizia a dare la risposta corretta quasi il 100% delle volte.

Non c’è stato un miglioramento graduale (dal 10% al 20% al 30% di precisione). C’è stato un salto netto, da zero a cento. Questo fenomeno è noto come grokking o emergenza. È simile a ciò che accade in fisica con le transizioni di fase: l’acqua si riscalda grado dopo grado rimanendo liquida, finché a 100°C non si trasforma improvvisamente in vapore. Nel deep learning, l’accumulo quantitativo di parametri porta a un salto qualitativo nelle capacità.

La teoria della compressione del mondo

Perché accade questo? Una delle teorie più accreditate tra i ricercatori di AI suggerisce che per prevedere con estrema precisione la parola successiva in un testo complesso, il modello sia costretto a costruire un “modello del mondo” interno.

Pensateci: per completare correttamente una frase in un romanzo giallo, l’IA non può limitarsi a guardare la statistica delle parole. Deve “capire” (in senso matematico) che se il maggiordomo era in cucina a pagina 10, non può essere l’assassino nel salotto a pagina 11. Per minimizzare l’errore di previsione, l’algoritmo è costretto a imparare la logica spaziale, temporale e causale. L’automazione del processo di apprendimento spinge il sistema a trovare scorciatoie cognitive che noi interpretiamo come ragionamento.

È come se chiedessimo a qualcuno di comprimere un’enorme enciclopedia in un file piccolissimo. Per riuscirci senza perdere informazioni vitali, quella persona deve per forza capire le leggi generali che governano i dati, non solo memorizzarli. L’intelligenza, in questo contesto, emerge come la forma più efficiente di compressione dei dati.

Il problema della “Black Box” e l’interpretabilità

Questo ci porta a un paradosso affascinante che permea l’attuale panorama tecnologico. Abbiamo costruito macchine capaci di superare i benchmark umani in esami di medicina o legge, ma non sappiamo esattamente come arrivino alla risposta. Sappiamo come addestrarle (l’algoritmo di ottimizzazione), conosciamo i dati di input e vediamo l’output, ma ciò che accade nel mezzo — nei miliardi di connessioni tra i neuroni artificiali — rimane in gran parte una “Black Box”, una scatola nera.

Quando ChatGPT o i suoi successori scrivono una poesia in rima, non stanno seguendo un modulo “Poesia” scritto da un ingegnere. Stanno navigando in uno spazio vettoriale multidimensionale dove il concetto di “rima”, “ritmo” e “significato” si sono allineati autonomamente durante l’addestramento. Questo rende il debugging estremamente difficile: non si può semplicemente aprire il cofano e “aggiustare” la comprensione dell’ironia, perché quella comprensione è spalmata su miliardi di parametri numerici.

Oltre la semplice imitazione

Un esempio classico che ha stupito i ricercatori riguardava l’apprendimento della sintassi del gioco Othello. Un modello addestrato solo sulle trascrizioni delle mosse (senza vedere la scacchiera e senza conoscere le regole) ha imparato a giocare mosse legali. Analizzando i suoi neuroni interni, gli scienziati hanno scoperto che l’IA aveva ricostruito autonomamente una rappresentazione della scacchiera 8×8 al suo interno. Aveva dedotto la geometria del gioco solo osservando le sequenze di testo. Questo dimostra che gli algoritmi non stanno solo scimmiottando il linguaggio, ma stanno estraendo la struttura profonda della realtà sottostante.

In Breve (TL;DR)

Le moderne intelligenze artificiali sviluppano abilità complesse come logica e programmazione senza istruzioni specifiche, superando la definizione di semplici pappagalli stocastici.

L’accumulo quantitativo di dati e parametri genera improvvisi salti qualitativi nelle prestazioni, simili alle transizioni di fase fisiche chiamate proprietà emergenti.

I modelli creano rappresentazioni interne del mondo per ottimizzare le previsioni, trasformandosi in scatole nere il cui funzionamento esatto rimane un mistero.

Conclusioni

La curiosità verso l’Intelligenza Artificiale non dovrebbe fermarsi alla superficie delle sue applicazioni pratiche, ma spingersi verso la natura stessa di questa “intelligenza aliena” che abbiamo creato. Le proprietà emergenti ci insegnano che la somma delle parti può essere molto più grande del tutto e che, forse, la complessità è la chiave stessa della coscienza o, quantomeno, del ragionamento avanzato. Mentre continuiamo a spingere i confini del progresso tecnologico, la vera sfida dei prossimi anni non sarà solo costruire modelli più grandi, ma sviluppare la “torcia” matematica necessaria per illuminare l’interno della scatola nera e capire, finalmente, cosa sta pensando la macchina.

Domande frequenti

Le proprietà emergenti sono abilità complesse che un modello di intelligenza artificiale sviluppa spontaneamente senza che siano state programmate esplicitamente nel suo codice. Queste capacità, come il ragionamento logico o la traduzione avanzata, si manifestano improvvisamente quando il sistema supera una certa soglia critica di dimensione e potenza di calcolo, andando oltre la semplice previsione statistica per cui era stato addestrato.

Per prevedere con estrema precisione la parola successiva in un testo complesso, l’algoritmo è costretto a costruire internamente un modello del mondo coerente. Per minimizzare l’errore, l’IA deve comprendere implicitamente le leggi spaziali, temporali e causali che governano i dati, poiché la semplice statistica non basta per completare frasi che richiedono deduzione. L’intelligenza emerge quindi come la forma più efficiente di compressione dei dati.

Il concetto di Black Box indica che, pur conoscendo i dati di input e l’algoritmo di addestramento, i ricercatori non sanno esattamente come la rete neurale elabori le informazioni al suo interno per generare una risposta. I processi decisionali sono distribuiti su miliardi di parametri numerici, rendendo estremamente difficile interpretare il percorso logico specifico seguito dalla macchina per arrivare a una determinata conclusione o opera creativa.

Un pappagallo stocastico si limita a ripetere sequenze di parole basandosi sulla probabilità statistica senza alcuna comprensione, mentre le moderne IA hanno dimostrato di estrarre la struttura profonda della realtà. Un esempio è la capacità di dedurre autonomamente le regole geometriche di giochi come Othello solo leggendo le mosse, provando che il sistema non sta solo imitando il linguaggio ma sta ricostruendo logiche sottostanti.

L’aumento della quantità di dati e parametri non porta a un miglioramento graduale, ma causa salti qualitativi improvvisi simili alle transizioni di fase in fisica. Un modello può fallire costantemente in un compito fino a quando, raggiunta una certa complessità strutturale, impara improvvisamente a risolverlo con alta precisione, fenomeno noto come grokking.

Fonti e Approfondimenti

- Wikipedia – Panoramica sui Modelli Linguistici di Grandi Dimensioni (LLM)

- Wikipedia – Comportamento emergente e proprietà nei sistemi complessi

- NIST (Governo USA) – Standard e ricerche sulla sicurezza dell’IA

- Governo UK – Documento di discussione su capacità e rischi dell’IA di frontiera

- Parlamento Europeo – La legge sull’IA e la regolamentazione dei modelli generali

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.