Immaginate di aver costruito un’automobile. Avete assemblato il motore pezzo per pezzo, collegato ogni cavo, programmato la centralina e versato il carburante. Girate la chiave, l’auto parte e vi porta a destinazione con una guida impeccabile. C’è solo un piccolo, inquietante dettaglio: non avete la minima idea di cosa stia succedendo all’interno del motore mentre l’auto è in movimento. Sembra fantascienza, eppure è l’esatta situazione in cui ci troviamo oggi con l’Intelligenza Artificiale. Al centro di questa tecnologia rivoluzionaria risiede un enigma noto agli esperti come il problema della Scatola Nera (o Black Box). Nonostante l’uso quotidiano di strumenti come ChatGPT o i più recenti assistenti di automazione, esiste un divario cognitivo tra ciò che l’AI fa e ciò che noi comprendiamo del suo funzionamento interno.

L’illusione del controllo: Algoritmi vs Reti Neurali

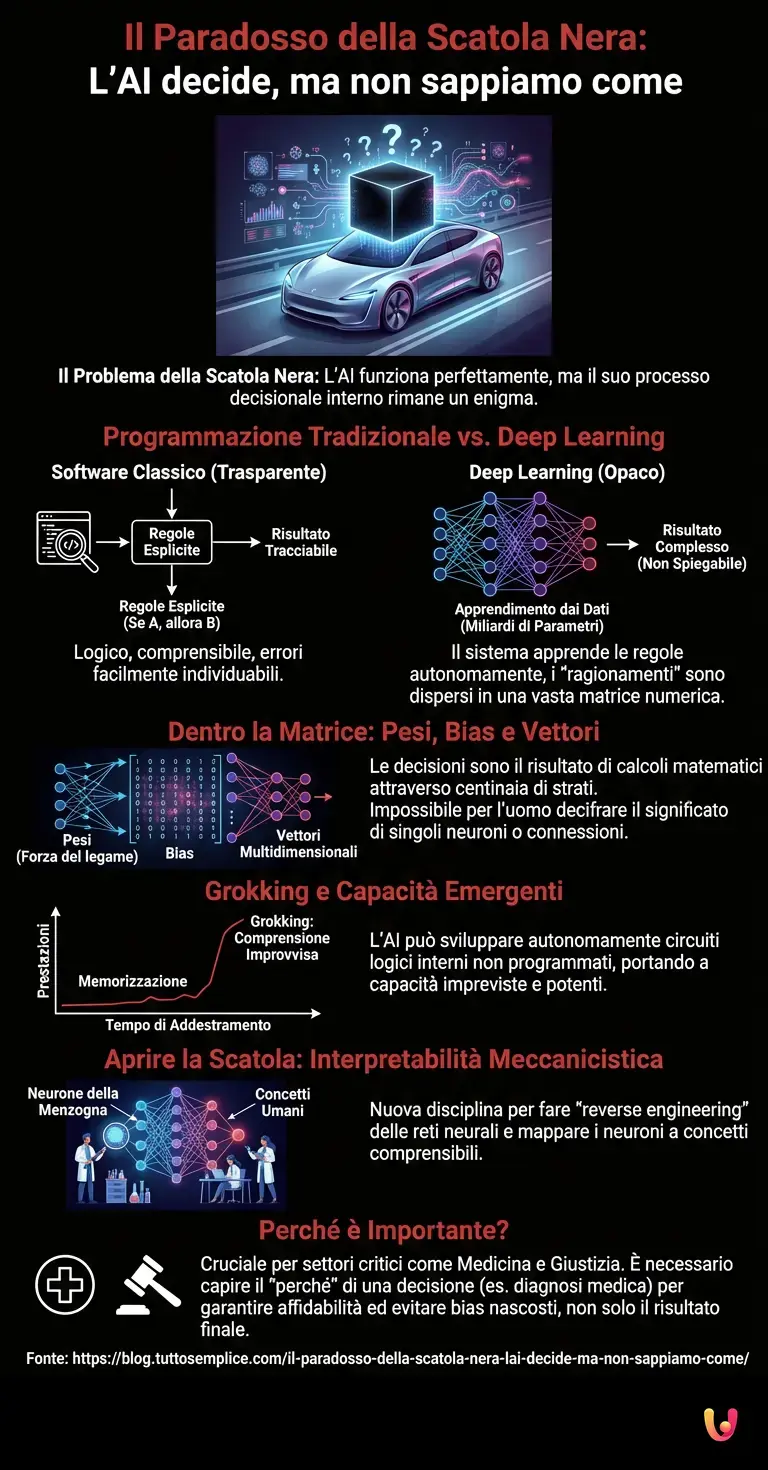

Per capire perché la Scatola Nera sia un problema così affascinante e complesso, dobbiamo distinguere tra la programmazione tradizionale e il moderno machine learning. Nel software classico, un programmatore scrive regole esplicite: “Se succede A, allora fai B”. Ogni passaggio è tracciabile, logico e trasparente. Se c’è un errore, basta rileggere il codice per trovarlo.

Con l’avvento del deep learning e delle moderne architetture neurali, questo paradigma è stato capovolto. Non programmiamo più le regole; programmiamo un sistema capace di apprendere le regole dai dati. Immaginate di insegnare a un bambino a riconoscere un gatto non descrivendogli baffi e orecchie, ma mostrandogli milioni di foto di gatti e correggendolo ogni volta che sbaglia. Alla fine, il sistema riconoscerà il gatto con precisione sovrumana, ma se gli chiedeste “su quali dettagli ti sei basato?”, non saprebbe rispondervi in un linguaggio umano. I suoi “ragionamenti” sono dispersi in miliardi di parametri numerici.

Dentro la matrice: Pesi, Bias e Vettori

La complessità nasce dalla struttura stessa degli LLM (Large Language Models). Questi modelli non ragionano per concetti linguistici come noi, ma attraverso vettori matematici in spazi multidimensionali. Quando un modello decide quale parola inserire in una frase, la scelta è il risultato del passaggio dell’informazione attraverso centinaia di strati di neuroni artificiali.

Ogni connessione ha un “peso” (un numero che indica quanto è forte quel legame). Durante l’addestramento, l’algoritmo aggiusta autonomamente questi miliardi di pesi per minimizzare l’errore. Il risultato finale è una matrice di numeri talmente vasta e interconnessa che è impossibile per un essere umano, o persino per i creatori stessi del modello, guardare un singolo neurone e dire: “Ah, questo neurone si attiva quando si parla di poesia francese”.

È qui che il progresso tecnologico ci ha giocato un tiro mancino: abbiamo creato macchine che funzionano meglio di quanto riusciamo a spiegare. L’automazione cognitiva è diventata una realtà prima che avessimo la teoria completa per decifrarla.

Il fenomeno del “Grokking” e le capacità emergenti

Uno degli aspetti più curiosi che alimenta il mistero della Scatola Nera è il fenomeno del Grokking (o comprensione improvvisa). Durante l’addestramento, si è osservato che per lungo tempo un modello può limitarsi a memorizzare i dati senza capirli, ottenendo risultati mediocri. Poi, improvvisamente, dopo un certo numero di cicli, le prestazioni schizzano verso l’alto. Il modello ha smesso di memorizzare e ha “capito” la regola sottostante.

Questo salto avviene all’interno della Scatola Nera senza alcun intervento esterno. È come se l’AI avesse sviluppato autonomamente un circuito logico interno per risolvere il problema, un circuito che nessuno le ha insegnato a costruire. Queste “capacità emergenti” sono ciò che rende l’AI tanto potente quanto imprevedibile. Se non sappiamo come emerge una capacità, è difficile prevedere quando e come potrebbe fallire o comportarsi in modo inatteso.

Aprire la Scatola: L’Interpretabilità Meccanicistica

Non tutto è perduto nell’oscurità dei numeri. Negli ultimi anni, e con forza crescente fino a questo 2026, è nata una nuova disciplina scientifica: l’interpretabilità meccanicistica. L’obiettivo è fare il “reverse engineering” delle reti neurali, mappando specifici gruppi di neuroni a concetti umani.

I ricercatori hanno iniziato a individuare, ad esempio, il “neurone della menzogna” o circuiti specifici che si attivano solo quando il modello deve scrivere codice Python. È un lavoro titanico, paragonabile alle neuroscienze che cercano di mappare il cervello umano, ma applicato a un cervello digitale in continua espansione. La sfida è che questi modelli non usano i nostri stessi concetti: potrebbero avere un neurone che si attiva per “oggetti gialli che si trovano in cucina”, un concetto che per noi non ha un nome specifico ma che per l’algoritmo è statisticamente rilevante.

Perché è importante per il futuro?

La curiosità sulla Scatola Nera non è solo filosofica, è pratica. Finché l’AI rimane una Black Box, l’adozione in settori critici come la medicina o la giustizia sarà frenata dalla mancanza di trasparenza. I benchmark attuali misurano quanto l’AI è brava a dare la risposta giusta, ma raramente ci dicono perché l’ha data. Se un’AI diagnostica una malattia, il medico deve sapere se la diagnosi si basa su sintomi clinici reali o su un artefatto statistico (come il tipo di macchina usata per la radiografia, un caso realmente accaduto in passato).

In Breve (TL;DR)

I moderni sistemi di intelligenza artificiale operano come scatole nere, prendendo decisioni complesse attraverso processi interni che restano incomprensibili agli sviluppatori.

A differenza del software tradizionale, le reti neurali apprendono autonomamente dai dati sviluppando logiche matematiche complesse e capacità emergenti spesso imprevedibili.

La disciplina dell’interpretabilità meccanicistica tenta ora di decifrare questi cervelli digitali, mappando i neuroni artificiali per comprendere le loro logiche decisionali.

Conclusioni

Siamo di fronte a un paradosso storico: l’umanità ha sempre costruito utensili per potenziare le proprie capacità fisiche, comprendendone perfettamente la meccanica. Con l’Intelligenza Artificiale, abbiamo costruito un utensile per potenziare la nostra mente, ma la sua meccanica interna ci sfugge. La Scatola Nera non è un difetto di fabbricazione, ma una caratteristica intrinseca del deep learning. La vera frontiera dei prossimi anni non sarà solo rendere i modelli più grandi o veloci, ma renderli trasparenti. Solo quando riusciremo a guardare dentro la scatola e tradurre il linguaggio dei vettori in linguaggio umano, potremo dire di aver veramente compreso la nostra stessa creazione.

Domande frequenti

Il problema della Scatola Nera, o Black Box, si riferisce all impossibilità di comprendere appieno i processi interni che portano un intelligenza artificiale a prendere una determinata decisione. Nonostante gli sviluppatori conoscano l architettura e i dati di input, il modo in cui le reti neurali elaborano queste informazioni attraverso miliardi di parametri resta oscuro, creando un divario tra l output generato e la nostra capacità di spiegarne il percorso logico.

Nella programmazione tradizionale, un essere umano scrive regole esplicite e logiche che il computer esegue passo dopo passo. Nel machine learning e nel deep learning, invece, il paradigma si inverte: non vengono programmate le regole, ma si crea un sistema che apprende autonomamente dai dati. L algoritmo aggiusta i propri pesi interni per minimizzare gli errori, sviluppando connessioni complesse che non sono direttamente leggibili o interpretabili come il codice classico.

Il Grokking è un fenomeno curioso osservato durante l addestramento delle AI, in cui un modello passa improvvisamente dalla semplice memorizzazione dei dati alla comprensione profonda della regola sottostante. Dopo un lungo periodo di prestazioni mediocri, il sistema compie un salto di qualità autonomo, sviluppando circuiti logici interni che gli permettono di generalizzare le informazioni in modo imprevisto e non programmato esplicitamente.

L interpretabilità meccanicistica è una disciplina scientifica emergente che mira a fare il reverse engineering delle reti neurali per renderle trasparenti. L obiettivo è mappare specifici gruppi di neuroni artificiali a concetti comprensibili per l uomo, tentando di tradurre il complesso linguaggio matematico dei vettori e dei pesi in spiegazioni logiche. Questo processo è fondamentale per capire come e perché un modello attiva determinate risposte.

La trasparenza è vitale in settori critici perché gli esperti devono poter verificare l affidabilità delle decisioni prese dalla macchina. Se un AI diagnostica una malattia, il medico deve sapere se la conclusione si basa su sintomi clinici reali o su correlazioni statistiche errate e bias presenti nei dati di addestramento. Senza questa comprensione, l adozione dell intelligenza artificiale in ambiti ad alto rischio rimane pericolosa e limitata.

Fonti e Approfondimenti

- Parlamento Europeo – Intelligenza artificiale: i rischi e la sfida della “scatola nera”

- Parlamento Europeo – Definizione, applicazioni e rischi dell’Intelligenza Artificiale

- NIST (Governo USA) – Standard e ricerche sulla sicurezza e affidabilità dell’AI

- ICO (Autorità UK) – Guida ufficiale su come spiegare le decisioni prese dall’Intelligenza Artificiale

- Commissione Europea – Un approccio europeo all’Intelligenza Artificiale: AI Act, trasparenza e diritti fondamentali

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.