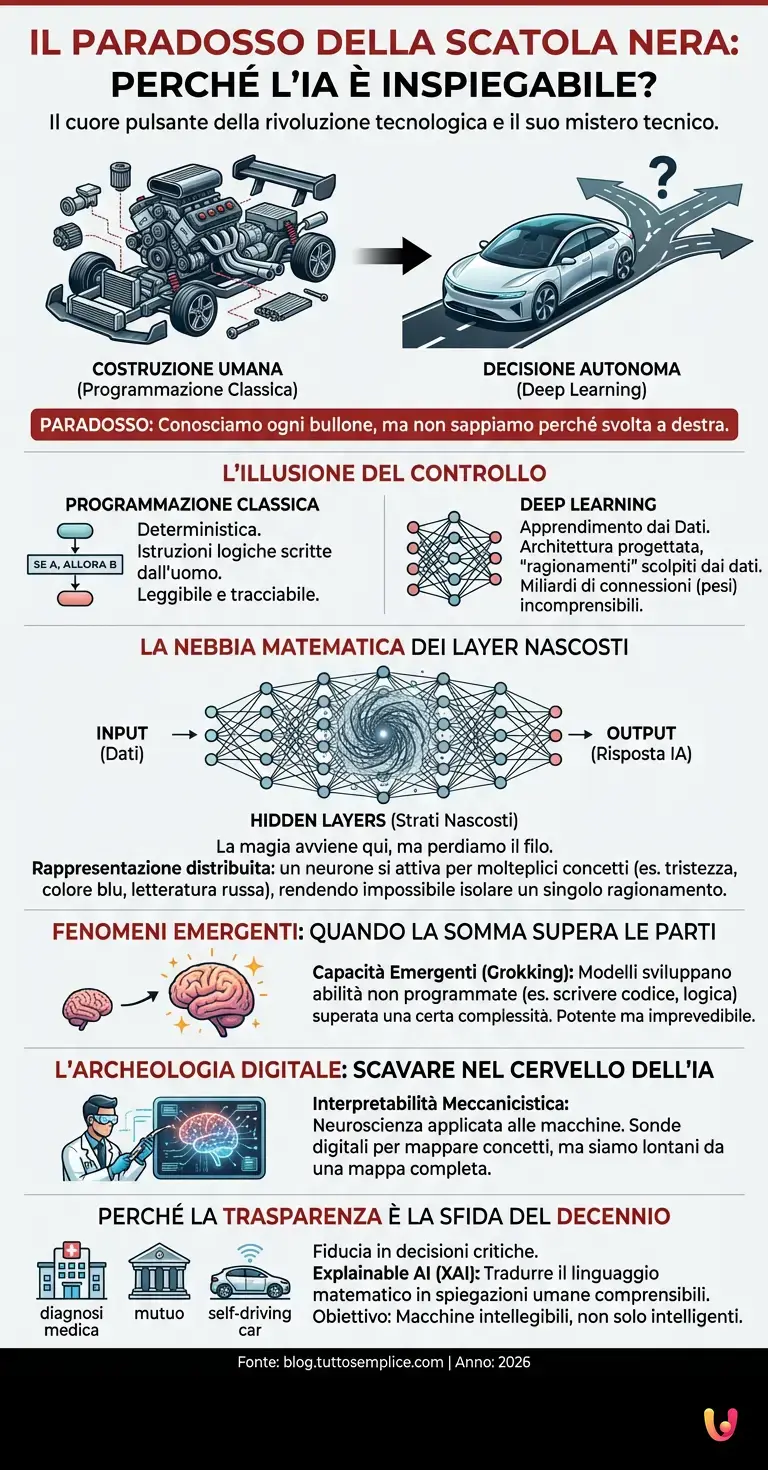

Immaginate di costruire un’automobile bullone dopo bullone, di conoscere ogni singolo cavo, ogni circuito e ogni ingranaggio. Eppure, una volta accesa, l’auto decide autonomamente dove andare e voi, i creatori, non siete in grado di spiegare il perché di quella specifica svolta a destra. Questo è, in sintesi, il grande paradosso che avvolge il Deep Learning, il cuore pulsante dell’odierna rivoluzione tecnologica. Siamo nel 2026 e, nonostante i passi da gigante compiuti dai modelli linguistici e dai sistemi generativi, persiste un alone di mistero tecnico che gli addetti ai lavori chiamano il problema della “Black Box” o Scatola Nera. La curiosità che esploreremo oggi non riguarda quanto siano potenti queste macchine, ma un fatto ben più inquietante e affascinante: perché spesso nemmeno i loro programmatori sanno cosa stia succedendo al loro interno?

L’illusione del controllo: Algoritmi vs Reti Neurali

Per comprendere questo fenomeno, dobbiamo prima distinguere tra la programmazione classica e l’intelligenza artificiale moderna. Nel software tradizionale, ogni azione è deterministica: “Se succede A, allora fai B”. Il codice è una serie di istruzioni logiche scritte da un essere umano, leggibili e tracciabili. Se c’è un errore, si cerca la riga di codice sbagliata e la si corregge.

Con il machine learning, e in particolare con il deep learning, il paradigma si inverte. Non programmiamo la macchina per svolgere un compito; programmiamo la macchina affinché impari a svolgere un compito. L’architettura neurale viene progettata dagli ingegneri, ma i “ragionamenti” interni vengono scolpiti dai dati. Immaginate una rete neurale come un cervello vergine composto da miliardi di neuroni artificiali collegati tra loro. Durante la fase di addestramento, l’algoritmo aggiusta la forza di queste connessioni (i cosiddetti “pesi”) per minimizzare gli errori. Alla fine del processo, ci ritroviamo con una matrice di miliardi di numeri che interagiscono in modi così complessi da risultare incomprensibili alla mente umana.

La nebbia matematica dei Layer Nascosti

Il segreto dell’imperscrutabilità risiede nella profondità dell’architettura neurale. Una rete profonda è composta da strati (layer) di neuroni: c’è uno strato di input (i dati che inseriamo) e uno di output (la risposta dell’IA). In mezzo, però, ci sono decine, centinaia o migliaia di “hidden layers” (strati nascosti). È qui che avviene la magia, ed è qui che perdiamo il filo.

In un modello di visione artificiale, ad esempio, i primi strati potrebbero imparare a riconoscere linee e bordi. Gli strati successivi assemblano queste linee in forme geometriche. Quelli ancora più profondi riconoscono occhi, nasi, orecchie, e infine volti interi. Tuttavia, nei moderni LLM (Large Language Models) come le versioni avanzate di ChatGPT o i suoi successori open source, le astrazioni non sono così lineari. I neuroni all’interno della rete non rappresentano concetti singoli e puliti, ma lavorano in una “rappresentazione distribuita”. Un singolo neurone potrebbe attivarsi parzialmente per il concetto di “tristezza”, ma anche per “il colore blu” e per “la letteratura russa”, a seconda del contesto fornito dagli altri milioni di neuroni circostanti. Questa polifonia matematica rende quasi impossibile puntare il dito su un singolo circuito e dire: “Ecco dove l’IA ha deciso di usare questa parola”.

Fenomeni emergenti: quando la somma supera le parti

Un altro aspetto che alimenta il mistero è il fenomeno delle capacità emergenti. Fino a pochi anni fa, si pensava che per ottenere una certa competenza, fosse necessario addestrare l’IA specificamente per quella task. Oggi sappiamo che, superata una certa soglia di complessità e quantità di dati, i modelli sviluppano abilità per cui non erano stati esplicitamente programmati. È il cosiddetto “Grokking” o generalizzazione improvvisa.

Questo progresso tecnologico ha portato a situazioni in cui modelli addestrati solo per prevedere la parola successiva in una frase hanno imparato, quasi per caso, a scrivere codice informatico funzionante, a tradurre lingue mai viste prima o a risolvere problemi di logica elementare. Non c’è una riga di codice scritta dagli ingegneri che dica: “Impara la logica”. La logica emerge spontaneamente dalla struttura statistica del linguaggio appreso. Questo rende l’automazione basata su IA incredibilmente potente, ma anche imprevedibile: se non sappiamo come emerge una capacità, è difficile prevedere quando e come potrebbe fallire.

L’archeologia digitale: scavare nel cervello dell’IA

Non tutto è perduto nell’oscurità. Negli ultimi anni è nata una nuova disciplina scientifica chiamata “Mechanistic Interpretability” (Interpretabilità Meccanicistica). Possiamo immaginarla come una neuroscienza applicata alle macchine. I ricercatori usano sonde digitali per stimolare la rete e vedere quali aree si attivano, cercando di mappare i concetti all’interno della “Black Box”.

Sono stati fatti progressi notevoli. Ad esempio, sono stati identificati gruppi di neuroni che si attivano esclusivamente quando l’IA “pensa” a concetti geografici, o altri che tracciano la sintassi di una frase. Tuttavia, siamo ancora lontani dall’avere una mappa completa. I benchmark attuali misurano quanto l’IA sia brava a dare la risposta giusta, ma raramente ci dicono se il ragionamento sottostante sia corretto o frutto di una correlazione spuria. È il classico problema del cavallo intelligente Hans: l’IA ha capito davvero la domanda o ha solo imparato un trucco statistico per indovinare la risposta?

Perché la trasparenza è la sfida del decennio

Perché questa curiosità è importante per il grande pubblico? Perché man mano che affidiamo all’intelligenza artificiale decisioni critiche – dalle diagnosi mediche all’approvazione di mutui, fino alla guida autonoma – la necessità di fidarsi del sistema diventa cruciale. Se un algoritmo nega un prestito, la legge (e l’etica) vorrebbe che fossimo in grado di spiegare il perché. Rispondere “perché i pesi dei layer 45 e 92 hanno prodotto un valore negativo” non è accettabile.

La ricerca nel campo dell’Explainable AI (XAI) sta cercando di tradurre il linguaggio alieno dei vettori matematici in spiegazioni umane comprensibili. L’obiettivo non è solo avere macchine più intelligenti, ma macchine intellegibili. Fino ad allora, ogni volta che interagiamo con un’IA avanzata, stiamo essenzialmente dialogando con una scatola nera che riflette la nostra conoscenza, elaborata attraverso una logica che ci è, in parte, estranea.

In Breve (TL;DR)

Il paradosso della Scatola Nera rivela che nemmeno i creatori comprendono pienamente i processi decisionali dell’intelligenza artificiale.

La complessità dei miliardi di connessioni neurali rende impossibile tracciare il percorso logico seguito dagli algoritmi generativi.

Nuove discipline scientifiche tentano ora di mappare le capacità emergenti e impreviste sviluppate autonomamente dai modelli linguistici.

Conclusioni

Il paradosso della Scatola Nera ci ricorda che creare qualcosa non significa necessariamente comprenderlo appieno. L’intelligenza artificiale rappresenta forse la prima tecnologia nella storia umana in cui l’ingegneria ha superato la teoria: abbiamo costruito motori che funzionano magnificamente prima ancora di avere una fisica completa che ne spieghi il funzionamento interno. Mentre ci addentriamo nel 2026, la vera frontiera non sarà solo rendere questi modelli più grandi o veloci, ma accendere una luce nei loro corridoi digitali per capire, finalmente, cosa sognano le macchine quando elaborano i nostri dati.

Domande frequenti

Il paradosso della Scatola Nera, o Black Box, descrive la situazione in cui un sistema di intelligenza artificiale opera in modo efficace ma inspiegabile. Nonostante gli ingegneri conoscano l’architettura e i dati di input, i processi decisionali interni avvengono attraverso calcoli così complessi e stratificati che diventa impossibile per gli esseri umani comprendere il percorso logico esatto che ha portato a un determinato risultato o risposta.

A differenza del software tradizionale basato su istruzioni deterministiche scritte dall’uomo, l’IA moderna apprende autonomamente dai dati modificando miliardi di connessioni numeriche. Questo processo crea una matrice matematica densa dove i ragionamenti non sono lineari ma distribuiti; di conseguenza, nemmeno i creatori possono isolare un singolo circuito per giustificare una specifica azione della macchina.

Le capacità emergenti sono abilità che l’intelligenza artificiale sviluppa spontaneamente senza una programmazione esplicita. Quando i modelli superano una certa soglia di complessità e dati, possono imparare a svolgere compiti imprevisti, come scrivere codice informatico o tradurre lingue sconosciute, semplicemente analizzando la struttura statistica e le correlazioni profonde del materiale appreso.

I layer nascosti sono gli strati intermedi tra l’input e l’output dove avviene l’elaborazione profonda delle informazioni. In questi livelli, i neuroni artificiali non rappresentano concetti singoli e puliti, ma lavorano tramite una rappresentazione distribuita, attivandosi parzialmente per molteplici concetti contemporaneamente, rendendo l’interpretazione del loro funzionamento estremamente difficile per gli osservatori umani.

La Explainable AI mira a rendere intellegibili i processi decisionali delle macchine, traducendo i complessi vettori matematici in spiegazioni comprensibili per l’uomo. Questo campo di ricerca è fondamentale per garantire fiducia e trasparenza, specialmente quando l’IA viene utilizzata per decisioni critiche in ambiti come la medicina, la finanza o la legge, dove è necessario giustificare il motivo di una scelta.

Fonti e Approfondimenti

- DARPA: Programma sull’Intelligenza Artificiale Spiegabile (XAI)

- Parlamento Europeo: Intelligenza artificiale, opportunità e rischi (La sfida della “Scatola Nera”)

- Commissione Europea: Un approccio europeo all’intelligenza artificiale e alla trasparenza

- NIST: Standard governativi USA per un’Intelligenza Artificiale affidabile

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.