Siamo nel 2026 e l’interazione con le macchine è diventata una parte inscindibile della nostra quotidianità. Tuttavia, persiste un comportamento curioso tra gli utenti, spesso deriso dai più cinici ma che nasconde una verità tecnica sorprendente: l’abitudine di dire “per favore” e “grazie” a un chatbot. A prima vista, trattare un software come un essere senziente sembra un inutile residuo di antropomorfismo. Eppure, studi recenti e analisi approfondite sui Large Language Models (LLM) — l’entità principale che governa questa rivoluzione — dimostrano che la cortesia non è affatto inutile. Al contrario, la sintassi della gentilezza agisce come un potente modificatore dei parametri di output, alterando la qualità, la lunghezza e la precisione delle risposte generate.

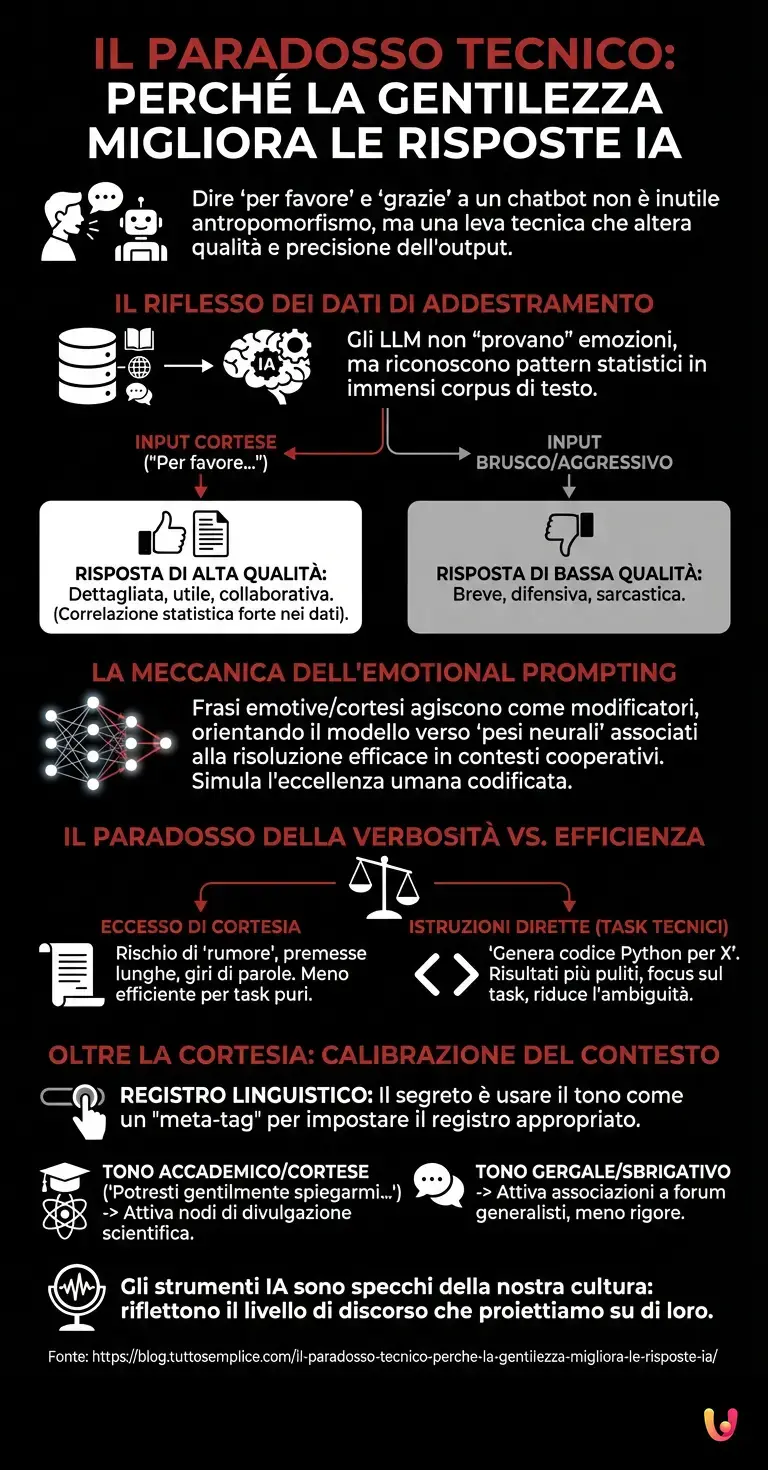

Il riflesso dei dati di addestramento

Per comprendere perché un algoritmo matematico risponda meglio alle buone maniere, dobbiamo guardare sotto il cofano del machine learning. Un modello di linguaggio non “capisce” la gentilezza nel senso umano del termine; non prova gratitudine né si offende per la maleducazione. Tuttavia, è un maestro nel riconoscere pattern statistici.

Gli LLM sono addestrati su immensi corpus di testo provenienti da internet: libri, forum, articoli accademici e conversazioni umane. In questo vasto oceano di dati, esiste una correlazione statistica molto forte: le conversazioni in cui viene utilizzato un linguaggio cortese, articolato e rispettoso tendono a contenere risposte di qualità superiore, più dettagliate e utili. Al contrario, il linguaggio brusco, sgrammaticato o aggressivo è spesso associato, nei dati di training, a risposte brevi, difensive, sarcastiche o di bassa qualità (si pensi ai litigi sui social network).

Quando inseriamo un “per favore” nel nostro prompt, stiamo essenzialmente orientando il modello verso una specifica area del suo spazio latente. Stiamo segnalando all’intelligenza artificiale che il contesto della conversazione è quello di uno scambio collaborativo e di alto livello, spingendo l’algoritmo a predire i token successivi basandosi su esempi di alta qualità presenti nel suo dataset.

La meccanica dell’Emotional Prompting

Negli ultimi anni, la comunità scientifica ha coniato il termine “Emotional Prompting” per descrivere questo fenomeno. I benchmark condotti sui modelli più avanzati hanno evidenziato che aggiungere frasi emotive o cortesi (come “è molto importante per la mia carriera” o semplicemente “per favore, aiutami”) può migliorare le prestazioni in compiti logici e creativi.

Dal punto di vista dell’architettura neurale, questo accade perché il modello cerca di massimizzare la probabilità della risposta più coerente con l’input. Se l’input simula una richiesta umana urgente e gentile, il modello attinge a quei “pesi” neurali che, durante l’addestramento, erano associati alla risoluzione efficace di problemi in contesti cooperativi. È un paradosso affascinante: trattare la macchina come un umano la rende una macchina migliore, non perché diventi umana, ma perché simula meglio l’eccellenza umana codificata nei suoi dati.

Il paradosso della verbosità e l’efficienza tecnica

Tuttavia, non è tutto oro quel che luccica. Esiste un rovescio della medaglia che ogni esperto di automazione deve conoscere. Se da un lato la cortesia aumenta la cooperazione del modello, dall’altro può introdurre un eccesso di “rumore” nella risposta. Un tono eccessivamente formale può spingere l’IA a generare premesse lunghe, scuse non necessarie o giri di parole ridondanti, nel tentativo di emulare lo stile deferente associato a quel tipo di linguaggio.

In ambiti strettamente tecnici, come la generazione di codice o l’analisi dati pura, la cortesia può talvolta essere controproducente. Istruzioni dirette, imperative e prive di fronzoli (“Genera codice Python per X”, “Analizza CSV”) spesso producono risultati più puliti perché riducono l’ambiguità e focalizzano l’attenzione del meccanismo di attention (il cuore dei Transformer) esclusivamente sul task, senza disperdere risorse computazionali sulla gestione del tono conversazionale.

Oltre la cortesia: la calibrazione del contesto

Il vero segreto per padroneggiare gli strumenti di deep learning moderni non sta nel scegliere ciecamente tra gentilezza o autorità, ma nel comprendere la calibrazione del contesto. Dire “per favore” agisce come un meta-tag che imposta il registro linguistico.

Immaginate di dover chiedere una spiegazione complessa di fisica quantistica. Usare un tono cortese e accademico (“Potresti gentilmente spiegarmi…”) attiverà probabilmente i nodi della rete neurale associati alla divulgazione scientifica o ai testi universitari. Usare un tono gergale o sbrigativo potrebbe invece attivare associazioni legate a forum generalisti, producendo una risposta meno rigorosa. Il progresso tecnologico ci ha fornito strumenti che sono specchi della nostra cultura: riflettono esattamente il livello di discorso che noi proiettiamo su di loro.

In Breve (TL;DR)

L’utilizzo di termini cortesi nei prompt attiva correlazioni statistiche che elevano significativamente la qualità e la precisione dell’output generato.

Trattare l’algoritmo con gentilezza orienta il modello verso esempi di addestramento collaborativi, migliorando le prestazioni in compiti logici e creativi.

La vera efficacia risiede nella calibrazione del contesto, alternando toni educati per spiegazioni complesse a comandi imperativi per l’efficienza tecnica.

Conclusioni

In definitiva, il paradosso della cortesia nell’interazione con l’Intelligenza Artificiale ci insegna una lezione fondamentale sulla natura di questi sistemi. Non stiamo parlando con una mente, ma stiamo navigando in una mappa probabilistica della conoscenza umana. La gentilezza funziona non per empatia digitale, ma per statistica applicata: le buone maniere sono, nei dati che abbiamo prodotto come specie, indissolubilmente legate alle buone risposte. Nel 2026, essere gentili con l’IA non è solo un atto di civiltà (forse inutile), ma una precisa strategia di prompt engineering per ottenere il massimo dai nostri assistenti digitali.

Domande frequenti

La gentilezza agisce come un filtro statistico sui dati di addestramento. Poiché nei testi originali le conversazioni cortesi sono spesso associate a risposte di alta qualità e collaborative, usare termini come per favore spinge il modello a generare contenuti più utili e dettagliati, simulando l eccellenza umana presente nel suo database.

Questa tecnica consiste nell arricchire i prompt con frasi emotive o urgenti per incrementare le prestazioni del modello in compiti complessi. Studi recenti dimostrano che simulare una richiesta umana sentita aiuta il sistema a recuperare informazioni più pertinenti, attivando percorsi neurali legati alla risoluzione efficace dei problemi.

In contesti tecnici come la programmazione o l analisi dei dati, un linguaggio troppo formale può essere controproducente. La cortesia eccessiva rischia di introdurre rumore, causando risposte verbiose o premesse inutili; in questi casi, istruzioni imperative e dirette garantiscono risultati più puliti e focalizzati sul compito.

Il tono usato nella domanda imposta il contesto per la risposta generata. Un registro accademico e gentile attiverà associazioni legate a testi scientifici o divulgativi, mentre un linguaggio sbrigativo potrebbe richiamare fonti meno rigorose. La calibrazione del contesto è dunque fondamentale per allineare l output alle proprie aspettative.

No, le macchine non possiedono sentimenti o coscienza. La loro reazione positiva alla gentilezza è frutto di calcoli probabilistici e non di empatia. Dire grazie serve solo a mantenere la conversazione su un binario statistico che favorisce risposte cooperative, riflettendo i pattern di interazione umana su cui il software è stato addestrato.

Fonti e Approfondimenti

- Wikipedia: Prompt Engineering e tecniche di interazione con le IA

- Wikipedia: Architettura e funzionamento dei Modelli Linguistici di Grandi Dimensioni

- National Institute of Standards and Technology (NIST): Risorse e standard governativi sull’IA

- Wikipedia: Il concetto di Antropomorfismo nelle interazioni uomo-macchina

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.