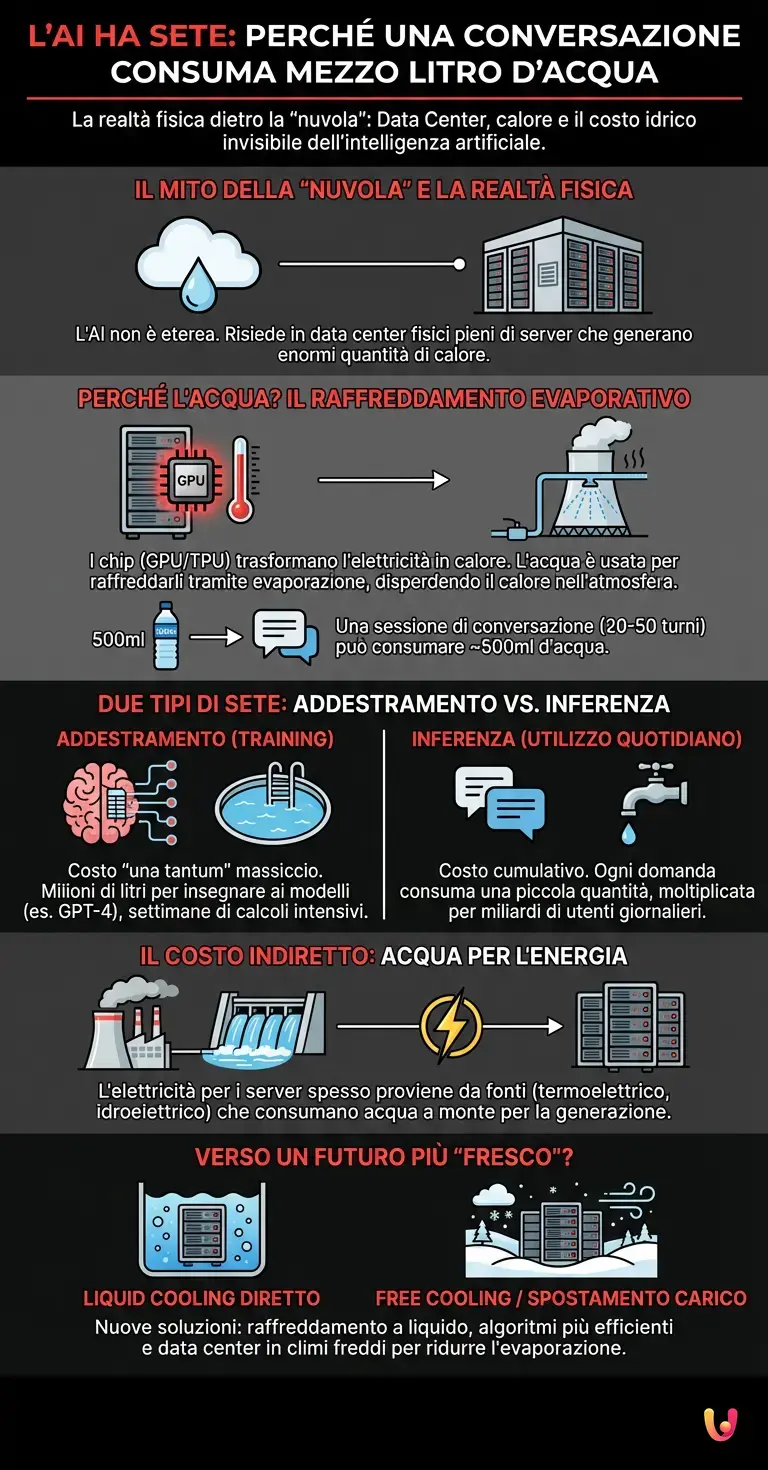

Siamo nel 2026 e l’interazione con l’Intelligenza Artificiale è diventata un gesto quotidiano, quasi banale, come accendere la luce o aprire un rubinetto. Quando digitiamo una richiesta su una chat o chiediamo a un assistente vocale di riassumere un documento, visualizziamo mentalmente un processo etereo, immateriale, che avviene in quella che chiamiamo “nuvola”. Tuttavia, la metafora del cloud è ingannevole. Dietro l’apparente leggerezza del software si nasconde una realtà fisica pesante, fatta di metallo, silicio e, sorprendentemente, enormi quantità d’acqua. La curiosità che affrontiamo oggi riguarda un dato sconcertante emerso negli ultimi anni e confermato dalle recenti analisi infrastrutturali: per generare una semplice conversazione composta da poche decine di domande e risposte, i sistemi di AI possono arrivare a “bere” l’equivalente di una bottiglietta d’acqua da mezzo litro. Ma come è possibile che un codice informatico abbia sete?

Il mito dell’immaterialità e la termodinamica dei Data Center

Per comprendere il nesso tra un algoritmo e l’acqua, dobbiamo spostare lo sguardo dai nostri schermi ai luoghi fisici dove l’AI risiede: i Data Center. Queste cattedrali del progresso tecnologico ospitano migliaia di server impilati in rack, che lavorano incessantemente per elaborare calcoli complessi. Al cuore di questi server pulsano le GPU (Graphics Processing Units) e le TPU (Tensor Processing Units), i chip specializzati nel deep learning e nel calcolo parallelo.

Qui entra in gioco la fisica elementare. Ogni volta che un processore esegue un’operazione, consuma elettricità. Secondo le leggi della termodinamica, questa energia non sparisce, ma si trasforma quasi interamente in calore. Immaginate ora migliaia di chip stipati in una stanza, ognuno dei quali raggiunge temperature elevate mentre esegue miliardi di calcoli al secondo per far funzionare un LLM (Large Language Model). Senza un sistema di raffreddamento efficiente, l’hardware fonderebbe in pochi minuti, portando al collasso l’intera infrastruttura.

Come funziona il raffreddamento: perché l’acqua?

Esistono diversi modi per raffreddare i server, ma l’acqua rimane uno dei vettori termici più efficienti, molto più dell’aria. La maggior parte dei grandi data center utilizza torri di raffreddamento evaporativo. Il principio è simile a quello della sudorazione umana: quando l’acqua evapora, sottrae calore all’ambiente circostante.

In questi impianti, l’acqua viene fatta circolare vicino ai componenti caldi (o in scambiatori di calore) per assorbire l’energia termica. Successivamente, quest’acqua riscaldata viene esposta all’aria nelle torri di raffreddamento, dove una parte di essa evapora, disperdendo il calore nell’atmosfera e raffreddando l’acqua residua che rientra nel ciclo. È proprio in questa fase di evaporazione che l’acqua viene “consumata”. Non viene restituita alla fonte, ma persa sotto forma di vapore. Ecco svelato il primo segreto del “mezzo litro”: è il tributo termico necessario per mantenere i chip alla temperatura operativa ottimale mentre elaborano la vostra risposta.

Addestramento vs. Inferenza: due tipi di sete

Quando parliamo di consumo idrico nell’ambito del machine learning, dobbiamo distinguere due fasi cruciali: l’addestramento (training) e l’inferenza.

L’addestramento è la fase in cui il modello “impara” leggendo terabyte di testo. È un processo intensivo che può durare settimane o mesi, coinvolgendo migliaia di GPU al massimo della potenza. Si stima che l’addestramento di modelli come GPT-4 (e i suoi successori del 2026) abbia consumato milioni di litri d’acqua, sufficienti a riempire diverse piscine olimpioniche. Tuttavia, questo è un costo “una tantum”.

Il vero costo invisibile, quello che riguarda il nostro “mezzo litro”, risiede nella fase di inferenza. L’inferenza avviene ogni volta che l’utente interroga il modello. Sebbene il costo energetico per una singola domanda sia infinitesimale rispetto all’addestramento, esso viene moltiplicato per miliardi di utenti giornalieri. È qui che l’efficienza dell’architettura neurale viene messa alla prova. Studi condotti da università prestigiose (come quelli pionieristici della UC Riverside) hanno calcolato che, a seconda dell’efficienza del data center e della temperatura esterna, una sessione di scambio con un chatbot (circa 20-50 turni di conversazione) consuma circa 500 ml d’acqua.

Il costo indiretto: l’acqua nell’energia

C’è un ulteriore livello di complessità che spesso sfugge ai benchmark ufficiali: il consumo idrico indiretto. I data center consumano quantità pantagrueliche di elettricità. Se questa energia proviene da fonti termoelettriche (carbone, gas, nucleare) o idroelettriche, c’è un consumo d’acqua a monte necessario per generare quell’elettricità.

Le centrali termoelettriche usano l’acqua per raffreddare le turbine, mentre l’idroelettrico ha tassi di evaporazione dai bacini. Quando sommiamo l’acqua evaporata nelle torri di raffreddamento del data center (consumo diretto) all’acqua utilizzata per produrre l’elettricità che alimenta i server (consumo indiretto), l’impronta idrica di ChatGPT e simili diventa ancora più marcata. Questo spiega perché il luogo geografico in cui avviene l’elaborazione è fondamentale: un data center in Iowa potrebbe avere un’efficienza idrica diversa da uno in Arizona o in Norvegia.

Perché nessuno ce lo racconta?

Per anni, l’industria tecnologica si è concentrata quasi esclusivamente sull’impronta di carbonio (Carbon Footprint), tralasciando l’impronta idrica (Water Footprint). L’acqua è stata considerata una risorsa a basso costo e infinitamente rinnovabile. Tuttavia, con il cambiamento climatico e la siccità che colpisce diverse aree del globo, la “sete” dell’automazione è diventata un tema critico. Le grandi aziende tech hanno iniziato solo recentemente a pubblicare report di sostenibilità più trasparenti, impegnandosi a diventare “water positive” (restituire più acqua di quella consumata) entro il 2030.

Verso un futuro più “fresco”?

La consapevolezza di questo costo invisibile sta spingendo l’ingegneria verso nuove soluzioni. Si stanno diffondendo tecniche di “liquid cooling” diretto, dove i server sono immersi in fluidi dielettrici speciali che catturano il calore in modo molto più efficiente dell’aria, riducendo la necessità di evaporazione dell’acqua. Inoltre, si sta lavorando su algoritmi più snelli, capaci di fornire le stesse prestazioni con meno calcoli e, di conseguenza, meno calore.

Un’altra strategia è lo spostamento del carico di lavoro: l’AI potrebbe decidere di elaborare la vostra richiesta in un data center situato in una regione fredda, dove è possibile utilizzare l’aria esterna per raffreddare i server (free cooling) senza sprecare acqua potabile.

In Breve (TL;DR)

Dietro l’apparente leggerezza del cloud si nascondono data center che consumano acqua per dissipare il calore generato dai calcoli intensivi dei processori.

Una semplice conversazione con un chatbot può consumare fino a mezzo litro d’acqua a causa dell’evaporazione necessaria per mantenere le temperature operative ottimali.

L’impatto idrico deriva principalmente dalla fase di inferenza, dove miliardi di interazioni quotidiane richiedono un costante tributo termico per il funzionamento degli algoritmi.

Conclusioni

Il “mezzo litro d’acqua per una risposta” non è una leggenda metropolitana, ma una stima realistica che unisce la termodinamica alla complessità computazionale dei moderni modelli linguistici. Ogni volta che interroghiamo un’intelligenza artificiale, attiviamo una catena fisica di eventi che ha un impatto tangibile sulle risorse del pianeta. Non si tratta di demonizzare la tecnologia, che rimane uno strumento fondamentale per il progresso umano, ma di sviluppare una consapevolezza critica. Sapere che dietro l’intangibilità digitale c’è un costo fisico ci aiuta a utilizzare questi strumenti con maggiore responsabilità e spinge l’industria a cercare soluzioni sempre più sostenibili per il futuro del nostro ecosistema.

Domande frequenti

Il consumo è dovuto principalmente alla necessità di raffreddare i data center. I potenti processori utilizzati per la AI generano enormi quantità di calore che deve essere dissipato per evitare guasti hardware. Il metodo più diffuso utilizza torri di raffreddamento evaporativo, dove la risorsa idrica viene fatta evaporare per sottrarre calore al sistema, venendo così consumata e non restituita immediatamente alla fonte.

Secondo studi recenti, una sessione di conversazione composta da circa 20-50 domande e risposte può consumare il corrispettivo di una bottiglietta di acqua da mezzo litro. Questo valore varia in base alla efficienza del data center e alla temperatura esterna, ma rappresenta il costo idrico della fase di inferenza, ovvero il momento in cui il modello elabora le risposte per il singolo utente.

La fase di addestramento è un processo iniziale intensivo che consuma milioni di litri di acqua una tantum per istruire il modello su enormi dataset. La fase di inferenza, invece, riguarda il consumo quotidiano generato dalle richieste degli utenti; sebbene il consumo per singola domanda sia basso, moltiplicato per miliardi di interazioni, la inferenza diventa la fase che richiede il maggior volume idrico complessivo nel lungo periodo.

Sì, il settore tecnologico sta sviluppando diverse strategie per mitigare il problema. Tra queste spiccano il raffreddamento a liquido diretto, che risulta più efficiente della aria, e lo spostamento dei carichi di lavoro in data center situati in regioni fredde per sfruttare il raffreddamento naturale. Inoltre, si lavora su algoritmi più snelli che richiedono meno potenza di calcolo e quindi generano meno calore.

Il consumo indiretto si riferisce alla acqua utilizzata a monte per generare la elettricità che alimenta i server. Le centrali termoelettriche usano acqua per il raffreddamento delle turbine, mentre quelle idroelettriche hanno tassi di evaporazione dai bacini. Sommandolo al consumo diretto per il raffreddamento dei server, il peso idrico totale di un modello AI risulta significativamente più alto rispetto alla sola gestione del calore in loco.

Fonti e Approfondimenti

- Wikipedia: Impatto ambientale dell’intelligenza artificiale

- Agenzia Internazionale dell’Energia (IEA): Analisi sui consumi di data center e reti

- OCSE: Osservatorio sulle politiche AI e sostenibilità ambientale

- USGS (Servizio Geologico USA): Utilizzo dell’acqua per la produzione di energia termoelettrica

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.