L’avanzata dell’intelligenza artificiale nel campo della creazione di immagini ha aperto orizzonti prima inimmaginabili. Trovare il miglior AI per immagini è diventata una priorità per artisti digitali, creatori di contenuti e semplici appassionati. Questo articolo si propone di offrire una panoramica dettagliata e un confronto tra i principali modelli di IA generativa disponibili, analizzandone potenzialità, limiti e ambiti di applicazione. Il mio obiettivo è fornirti gli strumenti per orientarti in questo panorama affascinante e in continua evoluzione, aiutandoti a scegliere la soluzione più adatta alle tue esigenze creative. Esploreremo insieme come queste tecnologie stiano ridefinendo i confini della creatività digitale.

L’universo delle intelligenze artificiali generative per immagini è vasto e in costante fermento. Modelli come Midjourney, DALL-E 3 e Stable Diffusion hanno raggiunto livelli di sofisticazione sorprendenti, capaci di tradurre semplici input testuali in opere visive complesse e stilisticamente variegate. Ma quale si distingue come il migliore? La risposta, come spesso accade, dipende molto dall’uso specifico che se ne intende fare, dalle proprie competenze tecniche e dalle aspettative in termini di qualità e controllo. In questa guida, cercherò di sviscerare le caratteristiche salienti di ciascun contendente, mettendo in luce i punti di forza e le aree di miglioramento, per permetterti una scelta consapevole. Ricorda, la tecnologia è uno strumento; la vera magia risiede nella tua visione.

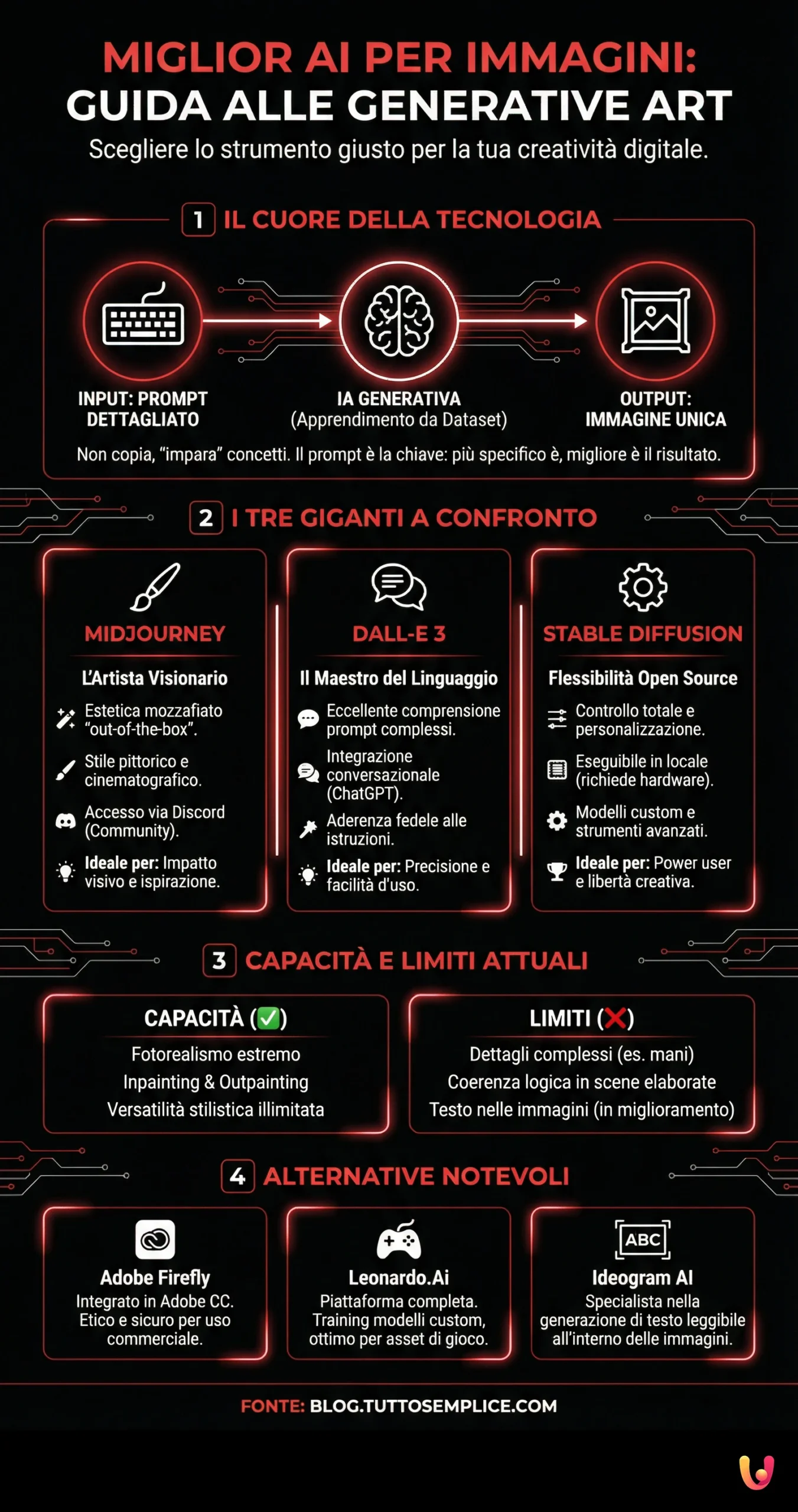

Comprendere l’Intelligenza Artificiale Generativa per Immagini

Prima di addentrarci nel confronto diretto tra i vari modelli, ritengo sia utile fare un passo indietro per capire, a grandi linee, cosa sia l’intelligenza artificiale generativa applicata alla creazione di immagini. Non temere, non entrerò in tecnicismi eccessivi, ma una comprensione di base è fondamentale per apprezzare appieno le potenzialità e le sfumature di questi strumenti. L’obiettivo è demistificare un po’ questa tecnologia, rendendola accessibile anche a chi non ha un background prettamente tecnico. Dopotutto, la creatività non dovrebbe avere barriere.

L’IA generativa, in questo contesto, si riferisce a sistemi capaci di creare nuove immagini da zero o di modificare immagini esistenti basandosi su input forniti dall’utente, solitamente sotto forma di testo (i cosiddetti “prompt”). Questi sistemi non si limitano a “copiare” o “mescolare” immagini esistenti in modo banale; piuttosto, apprendono da enormi dataset di immagini e testo per capire concetti, stili, oggetti e le relazioni tra di essi. È un processo complesso che coinvolge reti neurali profonde, in particolare architetture come le Generative Adversarial Networks (GAN) o i modelliTransformer e i modelli Diffusion. Il risultato è spesso sorprendente, a volte imperfetto, ma quasi sempre stimolante. Pensala come un apprendista artista digitale che ha studiato milioni di opere d’arte e fotografie, pronto a creare qualcosa di nuovo su tua indicazione.

L’Evoluzione della Creazione di Immagini AI

Il percorso che ci ha portato ai sofisticati generatori di immagini odierni è stato relativamente rapido ma incredibilmente denso di progressi. Agli albori, i primi esperimenti producevano risultati spesso astratti, a tratti goffi, ma che lasciavano intravedere un potenziale enorme. Ricordo ancora lo stupore di fronte alle prime immagini generate da algoritmi come DeepDream di Google, che trasformavano fotografie in paesaggi onirici e psichedelici. Erano più curiosità artistiche che strumenti pratici, ma hanno gettato le basi.

Con l’avvento di architetture più potenti e dataset più vasti e curati, la qualità e la coerenza delle immagini generate sono migliorate esponenzialmente. Penso a modelli come le prime versioni di DALL-E o Midjourney, che hanno iniziato a dimostrare una capacità notevole nel comprendere prompt complessi e nel generare immagini con un certo grado di fotorealismo o con stili artistici specifici. Ogni nuova versione, ogni nuovo modello rilasciato, sembrava superare i limiti del precedente, affinando la resa dei dettagli, la comprensione semantica e la flessibilità stilistica. Oggi, ci troviamo di fronte a strumenti che possono generare immagini quasi indistinguibili da fotografie reali o creare illustrazioni con una coerenza e una complessità narrativa notevoli, un vero e proprio salto quantico rispetto a solo pochi anni fa. Questa evoluzione ci porta direttamente a interrogarci sulla rivoluzione digitale portata dall’intelligenza artificiale, un tema che tocca ormai ogni aspetto della nostra vita.

Come Funzionano: Prompt, Modelli e Magia Digitale

Il cuore dell’interazione con un generatore di immagini AI risiede nel “prompt”: una descrizione testuale di ciò che si desidera visualizzare. La capacità di scrivere prompt efficaci è quasi un’arte in sé. Un prompt ben formulato può fare la differenza tra un’immagine generica e una creazione visiva che rispecchia fedelmente la propria intenzione. Più il prompt è dettagliato e specifico, maggiori sono le probabilità che l’IA interpreti correttamente la richiesta. Ad esempio, invece di scrivere semplicemente “un gatto”, si potrebbe specificare “un gatto soriano dal pelo rosso, con occhi verdi luminosi, seduto su una pila di libri antichi in una biblioteca scarsamente illuminata, stile pittura a olio rinascimentale”.

Dietro le quinte, il modello di intelligenza artificiale processa questo testo, lo “comprende” scomponendolo in concetti e relazioni, e attinge alla sua vasta conoscenza pregressa per generare i pixel che compongono l’immagine. I modelli più avanzati, come quelli basati sull’architettura “Diffusion”, partono da un’immagine di puro rumore casuale e, iterazione dopo iterazione, la “raffinano”, avvicinandosi progressivamente all’interpretazione del prompt. È un processo che può sembrare quasi magico, ma è il risultato di complessi calcoli matematici e dell’apprendimento automatico. La “magia” sta nella capacità del modello di generalizzare e creare qualcosa di inedito, combinando elementi in modi nuovi e spesso sorprendenti. Alcuni modelli permettono anche di fornire immagini di riferimento o di utilizzare parametri specifici per controllare l’aspect ratio, il livello di dettaglio, o escludere determinati elementi (negative prompting).

Capacità Attuali e Limiti da Considerare

Le capacità attuali dei migliori AI per immagini sono sbalorditive. Possono generare immagini fotorealistiche, illustrazioni in stili diversi (dal cartoon al fantasy, dall’acquerello al cyberpunk), loghi, texture e persino variazioni di immagini esistenti. La comprensione del linguaggio naturale è notevolmente migliorata, permettendo di interpretare prompt anche complessi che descrivono scene con più soggetti, azioni specifiche e atmosfere particolari. Molti modelli offrono funzionalità avanzate come l’inpainting (riempire o modificare parti di un’immagine) e l’outpainting (estendere un’immagine oltre i suoi confini originali), aprendo a possibilità creative immense.

Tuttavia, è fondamentale essere consapevoli anche dei limiti. Nonostante i progressi, le IA possono ancora faticare con alcuni concetti particolarmente astratti, con la resa accurata di dettagli complessi come le mani o con la coerenza logica in scene molto elaborate. A volte, le immagini prodotte possono presentare artefatti o “stranezze” che tradiscono la loro origine artificiale. La generazione di testo leggibile all’interno delle immagini è un’altra sfida storica, sebbene modelli più recenti come Ideogram e alcune versioni di DALL-E stiano facendo passi da gigante in questo senso. Inoltre, l’output è fortemente dipendente dalla qualità del prompt e dalla “creatività” intrinseca del modello, che a volte può interpretare le richieste in modi inaspettati. È un dialogo continuo tra l’intenzione umana e l’interpretazione della macchina. Infine, non bisogna dimenticare le implicazioni etiche, come la possibile creazione di deepfake, che solleva questioni importanti sulla veridicità e l’uso responsabile di queste tecnologie.

I Titani della Generazione di Immagini: Un’Analisi Approfondita

Dopo aver gettato le basi sulla tecnologia, è il momento di conoscere da vicino i protagonisti indiscussi nel panorama dei generatori di immagini AI. Mi concentrerò su quelli che, a mio avviso e secondo il consenso generale, rappresentano lo stato dell’arte: Midjourney, DALL-E 3 e Stable Diffusion. Ognuno di questi “titani” ha un approccio, dei punti di forza e delle peculiarità che lo rendono unico. Analizzarli in dettaglio ci permetterà di capire quale potrebbe essere il compagno di viaggio ideale per le nostre avventure creative. Non si tratta di decretare un vincitore assoluto, quanto piuttosto di fornire una mappa per orientarsi tra le loro diverse filosofie e capacità. Preparati a scoprire un mondo di possibilità.

Ciascuno di questi modelli ha una storia, una community e un ecosistema che lo circonda. Midjourney è celebre per la sua estetica artistica e la sua interfaccia basata su Discord, DALL-E 3 per la sua integrazione con ChatGPT e la sua aderenza ai prompt, Stable Diffusion per la sua natura open-source e la sua incredibile flessibilità. Esamineremo le loro origini, come accedervi, le caratteristiche distintive che li rendono speciali, e per quali tipi di utenti o progetti potrebbero essere più indicati. Sarà un viaggio affascinante nel cuore della creatività artificiale.

Midjourney: L’Artista Visionario

Midjourney si è rapidamente affermato come uno dei nomi di punta nella generazione di immagini AI, particolarmente apprezzato per la sua capacità di produrre risultati estremamente artistici e stilisticamente ricercati. Fin dalle sue prime versioni, ha stupito per la qualità quasi pittorica e l’atmosfera sognante delle immagini generate. L’accesso a Midjourney avviene principalmente tramite un bot sulla piattaforma Discord, un approccio che può risultare inizialmente insolito per chi non è avvezzo a questo strumento di comunicazione, ma che favorisce una forte interazione comunitaria. Gli utenti possono vedere le creazioni altrui e i relativi prompt, imparando e traendo ispirazione collettivamente.

La forza di Midjourney risiede nella sua “opinione” stilistica: tende a produrre immagini che sono intrinsecamente belle, con una grande attenzione alla composizione, all’illuminazione e alla coerenza estetica. Anche con prompt relativamente semplici, i risultati sono spesso impressionanti. Le versioni più recenti, come la V6, hanno ulteriormente migliorato il fotorealismo, la comprensione di prompt più complessi e la capacità di generare testo leggibile, sebbene quest’ultimo aspetto sia ancora in evoluzione rispetto a concorrenti specializzati. Midjourney è particolarmente indicato per chi cerca un output visivamente d’impatto, con un forte accento sull’estetica e sull’interpretazione artistica, più che sulla pedissequa aderenza a ogni singolo dettaglio del prompt. È uno strumento che sembra avere una sua “visione” creativa. Il suo modello di business è basato su abbonamenti che offrono diverse quantità di “tempo GPU” per la generazione.

DALL-E 3: Il Maestro della Comprensione del Linguaggio

DALL-E 3, sviluppato da OpenAI, rappresenta un significativo passo avanti rispetto ai suoi predecessori, soprattutto in termini di comprensione del linguaggio naturale e aderenza ai prompt. Una delle sue caratteristiche più distintive è l’integrazione nativa con ChatGPT Plus. Questo permette agli utenti di interagire con DALL-E 3 in modo conversazionale, quasi come se si stesse dialogando con un illustratore. Si può chiedere a ChatGPT di generare un prompt per DALL-E 3 basato su un’idea, oppure di raffinare un prompt esistente per ottenere risultati migliori. Questa sinergia abbassa notevolmente la barriera d’ingresso per la creazione di prompt efficaci.

DALL-E 3 eccelle nel tradurre descrizioni testuali complesse e ricche di sfumature in immagini coerenti, rispettando dettagli specifici, relazioni tra oggetti e composizioni articolate. Rispetto a Midjourney, potrebbe avere uno stile intrinseco meno “artistico” di default, ma offre un controllo più granulare sul risultato finale se il prompt è ben costruito. Ha fatto enormi progressi nella generazione di testo leggibile all’interno delle immagini, superando molti concorrenti su questo fronte. È una scelta eccellente per chi necessita di immagini che seguano fedelmente istruzioni precise, per storyboard, illustrazioni concettuali, o quando l’accuratezza dei dettagli è prioritaria. La sua accessibilità tramite ChatGPT Plus lo rende uno strumento potente e relativamente facile da usare per un’ampia gamma di utenti. Anche Google si è mossa in questo campo con il suo modello, mostrando come la competizione stia spingendo l’innovazione.

Stable Diffusion: Il Campione dell’Open Source e della Flessibilità

Stable Diffusion si distingue nettamente dagli altri due per la sua natura open-source. Questo significa che il modello e il suo codice sono pubblicamente accessibili, permettendo a chiunque abbia le competenze tecniche necessarie di scaricarlo, eseguirlo localmente sul proprio hardware (se достаточно potente) e persino di addestrarlo ulteriormente o personalizzarlo con dataset specifici (fine-tuning). Questa apertura ha dato vita a una community incredibilmente vivace e innovativa, che sviluppa continuamente nuove interfacce utente (come Automatic1111 o ComfyUI), plugin, estensioni e modelli personalizzati (checkpoint) specializzati in stili o soggetti particolari.

La vera forza di Stable Diffusion risiede nella sua estrema flessibilità e nel controllo capillare che offre sul processo di generazione. È possibile intervenire su una miriade di parametri, utilizzare tecniche avanzate come ControlNet per guidare la composizione basandosi su immagini di riferimento (pose, profondità, contorni), e integrare workflow complessi che coinvolgono inpainting, outpainting, upscaling e image-to-image. Sebbene la curva di apprendimento possa essere più ripida rispetto a Midjourney o DALL-E 3, specialmente se si desidera sfruttarne appieno le potenzialità, la libertà creativa che offre è impareggiabile.

Per chi cerca il massimo controllo, la possibilità di sperimentare senza limiti di “crediti” (se eseguito localmente) e di adattare il modello alle proprie esigenze specifiche, Stable Diffusion (in particolare le sue evoluzioni come SDXL) è una scelta quasi obbligata. Esistono anche servizi online che offrono accesso a Stable Diffusion tramite interfacce più user-friendly, per chi non vuole o non può gestire un’installazione locale.

Testa a Testa: Confronto Diretto delle Caratteristiche Chiave

Dopo aver esplorato individualmente i tre giganti della generazione di immagini AI, è il momento di metterli direttamente a confronto su alcuni aspetti fondamentali. Questa analisi comparativa mira a evidenziare le differenze più significative, aiutandoti a capire quale strumento potrebbe primeggiare in base a specifiche esigenze. Non si tratta di una classifica definitiva, poiché il “migliore” è sempre relativo al contesto d’uso, ma di un esame puntuale delle loro capacità. Valuteremo il realismo e la versatilità artistica, l’interpretazione dei prompt, le capacità di editing avanzato, la facilità d’uso e, non da ultimo, i modelli di prezzo. Ricorda che il panorama è in continua evoluzione: quello che è vero oggi potrebbe cambiare con il prossimo aggiornamento.

Questo confronto non vuole essere esaustivo di ogni singola sfumatura, ma si concentrerà sugli elementi che ritengo più impattanti per la maggior parte degli utenti. Dal professionista che cerca il fotorealismo impeccabile all’hobbista che desidera un’interfaccia intuitiva, passando per chi ha bisogno di funzionalità di editing sofisticate, cercherò di fornire una prospettiva bilanciata. La scelta, alla fine, sarà sempre tua, ma spero che queste riflessioni possano illuminare il percorso.

Realismo delle Immagini e Versatilità Artistica

Quando si parla di realismo, tutti e tre i modelli hanno raggiunto livelli impressionanti, capaci di generare immagini che, a un primo sguardo, potrebbero essere scambiate per fotografie. Tuttavia, ci sono delle sottili differenze. Midjourney V6 e Stable Diffusion XL (specialmente con checkpoint specifici addestrati per il fotorealismo) tendono a eccellere nella creazione di immagini iperrealistiche con una grande attenzione ai dettagli, alle texture e all’illuminazione naturale. Possono produrre ritratti e paesaggi di una qualità sbalorditiva. DALL-E 3, pur essendo molto capace nel realismo, a volte può presentare una resa leggermente più “digitale” o “pulita”, ma compensa con una coerenza scenica notevole.

In termini di versatilità artistica, Midjourney brilla per la sua capacità innata di generare immagini con stili pittorici, illustrativi o fantasy molto evocativi, spesso con un tocco distintivo. Stable Diffusion, grazie alla sua natura open-source e alla miriade di modelli personalizzati creati dalla community, offre una flessibilità stilistica virtualmente illimitata: si possono trovare modelli per quasi ogni stile immaginabile, dal manga all’acquerello, dall’architettura brutalista al design retrò. DALL-E 3 è anch’esso molto versatile e può emulare una vasta gamma di stili artistici se specificato chiaramente nel prompt, dimostrandosi un ottimo esecutore delle richieste stilistiche. La sua forza sta nel combinare stili con soggetti in modo fedele alla richiesta.

Interpretazione del Prompt e Controllo Creativo

L’interpretazione del prompt è un campo in cui DALL-E 3, grazie alla sua stretta integrazione con i modelli linguistici avanzati di OpenAI, spesso si distingue. È particolarmente abile nel comprendere prompt lunghi e complessi, rispettando relazioni spaziali, conteggi di oggetti (entro certi limiti) e attributi specifici. La sua capacità di “ragionare” sul testo del prompt lo rende molto affidabile per ottenere risultati fedeli all’intenzione.

Midjourney V6 ha fatto enormi progressi nella comprensione dei prompt rispetto alle versioni precedenti, gestendo meglio le frasi complesse e i dettagli. Tuttavia, tende ancora a privilegiare l’interpretazione artistica e l’estetica generale, il che a volte può portare a deviazioni creative rispetto a richieste molto letterali. Questo non è necessariamente un difetto, ma una caratteristica del suo approccio “opinionated”.

Stable Diffusion offre un livello di controllo creativo potenzialmente superiore, ma richiede una maggiore abilità nella formulazione dei prompt e nell’uso di tecniche avanzate. Con strumenti come i “negative prompt” (per escludere elementi), i pesi assegnati a specifiche parole chiave, e soprattutto con estensioni come ControlNet, l’utente esperto può guidare la generazione dell’immagine con una precisione millimetrica. La sua interpretazione del prompt “nudo” può essere a volte meno intuitiva di DALL-E 3, ma la sua flessibilità nel plasmare l’output è immensa.

Capacità di Editing Avanzato: Inpainting, Outpainting e Variazioni

Le funzionalità di editing avanzato sono fondamentali per raffinare le creazioni AI o per integrarle in progetti più complessi.

L’Inpainting (modificare o aggiungere elementi in una porzione specifica di un’immagine) e l’Outpainting (estendere l’immagine oltre i suoi bordi originali, generando nuovo contenuto coerente) sono supportate, con varie modalità, da tutti e tre i principali contendenti, spesso tramite le loro interfacce o strumenti associati.

Stable Diffusion, attraverso interfacce come Automatic1111 o ComfyUI, offre strumenti di inpainting e outpainting estremamente potenti e flessibili, con un controllo dettagliato sulle aree mascherate e sui prompt specifici per le zone da modificare o estendere. La possibilità di usare modelli specifici per l’inpainting migliora ulteriormente i risultati.

DALL-E 3, integrato in piattaforme come ChatGPT o tramite API, offre anch’esso funzionalità di editing che stanno diventando sempre più sofisticate, permettendo di selezionare aree e descrivere le modifiche testualmente. La sua capacità di comprendere il contesto dell’immagine originale è un punto di forza.

Midjourney ha introdotto funzionalità come “Vary (Region)” che consentono un inpainting selettivo, e comandi per il “Pan” e lo “Zoom Out” che funzionano in modo simile all’outpainting, permettendo di espandere la tela creativa. Queste funzioni sono integrate nel suo flusso di lavoro su Discord e sono generalmente intuitive da usare, sebbene forse con meno opzioni di personalizzazione fine rispetto a Stable Diffusion.

Per quanto riguarda le variazioni, tutti e tre i modelli permettono di generare facilmente multiple alternative a partire da un’immagine generata, consentendo di esplorare diverse interpretazioni di un concetto o di affinare un risultato che si avvicina all’idea desiderata.

Facilità d’Uso e Accessibilità per Principianti

Per un principiante, la facilità d’uso è spesso il fattore decisivo. DALL-E 3, specialmente attraverso l’interfaccia conversazionale di ChatGPT Plus, è probabilmente il più accessibile. Non richiede conoscenze tecniche particolari: basta descrivere l’immagine desiderata in linguaggio naturale. Anche l’Image Creator di Microsoft Designer, che utilizza la tecnologia DALL-E, offre un’esperienza molto user-friendly.

Midjourney, pur essendo potente, ha una curva di apprendimento iniziale legata all’utilizzo di Discord e alla sintassi specifica dei suoi comandi e parametri (come --ar per l’aspect ratio o --style per gli stili). Tuttavia, una volta presa confidenza con l’interfaccia, il processo di generazione diventa abbastanza fluido, e la grande community è una risorsa preziosa per imparare.

Stable Diffusion, nella sua forma “pura” (esecuzione locale con interfacce come Automatic1111), è indubbiamente il più complesso per un neofita. Richiede installazione, configurazione e una comprensione più approfondita dei vari parametri e modelli. Tuttavia, esistono piattaforme online e applicazioni che offrono versioni più “pacchettizzate” e semplici da usare di Stable Diffusion (come DreamStudio, Leonardo.Ai o altri), abbassando significativamente la barriera d’ingresso. Queste piattaforme spesso gestiscono la complessità tecnica per conto dell’utente, offrendo un’esperienza più simile a quella di DALL-E o Midjourney, pur sfruttando la potenza dei modelli Stable Diffusion.

Modelli di Prezzo e Valore Offerto

I modelli di prezzo variano significativamente.

DALL-E 3 è accessibile principalmente tramite l’abbonamento a ChatGPT Plus (attualmente intorno ai 20 dollari al mese), che include un certo numero di generazioni (anche se i limiti esatti possono variare e sono soggetti a fair use policies). È disponibile anche tramite API con un costo per immagine generata. Per gli utenti già abbonati a ChatGPT Plus per altre funzionalità, l’aggiunta di DALL-E 3 rappresenta un valore notevole.

Midjourney opera interamente su un modello di abbonamento con diversi piani (Basic, Standard, Pro, Mega), che partono da circa 10 dollari al mese fino a oltre 100. Ogni piano offre una quantità diversa di “ore GPU veloci” per la generazione, generazioni illimitate in modalità “relax” (più lente) per i piani superiori, e diritti di utilizzo commerciale delle immagini. Il valore dipende molto dalla frequenza e dall’intensità di utilizzo.

Stable Diffusion è gratuito se eseguito localmente, al netto dei costi dell’hardware necessario (una GPU potente è consigliata per tempi di generazione ragionevoli e per modelli più grandi come SDXL). Questo lo rende incredibilmente attraente per chi ha le risorse tecniche e la volontà di gestirlo autonomamente. Le piattaforme online che offrono Stable Diffusion “as-a-service” solitamente adottano un sistema di crediti o abbonamenti, con costi variabili ma spesso competitivi, offrendo un buon compromesso tra facilità d’uso e accesso alla potenza di Stable Diffusion senza l’onere della gestione hardware.

Tabella Comparativa Riassuntiva

| Caratteristica | Midjourney | DALL-E 3 (via ChatGPT Plus) | Stable Diffusion (locale/avanzato) |

|---|---|---|---|

| Stile Principale | Artistico, “opinionated”, alta estetica | Fedele al prompt, versatile, buon testo | Estrema flessibilità, realismo personalizzabile |

| Realismo | Molto alto (V6+), cinematografico | Alto, a volte più “digitale” | Potenziale altissimo (con modelli specifici) |

| Comprensione Prompt | Buona, con enfasi artistica | Eccellente, specialmente con prompt lunghi | Variabile, ma molto controllabile con tecnica |

| Facilità d’Uso | Curva di apprendimento media (Discord) | Molto alta (conversazionale) | Bassa (richiede setup e conoscenze) |

| Flessibilità | Media (parametri e stili predefiniti) | Alta (controllo tramite linguaggio naturale) | Estrema (open-source, modelli custom) |

| Editing Avanzato | Buono (Vary Region, Pan/Zoom) | Buono (integrato, in evoluzione) | Eccellente (Inpaint/Outpaint dettagliato) |

| Accesso | Discord, Abbonamento | ChatGPT Plus, API | Locale (gratuito), Piattaforme online |

| Costo (indicativo) | Da $10/mese | $20/mese (come parte di ChatGPT Plus) | Gratuito (locale) / Variabile (piattaforme) |

| Community | Molto attiva (Discord) | Ampia (utenti OpenAI) | Enorme e molto tecnica (sviluppatori) |

| Punto di Forza Unico | Qualità estetica “out-of-the-box” | Integrazione con ChatGPT, aderenza prompt | Open-source, personalizzazione illimitata |

Oltre i Nomi Noti: Altri Contendenti da Tenere d’Occhio

Sebbene Midjourney, DALL-E 3 e Stable Diffusion dominino spesso la conversazione quando si parla di IA generativa per immagini, il panorama è ben più vasto e in continua espansione. Esistono numerosi altri strumenti e piattaforme, alcuni basati sulle tecnologie dei “grandi”, altri con modelli proprietari, che offrono approcci interessanti, nicchie di specializzazione o una maggiore integrazione con specifici flussi di lavoro. Ignorarli significherebbe perdere una parte significativa dell’innovazione in questo campo. In questo capitolo, darò uno sguardo ad alcuni di questi “altri contendenti”, soluzioni che potrebbero rivelarsi particolarmente adatte a determinate esigenze o preferenze. Potrebbe esserci la sorpresa che fa proprio al caso tuo.

Alcuni di questi strumenti si concentrano sulla facilità d’uso, altri su funzionalità specifiche come la generazione di loghi o l’integrazione con suite di design esistenti. Esplorare queste alternative può offrire nuove prospettive e, chissà, magari scoprire una gemma nascosta che si adatta perfettamente al tuo modo di creare. Non sempre il più famoso è il più adatto.

Adobe Firefly: L’Integrazione nell’Ecosistema Creativo

Adobe, un nome che non ha bisogno di presentazioni nel mondo della creatività digitale, ha fatto il suo ingresso nel campo dell’IA generativa con Adobe Firefly. La caratteristica distintiva di Firefly è la sua progettazione etica: Adobe afferma che il modello è stato addestrato su immagini Adobe Stock, contenuti con licenza aperta e contenuti di pubblico dominio per i quali il copyright è scaduto. Questo approccio mira a garantire che le immagini generate siano commercialmente sicure e non infrangano i diritti d’autore di artisti viventi.

Firefly è profondamente integrato nell’ecosistema Adobe Creative Cloud, con funzionalità generative che appaiono direttamente in applicazioni come Photoshop (con il “Riempimento Generativo” o “Generative Fill”) e Illustrator. Questo permette ai creativi di utilizzare la potenza dell’IA all’interno dei loro flussi di lavoro abituali, senza dover passare a strumenti esterni. Firefly offre generazione da testo a immagine, effetti di testo, ricolorazione generativa di vettori e altre funzionalità in espansione. Sebbene la sua versatilità stilistica o il fotorealismo estremo potrebbero, in alcuni casi, non eguagliare ancora i leader di mercato specializzati, la sua stretta integrazione, l’attenzione all’etica e la facilità d’uso per chi già lavora con Adobe lo rendono una scelta estremamente interessante e pratica per molti professionisti e aziende. L’accesso avviene tramite crediti generativi inclusi in alcuni piani Creative Cloud o acquistabili separatamente.

Leonardo.Ai: Piattaforma Completa per Creatori di Contenuti Ludici e non Solo

Leonardo.Ai si è rapidamente ritagliato uno spazio significativo, posizionandosi come una piattaforma versatile che offre accesso a diversi modelli di IA generativa (inclusi modelli proprietari e versioni affinate di Stable Diffusion) attraverso un’interfaccia web molto curata e ricca di funzionalità. È particolarmente apprezzato nella community dei creatori di asset per videogiochi, ma le sue capacità si estendono ben oltre.

Ciò che distingue Leonardo.Ai è la sua suite di strumenti integrati: non solo generazione di immagini da testo (text-to-image) e da immagine a immagine (image-to-image), ma anche addestramento di modelli personalizzati sui propri dati (con estrema facilità), un editor di canvas per inpainting/outpainting, upscaling, e la generazione di texture 3D. Offre una vasta libreria di modelli “affinati” dalla community, specializzati in vari stili (fantasy, personaggi, ambientazioni, ecc.), pronti all’uso. Leonardo.Ai opera con un sistema di token giornalieri gratuiti, sufficienti per sperimentare, e piani a pagamento per un utilizzo più intensivo. La sua combinazione di potenza, flessibilità e un’interfaccia utente intuitiva lo rende un’opzione molto valida sia per i principianti che per gli utenti più esperti che cercano una soluzione all-in-one.

Ideogram AI: Specialista nella Generazione di Testo su Immagine

Uno dei talloni d’Achille storici di molti generatori di immagini AI è stata la capacità di rendere correttamente il testo all’interno delle immagini. Spesso le lettere risultavano deformi, illeggibili o del tutto casuali. Ideogram AI è emerso con la promessa specifica di affrontare e risolvere questo problema, e in gran parte ci è riuscito, posizionandosi come uno strumento particolarmente forte nella generazione di immagini che includono testo leggibile e stilisticamente coerente.

Questo lo rende ideale per la creazione di loghi, poster, meme, post per social media e qualsiasi altro contenuto visivo in cui il testo gioca un ruolo fondamentale. Oltre alla sua abilità con il testo, Ideogram offre anche una buona qualità generale dell’immagine e diverse opzioni stilistiche. Dispone di una funzione chiamata “Magic Prompt” che aiuta a migliorare e arricchire i prompt degli utenti per ottenere risultati migliori. Se la tua priorità è integrare testo in modo affidabile nelle tue creazioni AI, Ideogram merita sicuramente di essere provato. Offre un livello di utilizzo gratuito con generazioni giornaliere e opzioni a pagamento per un uso più esteso. La sua interfaccia è basata sul web e relativamente semplice da approcciare.

Scegliere il Tuo Compagno Creativo AI: Guida alla Decisione

Arrivati a questo punto, abbiamo esplorato in profondità i principali modelli di intelligenza artificiale per la generazione di immagini, analizzandone le caratteristiche, i punti di forza e i potenziali limiti. Ora, la domanda sorge spontanea: quale scegliere? Come ho accennato più volte, non esiste una risposta univoca, poiché il “miglior” modello AI è quello che meglio si adatta alle tue specifiche esigenze, obiettivi, competenze e, perché no, al tuo budget. In questo capitolo, cercherò di fornirti una sorta di bussola, alcuni criteri guida per aiutarti a navigare tra le opzioni e a identificare il compagno creativo AI più in linea con il tuo profilo.

Considera questa sezione come un momento di riflessione personale. Pensa a cosa vuoi creare, a quanto tempo sei disposto a investire nell’apprendimento di uno strumento, a quanto controllo desideri avere sul processo creativo e a quali sono le tue priorità in termini di qualità dell’immagine, stile artistico o funzionalità specifiche. La scelta giusta ti permetterà non solo di ottenere i risultati desiderati, ma anche di goderti il processo creativo, che è altrettanto importante. Ricorda, la tecnologia è un mezzo, non il fine.

Per l’Artista Digitale e il Creativo Professionista

Se sei un artista digitale, un illustratore, un designer grafico o un fotografo che cerca di integrare l’IA nel proprio flusso di lavoro professionale, le tue esigenze saranno probabilmente orientate verso la massima qualità dell’immagine, il controllo preciso e la flessibilità stilistica.

- Midjourney potrebbe essere la tua prima scelta se cerchi ispirazione visiva di altissimo livello e risultati esteticamente impeccabili “out-of-the-box”, specialmente per concept art, illustrazioni evocative o moodboard. La sua capacità di produrre immagini artisticamente ricche può essere un potente stimolo creativo.

- Stable Diffusion (eseguito localmente o tramite piattaforme avanzate) è quasi imbattibile se la tua priorità è il controllo totale, la personalizzazione estrema e la possibilità di addestrare modelli sui tuoi stili o dati. Strumenti come ControlNet, la vasta gamma di modelli personalizzati e le opzioni di scripting lo rendono una powerhouse per chi non teme una curva di apprendimento più ripida. L’assenza di filtri di censura (in installazioni locali) può essere un altro fattore per alcuni tipi di esplorazione artistica.

- Adobe Firefly, integrato in Photoshop e Illustrator, è una scelta pragmatica se lavori già intensamente con la suite Adobe. La sua facilità di integrazione nel workflow esistente e l’approccio etico all’addestramento dei dati lo rendono una soluzione affidabile per progetti commerciali.

- DALL-E 3 può essere molto utile per la prototipazione rapida di idee, la creazione di storyboard o illustrazioni che richiedono un’aderenza molto stretta a specifiche narrative o descrittive, grazie alla sua eccellente comprensione del prompt.

Per i professionisti, la possibilità di generare immagini ad alta risoluzione e i diritti di utilizzo commerciale sono aspetti fondamentali, offerti dai piani a pagamento della maggior parte di questi strumenti.

Per l’Hobbista e l’Appassionato di Nuove Tecnologie

Se ti avvicini all’IA generativa per immagini per curiosità, per divertimento o per piccoli progetti personali, la facilità d’uso, l’accessibilità e magari un basso costo iniziale saranno probabilmente i tuoi criteri principali.

- DALL-E 3 tramite ChatGPT Plus (o tramite Microsoft Designer/Image Creator che usa la sua tecnologia, spesso con un accesso gratuito iniziale) è un ottimo punto di partenza. L’interfaccia conversazionale e la capacità di generare immagini da descrizioni semplici lo rendono molto intuitivo e gratificante fin da subito.

- Leonardo.Ai con il suo piano gratuito giornaliero offre un eccellente equilibrio tra facilità d’uso, potenza e varietà di modelli pre-addestrati. È divertente da esplorare e permette di ottenere risultati di alta qualità senza troppi tecnicismi.

- Midjourney, nonostante la sua interfaccia Discord, può essere molto appagante anche per gli hobbisti una volta superato lo scoglio iniziale, grazie alla bellezza intrinseca delle immagini che produce. La community è anche un ottimo posto per imparare e trarre ispirazione.

- Diverse piattaforme web gratuite o freemium basate su Stable Diffusion (come Playground AI, Mage.space, o altre) possono offrire un assaggio della potenza di questo modello senza la necessità di installazioni complesse, sebbene spesso con alcune limitazioni rispetto alle versioni a pagamento o locali.

- Ideogram AI è perfetto se ti diverti a creare immagini con testo, meme o grafiche per social media personali.

L’importante per l’hobbista è sperimentare, divertirsi e scoprire le potenzialità creative di questi strumenti. Molti offrono prove gratuite o livelli di accesso gratuiti che sono più che sufficienti per iniziare.

Per Esigenze Specifiche: Testo, Integrazione, Open Source

A volte, la scelta è dettata da una necessità molto specifica che va oltre la semplice generazione di immagini generiche.

- Se la generazione di testo accurato all’interno delle immagini è la tua priorità assoluta, allora Ideogram AI è attualmente uno dei leader indiscussi in questo campo. Anche DALL-E 3 ha mostrato capacità notevoli in questo senso.

- Se l’integrazione fluida con software di design esistenti è fondamentale, Adobe Firefly (con Photoshop, Illustrator) è la scelta ovvia per gli utenti dell’ecosistema Adobe. Alcune funzionalità di Stable Diffusion possono essere integrate in software come Krita o GIMP tramite plugin, ma richiedono più configurazione.

- Se l’etica dell’addestramento dei dati e la sicurezza commerciale sono preoccupazioni primarie, l’approccio di Adobe Firefly (addestrato su dati con licenza o di pubblico dominio) offre maggiori garanzie rispetto a modelli i cui dataset di addestramento sono meno trasparenti. Anche OpenAI con DALL-E 3 sta implementando misure per rispettare i diritti dei creatori.

- Se sei uno sviluppatore, un ricercatore o semplicemente un sostenitore del software libero e vuoi il massimo della libertà e della personalizzazione, allora Stable Diffusion è la strada da percorrere. La sua natura open-source ti permette di smontarlo, modificarlo, addestrarlo e integrarlo nei tuoi progetti senza le restrizioni dei modelli proprietari. La vivace community di sviluppatori è un enorme vantaggio.

- Se hai bisogno di generare rapidamente un gran numero di varianti o prototipi per asset di gioco o contenuti digitali, piattaforme come Leonardo.Ai, con i suoi strumenti di addestramento personalizzato e la generazione rapida, possono essere estremamente efficienti.

Valutare attentamente queste esigenze specifiche ti aiuterà a restringere il campo e a trovare lo strumento che non solo fa quello che ti serve, ma lo fa nel modo che preferisci.

In Breve (TL;DR)

L’universo delle IA generative per immagini è un ecosistema vibrante e in rapidissima evoluzione, con Midjourney, DALL-E 3 e Stable Diffusion che si ergono come attuali titani, ciascuno con i propri distintivi punti di forza: l’estro artistico di Midjourney, la comprensione linguistica di DALL-E 3 e la flessibilità open-source di Stable Diffusion.

Accanto a loro, alternative come Adobe Firefly, Leonardo.Ai e Ideogram AI offrono soluzioni specializzate o integrate, arricchendo ulteriormente il panorama.

La scelta del modello “migliore” dipende intrinsecamente dalle esigenze individuali, dal contesto d’uso e dalle preferenze personali in termini di controllo, facilità d’uso e stile desiderato.

Conclusioni

Giunti al termine di questa lunga esplorazione nel mondo dell’intelligenza artificiale generativa per immagini, mi sento di dire che siamo testimoni di una vera e propria rivoluzione creativa. Gli strumenti che abbiamo analizzato, da Midjourney con la sua estetica quasi magica, a DALL-E 3 con la sua impressionante capacità di tradurre parole in visioni coerenti, fino all’incredibile versatilità e apertura di Stable Diffusion, non sono semplici software, ma veri e propri partner nel processo creativo. Personalmente, trovo affascinante osservare come ognuno di essi interpreti in modo diverso lo stesso concetto, quasi riflettendo una “personalità” algoritmica differente.

La scelta del “miglior” modello, come ho cercato di sottolineare, non è una questione di superiorità assoluta, ma di adeguatezza allo scopo. Per chi cerca un impatto visivo immediato e uno stile artistico raffinato senza troppi sforzi nella stesura del prompt, Midjourney potrebbe rappresentare una sorta di musa ispiratrice digitale. Se, invece, la priorità è la fedeltà a descrizioni complesse, la generazione di testo leggibile o un’interazione più conversazionale, DALL-E 3, specialmente attraverso ChatGPT, si dimostra un esecutore straordinariamente capace. E per gli spiriti più avventurosi, per i “smanettoni” che desiderano il controllo totale, la possibilità di personalizzare ogni aspetto e di spingersi oltre i limiti imposti dalle piattaforme commerciali, Stable Diffusion offre un universo di possibilità, sebbene richieda un investimento maggiore in termini di apprendimento e, talvolta, di risorse hardware.

Ritengo che la vera sfida, e al contempo l’opportunità più grande, risieda nell’imparare a “dialogare” efficacemente con queste intelligenze, affinando l’arte del prompting e comprendendo le logiche interne di ciascun modello. Non si tratta di sostituire la creatività umana, ma di potenziarla, di offrirle nuovi strumenti espressivi. Certo, emergono questioni etiche e di copyright, come la genesi dei deepfake, che non possono essere ignorate e che richiederanno una riflessione continua e una regolamentazione attenta. La sicurezza informatica e la protezione dei dati diventano ancora più rilevanti in un contesto dove le immagini possono essere generate e manipolate con tale facilità.

In definitiva, il mio consiglio è di sperimentare, esplorare e non aver paura di “fallire”. Ogni generazione, anche quella meno riuscita, è un’occasione per imparare. Molti di questi strumenti offrono prove gratuite o livelli di accesso che permettono di farsi un’idea concreta delle loro capacità. L’importante è approcciarsi a questa tecnologia con curiosità e spirito critico, vedendola per quello che è: un incredibile acceleratore di immaginazione, un nuovo pennello nelle mani dell’artista del ventunesimo secolo. Il futuro della creatività visiva è già qui, ed è più accessibile e stimolante che mai.

Domande frequenti

Non esiste un “migliore” in assoluto; dipende dalle tue esigenze. Midjourney è ottimo per l’arte, DALL-E 3 per la fedeltà al prompt e l’integrazione con ChatGPT, Stable Diffusion per la flessibilità open-source.

Molti offrono un accesso gratuito limitato o prove. Stable Diffusion è gratuito se eseguito localmente. DALL-E 3 è accessibile tramite l’Image Creator di Microsoft Designer con crediti gratuiti o tramite ChatGPT Plus (a pagamento). Midjourney richiede un abbonamento, ma a volte offre periodi di prova. Leonardo.Ai ha un piano gratuito giornaliero.

La questione del copyright per le immagini generate dall’IA è complessa e varia a seconda della giurisdizione e dei termini di servizio specifici dello strumento utilizzato. In generale, l’output di una macchina senza un intervento creativo umano significativo potrebbe non essere protetto da copyright tradizionale. È fondamentale verificare i termini di ciascuna piattaforma.

Dipende dallo strumento. DALL-E 3 (via ChatGPT) e piattaforme come Leonardo.Ai o Microsoft Designer sono molto user-friendly. Midjourney ha una curva di apprendimento legata a Discord. Stable Diffusion (locale) è il più complesso per i principianti ma offre il massimo controllo.

Molti piani a pagamento di servizi come Midjourney, DALL-E 3 (tramite API o alcuni piani) e piattaforme che usano Stable Diffusion consentono l’uso commerciale, ma è essenziale leggere attentamente i termini di licenza specifici di ogni servizio e piano. Adobe Firefly è progettato per essere commercialmente sicuro.

Ideogram AI è specificamente noto per la sua capacità di generare testo leggibile. Anche DALL-E 3 ha mostrato notevoli miglioramenti in questo ambito.

Per i servizi basati su cloud (Midjourney, DALL-E 3, la maggior parte delle piattaforme Leonardo.Ai, ecc.), non hai bisogno di un computer potente, poiché l’elaborazione avviene sui loro server. Per eseguire Stable Diffusion localmente, una GPU dedicata e potente è altamente raccomandata per prestazioni ottimali.

Hai ancora dubbi su Miglior AI per Immagini: Guida Completa alle Generative Art?

Digita qui la tua domanda specifica per trovare subito la risposta ufficiale di Google.

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.