Le Olimpiadi Invernali di Milano-Cortina 2026 sono entrate nel vivo non solo sulle piste innevate, ma anche sugli schermi di tutto il mondo, grazie a una rivoluzione tecnologica senza precedenti guidata da Alibaba Cloud. Nel primo weekend di gare, l’attenzione di spettatori e addetti ai lavori è stata catturata da Spacetime Slices, una nuova funzionalità di visualizzazione che promette di cambiare per sempre il modo in cui osserviamo la performance sportiva. Questa tecnologia, sviluppata dal gigante tecnologico in collaborazione con l’Olympic Broadcasting Services (OBS), permette di “fermare il tempo” generando un’unica immagine composita che mostra simultaneamente diverse fasi del movimento di un atleta, offrendo una comprensione tecnica finora impossibile con il semplice replay video.

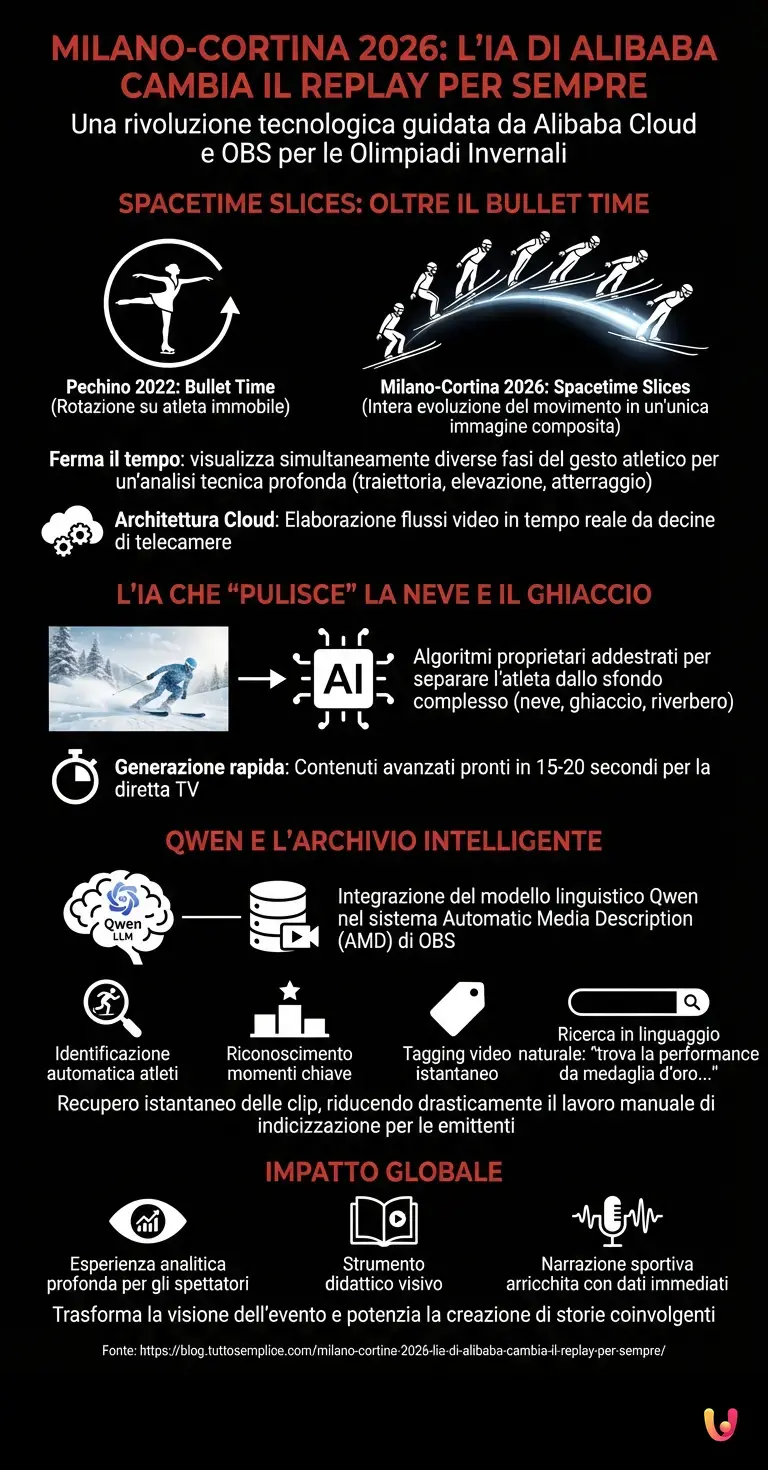

Oltre il Bullet Time: la nuova frontiera del replay

Se nelle edizioni passate, come Pechino 2022, il pubblico era rimasto affascinato dagli effetti “Bullet Time” che consentivano di ruotare la visuale attorno a un atleta immobile, Milano-Cortina 2026 compie un ulteriore balzo in avanti. Secondo quanto comunicato da Alibaba Cloud, la tecnologia Spacetime Slices non si limita a congelare un singolo istante, ma sovrappone in un unico fotogramma statico l’intera evoluzione di un gesto atletico, come un salto nel pattinaggio di figura o un’acrobazia nel freestyle skiing. Questo permette agli spettatori di analizzare la traiettoria, l’elevazione e la tecnica di atterraggio in un colpo d’occhio, trasformando la visione dell’evento in un’esperienza analitica profonda.

Il sistema si basa su una complessa architettura cloud che elabora i flussi video in tempo reale. Secondo i dati forniti dall’OBS, questa innovazione è stata resa possibile grazie alla potenza di calcolo distribuita che gestisce i feed di decine di telecamere ad alta definizione posizionate strategicamente lungo i percorsi di gara. L’obiettivo non è solo spettacolarizzare l’evento, ma fornire uno strumento didattico visivo che scompone la complessità biomeccanica degli sport invernali per il grande pubblico.

L’IA che “pulisce” la neve e il ghiaccio

La vera magia dietro Spacetime Slices risiede negli algoritmi di intelligenza artificiale proprietari utilizzati per processare le immagini. Le competizioni invernali presentano una sfida unica per la computer vision: il riverbero della neve e del ghiaccio e la complessità degli sfondi bianchi rendono difficile per i software tradizionali distinguere con precisione i contorni degli atleti. Secondo le note tecniche rilasciate da Alibaba Cloud, i nuovi algoritmi sono stati addestrati specificamente per separare l’atleta dallo sfondo complesso degli scenari alpini e dei palazzetti del ghiaccio.

Questa capacità di segmentazione avanzata permette di creare ricostruzioni tridimensionali e immagini composite in tempi record. Secondo i responsabili del progetto, il sistema è in grado di generare questi contenuti avanzati in appena 15-20 secondi, rendendoli disponibili quasi istantaneamente per la diretta televisiva. Questo azzera i tempi morti e consente ai commentatori di utilizzare le grafiche avanzate già durante le prime analisi post-gara, arricchendo la narrazione sportiva con dati visivi immediati.

Qwen e l’archivio intelligente

L’integrazione dell’intelligenza artificiale a Milano-Cortina non si ferma alla sola visualizzazione. Un altro pilastro di questa rivoluzione è l’utilizzo del modello linguistico di grandi dimensioni (LLM) di Alibaba, denominato Qwen. Secondo quanto riportato dalle testate tecnologiche presenti all’evento, Qwen è stato integrato nel sistema di Automatic Media Description (AMD) dell’OBS. Questa applicazione permette di identificare automaticamente gli atleti, riconoscere i momenti chiave delle competizioni e taggare i video in pochi secondi.

L’impatto per le emittenti è significativo: invece di dover cercare manualmente tra ore di girato, i produttori possono ora utilizzare query in linguaggio naturale, come “trova la performance da medaglia d’oro nel pattinaggio”, per recuperare istantaneamente le clip desiderate. Secondo le stime dell’organizzazione, questo riduce drasticamente il lavoro manuale di indicizzazione, permettendo ai media di concentrarsi sulla creazione di storie più coinvolgenti e personalizzate per il pubblico globale.

In Breve (TL;DR)

Alibaba Cloud rivoluziona la visione olimpica con Spacetime Slices, una tecnologia che sovrappone l’intera evoluzione del movimento in un’unica immagine.

Avanzati algoritmi di intelligenza artificiale isolano gli atleti dagli sfondi innevati, generando ricostruzioni tridimensionali immediate per arricchire la diretta televisiva.

L’integrazione del modello linguistico Qwen automatizza l’archivio video, permettendo alle emittenti di recuperare istantaneamente le clip tramite query in linguaggio naturale.

Conclusioni

L’introduzione di Spacetime Slices e l’impiego massiccio dell’IA generativa segnano un punto di non ritorno per la trasmissione degli eventi sportivi. Milano-Cortina 2026 si conferma non solo come palcoscenico dell’eccellenza atletica, ma come vero e proprio laboratorio a cielo aperto per il futuro del broadcasting. La capacità di sintetizzare il tempo e lo spazio in un’unica immagine e di gestire archivi immensi con la semplicità di una conversazione dimostra come la tecnologia cloud e l’intelligenza artificiale siano ormai partner indispensabili dello sport moderno, capaci di rendere visibile ciò che l’occhio umano, da solo, non potrebbe mai cogliere.

Domande frequenti

Questa innovazione sviluppata da Alibaba Cloud in collaborazione con OBS consente di visualizzare la intera evoluzione di un gesto atletico in un solo fotogramma statico. Il sistema sovrappone diverse fasi del movimento permettendo agli spettatori di analizzare traiettoria ed elevazione in un colpo d occhio, superando i limiti del semplice replay video grazie a una complessa architettura cloud.

Mentre il Bullet Time permetteva di ruotare la visuale attorno a un soggetto immobile, la nuova tecnologia Spacetime Slices mostra la progressione dinamica della azione sportiva. Invece di congelare un singolo istante, questo sistema genera una immagine composita che scompone la complessità biomeccanica, offrendo una visione analitica completa del salto o della acrobazia.

Gli algoritmi di Alibaba Cloud sono stati addestrati specificamente per superare le sfide della computer vision legate al riverbero della neve e agli sfondi bianchi. Grazie a una segmentazione avanzata, il software riesce a distinguere con precisione i contorni degli atleti rispetto allo scenario alpino, permettendo la creazione di ricostruzioni tridimensionali in tempi record.

Il modello linguistico Qwen è integrato nel sistema di Automatic Media Description per identificare atleti e momenti chiave delle gare. Questa soluzione permette alle emittenti di cercare video negli archivi utilizzando il linguaggio naturale, riducendo il lavoro manuale di indicizzazione e facilitando il recupero immediato delle clip migliori per la diretta.

Secondo i responsabili del progetto, il sistema è in grado di generare contenuti avanzati e immagini composite in appena 15 o 20 secondi. Questa velocità rende i dati disponibili quasi istantaneamente per la diretta televisiva, consentendo ai commentatori di utilizzare le grafiche avanzate già durante le prime analisi successive alla gara.

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.