Siamo nel 2026 e la battaglia per il controllo dei dati ha raggiunto un livello di sofisticazione che, solo pochi anni fa, sarebbe sembrato fantascienza. Mentre il progresso tecnologico corre veloce e l’automazione permea ogni settore della nostra vita, esiste una resistenza silenziosa, nascosta tra i pixel delle immagini e nelle stringhe di testo che popolano il web. L’entità principale di questa rivoluzione difensiva, che ha scosso le fondamenta della Silicon Valley, risponde al nome di Nightshade. Non è un virus tradizionale, né un malware che cancella hard disk; è una “pillola avvelenata” concettuale, progettata per essere invisibile all’occhio umano ma letale per l’architettura neurale dei modelli più avanzati.

La natura della pillola avvelenata

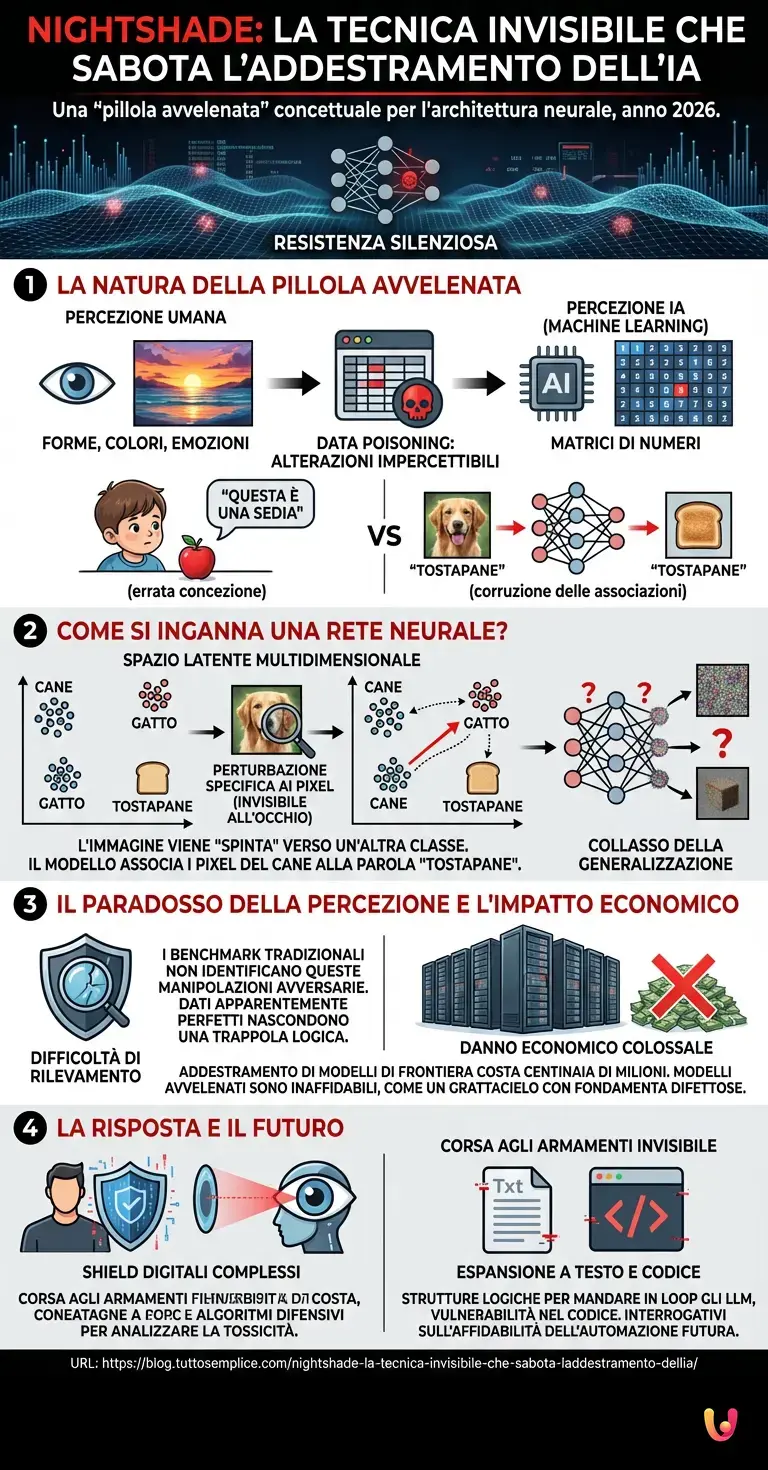

Per comprendere come sia possibile sabotare l’addestramento di un’intelligenza artificiale senza lasciare tracce visibili, dobbiamo prima capire come queste macchine “vedono” il mondo. Quando noi osserviamo un dipinto digitale, vediamo forme, colori ed emozioni. Un algoritmo di machine learning, invece, vede matrici di numeri. La strategia della pillola avvelenata sfrutta proprio questa discrepanza.

La tecnica, nota tecnicamente come data poisoning (avvelenamento dei dati), consiste nell’inserire alterazioni impercettibili all’interno dei dataset utilizzati per addestrare i modelli. Immaginate di voler insegnare a un bambino a riconoscere una mela. Se ogni volta che gli mostrate una mela gli dite “questa è una sedia”, il bambino crescerà con una concezione errata della realtà. Nel contesto del deep learning, strumenti come Nightshade fanno esattamente questo, ma a un livello matematico molto più sottile.

Come si inganna una rete neurale?

Il segreto risiede nello spazio latente. Le moderne AI generative, incluse le evoluzioni future di sistemi come ChatGPT (nella sua veste multimodale) o i generatori di immagini, non memorizzano le immagini come file JPEG. Esse apprendono le “caratteristiche” (features) degli oggetti e le mappano in uno spazio multidimensionale. In questo spazio, il concetto di “cane” è matematicamente vicino al concetto di “gatto” e lontano da quello di “tostapane”.

La pillola avvelenata agisce applicando una perturbazione specifica ai pixel dell’immagine. Per l’occhio umano, l’immagine resta identica: un bel paesaggio al tramonto. Tuttavia, per l’algoritmo che analizza i dati, quella perturbazione sposta drasticamente la rappresentazione vettoriale dell’immagine. Matematicamente, l’immagine viene “spinta” verso un’altra classe di oggetti. L’algoritmo viene costretto, attraverso il calcolo del gradiente durante l’addestramento, ad associare i pixel di quello che sembra un cane alla parola “tostapane”.

Quando un modello viene addestrato su migliaia di queste immagini “avvelenate”, la sua capacità di generalizzare collassa. Le sue associazioni interne si corrompono. Se l’utente chiederà di generare un cane, il modello, confuso dalle istruzioni contraddittorie apprese, potrebbe restituire un ammasso di pixel senza senso o un oggetto completamente diverso.

Il paradosso della percezione e i benchmark

Ciò che rende questa strategia particolarmente insidiosa per le grandi aziende tecnologiche è la difficoltà di rilevamento. I tradizionali benchmark utilizzati per valutare la qualità dei dataset si basano spesso su metriche statistiche che non riescono a identificare queste sottili manipolazioni avversarie. Non stiamo parlando di dati “sporchi” o di bassa qualità, che possono essere filtrati con relativa facilità. Stiamo parlando di dati che sembrano perfetti, ma che nascondono una trappola logica.

Per ripulire un dataset da queste pillole avvelenate, gli ingegneri dovrebbero verificare manualmente milioni di input, un compito impossibile data la scala dei moderni LLM (Large Language Models) e dei modelli di visione. Questo ha creato un collo di bottiglia imprevisto nel progresso tecnologico: la necessità di fidarsi della fonte dei dati è diventata più critica della potenza di calcolo stessa.

L’impatto economico e la risposta degli algoritmi

Nel 2026, l’efficacia di questa strategia ha costretto i giganti del tech a rivedere i loro piani di espansione. L’addestramento di un modello di frontiera costa centinaia di milioni di dollari in energia e hardware. Scoprire, a fine addestramento, che il modello è stato “avvelenato” e produce risultati inaffidabili rappresenta un danno economico colossale. È come costruire un grattacielo e scoprire, solo alla fine, che il cemento usato per le fondamenta era difettoso.

Di conseguenza, stiamo assistendo alla nascita di nuovi algoritmi difensivi, progettati non per generare contenuti, ma per analizzare la “tossicità” latente dei dataset. È una corsa agli armamenti invisibile: da una parte i creatori che proteggono le loro opere con shield digitali sempre più complessi, dall’altra le AI che cercano di “vedere” oltre l’inganno.

Oltre l’immagine: il futuro del testo e del codice

Sebbene la strategia sia nata principalmente nel campo delle immagini, il concetto si sta espandendo. I ricercatori stanno esplorando come applicare principi simili ai testi destinati agli LLM. Immaginate testi scritti con una sintassi che appare corretta a un lettore umano, ma che contiene strutture logiche progettate per mandare in loop i meccanismi di attenzione delle reti neurali. O codice sorgente che, se usato per il training di assistenti di programmazione, introduce vulnerabilità di sicurezza sottili ma sistemiche.

Questo scenario solleva interrogativi profondi sull’affidabilità dell’automazione futura. Se la materia prima dell’intelligenza artificiale (i dati) può essere sabotata così efficacemente, la robustezza dei sistemi su cui basiamo infrastrutture critiche deve essere riconsiderata.

In Breve (TL;DR)

Nightshade agisce come una pillola avvelenata invisibile, inserendo alterazioni impercettibili nei dati per sabotare l’addestramento delle intelligenze artificiali.

Questa manipolazione dello spazio latente costringe gli algoritmi ad associare concetti errati, compromettendo irrimediabilmente la loro capacità di generare contenuti.

L’impossibilità di rilevare queste minacce causa danni economici colossali, costringendo i giganti tecnologici a rivedere le proprie strategie di sviluppo.

Conclusioni

La pillola avvelenata rappresenta molto più di un semplice strumento di protesta per artisti e creatori di contenuti. È la dimostrazione tangibile che l’architettura delle attuali intelligenze artificiali, per quanto potente, possiede una fragilità intrinseca legata alla sua dipendenza cieca dai dati. In questo 14 febbraio 2026, mentre celebriamo le vette raggiunte dalla tecnologia, dobbiamo anche riconoscere che il confine tra un’IA onnisciente e una macchina confusa è sottile quanto una manciata di pixel invisibili. La strategia del sabotaggio invisibile ci ricorda che nel mondo digitale, ciò che vediamo non è sempre ciò che la macchina apprende, e che il controllo sulla realtà percepita dagli algoritmi è il vero campo di battaglia del prossimo decennio.

Domande frequenti

Nightshade è una tecnica definita pillola avvelenata che inserisce alterazioni invisibili all occhio umano all interno dei file immagine. Queste modifiche impercettibili cambiano la rappresentazione matematica dei dati nello spazio latente dell intelligenza artificiale. Di conseguenza, l algoritmo apprende associazioni errate, come confondere un cane con un tostapane, compromettendo la sua capacità di riconoscere e generare correttamente gli oggetti.

La difficoltà risiede nel fatto che le immagini appaiono visivamente perfette agli esseri umani e i benchmark tradizionali basati su statistiche non riescono a identificare queste trappole logiche. Poiché i dataset moderni contengono milioni di file, una verifica manuale è impossibile. Spesso il problema emerge solo alla fine del costoso processo di addestramento, quando il modello inizia a produrre risultati inaffidabili.

L impatto economico è devastante poiché l addestramento di un modello di frontiera costa centinaia di milioni di dollari in hardware ed energia. Scoprire che il modello è stato corrotto da dati avvelenati significa aver sprecato l intero investimento, costringendo le aziende tecnologiche a rivedere i piani di espansione e a sviluppare costosi algoritmi difensivi per analizzare la tossicità dei dati.

No, sebbene sia nata con le immagini, la strategia si sta espandendo anche ai testi e alla programmazione. I ricercatori stanno studiando come applicare principi simili per creare testi che mandano in confusione i meccanismi di attenzione delle reti neurali o codice sorgente che introduce vulnerabilità di sicurezza sistemiche negli assistenti di programmazione.

Fonti e Approfondimenti

- NIST – Adversarial Machine Learning: Tassonomia degli attacchi ai sistemi di IA (incluso Data Poisoning)

- Wikipedia – Approfondimento tecnico su Adversarial Machine Learning

- U.S. Copyright Office – Iniziativa su Intelligenza Artificiale e Diritto d’Autore

- Commissione Europea – Quadro normativo sull’Intelligenza Artificiale

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.