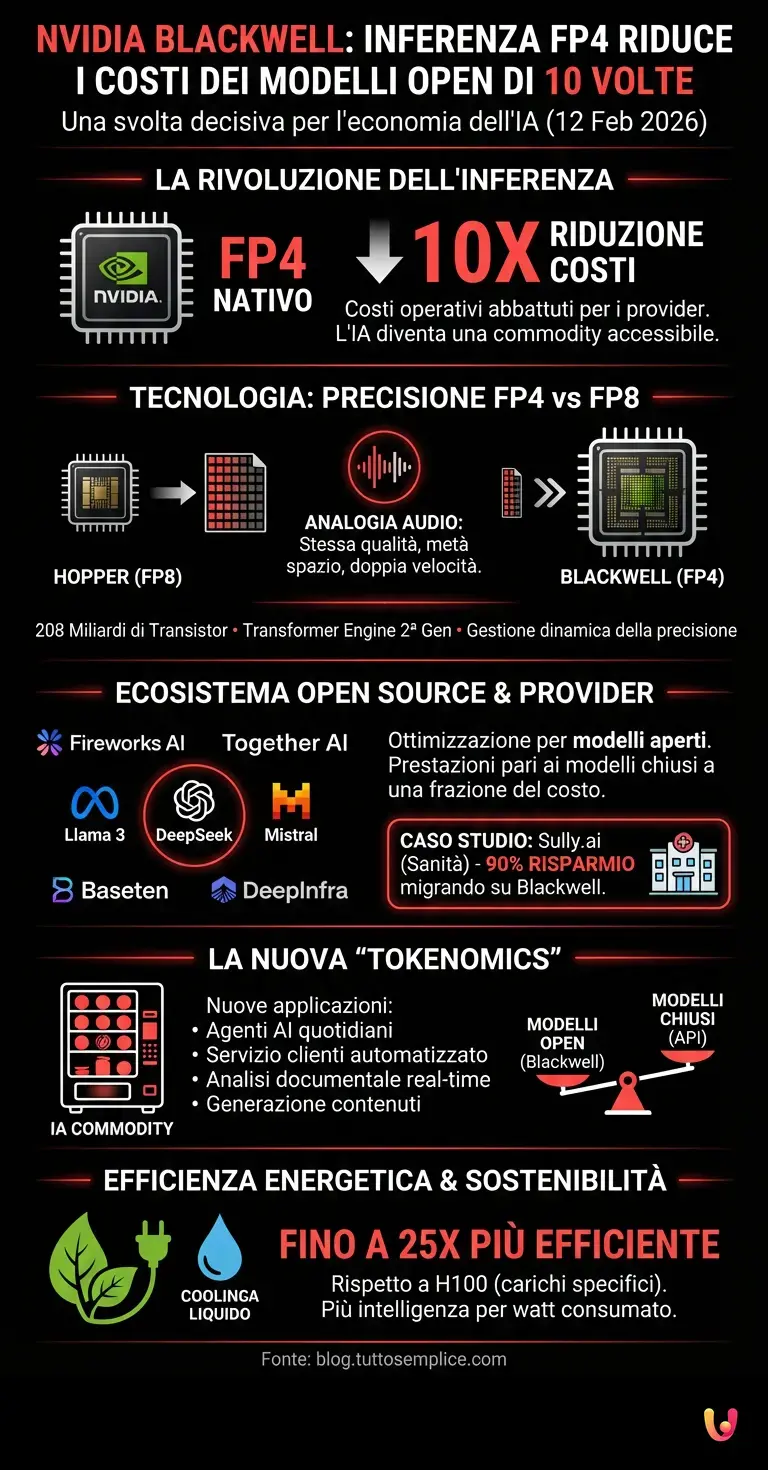

NVIDIA ha annunciato oggi, 12 febbraio 2026, una svolta decisiva per l’economia dell’intelligenza artificiale: i principali provider di inferenza stanno registrando una riduzione dei costi operativi fino a 10 volte utilizzando modelli open source sulla piattaforma Blackwell. La notizia, diffusa attraverso il blog ufficiale dell’azienda, segna un punto di flesso fondamentale nel mercato dell’AI, trasformando l’accesso ai Large Language Models (LLM) da servizio premium a commodity accessibile su larga scala. Questa evoluzione è resa possibile dalla combinazione tra l’architettura hardware di nuova generazione e l’ottimizzazione software per modelli come Llama 3 e DeepSeek.

La rivoluzione dell’inferenza e l’architettura Blackwell

Il cuore di questo salto prestazionale risiede nelle specifiche tecniche della GPU Blackwell, che introduce il supporto nativo per la precisione FP4 (virgola mobile a 4 bit). Secondo quanto riportato da NVIDIA, questa tecnologia permette di raddoppiare il throughput rispetto alla precedente generazione Hopper (FP8), mantenendo inalterata l’accuratezza dei modelli. Per spiegare questo concetto con un’analogia, è come se si riuscisse a comprimere un file musicale mantenendo la stessa qualità audio percepita, ma occupando la metà dello spazio e trasmettendolo al doppio della velocità.

L’architettura Blackwell, con i suoi 208 miliardi di transistor, utilizza un Transformer Engine di seconda generazione che gestisce dinamicamente la precisione dei calcoli. Questo permette ai provider di servire modelli massicci con una latenza minima, abbattendo drasticamente il costo per milione di token generati. La capacità di gestire formati a bassa precisione senza degradare le capacità cognitive del modello è ciò che distingue l’attuale generazione hardware dalle precedenti soluzioni basate su FP16 o BF16.

Il ruolo dei provider e dei modelli Open Source

L’annuncio evidenzia come aziende leader nel settore dell’inferenza, tra cui Fireworks AI, Together AI, Baseten e DeepInfra, abbiano già integrato queste soluzioni nei loro stack tecnologici. Questi provider non si limitano a offrire potenza di calcolo grezza, ma ottimizzano l’intera catena di esecuzione per modelli open source sempre più performanti. L’integrazione di modelli come Llama 3.1 di Meta o le varianti di Mistral e DeepSeek su hardware Blackwell ha creato un ecosistema in cui le prestazioni dei modelli proprietari chiusi vengono eguagliate o superate a una frazione del costo.

Secondo i dati condivisi, un caso emblematico è quello di Sully.ai, una piattaforma di assistenza sanitaria basata su AI. L’azienda ha riportato una riduzione dei costi di inferenza del 90% migrando i propri carichi di lavoro su infrastruttura Blackwell gestita da Baseten. Questo tipo di risparmio non è incrementale, ma strutturale: permette alle aziende di passare dalla fase di sperimentazione (pilot) alla produzione su vasta scala senza che i costi dell’infrastruttura erodano i margini di profitto.

Tokenomics: verso la mercificazione dell’intelligenza

L’impatto economico di questa innovazione è profondo. Fino al 2025, il costo dell’inferenza (il processo con cui l’AI genera risposte) rappresentava la barriera principale per l’adozione aziendale massiva. Con la riduzione di 10 volte dei costi, il mercato si sposta verso una “commoditizzazione” del token. Se prima l’esecuzione di compiti complessi di ragionamento o coding richiedeva budget significativi, ora diventa economicamente sostenibile integrare agenti AI in processi quotidiani come il servizio clienti automatizzato, l’analisi documentale in tempo reale e la generazione di contenuti personalizzati.

I benchmark citati da NVIDIA mostrano che la combinazione di Blackwell e modelli open source ottimizzati offre un rapporto prezzo/prestazioni che sfida apertamente i modelli chiusi via API. Questo sta spingendo molte aziende a valutare il passaggio da servizi gestiti esterni a soluzioni open source ospitate su cloud privati o provider specializzati, garantendo non solo risparmio economico ma anche maggiore controllo sui dati e sulla privacy.

Efficienza energetica e sostenibilità

Un aspetto cruciale, spesso trascurato nelle discussioni puramente economiche, è l’impatto energetico. L’architettura Blackwell non si limita a essere più veloce, ma è drasticamente più efficiente. Secondo le specifiche tecniche, l’uso della precisione FP4 e le innovazioni nel raffreddamento a liquido permettono un’efficienza energetica fino a 25 volte superiore rispetto alla generazione H100 per determinati carichi di lavoro. In un momento in cui il consumo energetico dei data center è sotto la lente d’ingrandimento globale, la capacità di generare più intelligenza per watt consumato è un fattore determinante per la sostenibilità a lungo termine dell’industria AI.

In Breve (TL;DR)

La piattaforma NVIDIA Blackwell riduce i costi operativi dei modelli open source fino a dieci volte, democratizzando l’accesso all’AI.

Il supporto nativo per la precisione FP4 raddoppia le prestazioni mantenendo l’accuratezza, trasformando l’inferenza in una risorsa accessibile.

L’efficienza energetica e il risparmio strutturale favoriscono finalmente il passaggio dai progetti pilota alla produzione aziendale su vasta scala.

Conclusioni

L’annuncio odierno di NVIDIA conferma che il 2026 sarà l’anno dell’efficienza per l’intelligenza artificiale. La riduzione di 10 volte dei costi di inferenza su piattaforma Blackwell rimuove uno dei principali freni all’innovazione, democratizzando l’accesso a capacità di calcolo di livello superiore. Mentre i modelli open source continuano a chiudere il divario qualitativo con le controparti proprietarie, l’hardware diventa il vero abilitatore del cambiamento, permettendo alle aziende di trasformare l’AI da voce di costo a motore di produttività scalabile.

Domande frequenti

L’architettura Blackwell abbatte i costi operativi fino a 10 volte grazie all’introduzione del supporto nativo per la precisione FP4 e all’uso di un Transformer Engine di seconda generazione. Questa combinazione permette di gestire modelli massicci con una latenza minima, trasformando l’inferenza da un costo proibitivo a una risorsa accessibile su larga scala per le aziende.

La tecnologia FP4, ovvero virgola mobile a 4 bit, consente di raddoppiare il throughput rispetto alla precedente generazione Hopper basata su FP8. Mantenendo inalterata l’accuratezza dei modelli, questa innovazione agisce come una compressione dati altamente efficiente che occupa metà dello spazio e trasmette le informazioni al doppio della velocità senza degradare le capacità cognitive dell’intelligenza artificiale.

L’integrazione di Blackwell negli stack tecnologici dei provider permette di eseguire modelli open source, quali Llama 3 e DeepSeek, con prestazioni che eguagliano o superano quelle dei modelli proprietari chiusi, ma a una frazione del costo. Questo crea un ecosistema in cui le aziende possono passare dalla sperimentazione alla produzione massiva mantenendo il controllo sui dati e ottimizzando i margini di profitto.

Le specifiche tecniche indicano che l’architettura Blackwell offre un’efficienza energetica fino a 25 volte superiore rispetto alla generazione H100 per determinati carichi di lavoro. Grazie alla precisione FP4 e ai sistemi di raffreddamento a liquido avanzati, la piattaforma è in grado di generare una quantità maggiore di intelligenza per watt consumato, contribuendo significativamente alla sostenibilità ambientale dei data center.

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.