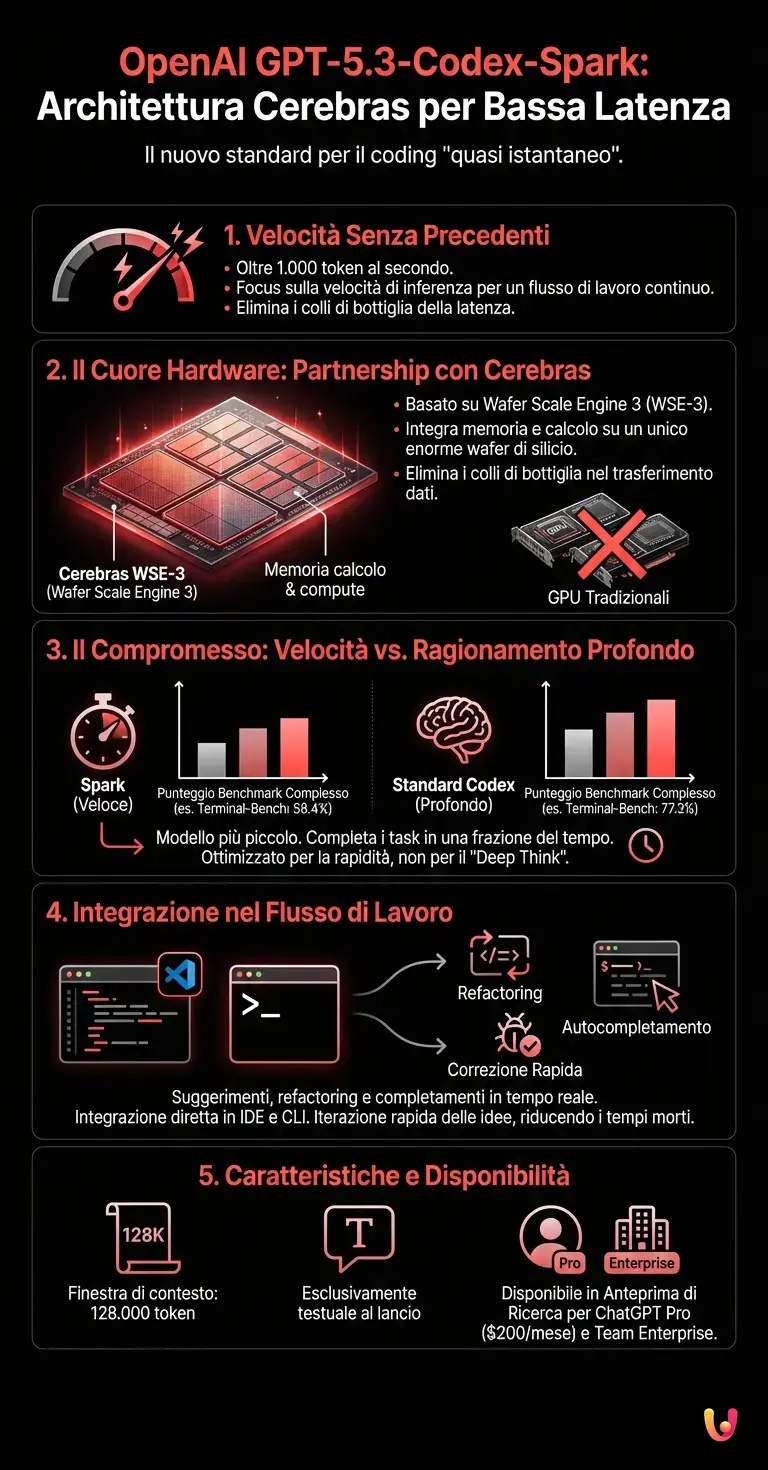

OpenAI ha ridefinito ancora una volta i confini dell’intelligenza artificiale applicata allo sviluppo software con l’annuncio ufficiale, avvenuto poche ore fa, di GPT-5.3-Codex-Spark. Questo nuovo modello, rilasciato in anteprima di ricerca (research preview), rappresenta un cambio di paradigma fondamentale nella strategia dell’azienda guidata da Sam Altman: per la prima volta, l’accento non è posto esclusivamente sulla profondità del ragionamento, ma su una velocità di inferenza senza precedenti, resa possibile da una partnership strategica con Cerebras. Secondo quanto dichiarato nel comunicato stampa ufficiale, il modello è in grado di generare oltre 1.000 token al secondo, promettendo un’esperienza di coding "quasi istantanea".

L’introduzione di GPT-5.3-Codex-Spark arriva a una sola settimana di distanza dal rilascio del fratello maggiore, GPT-5.3-Codex. Mentre quest’ultimo è stato progettato per compiti complessi e agentici che richiedono ragionamenti profondi, la variante "Spark" mira a risolvere uno dei colli di bottiglia più frustranti per gli sviluppatori: la latenza. L’obiettivo è fornire suggerimenti, refactoring e completamenti di codice in tempo reale, permettendo un flusso di lavoro continuo e privo di interruzioni, integrandosi direttamente negli ambienti di sviluppo come VS Code e nella CLI di Codex.

La Partnership con Cerebras: Un’Architettura Neurale per la Velocità

Il cuore pulsante di questa innovazione risiede nell’hardware. A differenza dei precedenti modelli addestrati ed eseguiti prevalentemente su GPU NVIDIA, GPT-5.3-Codex-Spark sfrutta la potenza del Wafer Scale Engine 3 (WSE-3) di Cerebras. Questa architettura unica, che integra memoria e calcolo su un singolo wafer di silicio di dimensioni enormi, elimina i tradizionali colli di bottiglia nel trasferimento dei dati. Secondo Sean Lie, CTO di Cerebras, questa collaborazione permette di "stringere il ciclo di feedback end-to-end", rendendo l’interazione con l’AI fluida e naturale.

Sachin Katti, Head of Compute di OpenAI, ha sottolineato l’importanza di questa diversificazione hardware: "Portare il calcolo su scala wafer in produzione ci offre un nuovo modo per mantenere Codex reattivo per lavori sensibili alla latenza". Questa mossa segnala un’evoluzione nel progresso tecnologico delle infrastrutture AI, dove l’hardware viene sempre più specializzato in base al tipo di carico di lavoro: GPU per il training massivo e chip specializzati come quelli di Cerebras per l’inferenza a bassissima latenza.

Benchmark e Prestazioni: Il Compromesso tra Velocità e Intelligenza

Dal punto di vista tecnico, è fondamentale analizzare i compromessi scelti dagli ingegneri di OpenAI. GPT-5.3-Codex-Spark è un modello più piccolo rispetto alla versione standard e, come tale, mostra prestazioni differenti nei benchmark di settore. Secondo i dati rilasciati, su test come SWE-Bench Pro e Terminal-Bench 2.0 — standard de facto per valutare le capacità di ingegneria del software agentica — Spark ottiene punteggi inferiori rispetto a GPT-5.3-Codex (ad esempio, 58.4% contro 77.3% su Terminal-Bench). Tuttavia, completa questi task in una frazione del tempo.

Questa scelta progettuale riflette una comprensione matura delle esigenze degli sviluppatori: non ogni interazione richiede la massima capacità di ragionamento (o "Deep Think"). Per modifiche rapide, correzioni di sintassi o generazione di boilerplate, la velocità è il fattore critico. Il modello supporta una finestra di contesto di 128.000 token ed è, al lancio, esclusivamente testuale. L’automazione derivante da una risposta istantanea permette agli sviluppatori di iterare le idee molto più velocemente, riducendo i tempi morti che spesso interrompono la concentrazione.

Disponibilità e Integrazione nel Flusso di Lavoro

Attualmente, GPT-5.3-Codex-Spark è disponibile in anteprima di ricerca per gli utenti abbonati a ChatGPT Pro ($200/mese) e per i team Enterprise. L’accesso è integrato nell’ultima versione dell’app Codex, nell’estensione per IDE e nella riga di comando (CLI). OpenAI ha avvertito che, trattandosi di una preview su hardware specializzato, potrebbero verificarsi code o limitazioni di accesso durante i picchi di domanda, poiché l’infrastruttura Cerebras viene scalata progressivamente.

L’integrazione di algoritmi di machine learning così rapidi apre scenari inediti per la programmazione assistita. Non si tratta più solo di autocompletamento, ma di una collaborazione attiva dove l’AI può proporre intere ristrutturazioni di codice nel tempo che lo sviluppatore impiega a formulare il pensiero successivo. Sebbene il modello non raggiunga la soglia di "alta capacità" nel framework di sicurezza per la cybersecurity di OpenAI (a differenza del fratello maggiore), la sua utilità nel ciclo quotidiano di sviluppo "red-green-refactor" è innegabile.

In Breve (TL;DR)

OpenAI ridefinisce lo sviluppo software con GPT-5.3-Codex-Spark, un modello rivoluzionario capace di generare oltre mille token al secondo per un coding istantaneo.

La partnership strategica con Cerebras introduce un’architettura hardware specializzata che abbatte drasticamente la latenza, garantendo risposte immediate e un flusso di lavoro continuo.

Pur sacrificando parte della capacità di ragionamento profondo, questa soluzione accelera notevolmente le iterazioni quotidiane integrandosi direttamente negli ambienti di sviluppo.

Conclusioni

Con il lancio di GPT-5.3-Codex-Spark, OpenAI dimostra che la corsa all’intelligenza artificiale non riguarda solo la creazione di modelli sempre più intelligenti, ma anche più efficienti e utilizzabili in contesti reali. L’adozione di hardware non convenzionale come quello di Cerebras segna un punto di svolta nell’industria, suggerendo che il futuro dei LLM (Large Language Models) sarà ibrido e specializzato. Per gli sviluppatori, questo significa strumenti più reattivi e un passo avanti verso una simbiosi uomo-macchina sempre più stretta nel processo creativo del software.

Domande frequenti

GPT-5.3-Codex-Spark è un nuovo modello di intelligenza artificiale rilasciato da OpenAI, progettato specificamente per lo sviluppo software a bassa latenza. La sua caratteristica distintiva è la velocità di inferenza senza precedenti, capace di generare oltre 1.000 token al secondo. A differenza dei modelli focalizzati sul ragionamento profondo, Spark mira a fornire suggerimenti di codice e refactoring quasi istantanei, migliorando il flusso di lavoro degli sviluppatori. Questa rapidità è resa possibile grazie all utilizzo dell innovativo hardware Wafer Scale Engine 3 fornito dal partner strategico Cerebras.

La differenza sostanziale risiede nel compromesso tra velocità e capacità di ragionamento complesso. Il modello standard GPT-5.3-Codex è ottimizzato per compiti agentici difficili e ottiene punteggi più alti nei benchmark come SWE-Bench Pro. Al contrario, la variante Spark è un modello più piccolo che sacrifica parte della profondità analitica per offrire una risposta estremamente rapida. È quindi meno adatto per risolvere problemi architetturali complessi, ma eccelle nella generazione di codice boilerplate, correzioni di sintassi e modifiche veloci dove la reattività è fondamentale.

L integrazione con l hardware di Cerebras, in particolare il Wafer Scale Engine 3 (WSE-3), permette a OpenAI di superare i colli di bottiglia tipici delle tradizionali GPU. Questa architettura unica unisce memoria e capacità di calcolo su un singolo wafer di silicio di grandi dimensioni, eliminando i ritardi nel trasferimento dei dati. Ciò consente di stringere il ciclo di feedback end-to-end, rendendo l inferenza incredibilmente veloce e adatta a carichi di lavoro sensibili alla latenza, differenziando così l hardware per l inferenza da quello usato per il training massivo.

Attualmente, il modello è disponibile in anteprima di ricerca (research preview). L accesso è riservato agli utenti che hanno sottoscritto l abbonamento ChatGPT Pro, il cui costo è di 200 dollari al mese, oltre che ai team con piani Enterprise. Il modello è integrato direttamente negli strumenti di lavoro degli sviluppatori, come l estensione per IDE (ad esempio VS Code) e la riga di comando CLI di Codex. Tuttavia, OpenAI avverte che potrebbero esserci code o limitazioni iniziali mentre l infrastruttura viene scalata.

La versione Spark è ideale per le attività quotidiane di coding che richiedono interazioni frequenti e veloci, come il ciclo red-green-refactor. È perfetta per l autocompletamento intelligente, la correzione rapida di errori, la scrittura di funzioni standard e il refactoring immediato del codice. Grazie alla sua finestra di contesto di 128.000 token e alla natura testuale, permette agli sviluppatori di iterare le idee senza perdere la concentrazione, lasciando invece i compiti che richiedono un ragionamento profondo (Deep Think) al modello fratello maggiore.

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.