In Breve (TL;DR)

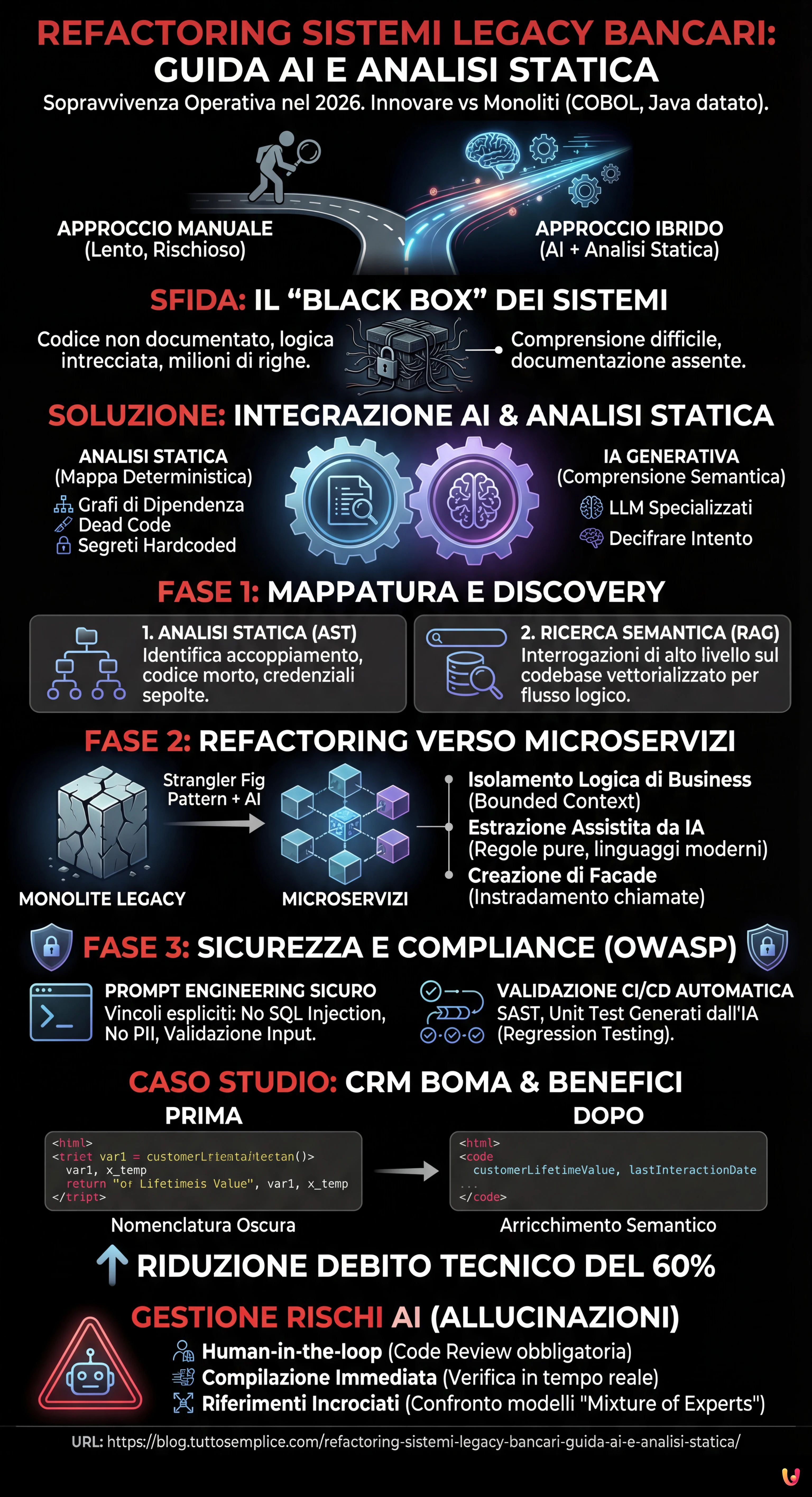

La modernizzazione dei sistemi bancari legacy diventa sostenibile combinando la precisione dell’analisi statica con la capacità interpretativa dell’Intelligenza Artificiale Generativa.

L’adozione di architetture RAG e pattern evolutivi accelera la mappatura del codice obsoleto, facilitando la transizione sicura da monoliti complessi a microservizi agili.

L’integrazione di protocolli di sicurezza rigorosi e validazioni automatiche nella pipeline di sviluppo mitiga i rischi operativi derivanti dalla generazione automatica del codice.

Il diavolo è nei dettagli. 👇 Continua a leggere per scoprire i passaggi critici e i consigli pratici per non sbagliare.

Nel panorama finanziario del 2026, il refactoring sistemi legacy non è più una scelta opzionale, ma una necessità di sopravvivenza operativa. Le istituzioni bancarie si trovano strette tra la necessità di innovare rapidamente (per competere con le Fintech native digitali) e il peso di codebase monolitici, spesso scritti in COBOL o vecchie versioni di Java, che gestiscono transazioni critiche da decenni. Questa guida tecnica esplora come l’integrazione tra Intelligenza Artificiale Generativa (GenAI) e strumenti deterministici di analisi statica del codice stia rivoluzionando il modo in cui affrontiamo la modernizzazione del software.

Il Problema del “Black Box” nei Sistemi Bancari

Il principale ostacolo nel refactoring di sistemi bancari non è la scrittura del nuovo codice, ma la comprensione di quello vecchio. Parliamo di milioni di righe di codice dove la logica di business è intrecciata con la gestione dell’infrastruttura, e dove la documentazione è spesso assente o obsoleta. In questo contesto, un approccio manuale è rischioso e insostenibilmente lento.

La soluzione moderna risiede in un approccio ibrido: utilizzare l’analisi statica per creare una mappa certa delle dipendenze e gli LLM (Large Language Models) specializzati nel code understanding per decifrare l’intento semantico delle funzioni.

Fase 1: Mappatura e Discovery con Analisi Statica e AI

Prima di toccare una singola riga di codice, è necessario illuminare le zone d’ombra del monolite. Ecco come strutturare la fase di discovery:

1. Generazione dell’Abstract Syntax Tree (AST)

Gli strumenti di analisi statica (come SonarQube avanzato o strumenti proprietari di mainframe analysis) devono essere configurati per generare non solo report di qualità, ma grafi di dipendenza completi. L’obiettivo è identificare:

- Accoppiamento afferente ed efferente: Quali moduli sono troppo interconnessi?

- Dead Code: Codice che non viene mai eseguito ma che consuma risorse cognitive.

- Hardcoded Secrets: Credenziali sepolte nel codice sorgente.

2. Semantic Code Search con RAG (Retrieval-Augmented Generation)

Una volta indicizzato il codebase, possiamo utilizzare un’architettura RAG. Invece di chiedere a un LLM generico di “spiegare questo file”, inseriamo l’intero codebase vettorializzato in un database. Questo permette di interrogare il sistema con domande di alto livello:

“Mostrami tutte le funzioni che calcolano il tasso di interesse composto e che hanno dipendenze dirette con la tabella DB_CLIENTI_STORICO.”

L’AI restituisce non solo i file, ma il flusso logico che li collega, riducendo il tempo di analisi da settimane a minuti.

Fase 2: Strategie di Refactoring verso Microservizi

Una volta mappato il territorio, l’obiettivo è il refactoring sistemi legacy verso un’architettura a microservizi o modulare. La tecnica regina rimane lo Strangler Fig Pattern, potenziato dall’AI.

Isolamento della Logica di Business

Qui entra in gioco l’esperienza maturata nello sviluppo del CRM BOMA. Durante la creazione di BOMA, ci siamo trovati di fronte alla necessità di migrare logiche complesse di gestione clienti da un vecchio gestionale VB6. L’errore comune è tentare di riscrivere tutto da zero (Big Bang Rewrite). Invece, abbiamo utilizzato l’AI per estrarre le “regole pure” di business, separandole dal codice di interfaccia utente e di accesso ai dati.

Il processo applicato:

- Identificazione: L’analisi statica individua i confini del modulo (Bounded Context).

- Estrazione Assistita: Si fornisce all’LLM il codice legacy e si richiede di generare una versione agnostica della logica in un linguaggio moderno (es. Go o Rust), mantenendo input e output identici.

- Creazione di Facade: Si implementa un’interfaccia che instrada le chiamate dal vecchio sistema al nuovo microservizio.

Fase 3: Sicurezza e Compliance (OWASP Top 10)

Nel settore bancario, la sicurezza non è negoziabile. L’uso di AI per generare codice introduce nuovi rischi (es. codice insicuro o allucinazioni). È imperativo integrare controlli di sicurezza nella pipeline di refactoring.

Prompt Engineering per la Sicurezza

Quando si chiede a un LLM di rifattorizzare una funzione, il prompt deve includere vincoli di sicurezza espliciti. Esempio di prompt strutturato:

ROLE: Senior Security Architect TASK: Refactoring della funzione 'processTransaction' da COBOL a Java Spring Boot. CONSTRAINTS: 1. Utilizza Prepared Statements per prevenire SQL Injection (OWASP A03:2021). 2. Implementa validazione rigorosa degli input. 3. Assicura che i log non contengano PII (Personally Identifiable Information). 4. Aggiungi commenti Javadoc spiegando la logica di business preservata.

Validazione Automatica nella CI/CD

Il codice generato dall’AI non deve mai andare in produzione senza validazione. La pipeline CI/CD deve includere:

- SAST (Static Application Security Testing): Scansione automatica per vulnerabilità note.

- Unit Test Generati: Chiedere all’AI di generare test unitari per il vecchio codice e assicurarsi che il nuovo codice passi gli stessi test (Regression Testing).

Il Caso Studio: L’Eredità del CRM BOMA

L’esperienza con il CRM BOMA è stata illuminante per definire questo protocollo. In quel progetto, la sfida non era solo tecnologica, ma semantica. Il vecchio sistema utilizzava nomenclature oscure (es. variabili come var1, x_temp). Utilizzando LLM per analizzare il flusso dei dati, siamo riusciti a rinominare e rifattorizzare le variabili con nomi parlanti basati sul contesto reale di utilizzo (es. customerLifetimeValue, lastInteractionDate).

Questo processo di “arricchimento semantico” durante il refactoring ha permesso non solo di aggiornare lo stack tecnologico, ma di rendere il codice manutenibile per i futuri sviluppatori, riducendo il debito tecnico del 60% nei primi 6 mesi post-migrazione.

Troubleshooting: Gestire le Allucinazioni dell’AI

Anche nel 2026, gli LLM possono “allucinare”, inventando librerie o metodi inesistenti. Per mitigare questo rischio:

- Human-in-the-loop: La Code Review umana rimane obbligatoria per la logica critica.

- Compilazione Immediata: Integrare l’IDE con l’agente AI per verificare che il codice suggerito compili in tempo reale.

- Riferimenti Incrociati: Usare due modelli diversi per generare il codice e un terzo modello per confrontare le soluzioni (Pattern “Mixture of Experts”).

Conclusioni

Il refactoring sistemi legacy nel settore bancario è un’operazione a cuore aperto. L’adozione di strumenti di analisi statica combinati con l’intelligenza artificiale permette di ridurre i rischi operatori e accelerare il time-to-market. Tuttavia, la tecnologia è solo un acceleratore: la profonda comprensione dei domini bancari e l’architettura software, come dimostrato nel caso BOMA, rimangono le fondamenta insostituibili per il successo del progetto.

Domande frequenti

L’integrazione tra AI Generativa e analisi statica permette di decifrare rapidamente codebase obsoleti, riducendo i tempi di discovery da settimane a minuti. Grazie all’architettura RAG, è possibile interrogare il codice vettorializzato per comprendere flussi logici complessi e dipendenze nascoste, facilitando l’estrazione delle regole di business senza dover analizzare manualmente milioni di righe di codice.

La tecnica raccomandata è lo Strangler Fig Pattern potenziato dall’AI. Questo approccio evita la riscrittura totale immediata, preferendo l’isolamento graduale dei contesti limitati. Gli LLM vengono utilizzati per estrarre la logica pura dal vecchio sistema e riscriverla in linguaggi moderni, mentre si creano interfacce facade che instradano il traffico verso i nuovi microservizi in modo progressivo.

La sicurezza si ottiene imponendo vincoli espliciti nei prompt, come l’uso di Prepared Statements per prevenire SQL Injection secondo gli standard OWASP, e integrando controlli automatici nella pipeline CI/CD. È essenziale mantenere un approccio human-in-the-loop per la revisione del codice critico e utilizzare strumenti SAST per scansionare vulnerabilità prima che il software vada in produzione.

Si utilizza un approccio di arricchimento semantico tramite LLM specializzati nel code understanding. Questi modelli analizzano il flusso dei dati e suggeriscono rinominazioni delle variabili oscure con termini basati sul contesto reale, come visto nel caso studio CRM BOMA. Questo processo trasforma il codice black box in una struttura leggibile e manutenibile per i futuri sviluppatori.

Le allucinazioni si verificano quando l’AI inventa librerie o metodi inesistenti. Per mitigarle, si adottano strategie come la compilazione immediata del codice suggerito direttamente nell’IDE e l’uso di modelli multipli per confrontare le soluzioni (Mixture of Experts). Inoltre, la generazione automatica di unit test assicura che il nuovo codice rispetti rigorosamente le funzionalità del sistema originale.

Fonti e Approfondimenti

- Banca d’Italia: Indagine Fintech nel sistema finanziario italiano e investimenti tecnologici

- EUR-Lex: Testo ufficiale del Regolamento (UE) 2022/2554 (DORA) sulla resilienza operativa digitale

- NIST: Framework per la gestione dei rischi dell’Intelligenza Artificiale (AI RMF)

- IBM: Definizione di sistemi legacy e strategie di modernizzazione

- Wikipedia: Approfondimento sul Refactoring del codice software

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.