Siamo nel 2026 e l’Intelligenza Artificiale permea ormai ogni aspetto della nostra quotidianità lavorativa e creativa. Dai sistemi di guida autonoma alla generazione di codice complesso, sembra non esserci limite al progresso tecnologico. Eppure, sotto la scocca scintillante dei più avanzati Large Language Model (LLM), si nasconde una fragilità strutturale sorprendente, un tallone d’Achille che svela la vera natura di questi sistemi. Esiste una tipologia di domanda, banale per un bambino delle elementari, che manda letteralmente in crisi il cervello elettronico più sofisticato. Non si tratta di un quesito filosofico irrisolvibile né di un calcolo quantistico, ma di una semplice inversione logica.

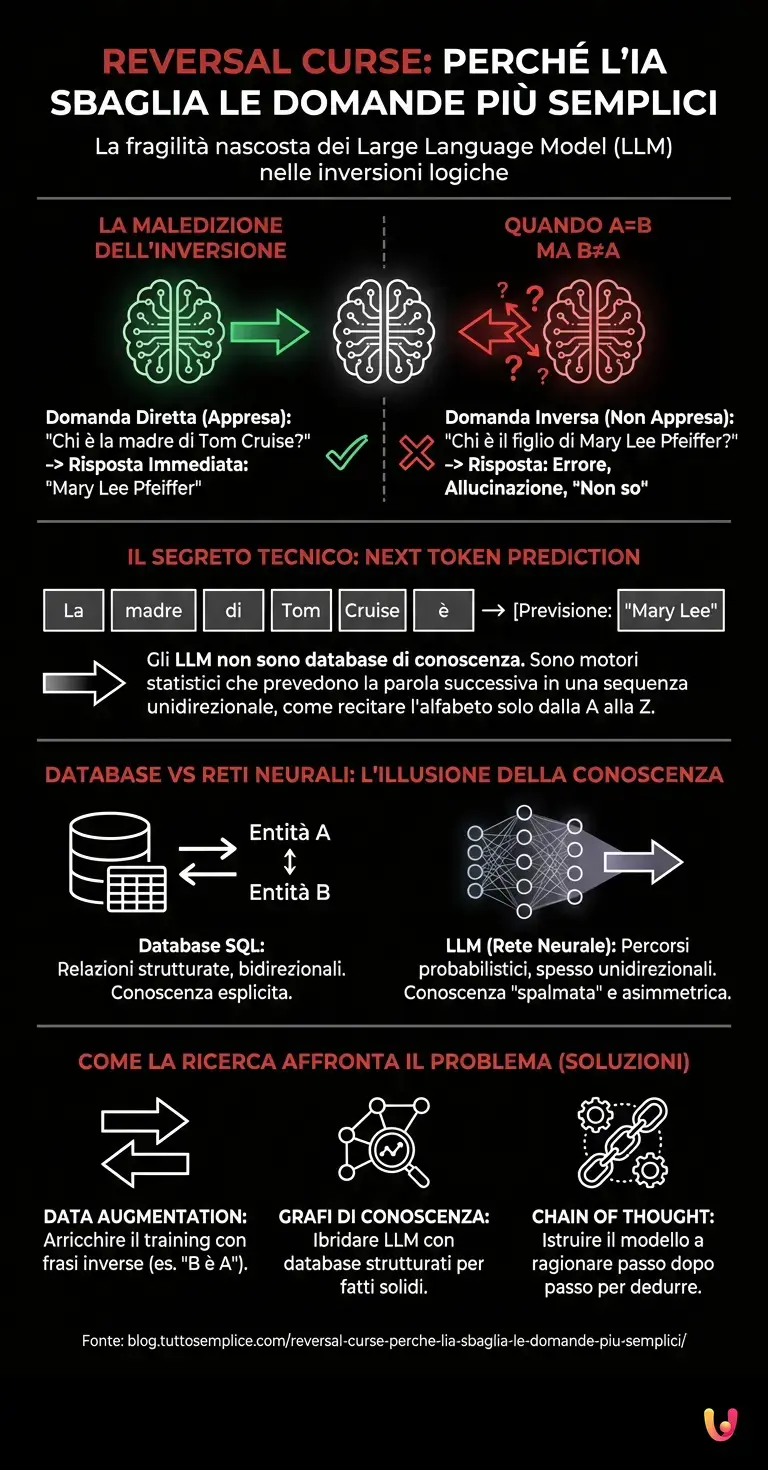

La Maledizione dell’Inversione: quando A è B, ma B non è A

Immaginate di chiedere a un sistema di machine learning avanzato: “Chi è la madre di Tom Cruise?”. Il modello, avendo ingerito terabyte di dati biografici, risponderà prontamente e correttamente: “Mary Lee Pfeiffer”. Fin qui, tutto perfetto. L’automazione funziona, il recupero dell’informazione è istantaneo.

Tuttavia, se proviamo a porre la domanda al contrario: “Chi è il figlio di Mary Lee Pfeiffer?”, accade l’impensabile. In una percentuale significativa di casi, anche i modelli più blasonati come le versioni evolute di ChatGPT o i suoi concorrenti open-source, iniziano a balbettare, allucinare risposte errate o dichiarare di non conoscere l’informazione. Questo fenomeno è stato battezzato dai ricercatori come Reversal Curse, la “Maledizione dell’Inversione”.

Perché accade? Per noi umani, la relazione “Tom Cruise è figlio di Mary Lee” implica automaticamente e senza sforzo che “Mary Lee è madre di Tom Cruise”. La relazione è bidirezionale. Per un’architettura neurale di tipo trasformatore (Transformer), invece, questa equivalenza non è affatto scontata. Se il modello non ha incontrato esplicitamente la frase nel senso inverso durante il suo addestramento, non è in grado di dedurla logicamente con la stessa certezza con cui noi applichiamo la proprietà commutativa.

Il segreto tecnico: la tirannia del “Next Token Prediction”

Per comprendere la radice di questo limite, dobbiamo immergerci nel funzionamento profondo del deep learning applicato al linguaggio. Gli LLM non sono database di conoscenza strutturata come un’enciclopedia o un foglio Excel. Non memorizzano fatti univoci (es. Relazione: Madre-Figlio). Sono, essenzialmente, motori statistici di completamento del testo.

L’obiettivo primario di questi algoritmi è prevedere la parola (o il token) successiva in una sequenza. Quando il modello viene addestrato su milioni di testi che dicono “La madre di Tom Cruise è Mary Lee”, i pesi della rete neurale si aggiornano per massimizzare la probabilità che, dopo la sequenza “La madre di Tom Cruise è”, appaia “Mary Lee”.

Possiamo paragonare questo processo all’imparare l’alfabeto o una poesia a memoria. Se vi chiedo di recitare l’alfabeto dalla A alla Z, lo farete in pochi secondi. Ma se vi chiedo di recitarlo dalla Z alla A, o di dirmi istantaneamente quale lettera precede la ‘M’ senza ripercorrere la sequenza mentalmente, farete molta più fatica. L’AI vive lo stesso dramma: ha imparato la “canzone” dei dati in una direzione, ma non ha creato una mappa concettuale che colleghi le entità in modo spaziale o logico bidirezionale.

Database vs Reti Neurali: l’illusione della conoscenza

Questo fenomeno evidenzia una distinzione cruciale che spesso sfugge al grande pubblico: la differenza tra conoscenza e probabilità. Un database SQL tradizionale, se interrogato correttamente, troverà il collegamento tra due entità indipendentemente dalla direzione della query, perché i dati sono strutturati in tabelle relazionali. Un LLM, invece, “spalma” l’informazione attraverso miliardi di parametri numerici.

Quando chiediamo al modello di invertire la relazione, gli stiamo chiedendo di risalire la corrente del fiume probabilistico. Se nei dati di training la frase “Il figlio di Mary Lee è Tom” appare raramente rispetto a “La madre di Tom è Mary”, il percorso neuronale che porta dalla madre al figlio è debole, quasi inesistente. Il modello non “sa” chi sono queste persone; sa solo quali parole tendono a seguire quali altre.

Questo ha implicazioni enormi per l’automazione aziendale e la verifica dei fatti. Se ci affidiamo all’AI per dedurre relazioni non esplicitate nei documenti di partenza, rischiamo di ottenere risposte incomplete o errate, proprio a causa di questa asimmetria nell’apprendimento.

Come la ricerca sta affrontando il problema

Nel 2026, la comunità scientifica non è rimasta a guardare. I nuovi benchmark per valutare le prestazioni delle intelligenze artificiali includono ora test specifici sulla reversibilità logica. Per mitigare la Reversal Curse, gli ingegneri stanno adottando diverse strategie:

- Data Augmentation: Durante la fase di training, i dataset vengono arricchiti artificialmente con frasi inverse (es. trasformando automaticamente ogni frase “A è B” anche in “B è A”).

- Grafi di Conoscenza (Knowledge Graphs): Si tenta di ibridare gli LLM con database strutturati, permettendo al modello di consultare una fonte esterna di “fatti” solidi quando la previsione statistica è incerta.

- Chain of Thought (Catena di Pensiero): Si istruisce il modello a “ragionare ad alta voce”, scomponendo il problema. Chiedendo all’AI di elencare prima i parenti di Tom Cruise e poi cercare tra essi, si aumentano le probabilità di successo, aggirando il blocco dell’associazione diretta.

In Breve (TL;DR)

I modelli linguistici più evoluti mostrano una sorprendente fragilità nel dedurre relazioni logiche inverse, fenomeno noto come Maledizione dell’Inversione.

Il problema deriva dall’addestramento statistico basato sulla previsione del prossimo token, che non garantisce la comprensione bidirezionale dei concetti.

Distinguere tra probabilità e reale conoscenza è fondamentale per evitare errori critici nell’automazione aziendale e nella verifica dei fatti.

Conclusioni

La “domanda al contrario” rimane una delle dimostrazioni più eleganti e spietate dei limiti attuali dell’Intelligenza Artificiale. Ci ricorda che, nonostante la capacità di scrivere poesie o superare esami universitari, questi sistemi non possiedono ancora una comprensione del mondo analoga a quella umana. Il loro “ragionamento” è una simulazione statistica estremamente convincente, ma che si infrange non appena si inverte il flusso dei dati. La sfida per il futuro non sarà solo aumentare la potenza di calcolo, ma insegnare alle macchine non solo a prevedere la parola successiva, ma a comprendere la simmetria intrinseca della realtà.

Domande frequenti

La Maledizione dell Inversione, nota anche come Reversal Curse, è un fenomeno per cui i modelli linguistici avanzati faticano a dedurre una relazione inversa tra due entità se non l hanno appresa esplicitamente. Ad esempio, un AI potrebbe sapere chi è la madre di un personaggio famoso, ma fallire nel rispondere correttamente se le viene chiesto chi è il figlio di quella stessa madre, dimostrando una mancanza di logica bidirezionale automatica.

Questo errore accade perché i Large Language Model non sono database di fatti, ma motori statistici progettati per la previsione del prossimo token, ovvero la parola successiva. Hanno imparato i dati in una sequenza specifica, simile a una poesia a memoria, e non possiedono una mappa concettuale spaziale; pertanto, invertire il flusso logico richiede un percorso probabilistico che spesso non esiste nei loro parametri di addestramento.

La differenza sostanziale risiede nella struttura dell informazione. Un database SQL organizza i dati in tabelle relazionali che permettono di collegare le entità in qualsiasi direzione (A è B e B è A). Al contrario, un modello AI spalma la conoscenza su miliardi di parametri numerici basati sulla probabilità, rendendo difficile il recupero dell informazione se la domanda va contro la corrente del flusso di dati appreso inizialmente.

I ricercatori stanno affrontando il problema attraverso diverse strategie tecniche. Tra queste vi sono la Data Augmentation, che consiste nell inserire artificialmente frasi inverse durante l addestramento, l uso di Grafi di Conoscenza per fornire dati strutturati esterni, e la tecnica Chain of Thought, che guida il modello a ragionare passo dopo passo per dedurre la risposta corretta invece di affidarsi alla sola associazione diretta.

Non esattamente come la mente umana. L AI esegue una simulazione statistica convincente basata sulla frequenza delle parole, ma non possiede una reale comprensione della simmetria della realtà. Il paradosso dell inversione dimostra che, sebbene i modelli possano superare esami complessi, mancano ancora della capacità intuitiva di capire che se A è collegato a B, allora B è necessariamente collegato ad A senza bisogno di un addestramento specifico.

Fonti e Approfondimenti

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.