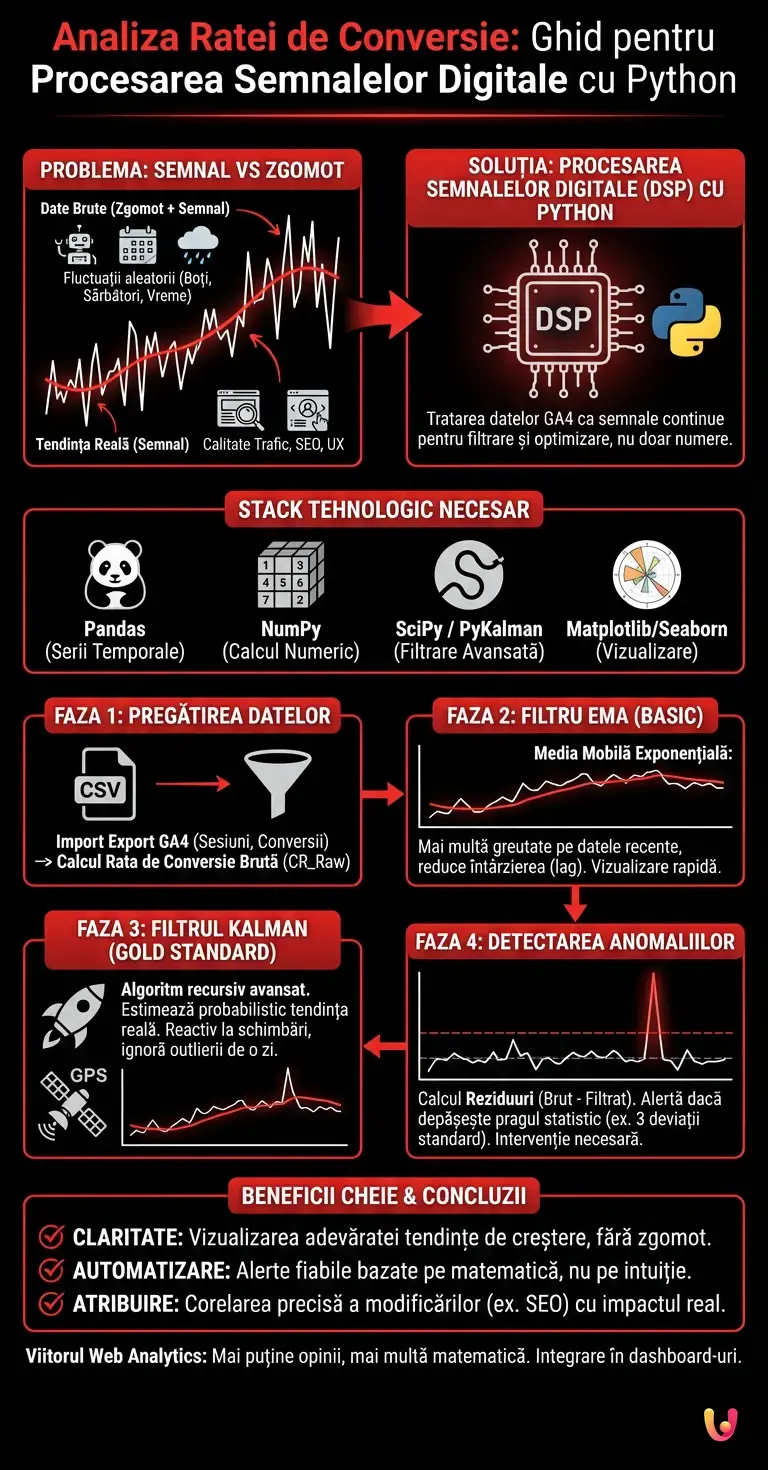

În peisajul actual de digital marketing, analiza ratei de conversie suferă adesea de o problemă fundamentală: interpretarea greșită a varianței. Prea des, marketerii reacționează la fluctuații zilnice aleatorii ca și cum ar fi tendințe structurale, ducând la decizii pripite și costisitoare. Pentru a ridica calitatea insight-urilor, trebuie să privim dincolo de instrumentele standard și să apelăm la ingineria electronică. În acest ghid tehnic, vom explora cum să tratăm datele exportate din Google Analytics 4 nu ca simple numere într-o foaie de calcul, ci ca semnale continue de procesat, filtrat și optimizat.

Problema: Semnal vs Zgomot în Marketing

Când observăm un grafic al evoluției conversiilor pe o bază temporală, ceea ce vedem este suma a două componente:

- Semnalul (Signal): Adevărata tendință de fond determinată de calitatea traficului, de SEO și de UX-ul site-ului.

- Zgomotul (Noise): Variații aleatorii datorate boților, sărbătorilor, vremii sau simplei stocasticități a comportamentului uman.

Abordarea clasică se limitează la calcularea mediilor simple. Abordarea avansată, derivată din Digital Signal Processing (DSP), aplică filtre matematice pentru a elimina zgomotul și a dezvălui adevărata natură a semnalului. Acest lucru ne permite să răspundem la întrebarea: «Scăderea de ieri este o anomalie statistică sau site-ul a încetat să funcționeze?».

Condiții Prealabile și Stack Tehnologic

Pentru a urma acest ghid, este necesar un mediu de dezvoltare Python configurat. Vom utiliza următoarele biblioteci, standard de facto în data science:

- Pandas: Pentru manipularea seriilor temporale.

- NumPy: Pentru calcul numeric vectorial.

- SciPy / PyKalman: Pentru implementarea algoritmilor de filtrare avansați.

- Matplotlib/Seaborn: Pentru vizualizarea semnalelor.

Asigurați-vă că aveți un export CSV al datelor voastre zilnice (Sesiuni și Conversii) din GA4.

Faza 1: Pregătirea Setului de Date

Primul pas este importarea datelor și calcularea ratei de conversie brute (CR). Adesea, datele brute sunt «murdare» și discontinue.

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

# Încărcare date (simulare a unui export GA4)

# CSV-ul trebuie să aibă coloanele: 'Date', 'Sessions', 'Conversions'

df = pd.read_csv('ga4_data_export.csv', parse_dates=['Date'])

df.set_index('Date', inplace=True)

# Calculul Ratei de Conversie (CR) Zilnice

# Gestionăm împărțirea la zero în cazul zilelor fără trafic

df['CR_Raw'] = np.where(df['Sessions'] > 0, df['Conversions'] / df['Sessions'], 0)

print(df.head())

Faza 2: Filtre cu Răspuns la Impuls Infinit (IIR) – Media Mobilă Exponențială

Primul nivel de curățare este aplicarea unei Medii Mobile Exponențiale (EMA). Spre deosebire de media mobilă simplă (SMA), EMA atribuie mai multă greutate datelor recente, reducând întârzierea (lag) în detectarea tendințelor. În termeni de DSP, aceasta acționează ca un filtru trece-jos de bază.

# Aplicarea unei EMA cu span de 7 zile (ciclu săptămânal)

df['CR_EMA'] = df['CR_Raw'].ewm(span=7, adjust=False).mean()

# Vizualizare

plt.figure(figsize=(12,6))

plt.plot(df.index, df['CR_Raw'], label='CR Brut (Zgomotos)', alpha=0.3, color='gray')

plt.plot(df.index, df['CR_EMA'], label='EMA 7 Zile (Semnal Curat)', color='blue')

plt.title('Analiza Ratei de Conversie: Raw vs EMA')

plt.legend()

plt.show()

EMA este utilă pentru vizualizări rapide, dar suferă încă de o întârziere intrinsecă. Dacă rata de conversie se prăbușește astăzi, EMA va avea nevoie de câteva zile pentru a reflecta pe deplin schimbarea.

Faza 3: Filtrul Kalman (Abordarea Gold Standard)

Aici intrăm pe teritoriul ingineriei avansate. Filtrul Kalman este un algoritm recursiv care estimează starea internă a unui sistem dinamic liniar pornind de la o serie de măsurători zgomotoase. Este același algoritm folosit pentru navigarea rachetelor și urmărirea GPS.

În analiza ratei de conversie, filtrul Kalman consideră CR nu ca un număr fix, ci ca o estimare probabilistică ce se actualizează constant, echilibrând incertitudinea măsurătorii (data de astăzi) cu predicția modelului (tendința istorică).

Implementarea Python a Filtrului Kalman

Vom utiliza biblioteca pykalman (sau o implementare custom simplificată) pentru a aplica acest concept.

from pykalman import KalmanFilter

# Configurarea Filtrului

# Transition Covariance: cât de repede ne așteptăm să se schimbe adevăratul CR

# Observation Covariance: cât zgomot există în datele zilnice

kf = KalmanFilter(transition_matrices=[1],

observation_matrices=[1],

initial_state_mean=df['CR_Raw'].mean(),

initial_state_covariance=1,

observation_covariance=0.01,

transition_covariance=0.001)

# Calculul stărilor (semnalul filtrat)

state_means, state_covariances = kf.filter(df['CR_Raw'].values)

df['CR_Kalman'] = state_means

De ce Kalman bate Media Mobilă?

Observând rezultatele, veți nota că linia Kalman (CR_Kalman) este incredibil de mai reactivă la schimbările reale față de media mobilă, dar ignoră aproape complet outlierii unei singure zile (ex. un atac de boți care umflă sesiunile scăzând CR-ul). Filtrul «învață» varianța sistemului.

Faza 4: Detectarea Anomaliilor și Luarea Deciziilor

Acum că avem un semnal curat, putem calcula reziduurile, adică diferența dintre data brută și semnalul filtrat. Acest lucru este fundamental pentru alertarea automată.

# Calculul reziduurilor

df['Residuo'] = df['CR_Raw'] - df['CR_Kalman']

# Definirea pragului de anomalie (ex. 3 deviații standard)

soglia = df['Residuo'].std() * 3

# Identificarea zilelor anormale

anomalie = df[abs(df['Residuo']) > soglia]

print(f"Zile cu anomalii semnificative: {len(anomalie)}")

Dacă reziduul depășește pragul, înseamnă că s-a întâmplat ceva ce nu poate fi explicat prin zgomotul statistic normal. Doar în acest caz Specialistul SEO sau Marketing Managerul trebuie să intervină.

Concluzii și Aplicații SEO

Aplicarea teoriei semnalelor la analiza ratei de conversie transformă modul în care interpretăm datele web. În loc să urmărim fantome sau să reacționăm la panica unei singure zile negative, obținem:

- Claritate: Vizualizarea adevăratei tendințe de creștere curățată de sezonalitate.

- Automatizare: Sisteme de alertă bazate pe deviații standard reale, nu pe senzații.

- Atribuire: Capacitatea de a corela modificări On-Page (ex. update Core Web Vitals) cu variații structurale ale semnalului.

Integrarea scripturilor Python de acest tip în dashboard-urile companiei sau în rapoartele Looker Studio (via BigQuery) reprezintă viitorul Web Analytics: mai puține opinii, mai multă matematică.

Întrebări frecvente

Abordarea clasică a analizei datelor suferă adesea de o interpretare eronată a varianței, confundând fluctuațiile zilnice aleatorii cu tendințe structurale. Aplicând filtre matematice derivate din ingineria electronică datelor din GA4, este posibilă separarea semnalului real, determinat de SEO și UX, de zgomotul de fond cauzat de boți sau stocasticitate, obținând insight-uri mai fiabile.

Filtrul Kalman este un algoritm recursiv superior deoarece estimează starea sistemului echilibrând incertitudinea măsurătorii de astăzi cu predicția istorică. Spre deosebire de mediile mobile care pot suferi de întârzieri sau lag, această metodă este extrem de reactivă la schimbările reale ale tendinței, dar ignoră aproape complet outlierii unei singure zile, oferind o viziune mai precisă.

Pentru a identifica o anomalie semnificativă se calculează reziduurile, adică diferența matematică dintre data brută și semnalul filtrat de algoritm. Dacă această valoare depășește un prag statistic predefinit, calculat de obicei pe trei deviații standard, ne aflăm în fața unui eveniment anormal care necesită o intervenție tehnică sau strategică, excluzând falsurile pozitive.

Pentru a replica stack-ul tehnologic descris sunt esențiale Pandas pentru manipularea seriilor temporale și NumPy pentru calculul numeric vectorial. Pentru partea algoritmică avansată se utilizează SciPy sau PyKalman pentru filtre, în timp ce Matplotlib și Seaborn sunt fundamentale pentru a vizualiza grafic distincția dintre semnalul curat și datele brute zgomotoase.

Media Mobilă Exponențială, sau EMA, se diferențiază de media simplă deoarece atribuie o greutate mai mare datelor mai recente. Acest mecanism acționează ca un filtru trece-jos care reduce drastic întârzierea în detectarea tendințelor, permițând marketerilor să reacționeze mai rapid la schimbările structurale fără a fi păcăliți de volatilitatea zilnică.

Încă ai dubii despre Analiza Ratei de Conversie: Ghid pentru Procesarea Semnalelor Digitale cu Python?

Tastați aici întrebarea dvs. specifică pentru a găsi instantaneu răspunsul oficial de la Google.

Ați găsit acest articol util? Există un alt subiect pe care ați dori să-l tratez?

Scrieți-l în comentariile de mai jos! Mă inspir direct din sugestiile voastre.