Pe Scurt (TL;DR)

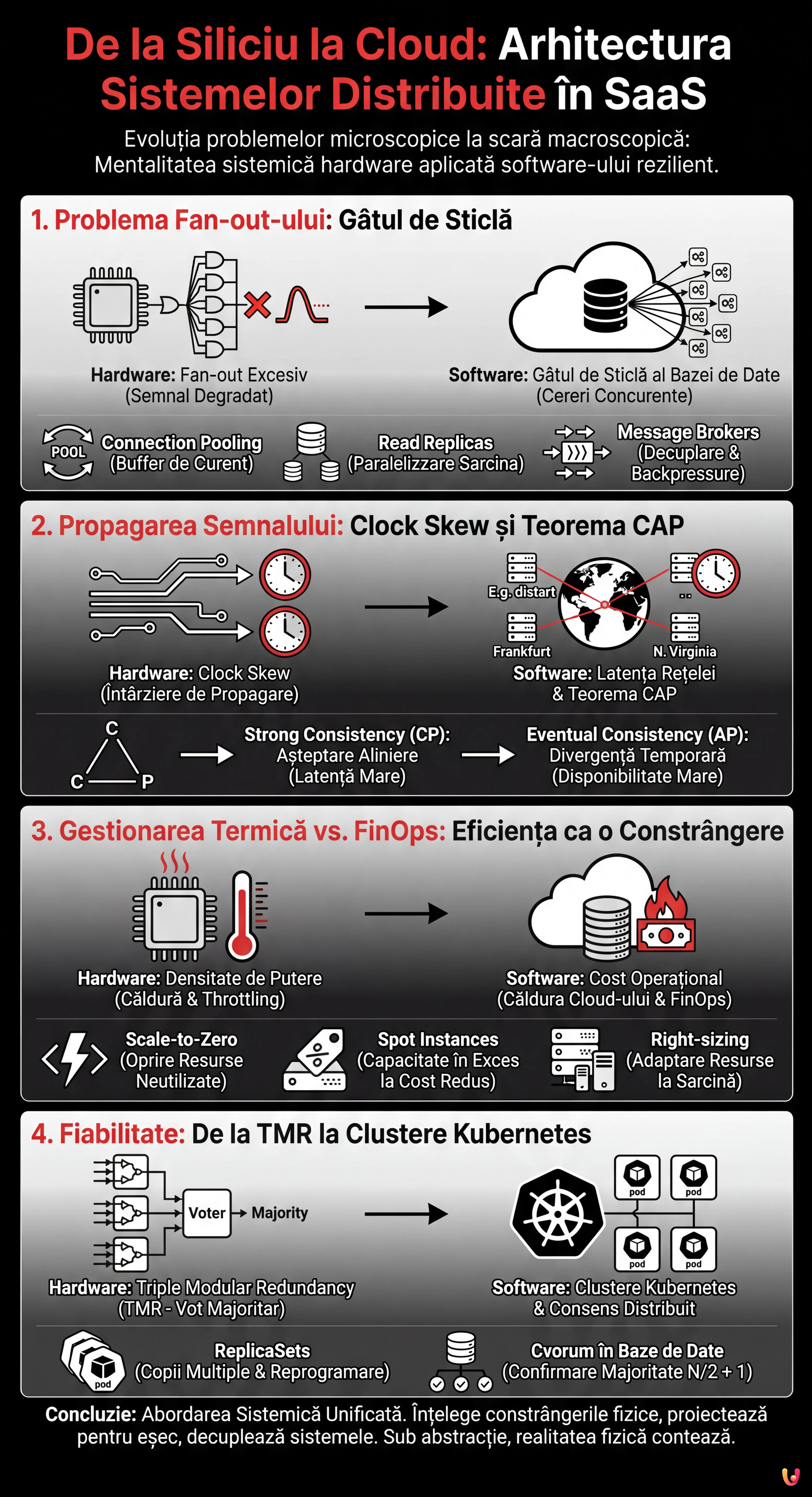

Arhitectura sistemelor distribuite în cloud reflectă la scară macroscopică legile fizice fundamentale care guvernează proiectarea circuitelor integrate.

Constrângerile hardware precum Fan-out-ul și propagarea semnalului explică perfect provocările moderne de load balancing și coerență a datelor.

Optimizarea termică a procesoarelor își găsește echivalentul în FinOps, transformând gestionarea energetică a siliciului în strategii pentru reducerea costurilor cloud.

Diavolul se ascunde în detalii. 👇 Continuă să citești pentru a descoperi pașii critici și sfaturile practice pentru a nu greși.

Suntem în 2026, și în timp ce inteligența artificială generativă a rescris regulile interacțiunii om-mașină, legile fundamentale ale fizicii și logicii rămân neschimbate. Pentru cineva ca mine, care și-a început cariera cu un ciocan de lipit în mână și schema unui circuit integrat (IC) pe masă, peisajul actual al Cloud Computing-ului nu pare o lume extraterestră, ci o evoluție la scară macroscopică a problemelor pe care le-am rezolvat deja la scară microscopică. În centrul tuturor lucrurilor se află arhitectura sistemelor distribuite: un concept pe care astăzi îl aplicăm clusterelor globale, dar care se naște din interconexiunile dintre tranzistori pe o plachetă de siliciu.

În acest eseu tehnic, vom explora modul în care mentalitatea sistemică necesară pentru a proiecta hardware fiabil este cheia de boltă pentru construirea unui software rezilient. Vom analiza cum constrângerile fizice ale siliciului își găsesc analogii perfecți în provocările imateriale ale SaaS-ului modern.

1. Problema Fan-out-ului: De la Porți Logice la Echilibrarea Sarcinii

În ingineria electronică, Fan-out-ul definește numărul maxim de intrări logice pe care o ieșire le poate pilota în mod fiabil. Dacă o poartă logică încearcă să trimită un semnal către prea multe alte porți, curentul se divide excesiv, semnalul se degradează, iar comutarea (de la 0 la 1 sau invers) devine lentă sau nedefinită. Este o limită fizică a capacității de pilotare.

Analogul în Software: Gâtul de Sticlă al Bazei de Date

În arhitectura sistemelor distribuite, conceptul de Fan-out se manifestă brutal atunci când un singur serviciu (de exemplu, o bază de date master sau un serviciu de autentificare) este bombardat de prea multe cereri concurente de la microserviciile client. Exact așa cum un tranzistor nu poate furniza curent infinit, o bază de date nu are conexiuni TCP sau cicluri CPU infinite.

Soluția hardware este inserarea de buffere pentru a regenera semnalul și a crește capacitatea de pilotare. În SaaS, aplicăm același principiu prin:

- Connection Pooling: Care acționează ca un buffer de curent, menținând conexiunile active și reutilizabile.

- Read Replicas: Care paralelizează sarcina de citire, similar cu adăugarea de etaje de amplificare în paralel.

- Message Brokers (Kafka/RabbitMQ): Care decuplează producătorul de consumator, gestionând vârfurile de sarcină (backpressure) exact cum un condensator de decuplare stabilizează tensiunea în timpul vârfurilor de absorbție.

2. Propagarea Semnalului: Clock Skew și Teorema CAP

Pe circuitele de înaltă frecvență, viteza luminii (sau mai bine zis, viteza de propagare a semnalului în cupru/aur) este o constrângere tangibilă. Dacă o pistă pe PCB este mai lungă decât alta, semnalul ajunge cu întârziere, cauzând probleme de sincronizare cunoscute sub numele de Clock Skew. Sistemul devine incoerent deoarece diverse părți ale cipului văd “realitatea” în momente diferite.

Tirania Distanței în Cloud

În cloud, latența rețelei este noua întârziere de propagare. Când proiectăm o arhitectură de sisteme distribuite geo-redundantă, nu putem ignora faptul că lumina are nevoie de timp pentru a călători de la Frankfurt la Virginia de Nord. Această întârziere fizică este rădăcina Teoremei CAP (Consistency, Availability, Partition tolerance).

Un inginer electronist știe că nu poate avea un semnal perfect sincron pe un cip enorm fără a încetini ceasul (sacrificând performanța pentru coerență). În mod similar, un arhitect software trebuie să aleagă între:

- Strong Consistency (CP): A aștepta ca toate nodurile să fie aliniate (ca un ceas global lent), acceptând o latență ridicată.

- Eventual Consistency (AP): A permite nodurilor să diveragă temporar pentru a menține disponibilitatea ridicată și latența scăzută, gestionând conflictele a posteriori (similar cu circuitele asincrone sau self-timed).

3. Gestionarea Termică vs. FinOps: Eficiența ca o Constrângere

Densitatea de putere este inamicul numărul unu în procesoarele moderne. Dacă nu se disipă căldura, cipul intră în thermal throttling (încetinește) sau se arde. Proiectarea VLSI (Very Large Scale Integration) modernă se învârte în jurul conceptului de “Dark Silicon”: nu putem aprinde toți tranzistorii simultan deoarece cipul s-ar topi. Trebuie să aprindem doar ceea ce este necesar, atunci când este necesar.

Costul este Căldura Cloud-ului

În modelul SaaS, “căldura” este costul operațional. O arhitectură ineficientă nu topește serverele (de asta se ocupă furnizorul de cloud), dar arde bugetul companiei. FinOps este gestionarea termică modernă.

Așa cum un inginer hardware folosește Clock Gating pentru a opri părțile cipului neutilizate, un Cloud Architect trebuie să implementeze:

- Scale-to-Zero: Utilizând tehnologii Serverless (precum AWS Lambda sau Google Cloud Run) pentru a opri complet resursele atunci când nu există trafic.

- Spot Instances: Exploatarea capacității în exces la cost redus, acceptând riscul de întrerupere, similar cu utilizarea componentelor cu toleranțe mai largi în circuite non-critice.

- Right-sizing: Adaptarea resurselor la sarcina reală, evitând supra-aprovizionarea care în lumea hardware ar echivala cu utilizarea unui radiator de 1kg pentru un cip de 5W.

4. Fiabilitate: De la TMR la Clustere Kubernetes

În sistemele avionice sau spațiale, unde reparația este imposibilă și radiațiile pot inversa aleatoriu un bit (Single Event Upset), se utilizează Triple Modular Redundancy (TMR). Trei circuite identice execută același calcul și un circuit de vot (voter) decide ieșirea bazându-se pe majoritate. Dacă unul eșuează, sistemul continuă să funcționeze.

Orchestrarea Rezilienței

Aceasta este esența exactă a unui cluster Kubernetes sau a unei baze de date distribuite cu consens Raft/Paxos. Într-o arhitectură de sisteme distribuite modernă:

- ReplicaSets: Mențin multiple copii (Pod-uri) ale aceluiași serviciu. Dacă un nod cade (hardware failure), Control Plane-ul (“voter-ul”) observă și reprogramează pod-ul în altă parte.

- Cvorum în Bazele de Date: Pentru a confirma o scriere într-un cluster (ex. Cassandra sau etcd), cerem ca majoritatea nodurilor (N/2 + 1) să confirme operațiunea. Acest lucru este matematic identic cu logica de vot a TMR-ului hardware.

Diferența substanțială este că în hardware redundanța este statică (cablată), în timp ce în software este dinamică și reconfigurabilă. Totuși, principiul de bază rămâne: nu te încrede niciodată în componenta individuală.

Concluzii: Abordarea Sistemică Unificată

Trecerea de la siliciu la cloud nu înseamnă schimbarea meseriei, ci schimbarea scării. Proiectarea unei arhitecturi de sisteme distribuite eficiente necesită aceeași disciplină necesară pentru tape-out-ul unui microprocesor:

- Înțelegerea constrângerilor fizice (lățime de bandă, latență, cost/căldură).

- Proiectarea pentru eșec (componenta se va strica, pachetul se va pierde).

- Decuplarea sistemelor pentru a evita propagarea erorilor.

În 2026, instrumentele au devenit incredibil de abstracte. Scriem YAML care descriu infrastructuri efemere. Dar sub acele niveluri de abstractizare, există încă electroni care aleargă, ceasuri care ticăie și buffere care se umplu. Menținerea conștientizării acestei realități fizice este ceea ce distinge un dezvoltator bun de un adevărat Arhitect de Sisteme.

Întrebări frecvente

Arhitectura cloud este considerată o evoluție la scară macroscopică a provocărilor microscopice tipice circuitelor integrate. Probleme fizice precum gestionarea căldurii și propagarea semnalului în siliciu își găsesc o corespondență directă în gestionarea costurilor și în latența de rețea a software-ului, necesitând o mentalitate sistemică similară pentru a garanta reziliența și eficiența operațională.

Fan-out-ul în software se manifestă atunci când un singur serviciu, cum ar fi o bază de date master, primește un număr excesiv de cereri concurente, analog cu o poartă logică ce pilotează prea multe intrări. Pentru a atenua acest gât de sticlă, se adoptă soluții precum connection pooling, replicile de citire și brokerii de mesaje, care acționează ca buffere pentru a stabiliza sarcina și a preveni degradarea performanțelor.

Latența rețelei, comparabilă cu întârzierea de propagare a semnalului în circuitele electronice, împiedică sincronizarea instantanee între noduri geografic distante. Această constrângere fizică obligă arhitecții software să aleagă între Strong Consistency, acceptând latențe mai mari pentru a aștepta alinierea nodurilor, sau Eventual Consistency, care privilegiază disponibilitatea tolerând dezalinieri temporare ale datelor.

În modelul SaaS, costul operațional reprezintă echivalentul căldurii generate în procesoare: ambele sunt factori limitativi care trebuie controlați. Strategiile FinOps precum Scale-to-Zero și Right-sizing reflectă tehnici hardware precum Clock Gating, oprind sau redimensionând resursele neutilizate pentru a optimiza eficiența și a împiedica consumarea inutilă a bugetului.

Clusterele Kubernetes aplică în mod dinamic principiile Redundanței Modulare Triple utilizate în sistemele critice hardware. Prin utilizarea ReplicaSets și a algoritmilor de consens pentru bazele de date distribuite, sistemul monitorizează constant starea serviciilor și înlocuiește nodurile eșuate bazându-se pe mecanisme de vot și majoritate, asigurând continuitatea operațională fără puncte unice de eșec.

Ați găsit acest articol util? Există un alt subiect pe care ați dori să-l tratez?

Scrieți-l în comentariile de mai jos! Mă inspir direct din sugestiile voastre.