Pe Scurt (TL;DR)

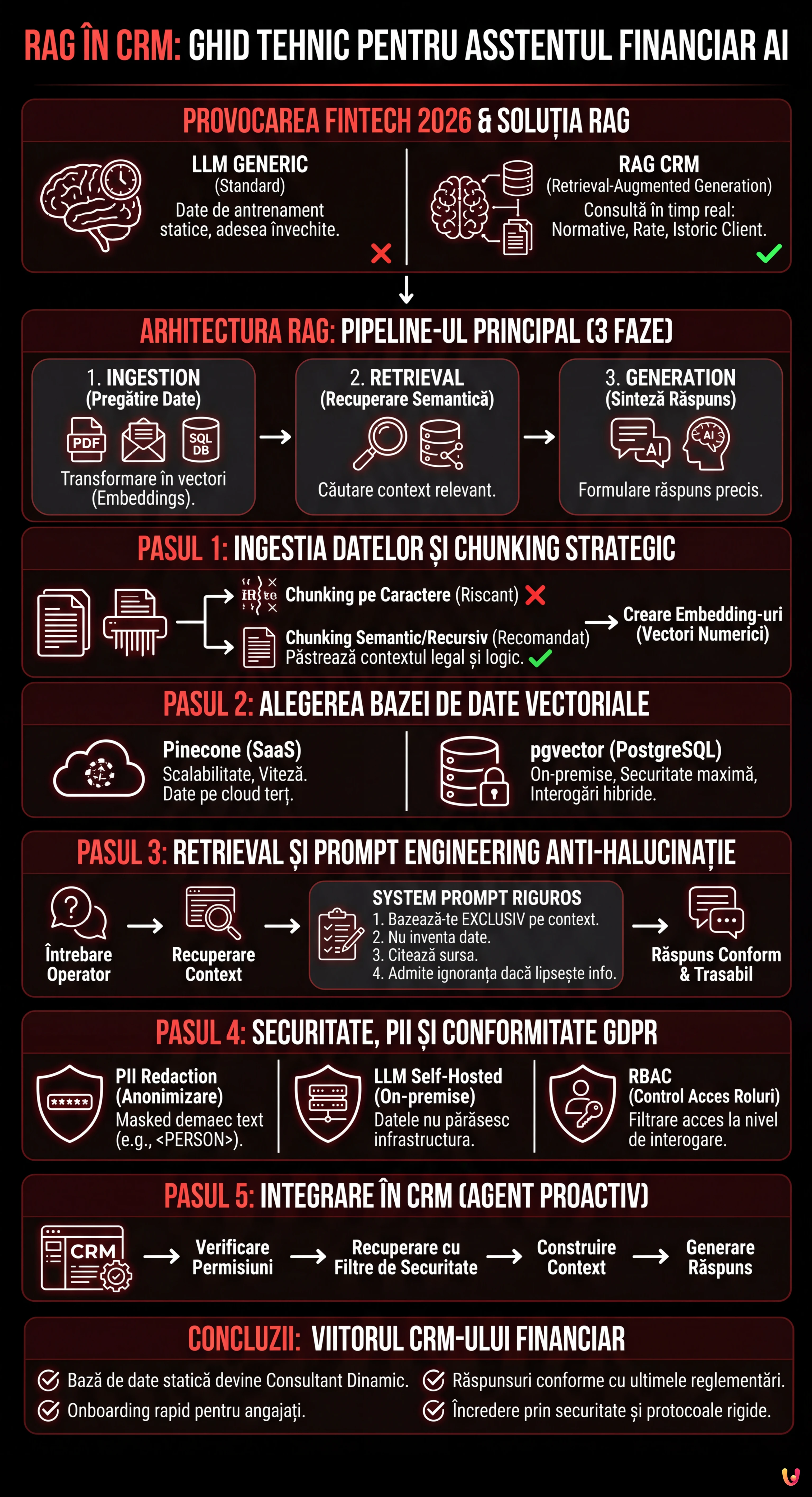

Arhitectura RAG potențează CRM-urile financiare consultând normative și date despre clienți în timp real pentru a genera răspunsuri precise și fără halucinații.

Pipeline-ul tehnic integrează ingestia semantică, baze de date vectoriale și prompt engineering pentru a transforma documente complexe în consultanță financiară sigură și complet trasabilă.

Utilizarea strategică a pgvector și chunking-ul avansat permite construirea de asistenți virtuali capabili să pre-califice lead-uri și să gestioneze credite garantând conformitatea.

Diavolul se ascunde în detalii. 👇 Continuă să citești pentru a descoperi pașii critici și sfaturile practice pentru a nu greși.

Suntem în 2026 și integrarea Inteligenței Artificiale în sistemele de afaceri nu mai este o noutate, ci un standard operațional. Totuși, în sectorul fintech și imobiliar, provocarea nu este doar generarea de text, ci generarea de răspunsuri precise, trasabile și conforme. Aici intervine arhitectura RAG în CRM (Retrieval-Augmented Generation). Spre deosebire de un LLM generic care se bazează doar pe setul său de antrenament (adesea învechit), un sistem RAG permite CRM-ului vostru proprietar (cum ar fi BOMA sau soluții personalizate) să consulte în timp real documentația normativă, ratele actuale ale dobânzilor și istoricul clientului înainte de a formula un răspuns.

În această analiză tehnică aprofundată, vom explora cum să construim un asistent financiar inteligent capabil să pre-califice lead-uri și să ofere consultanță privind creditele, minimizând halucinațiile și garantând securitatea maximă a datelor.

Arhitectura RAG în Context Financiar

Implementarea RAG în CRM necesită un pipeline robust compus din trei faze principale: Ingestion (pregătirea datelor), Retrieval (recuperare semantică) și Generation (sinteza răspunsului). În contextul unui CRM financiar, datele nu sunt doar text liber, ci o combinație de:

- Date Nestructurate: PDF-uri cu reglementări bancare, politici de creditare, transcrieri de email-uri.

- Date Structurate: Fișe clienți, scoring de credit, rate LTV (Loan-to-Value) prezente în baza de date SQL.

Obiectivul este transformarea acestor date în vectori numerici (embedding) pe care LLM-ul să îi poată “înțelege” și interoga.

Pasul 1: Ingestia Datelor și Chunking Strategic

Primul pas este transformarea documentației (ex. “Ghid Credite 2026.pdf”) în fragmente gestionabile. Nu putem introduce un manual întreg de 500 de pagini în fereastra de context a LLM-ului. Trebuie să împărțim textul în chunks.

Pentru documente financiare, un chunking bazat pur pe caractere este riscant deoarece ar putea rupe o clauză legală la jumătate. Folosim o abordare semantică sau recursivă.

Exemplu de Cod: Pipeline de Ingestie cu LangChain

Iată cum să implementați o funcție Python pentru a procesa documentele și a crea embedding-uri folosind OpenAI (sau modele open-source echivalente).

from langchain_community.document_loaders import PyPDFLoader

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_openai import OpenAIEmbeddings

import os

# Configurare API Key (gestionată prin variabile de mediu pentru securitate)

os.environ["OPENAI_API_KEY"] = "sk-..."

def process_financial_docs(file_path):

# 1. Încărcarea documentului

loader = PyPDFLoader(file_path)

docs = loader.load()

# 2. Chunking Strategic

# Dimensiune chunk de 1000 token-uri cu suprapunere de 200 pentru a menține contextul între fragmente

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000,

chunk_overlap=200,

separators=["nn", "n", " ", ""]

)

splits = text_splitter.split_documents(docs)

# 3. Crearea Embedding-urilor

# Folosim text-embedding-3-small pentru un echilibru bun cost/performanță

embeddings = OpenAIEmbeddings(model="text-embedding-3-small")

return splits, embeddingsPasul 2: Alegerea și Gestionarea Bazei de Date Vectoriale

Odată create embedding-urile, unde le arhivăm? Alegerea bazei de date vectoriale este critică pentru performanța RAG în CRM.

- Pinecone: Soluție gestionată (SaaS). Excelentă pentru scalabilitate și viteză, dar datele rezidă pe cloud-uri terțe. Ideal dacă politica companiei o permite.

- pgvector (PostgreSQL): Alegerea preferată pentru CRM-urile proprietare care folosesc deja Postgres. Permite executarea de interogări hibride (ex. “găsește documente similare semantic” AND “aparținând clientului ID=123”).

Dacă construim un asistent financiar intern, pgvector oferă avantajul de a menține datele vectoriale în același perimetru de securitate ca datele financiare structurate.

Pasul 3: Retrieval și Prompt Engineering Anti-Halucinație

Inima sistemului este recuperarea informațiilor pertinente. Când un operator întreabă CRM-ul: “Clientul Popescu poate accesa Creditul pentru Tineri cu un venit de 35k?”, sistemul trebuie să recupereze politicile referitoare la “Creditul pentru Tineri” și limitele de venit.

Totuși, recuperarea datelor nu este suficientă. Trebuie să instruim LLM-ul să nu inventeze. Acest lucru se obține printr-un System Prompt riguros.

Exemplu de Prompt Engineering Avansat

Folosim un șablon care forțează modelul să citeze sursele sau să își admită ignoranța.

SYSTEM_PROMPT = """

Ești un Asistent Financiar Senior integrat în CRM-ul BOMA.

Sarcina ta este să răspunzi la întrebări bazându-te EXCLUSIV pe contextul furnizat mai jos.

REGULI OPERAȚIONALE:

1. Dacă răspunsul nu este prezent în context, trebuie să răspunzi: "Îmi pare rău, politicile actuale nu acoperă acest caz specific."

2. Nu inventa rate ale dobânzii sau reguli nescrise.

3. Citează întotdeauna documentul de referință (ex. [Politica Credite v2.4]).

4. Menține un ton profesional și formal.

CONTEXT:

{context}

ÎNTREBARE UTILIZATOR:

{question}

"""Pasul 4: Securitate, PII și Conformitate GDPR

Integrarea RAG în CRM-ul financiar comportă riscuri enorme legate de confidențialitate. Nu putem trimite date sensibile (PII – Personally Identifiable Information) precum Coduri Numerice Personale (CNP), nume complete sau solduri bancare direct către API-urile OpenAI sau Anthropic fără precauții, în special sub GDPR.

Strategii de Protecție (Guardrails)

- PII Redaction (Anonimizare): Înainte de a trimite prompt-ul către LLM, utilizați biblioteci precum Microsoft Presidio pentru a identifica și masca datele sensibile. “Ion Popescu” devine “<PERSON>”.

- LLM Self-Hosted: Pentru securitate maximă, evaluați utilizarea modelelor open-source precum Llama 3 sau Mistral, găzduite pe servere proprietare (on-premise sau VPC privată). Acest lucru garantează că niciun fel de date nu părăsesc infrastructura companiei.

- Role-Based Access Control (RBAC): Sistemul RAG trebuie să respecte permisiunile CRM-ului. Un agent junior nu trebuie să poată interoga vectori referitori la documente rezervate direcțiunii. Acest filtru se aplică la nivel de interogare pe baza de date vectorială (Metadata Filtering).

Pasul 5: Orchestrare și Integrare în CRM

Ultima piesă este integrarea în frontend-ul CRM-ului. Asistentul nu trebuie să fie doar un chat, ci un agent proactiv. Iată un exemplu logic de structurare a apelului:

def get_crm_answer(user_query, user_id):

# 1. Verificare permisiuni utilizator

user_permissions = db.get_permissions(user_id)

# 2. Recuperare documente pertinente (Retrieval) cu filtre de securitate

docs = vector_store.similarity_search(

user_query,

k=3,

filter={"access_level": {"$in": user_permissions}}

)

# 3. Construirea contextului

context_text = "nn".join([d.page_content for d in docs])

# 4. Generare Răspuns (Generation)

response = llm_chain.invoke({"context": context_text, "question": user_query})

return responseConcluzii: Viitorul CRM-ului Financiar

Implementarea RAG în CRM transformă o bază de date statică într-un consultant dinamic. Pentru instituțiile financiare, acest lucru înseamnă reducerea timpului de onboarding pentru noii angajați (care au acces instantaneu la toată baza de cunoștințe a companiei) și garantarea faptului că fiecare răspuns oferit clientului este conform cu ultimele reglementări în vigoare.

Cheia succesului nu rezidă în cel mai puternic model, ci în calitatea pipeline-ului de date și în rigiditatea protocoalelor de securitate. În 2026, încrederea este cel mai prețios activ, iar o arhitectură RAG bine proiectată este cel mai bun instrument pentru a o păstra.

Întrebări frecvente

În timp ce un LLM generic se bazează pe date de antrenament statice și adesea învechite, o arhitectură RAG (Retrieval-Augmented Generation) integrată în CRM permite consultarea în timp real a documentelor companiei, a ratelor actuale ale dobânzilor și a istoricului clienților. Această abordare garantează răspunsuri bazate pe date proprietare actualizate, reducând riscul informațiilor obsolete și îmbunătățind conformitatea normativă în consultanța financiară.

Protecția datelor personale se realizează prin diverse strategii defensive. Este esențial să se aplice tehnici de PII Redaction pentru a anonimiza numele și codurile numerice personale înainte ca acestea să ajungă la modelul AI. În plus, utilizarea modelelor open-source găzduite pe servere proprietare și implementarea controalelor de acces bazate pe roluri (RBAC) asigură că informațiile sensibile nu părăsesc niciodată infrastructura companiei și sunt accesibile doar personalului autorizat.

Pentru documente legale și financiare, divizarea textului bazată pur pe caractere este nerecomandată deoarece riscă să rupă clauze importante. Strategia optimă prevede un chunking semantic sau recursiv, care menține unite paragrafele logice și utilizează un sistem de suprapunere (overlap) între fragmente. Această metodă păstrează contextul necesar pentru ca inteligența artificială să poată interpreta corect reglementările în timpul fazei de recuperare.

Utilizarea pgvector pe PostgreSQL este adesea preferabilă pentru CRM-urile proprietare deoarece permite menținerea datelor vectoriale (embedding) în același perimetru de securitate cu datele structurate ale clienților. Spre deosebire de soluțiile SaaS externe, această configurație facilitează executarea de interogări hibride care combină căutarea semantică cu filtre SQL tradiționale, oferind un control mai mare asupra confidențialității și reducând latența rețelei.

Prompt Engineering-ul avansat acționează ca un filtru de securitate instruind modelul să se bazeze exclusiv pe contextul furnizat. Printr-un System Prompt riguros, se impune asistentului să citeze sursele documentare specifice pentru fiecare afirmație și să admită explicit ignoranța dacă răspunsul nu este prezent în politicile companiei, împiedicând astfel generarea de rate sau reguli financiare inexistente.

Surse și Aprofundare

- Lucrarea de cercetare originală: Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks

- Comisia Europeană: Legea privind Inteligența Artificială (AI Act)

- IBM Research: Ce este arhitectura RAG (Retrieval-Augmented Generation)

- Regulamentul General privind Protecția Datelor (GDPR) în contextul datelor clienților

Ați găsit acest articol util? Există un alt subiect pe care ați dori să-l tratez?

Scrieți-l în comentariile de mai jos! Mă inspir direct din sugestiile voastre.