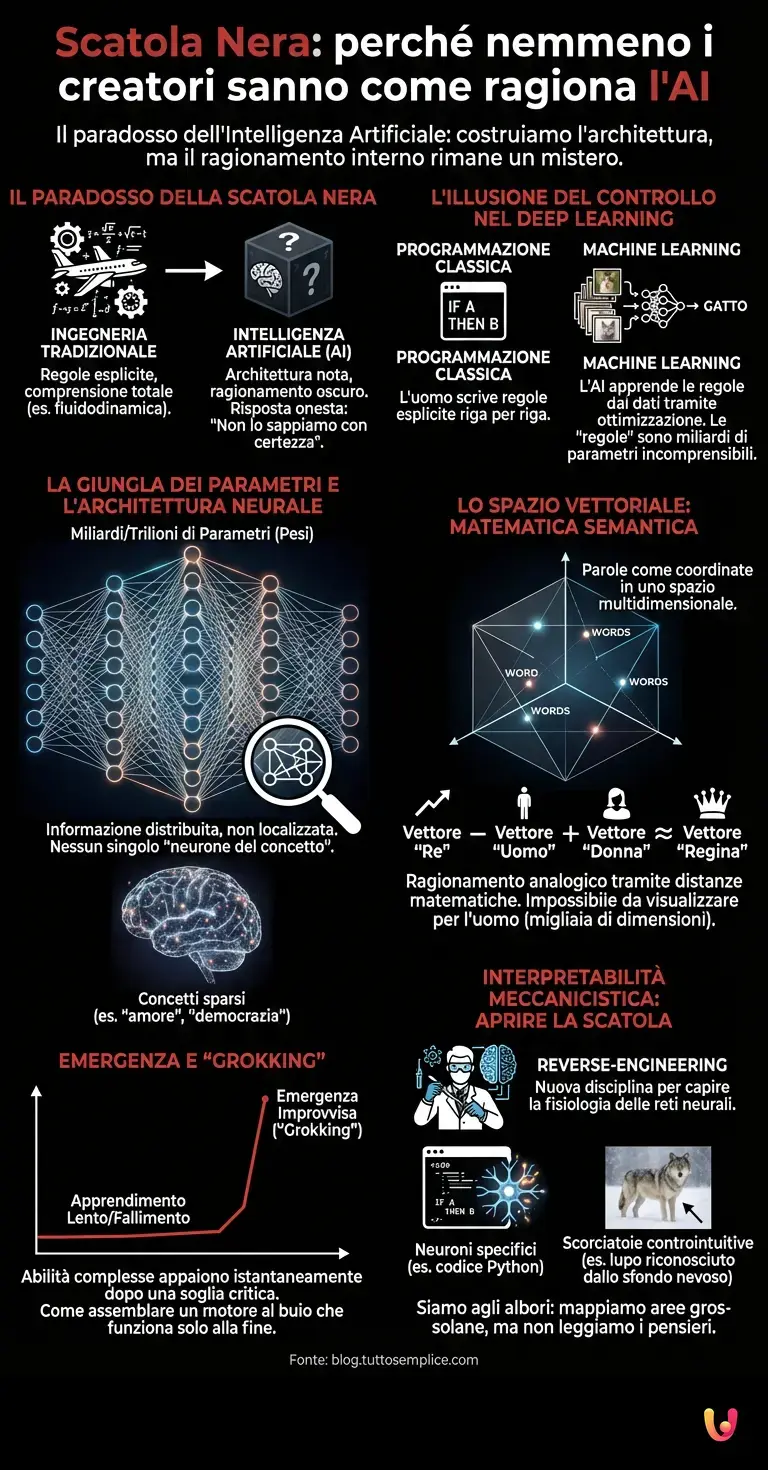

C’è un paradosso affascinante e al contempo inquietante che aleggia nei laboratori di ricerca della Silicon Valley e nei centri di calcolo di tutto il mondo. Riguarda la natura stessa della Rete Neurale, l’architettura fondamentale che alimenta i moderni sistemi di intelligenza artificiale. Se chiedeste a un ingegnere aerospaziale come vola un aereo, vi risponderebbe con equazioni precise sulla fluidodinamica. Se chiedeste a un orologiaio come funziona un cronografo, vi mostrerebbe ogni singolo ingranaggio. Ma se chiedete a un ricercatore di AI perché un modello linguistico ha scelto una specifica parola in una frase poetica o come ha risolto un problema di logica complessa, la risposta onesta è spesso un disarmante: “Non lo sappiamo con certezza”. Benvenuti nel problema della “Black Box”, o Scatola Nera.

L’illusione del controllo nel Deep Learning

Per comprendere questa curiosità, dobbiamo prima sfatare un mito comune: l’idea che l’intelligenza artificiale sia programmata riga per riga come un software tradizionale. In un programma classico, l’essere umano scrive regole esplicite: “Se succede A, allora fai B”. Nel machine learning, e ancor più nel deep learning, questo paradigma viene capovolto. Noi non scriviamo le regole; costruiamo un’architettura capace di apprenderle dai dati.

Immaginate di voler insegnare a un computer a riconoscere un gatto. Invece di descrivere geometricamente le orecchie a punta o i baffi, forniamo alla macchina milioni di immagini etichettate. L’algoritmo, attraverso un processo di ottimizzazione matematica, aggiusta autonomamente i suoi parametri interni per minimizzare l’errore. Alla fine del processo, il sistema riconosce il gatto con precisione sovrumana, ma le “regole” che ha dedotto per farlo sono sepolte in una matrice di miliardi di numeri incomprensibili per la mente umana.

La giungla dei parametri e l’architettura neurale

Il cuore del mistero risiede nella complessità dell’architettura neurale. I moderni LLM (Large Language Models) come le versioni avanzate di ChatGPT o i suoi concorrenti open-source, non sono composti da poche centinaia di neuroni artificiali, ma da centinaia di miliardi, se non trilioni, di parametri. Ogni parametro è un piccolo “peso” numerico che determina quanto forte è la connessione tra due neuroni simulati.

Quando inviate un prompt a un’AI, il vostro input viene trasformato in numeri e passa attraverso questa immensa rete. Ogni strato della rete elabora l’informazione, estraendo caratteristiche sempre più astratte, fino a produrre l’output finale. Il problema è che non esiste una mappa che ci dica: “Il neurone 4.567.890 nel livello 32 si attiva quando si parla di filosofia francese”. L’informazione è distribuita in modo diffuso. Un concetto come “amore” o “democrazia” non risiede in un singolo punto, ma è spalmato attraverso migliaia di connessioni in uno spazio vettoriale multidimensionale.

Lo spazio vettoriale: dove la matematica diventa semantica

Qui entriamo in uno degli aspetti più affascinanti del progresso tecnologico attuale. Per un’AI, le parole non sono simboli linguistici, ma coordinate in uno spazio geometrico a migliaia di dimensioni. In questo spazio, la distanza matematica tra le parole riflette la loro relazione semantica. “Re” meno “Uomo” più “Donna” porta il vettore risultante vicino a “Regina”.

Questa rappresentazione geometrica del significato permette agli algoritmi di compiere ragionamenti analogici sorprendenti. Tuttavia, visualizzare uno spazio a 10.000 dimensioni è impossibile per il cervello umano, evolutosi per navigare in tre dimensioni spaziali. Di conseguenza, le “traiettorie di pensiero” che l’AI percorre per arrivare a una conclusione rimangono oscure. Vediamo l’input e l’output, ma il viaggio intermedio avviene in una dimensione matematica che possiamo calcolare, ma non intuire.

Il fenomeno dell’Emergenza e la “Grokking”

Una delle curiosità più recenti che ha lasciato perplessi gli scienziati è il fenomeno dell’emergenza, talvolta definito “Grokking”. Durante l’addestramento, capita che un modello sembri non imparare nulla per molto tempo, fallendo miseramente nei benchmark di valutazione. Poi, improvvisamente, superata una certa soglia di dati o di potenza di calcolo, l’abilità “emerge” quasi istantaneamente. Il modello passa dal non saper fare una somma a risolverla perfettamente.

Perché accade? Si ipotizza che la rete neurale stia internamente costruendo circuiti logici complessi che non funzionano finché non sono completi. È come se stesse assemblando un motore al buio: il motore non parte finché l’ultimo bullone non è stretto, ma una volta fatto, funziona perfettamente. Questo comportamento non lineare rende difficile prevedere quali capacità un modello svilupperà semplicemente scalandone le dimensioni.

L’Interpretabilità Meccanicistica: aprire la scatola

Nonostante l’aura di mistero, la scienza non sta a guardare. È nata una nuova disciplina chiamata “Interpretabilità Meccanicistica”. L’obiettivo è fare il reverse-engineering delle reti neurali, simile a come un biologo disseziona un organismo per capirne la fisiologia. I ricercatori stanno cercando di individuare specifici gruppi di neuroni responsabili di compiti precisi.

Sono stati scoperti, ad esempio, neuroni che si attivano solo in presenza di codice Python, o neuroni che reagiscono a concetti emotivi specifici. Tuttavia, siamo ancora agli albori. Se l’AI fosse un cervello umano, saremmo appena riusciti a mappare qualche area grossolana, ma saremmo ancora lontani dal leggere i pensieri. La sfida è che l’automazione cognitiva dell’AI spesso trova scorciatoie controintuitive: un modello potrebbe classificare un’immagine come “lupo” non perché riconosce l’animale, ma perché ha imparato che lo sfondo bianco (neve) è spesso associato ai lupi nei dati di addestramento. Queste correlazioni spurie sono invisibili senza un’analisi profonda della “Black Box”.

In Breve (TL;DR)

I moderni sistemi di intelligenza artificiale restano una scatola nera persino per i creatori, che non ne comprendono appieno i processi decisionali.

Diversamente dai software classici, le reti neurali apprendono autonomamente in spazi multidimensionali dove le informazioni sono distribuite su miliardi di parametri.

Fenomeni imprevedibili come l’emergenza mostrano come abilità complesse scaturiscano improvvisamente da architetture matematiche che possiamo calcolare ma non intuire.

Conclusioni

La curiosità che circonda l’intelligenza artificiale non riguarda solo ciò che può fare, ma il come lo fa. Viviamo in un’epoca storica unica, in cui abbiamo creato macchine che pensano (o simulano il pensiero) in modi che i loro stessi creatori faticano a decifrare completamente. La “Scatola Nera” non è un difetto di fabbricazione, ma una caratteristica intrinseca del deep learning: la complessità necessaria per emulare l’intelligenza sembra richiedere un livello di opacità strutturale.

Mentre ci affidiamo sempre più a questi sistemi per decisioni mediche, finanziarie o legali, la spinta verso la trasparenza algoritmica diventa cruciale. Non basta che l’AI funzioni; dobbiamo capire il perché. Fino ad allora, ogni conversazione con un’intelligenza artificiale rimarrà, in parte, un dialogo con l’ignoto, un confronto con una logica aliena costruita dalle nostre stesse mani.

Domande frequenti

Il problema della Scatola Nera, o Black Box, si riferisce all’impossibilità di comprendere appieno i processi decisionali interni delle moderne reti neurali. A differenza dei software tradizionali, dove le regole sono scritte esplicitamente dall’uomo, i modelli di deep learning apprendono autonomamente analizzando enormi quantità di dati. Anche se i ricercatori conoscono l’architettura e gli algoritmi di ottimizzazione, il modo specifico in cui l’AI elabora le informazioni attraverso miliardi di parametri rimane oscuro. Non esiste una mappa chiara che spieghi perché il modello scelga una determinata parola o soluzione, rendendo il processo logico intermedio inaccessibile alla comprensione umana diretta.

La differenza fondamentale risiede nell’approccio alle regole. Nella programmazione classica, l’essere umano scrive istruzioni precise secondo la logica se succede questo, allora fai quello. Nel machine learning e nel deep learning, questo paradigma viene capovolto: non si forniscono regole, ma un’architettura capace di dedurle dai dati. Fornendo milioni di esempi, l’algoritmo aggiusta autonomamente i propri parametri interni per minimizzare l’errore. Di conseguenza, le regole che governano il comportamento dell’AI non sono scritte nel codice, ma sono sepolte in una matrice numerica complessa generata durante l’addestramento.

I moderni modelli linguistici (LLM) trasformano le parole in coordinate numeriche all’interno di uno spazio vettoriale a migliaia di dimensioni. In questo sistema geometrico, la distanza matematica tra i vettori rappresenta la relazione semantica tra i concetti. I parametri, che possono essere centinaia di miliardi, agiscono come pesi che determinano la forza delle connessioni tra i neuroni artificiali. L’informazione non è archiviata in un singolo punto, ma è distribuita in modo diffuso attraverso la rete. Questo permette all’AI di calcolare traiettorie di pensiero matematiche che risultano impossibili da visualizzare o intuire per la mente umana.

Il Grokking, o fenomeno dell’emergenza, è un comportamento curioso osservato durante l’addestramento delle reti neurali. Accade quando un modello sembra non imparare nulla e fallisce nei test per un lungo periodo, per poi acquisire improvvisamente una capacità complessa una volta superata una certa soglia di dati o calcolo. Gli scienziati ipotizzano che la rete stia costruendo internamente circuiti logici complessi che non funzionano finché non sono completati, simile all’assemblaggio di un motore che non parte finché l’ultimo pezzo non è al suo posto. Questo rende l’apprendimento dell’AI non lineare e difficile da prevedere.

L’interpretabilità meccanicistica è una nuova disciplina scientifica che mira ad aprire la Scatola Nera dell’AI attraverso il reverse-engineering. L’obiettivo è analizzare le reti neurali per individuare quali specifici gruppi di neuroni o circuiti siano responsabili di determinati compiti, concetti o emozioni. I ricercatori cercano di mappare il funzionamento interno del modello per capire se l’AI sta ragionando correttamente o se sta utilizzando scorciatoie logiche errate, come associazioni casuali presenti nei dati di addestramento. Questa trasparenza è cruciale per l’adozione sicura dell’AI in settori delicati come la medicina o la legge.

Fonti e Approfondimenti

- Wikipedia: Definizione e funzionamento delle Reti Neurali Artificiali

- DARPA: Il programma di ricerca sulla Explainable AI (XAI)

- Wikipedia: Deep learning e livelli di astrazione dei dati

- Commissione Europea: L’approccio europeo all’eccellenza e alla fiducia nell’IA

- NIST: Framework governativo USA per la gestione dei rischi e la trasparenza dell’AI

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.