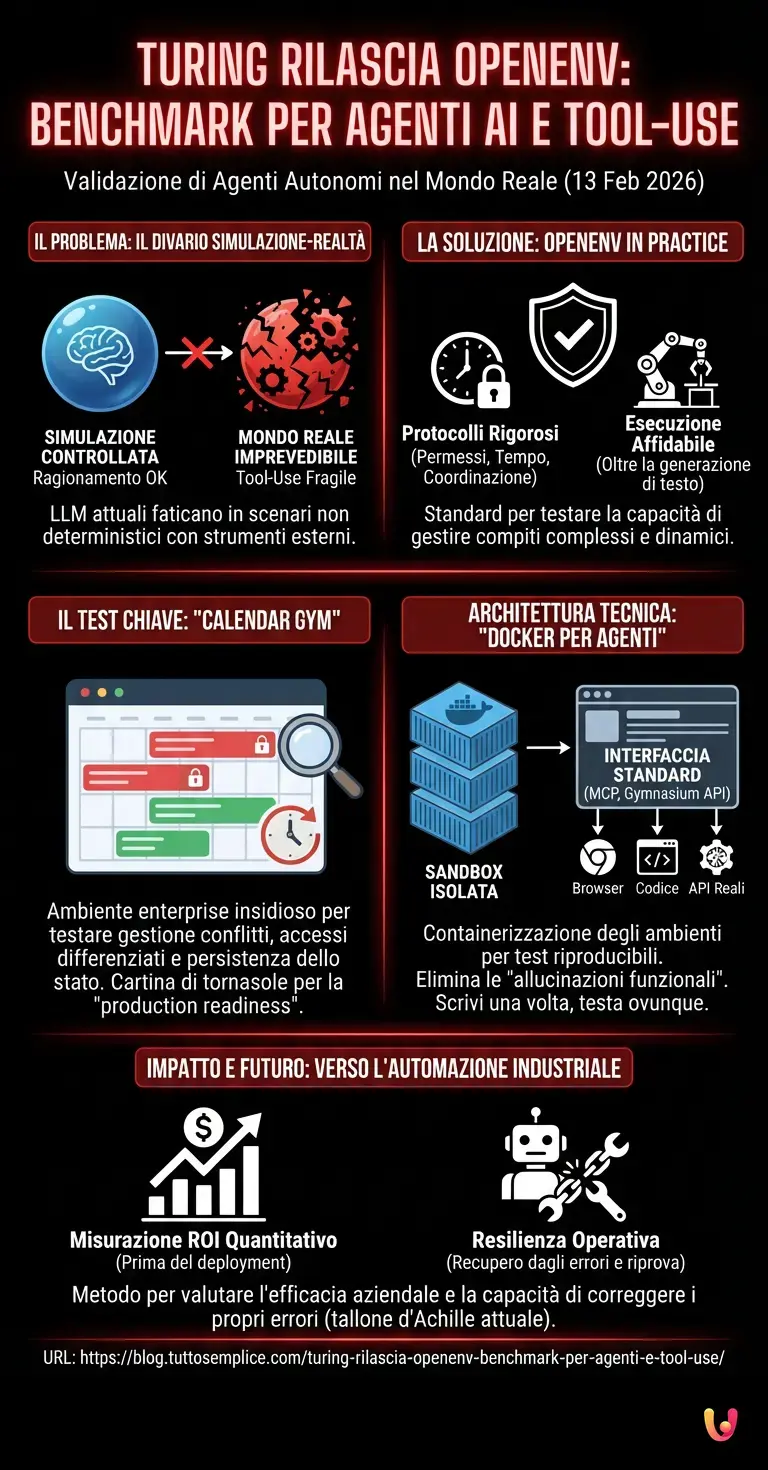

Nel panorama in rapida evoluzione dell’intelligenza artificiale, la data di oggi, 13 febbraio 2026, segna un punto di svolta fondamentale per la validazione degli agenti autonomi. L’organizzazione di ricerca Turing ha rilasciato ufficialmente il report tecnico e il benchmark intitolato “OpenEnv in Practice: Evaluating Tool-Using Agents in Real-World Environments”. Questo studio, che si innesta sul framework OpenEnv sviluppato in collaborazione tra Meta e Hugging Face, promette di risolvere uno dei problemi più ostici del settore: il divario prestazionale tra le simulazioni di ricerca controllate e l’imprevedibilità degli ambienti di produzione reali.

L’annuncio odierno mette in luce le limitazioni degli attuali Large Language Models (LLM) quando vengono chiamati a operare come agenti funzionali. Sebbene modelli come GPT-5 o Llama 4 abbiano dimostrato capacità di ragionamento eccezionali, la loro abilità di interagire con strumenti esterni (tool-use) in scenari non deterministici è spesso risultata fragile. Secondo quanto riportato da Turing, il nuovo standard introduce protocolli rigorosi per testare la capacità degli algoritmi di gestire permessi, ragionamento temporale e coordinazione multi-agente, spostando l’asticella dalla semplice generazione di testo all’esecuzione affidabile di compiti complessi.

Il Paradosso della Semplicità: Il Caso “Calendar Gym”

Il cuore pulsante della pubblicazione di Turing è l’introduzione di “Calendar Gym”, un ambiente di test apparentemente banale ma tecnicamente insidioso. A differenza dei classici benchmark basati su videogiochi o coding statico, Calendar Gym simula un sistema di gestione appuntamenti di livello enterprise. Qui, un agente AI non deve solo “prenotare una riunione”, ma deve navigare tra conflitti di orario, livelli di accesso differenziati (chi può vedere cosa) e la persistenza dello stato nel tempo.

Secondo i dati emersi dallo studio, molti agenti che ottengono punteggi elevati nei test accademici falliscono miseramente in questo ambiente. La necessità di mantenere una “memoria” coerente delle azioni passate e di comprendere le conseguenze future di una modifica al calendario mette a dura prova le attuali architetture neurali. Questo ambiente funge da cartina di tornasole per la production readiness: se un’IA non riesce a gestire un calendario condiviso senza creare conflitti o violare la privacy, non può essere affidata a compiti critici come la gestione finanziaria o l’accesso a database aziendali.

Architettura Tecnica: Standardizzare l’Imprevedibile

Sotto il profilo tecnico, OpenEnv si propone come il “Docker per gli agenti AI”. Il framework utilizza un’interfaccia standardizzata basata sul protocollo MCP (Model Context Protocol) e sulle API in stile Gymnasium (reset, step, action, observation), familiari a chiunque lavori nel machine learning e nel reinforcement learning. La grande innovazione risiede nella containerizzazione degli ambienti: ogni test avviene in una sandbox isolata che replica fedelmente le API del mondo reale, inclusi i browser e i repository di codice.

Questa standardizzazione permette agli sviluppatori di scrivere un agente una sola volta e testarlo su decine di ambienti diversi senza dover riscrivere il codice di interfaccia. L’approccio mira a eliminare le “allucinazioni funzionali”, ovvero quei casi in cui l’IA crede di aver eseguito un’azione (come inviare una mail) senza che il sistema sottostante l’abbia effettivamente processata. L’integrazione profonda con l’ecosistema Hugging Face garantisce inoltre che questi benchmark siano accessibili e riproducibili dalla comunità globale di ricerca.

Dalla Teoria all’Automazione Industriale

L’impatto di OpenEnv in Practice va oltre la semplice metrica accademica. Per le aziende che stanno investendo massicciamente nell’automazione dei processi, questo strumento offre finalmente un metodo quantitativo per misurare il ROI (Return on Investment) degli agenti AI prima del deployment. Fino a ieri, l’unico modo per verificare se un agente fosse capace di gestire un workflow aziendale era metterlo in produzione, con tutti i rischi annessi.

Il progresso tecnologico in questo campo sta accelerando verso sistemi “agentici” capaci di lunghe catene di ragionamento (long-horizon reasoning). Tuttavia, come evidenziato dagli autori del report, la capacità di recuperare dagli errori (error recovery) rimane il tallone d’Achille. In un ambiente OpenEnv, se un agente fallisce una chiamata API, deve dimostrare di saper leggere il messaggio di errore, correggere i parametri e riprovare, esattamente come farebbe un operatore umano esperto. È questa resilienza operativa che Turing e i suoi partner stanno cercando di codificare e misurare.

In Breve (TL;DR)

Turing presenta OpenEnv, un benchmark sviluppato con Meta e Hugging Face per colmare il divario tra simulazione e realtà operativa.

Il protocollo include Calendar Gym, un ambiente complesso che testa la capacità degli agenti di gestire privacy, orari e conflitti.

Questa standardizzazione permette alle aziende di valutare concretamente l’efficacia e la resilienza degli agenti AI prima dell’utilizzo produttivo.

Conclusioni

Con il rilascio di “OpenEnv in Practice”, Turing, in concerto con Meta e Hugging Face, ha definito un nuovo standard de facto per l’industria dell’Intelligenza Artificiale. Non è più sufficiente che un modello sappia “parlare” correttamente; ora deve dimostrare di saper “agire” in modo sicuro e prevedibile all’interno di infrastrutture digitali complesse. Questo passaggio dai benchmark statici agli ambienti dinamici e stateful rappresenta la maturazione necessaria affinché l’AI possa integrarsi profondamente nel tessuto produttivo reale, trasformando la promessa dell’automazione intelligente in una realtà ingegneristica affidabile.

Domande frequenti

OpenEnv rappresenta un nuovo standard sviluppato da Turing, in collaborazione con Meta e Hugging Face, per validare le capacità degli agenti autonomi in scenari reali. Questo framework agisce come un sistema di containerizzazione che permette di testare l affidabilità degli algoritmi nell uso di strumenti esterni, colmando il divario tra le simulazioni accademiche e le imprevedibili necessità degli ambienti di produzione.

Calendar Gym è un ambiente di test che simula la gestione di appuntamenti aziendali, mettendo alla prova la capacità dell IA di gestire permessi, conflitti orari e la persistenza della memoria nel tempo. Se un agente fallisce in questo compito apparentemente semplice, dimostra di non essere pronto per gestire operazioni critiche come l accesso a database finanziari o dati sensibili, evidenziando i limiti delle attuali architetture neurali.

Questo strumento fornisce alle imprese un metodo quantitativo per misurare il ritorno sull investimento degli agenti AI prima che vengano messi in produzione, riducendo i rischi operativi. Grazie alla simulazione di errori reali, le aziende possono verificare se l agente è in grado di recuperare dai fallimenti delle API e correggere i propri parametri autonomamente, garantendo una resilienza operativa indispensabile per i flussi di lavoro aziendali.

Le allucinazioni funzionali si verificano quando un modello di intelligenza artificiale crede erroneamente di aver eseguito un azione, come l invio di una email, senza che il sistema sottostante l abbia realmente processata. OpenEnv risolve questo problema verificando l effettiva esecuzione dei comandi tramite protocolli standardizzati, assicurando che l IA non si limiti a generare testo ma compia azioni concrete e verificabili.

Il framework utilizza un approccio simile a Docker, impiegando interfacce standard basate sul protocollo MCP e API in stile Gymnasium per creare sandbox isolate e riproducibili. Questa struttura permette agli sviluppatori di scrivere il codice dell agente una sola volta e testarlo su molteplici ambienti diversi, replicando fedelmente browser e repository di codice per una valutazione precisa delle capacità di tool-use.

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.