In Breve (TL;DR)

Scopri come installare e utilizzare Ollama su PC e Mac per sfruttare la potenza dell’intelligenza artificiale direttamente sul tuo hardware, garantendo la massima privacy.

Scopri come sfruttare la potenza dei modelli LLM direttamente sul tuo hardware, proteggendo la tua privacy e lavorando senza dipendere dal cloud.

Scopri come sfruttare la potenza dei modelli LLM direttamente sul tuo hardware per garantire la massima privacy e indipendenza dal cloud.

Il diavolo è nei dettagli. 👇 Continua a leggere per scoprire i passaggi critici e i consigli pratici per non sbagliare.

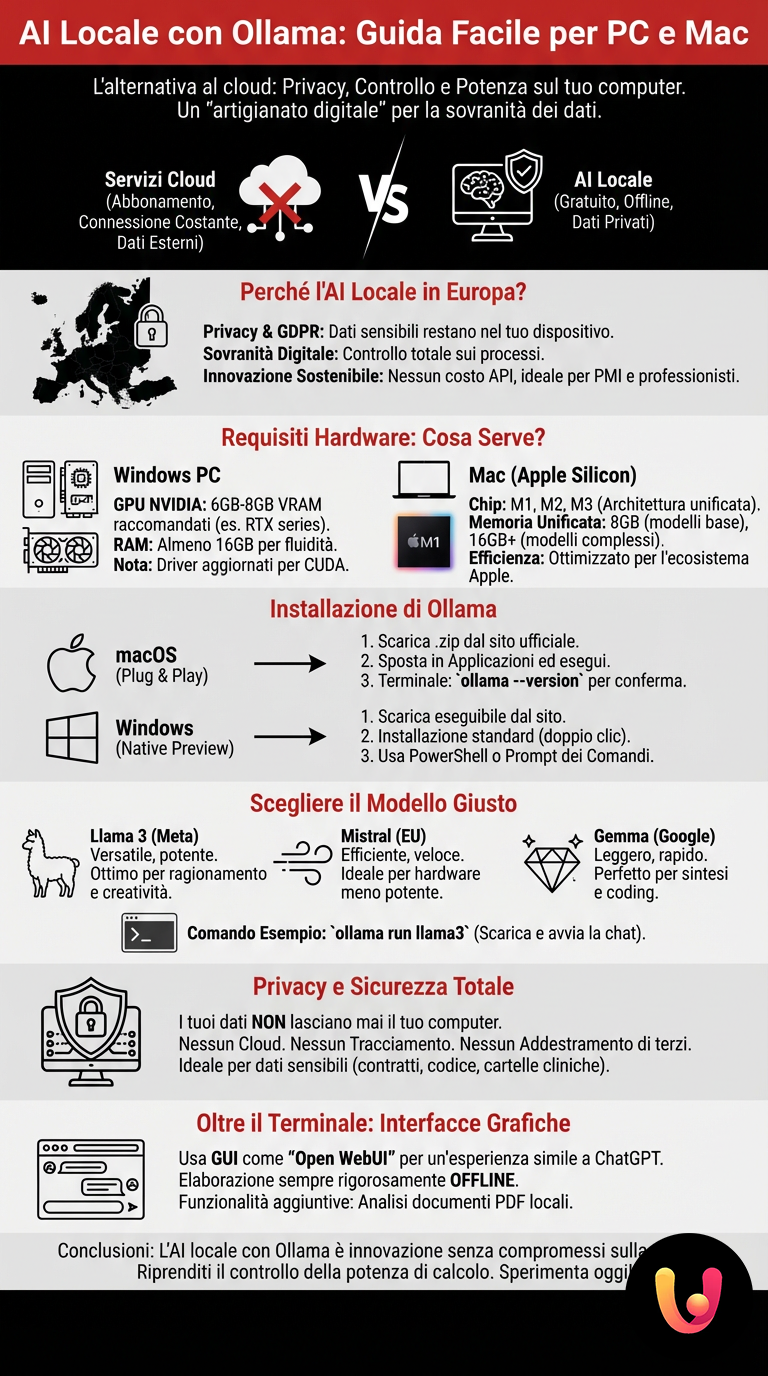

L’intelligenza artificiale sta trasformando radicalmente il nostro modo di lavorare e creare, ma spesso ci troviamo legati a servizi cloud che richiedono un abbonamento e una connessione internet costante. Esiste però un’alternativa che sta guadagnando terreno, specialmente in Europa dove la privacy è una priorità assoluta: l’esecuzione di modelli AI direttamente sul proprio computer. Questa pratica, che potremmo definire come un “artigianato digitale”, permette di riappropriarsi dei propri dati e della potenza di calcolo.

Ollama rappresenta oggi la soluzione più elegante e accessibile per portare i grandi modelli linguistici (LLM) sui nostri dispositivi domestici o lavorativi. Che si tratti di un PC Windows assemblato per il gaming o di un MacBook utilizzato per la grafica, questo strumento abbatte le barriere tecniche. In questa guida esploreremo come installare e utilizzare Ollama, analizzando i requisiti hardware e i vantaggi concreti di avere un assistente intelligente che “vive” nel vostro computer, senza inviare un solo byte oltre i confini della vostra scrivania.

L’indipendenza tecnologica non è solo una questione di hardware, ma di controllo sui processi decisionali della macchina. Eseguire l’AI in locale è il primo passo verso la sovranità digitale personale.

Perché scegliere l’AI locale nel contesto europeo

Nel mercato europeo e italiano, la sensibilità verso la protezione dei dati personali è molto più alta rispetto ad altre aree geografiche. Utilizzare servizi come ChatGPT o Claude implica spesso l’invio di informazioni sensibili a server situati oltreoceano. L’esecuzione locale con Ollama risponde perfettamente alla normativa GDPR e alla cultura della riservatezza che caratterizza la nostra tradizione.

Inoltre, l’approccio locale favorisce l’innovazione sostenibile. Non dipendere da API costose permette a piccole imprese, studi legali o creativi freelance di sperimentare senza limiti di budget. È una democratizzazione della tecnologia che si sposa bene con il tessuto imprenditoriale italiano, fatto di realtà agili che necessitano di strumenti potenti ma flessibili. Per approfondire i temi legati alla sicurezza dei dati, vi consigliamo la lettura della nostra guida a Ollama e DeepSeek in locale.

Requisiti Hardware: Cosa serve per iniziare

Prima di procedere con l’installazione, è fondamentale capire se il vostro computer è all’altezza del compito. I modelli di linguaggio richiedono risorse specifiche, diverse da quelle necessarie per la navigazione web o l’ufficio standard. Il componente critico non è tanto il processore centrale (CPU), quanto la memoria RAM e la scheda video (GPU).

Per gli utenti Windows, una scheda video NVIDIA con almeno 6GB o 8GB di VRAM è altamente raccomandata per modelli di base. Se non disponete di una GPU dedicata, il sistema userà la RAM di sistema, ma sarà significativamente più lento. Si consigliano almeno 16GB di RAM totale per un’esperienza fluida. Per chi deve aggiornare il proprio setup, può essere utile consultare la nostra guida alla scelta di GPU e monitor per workstation.

Per gli utenti Mac, la situazione è spesso più rosea grazie all’architettura Apple Silicon (chip M1, M2, M3). La memoria unificata di questi processori permette di caricare modelli anche molto pesanti in modo efficiente. Un MacBook Air M1 con 8GB di RAM può già eseguire modelli leggeri, mentre per modelli più complessi sono preferibili 16GB o più.

Installazione di Ollama su macOS

L’ecosistema Apple è attualmente il terreno più fertile per Ollama, grazie all’ottimizzazione per i chip Silicon. La procedura è estremamente semplice e rispecchia la filosofia “plug and play” tipica della mela. Non servono competenze di programmazione avanzate per iniziare.

Basta recarsi sul sito ufficiale di Ollama e scaricare il file .zip dedicato a macOS. Una volta estratta l’applicazione, spostatela nella cartella Applicazioni ed eseguitela. Si aprirà un terminale che vi guiderà nei primi passi. Il sistema installerà automaticamente le dipendenze necessarie per comunicare con l’hardware.

Dopo l’installazione, aprite il terminale di sistema. Digitando il comando ollama --version, dovreste vedere il numero della versione installata. Questo conferma che il vostro Mac è pronto per scaricare il suo primo “cervello” digitale.

Installazione di Ollama su Windows

Fino a poco tempo fa, utilizzare Ollama su Windows richiedeva passaggi complessi tramite WSL (Windows Subsystem for Linux). Oggi, fortunatamente, esiste una versione “Preview” nativa che semplifica notevolmente il processo, rendendo l’AI accessibile a milioni di utenti PC.

Scaricate l’eseguibile per Windows dal sito ufficiale. L’installazione è standard: doppio clic e seguite le istruzioni a schermo. Una volta completato, Ollama girerà in background. Potrete interagire con esso tramite PowerShell o il Prompt dei Comandi. Se non avete familiarità con questi strumenti, vi suggeriamo di leggere la nostra guida completa alle scorciatoie e gestione di Windows.

Nota tecnica: Su Windows, assicuratevi di avere i driver della scheda video aggiornati. Ollama cercherà automaticamente di utilizzare i core CUDA delle schede NVIDIA per accelerare le risposte.

Scegliere il modello giusto: Llama 3, Mistral e Gemma

Ollama è come un lettore multimediale: ha bisogno di un file da riprodurre. In questo caso, i file sono i “modelli”. Esistono diverse opzioni, ognuna con caratteristiche uniche, simili a diversi dialetti o specializzazioni professionali.

- Llama 3: Sviluppato da Meta, è attualmente uno degli standard di riferimento per versatilità e potenza. È ottimo per ragionamento logico e scrittura creativa.

- Mistral: Un modello europeo (francese) molto efficiente. Spesso supera modelli più grandi in termini di velocità e precisione, perfetto per hardware meno potente.

- Gemma: La proposta open di Google, leggera e veloce, ideale per compiti di sintesi e coding rapido.

Per scaricare ed eseguire, ad esempio, Llama 3, basta digitare nel terminale il comando: ollama run llama3. Il software scaricherà automaticamente i gigabyte necessari (solitamente circa 4GB per la versione base) e avvierà la chat.

Privacy e Sicurezza: I tuoi dati restano a casa

Il vantaggio incommensurabile di questa tecnologia è la privacy. Quando chiedete a un’AI locale di analizzare un contratto, riassumere una cartella clinica o correggere una bozza riservata, nessun dato lascia il vostro computer. Non c’è cloud, non c’è tracciamento, non c’è addestramento sui vostri dati da parte di terzi.

Questo aspetto è cruciale per professionisti come avvocati, medici o sviluppatori che lavorano su codice proprietario. In un’epoca in cui le violazioni dei dati sono all’ordine del giorno, l’AI locale funge da cassaforte intelligente. Per una visione più ampia sul futuro di questi strumenti, potete consultare la nostra analisi sull’AI generativa e il futuro della sicurezza.

Interfacce Grafiche: Oltre il Terminale

Sebbene Ollama funzioni nativamente da riga di comando, molti utenti preferiscono un’interfaccia visiva simile a quella di ChatGPT. La comunità open source ha creato strumenti fantastici come “Open WebUI” o “Ollama WebUI”. Questi programmi si collegano a Ollama e offrono una finestra di chat nel browser.

Installare queste interfacce spesso richiede Docker, uno strumento per container software. Tuttavia, esistono anche applicazioni desktop “wrapper” che rendono l’esperienza utente immediata, permettendo di salvare le chat, organizzare i prompt e persino caricare documenti PDF per farli analizzare dall’AI, il tutto mantenendo l’elaborazione rigorosamente offline.

Conclusioni

Eseguire l’intelligenza artificiale in locale con Ollama rappresenta un perfetto connubio tra innovazione tecnologica e la tradizionale necessità di controllo e riservatezza. Non è solo una soluzione per “smanettoni”, ma una via percorribile per chiunque voglia sfruttare la potenza degli LLM senza compromessi sulla privacy. Che siate su un PC Windows da gaming o su un elegante Mac, la barriera all’ingresso non è mai stata così bassa.

Vi invitiamo a sperimentare. Iniziate con modelli piccoli, testate le capacità del vostro hardware e scoprite come l’AI possa diventare uno strumento personale, privato e incredibilmente potente. Il futuro dell’intelligenza artificiale non è solo nel cloud delle grandi corporation, ma anche nei chip dei nostri computer di casa.

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.