Kurz gesagt (TL;DR)

Der AI Act klassifiziert Kreditscoring als Hochrisiko-Anwendung und verpflichtet Finanzinstitute ab 2026 zu strenger Transparenz bei automatisierten Entscheidungen.

Entwickler müssen undurchsichtige Black-Box-Modelle durch Explainable AI wie SHAP ersetzen, um jede Kreditablehnung technisch und rechtlich sauber zu begründen.

Dieser technische Leitfaden verbindet regulatorische Compliance mit MLOps-Engineering und zeigt die praktische Integration von Erklärbarkeitsmodellen in produktive Cloud-Umgebungen.

Der Teufel steckt im Detail. 👇 Lesen Sie weiter, um die kritischen Schritte und praktischen Tipps zu entdecken, um keine Fehler zu machen.

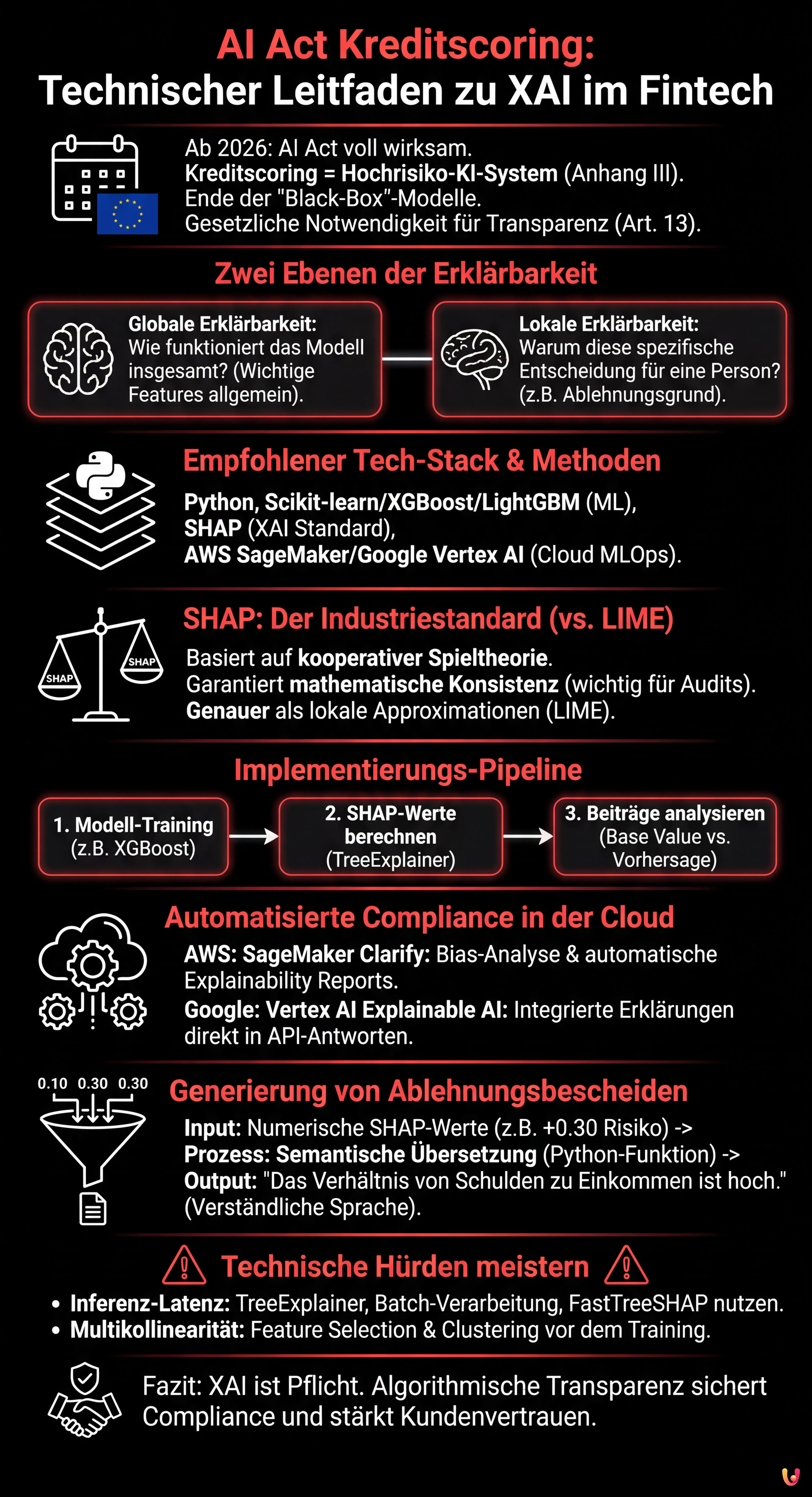

Wir schreiben das Jahr 2026 und die europäische Fintech-Landschaft hat sich radikal gewandelt. Mit der vollen Wirksamkeit der europäischen KI-Verordnung ist die Anpassung von ai act credit scoring-Systemen kein Wettbewerbsvorteil mehr, sondern eine gesetzliche Notwendigkeit. Systeme zur Bewertung der Kreditwürdigkeit werden gemäß Anhang III des AI Acts als High-Risk AI Systems (Hochrisiko-KI-Systeme) eingestuft. Dies bringt strenge Verpflichtungen hinsichtlich Transparenz und Erklärbarkeit mit sich (Artikel 13).

Für CTOs, Data Scientists und MLOps-Ingenieure bedeutet dies das Ende undurchschaubarer “Black-Box”-Modelle. Es reicht nicht mehr aus, dass ein XGBoost-Modell oder ein neuronales Netz eine AUC (Area Under Curve) von 0,95 aufweist; sie müssen erklären können, warum ein Hypothekendarlehen für einen bestimmten Kunden abgelehnt wurde. Dieser technische Leitfaden untersucht die Implementierung von Explainable AI (XAI) in Produktionspipelines und schließt die Lücke zwischen regulatorischer Compliance und Software-Engineering.

Die Transparenzanforderung im AI Act für Fintech

Der AI Act legt fest, dass Hochrisikosysteme so konzipiert sein müssen, dass ihre Funktionsweise transparent genug ist, damit Nutzer den Output des Systems interpretieren können. Im Kontext des Kreditscorings bedeutet dies zwei Ebenen der Erklärbarkeit:

- Globale Erklärbarkeit: Verstehen, wie das Modell insgesamt funktioniert (welche Features allgemein am stärksten gewichtet werden).

- Lokale Erklärbarkeit: Verstehen, warum das Modell eine spezifische Entscheidung für eine einzelne Person getroffen hat (z. B. “Die Hypothek wurde abgelehnt, weil das Verhältnis von Schulden zu Einkommen 40 % übersteigt”).

Das technische Ziel ist es, komplexe mathematische Vektoren in verständliche und rechtlich vertretbare Ablehnungsbescheide (Adverse Action Notices) umzuwandeln.

Voraussetzungen und Technologie-Stack

Um diesem Implementierungsleitfaden zu folgen, werden Kenntnisse in Python und den Grundprinzipien des maschinellen Lernens vorausgesetzt. Der Referenz-Stack umfasst:

- ML-Bibliotheken: Scikit-learn, XGBoost oder LightGBM (De-facto-Standard für tabellarische Daten im Kreditscoring).

- XAI-Bibliotheken: SHAP (SHapley Additive exPlanations) und LIME.

- Cloud-Provider: AWS SageMaker oder Google Vertex AI (für die MLOps-Orchestrierung).

Abkehr von der Black-Box: SHAP vs. LIME

Obwohl es inhärent interpretierbare Modelle gibt (wie logistische Regressionen oder flache Entscheidungsbäume), opfern diese oft die Vorhersagegenauigkeit. Die moderne Lösung ist die Verwendung komplexer Modelle (Ensemble-Methoden) in Kombination mit modellagnostischen Interpretationsmethoden.

Warum SHAP für Kreditscoring wählen?

Unter den verschiedenen Optionen hat sich SHAP zum Industriestandard für den Bankensektor entwickelt. Im Gegensatz zu LIME, das das Modell lokal approximiert, basiert SHAP auf der kooperativen Spieltheorie und garantiert drei grundlegende mathematische Eigenschaften: local accuracy, missingness und consistency. In einem regulierten Kontext wie dem ai act credit scoring bietet die mathematische Konsistenz von SHAP eine höhere Sicherheit im Falle eines Audits.

Schritt-für-Schritt-Implementierung: Von XGBoost zu SHAP

Nachfolgend ein praktisches Beispiel, wie SHAP in ein Risikoscoring-Modell integriert werden kann.

1. Training des Modells

Nehmen wir an, wir haben einen XGBoost-Klassifikator auf einem Datensatz von Kreditanträgen trainiert.

import xgboost as xgb

import shap

import pandas as pd

# Laden der Daten und Training (vereinfacht)

X, y = shap.datasets.adult() # Beispiel-Datensatz

model = xgb.XGBClassifier().fit(X, y)2. Berechnung der SHAP-Werte

Anstatt uns auf die Vorhersage zu beschränken, berechnen wir die Shapley-Werte für jede Instanz. Diese Werte geben an, wie stark jedes Feature dazu beigetragen hat, die Vorhersage im Vergleich zum Durchschnitt des Datensatzes (Base Value) zu verschieben.

# Initialisierung des Explainers

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X)

# Beispiel: Erklärung für Kunden-ID 0

print(f"Base Value: {explainer.expected_value}")

print(f"SHAP Values Kunde 0: {shap_values[0]}")Wenn der Base Value (durchschnittliche Ausfallwahrscheinlichkeit) 0,20 beträgt und die Vorhersage für den Kunden 0,65 ist, sagen uns die SHAP-Werte genau, welche Variablen diese +0,45 Risiko hinzugefügt haben (z. B. +0,30 für vergangene Zahlungsverzüge, +0,15 für geringe Beschäftigungsdauer).

MLOps-Integration in der Cloud: Automatisierung der Compliance

SHAP in einem Notebook auszuführen ist einfach, aber der AI Act erfordert kontinuierliche Überwachung und skalierbare Prozesse. Hier erfahren Sie, wie Sie XAI in Cloud-Pipelines integrieren.

AWS SageMaker Clarify

AWS bietet SageMaker Clarify, einen nativen Dienst, der sich in den Lebenszyklus des Modells integriert. Zur Konfiguration:

- Konfiguration des Prozessors: Während der Definition des Training-Jobs wird ein

SageMakerClarifyProcessorkonfiguriert. - Bias-Analyse: Clarify berechnet Bias-Metriken vor dem Training (z. B. Klassenungleichgewichte) und nach dem Training (z. B. Genauigkeitsunterschiede zwischen demografischen Gruppen), was für die vom AI Act geforderte Fairness unerlässlich ist.

- Explainability Report: Es wird eine SHAP-Konfiguration definiert (z. B.

SHAPConfig), die automatisch JSON-Berichte für jeden Inferenz-Endpunkt generiert.

Google Vertex AI Explainable AI

Ähnlich ermöglicht Vertex AI die Konfiguration der explanationSpec während des Hochladens des Modells. Google unterstützt nativ Sampled Shapley und Integrated Gradients. Der Vorteil hierbei ist, dass die Erklärung direkt in der API-Antwort zusammen mit der Vorhersage zurückgegeben wird, was die Latenz reduziert.

Automatische Generierung von “Adverse Action Notices”

Der letzte Schritt besteht darin, die numerischen SHAP-Werte in natürliche Sprache für den Endkunden zu übersetzen, um der Benachrichtigungspflicht nachzukommen.

Stellen wir uns eine Python-Funktion vor, die den Output verarbeitet:

def genera_spiegazione(shap_values, feature_names, threshold=0.1):

spiegazioni = []

for value, name in zip(shap_values, feature_names):

if value > threshold: # Positiver Beitrag zum Risiko

if name == "num_ritardi_pagamento":

spiegazioni.append("Das Vorhandensein von Verzögerungen bei jüngsten Zahlungen hat sich negativ ausgewirkt.")

elif name == "rapporto_debito_reddito":

spiegazioni.append("Das Verhältnis zwischen Ihren Schulden und Ihrem Einkommen ist hoch.")

return spiegazioniDiese semantische Übersetzungsschicht macht das System konform mit Artikel 13 des AI Acts, indem der Algorithmus für den nicht-technischen Nutzer transparent gemacht wird.

Fehlerbehebung und häufige Herausforderungen

Bei der Implementierung erklärbarer ai act credit scoring-Systeme stößt man oft auf technische Hindernisse:

1. Inferenz-Latenz

Die Berechnung von SHAP-Werten, insbesondere die exakte Methode bei tiefen Entscheidungsbäumen, ist rechenintensiv.

Lösung: Verwenden Sie TreeExplainer (optimiert für Bäume) anstelle von KernelExplainer. Berechnen Sie in der Produktion die Erklärungen asynchron (Batch-Verarbeitung), wenn keine sofortige Echtzeit-Antwort an den Nutzer erforderlich ist, oder verwenden Sie approximierte Versionen wie FastTreeSHAP.

2. Multikollinearität

Wenn zwei Features stark korreliert sind (z. B. “Jahreseinkommen” und “Monatseinkommen”), könnte SHAP die Wichtigkeit zwischen beiden aufteilen, was die Erklärung verwirrend macht.

Lösung: Führen Sie vor dem Training eine strenge Feature Selection und Entfernung redundanter Features durch. Verwenden Sie hierarchische Clustering-Techniken, um korrelierte Features zu gruppieren.

Fazit

Die Anpassung an den AI Act im Bereich Kreditscoring ist nicht nur eine bürokratische Übung, sondern eine technische Herausforderung, die die Qualität von Finanzsoftware steigert. Durch die Implementierung von XAI-basierten Architekturen wie SHAP und deren Integration in robuste MLOps-Pipelines auf SageMaker oder Vertex AI können Fintech-Unternehmen nicht nur die rechtliche Compliance sicherstellen, sondern auch das Vertrauen der Verbraucher stärken. Algorithmische Transparenz ist die neue Währung des digitalen Kredits.

Häufig gestellte Fragen

Die KI-Verordnung klassifiziert Systeme zur Bewertung der Kreditwürdigkeit gemäß Anhang III als Hochrisikosysteme. Diese Definition erlegt Fintech-Unternehmen strenge Transparenz- und Erklärbarkeitspflichten auf und zwingt zur Abkehr von Black-Box-Modellen. Es ist nun erforderlich, dass Algorithmen verständliche Begründungen für jede Entscheidung liefern, insbesondere im Falle einer Kreditablehnung.

Die globale Erklärbarkeit ermöglicht es, die Funktionsweise des Modells als Ganzes zu verstehen und zu identifizieren, welche Variablen allgemein das größte Gewicht haben. Die lokale Erklärbarkeit hingegen ist für die regulatorische Compliance entscheidend, da sie klärt, warum das Modell eine spezifische Entscheidung für einen einzelnen Kunden getroffen hat, was die Erstellung präziser Benachrichtigungen über die Gründe eines negativen Ergebnisses ermöglicht.

SHAP hat sich zum Industriestandard entwickelt, da es auf der kooperativen Spieltheorie basiert und mathematische Eigenschaften wie Konsistenz garantiert, was bei Audits essenziell ist. Im Gegensatz zu LIME, das lokale Approximationen liefert, berechnet SHAP den exakten Beitrag jedes Merkmals im Vergleich zum Durchschnitt und bietet so eine rechtlich solidere Rechtfertigung des Kreditscores.

Zur Automatisierung der Compliance können verwaltete Dienste wie AWS SageMaker Clarify oder Google Vertex AI genutzt werden. Diese Tools integrieren sich in den Lebenszyklus des Modells, um Bias-Metriken zu berechnen und automatisch SHAP-Erklärbarkeitsberichte für jede Inferenz zu generieren, was eine kontinuierliche Überwachung ohne übermäßigen manuellen Eingriff gewährleistet.

Die Berechnung von SHAP-Werten kann rechenintensiv sein und Antworten verlangsamen. Zur Minderung des Problems wird empfohlen, den TreeExplainer zu verwenden, der für Entscheidungsbäume optimiert ist, oder die Berechnung in asynchrone Batch-Prozesse zu verlagern, wenn keine sofortige Antwort benötigt wird. Eine weitere effektive Lösung ist die Verwendung schneller Approximationen wie FastTreeSHAP.

Quellen und Vertiefung

- Verordnung (EU) 2024/1689 des Europäischen Parlaments und des Rates (Gesetz über künstliche Intelligenz)

- Europäische Kommission: Das Gesetz über künstliche Intelligenz (AI Act)

- BaFin (Bundesanstalt für Finanzdienstleistungsaufsicht): Big Data und künstliche Intelligenz

- Wikipedia: Explainable Artificial Intelligence (XAI)

- Der Bundesbeauftragte für den Datenschutz: Automatisierte Entscheidungen und Profiling

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.