Kurz gesagt (TL;DR)

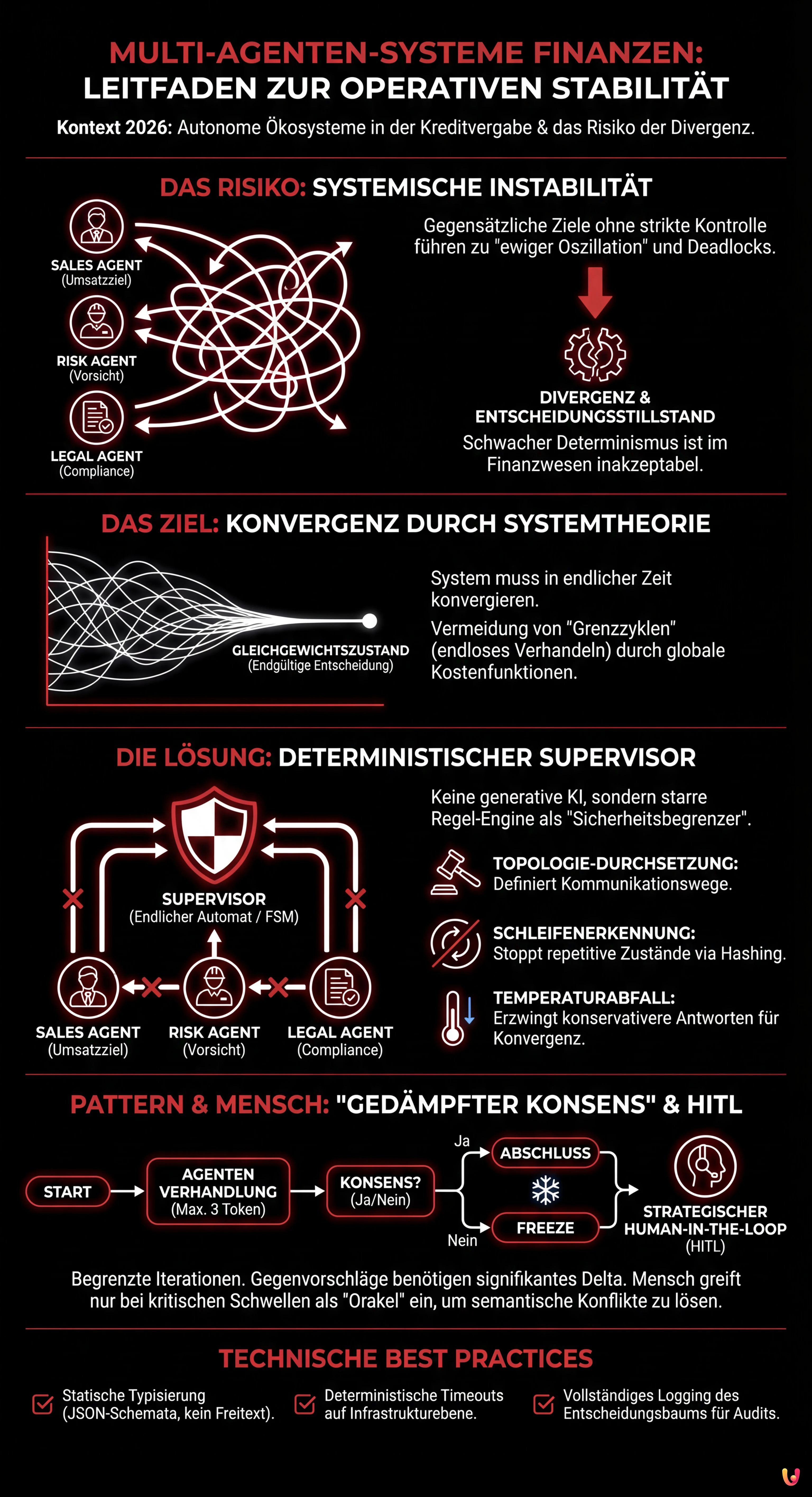

Der Übergang zu autonomen Multi-Agenten-Systemen im Finanzsektor erzeugt neue Risiken wie systemische Instabilität und endlose Entscheidungsschleifen.

Die Anwendung von Systemtheorie und Lyapunov-Stabilität gewährleistet, dass komplexe KI-Verhandlungen in endlicher Zeit zuverlässig konvergieren.

Deterministische Supervisoren verhindern als strikte Regelwächter technische Deadlocks und erzwingen durch Topologie-Kontrolle sichere Entscheidungen im Kreditwesen.

Der Teufel steckt im Detail. 👇 Lesen Sie weiter, um die kritischen Schritte und praktischen Tipps zu entdecken, um keine Fehler zu machen.

Im Panorama der Unternehmensautomatisierung des Jahres 2026 hat die Einführung von Multi-Agenten-Systemen im Finanzwesen die experimentelle Phase hinter sich gelassen und ist zur Referenzarchitektur in den Pipelines der Kreditvergabe geworden. Der Übergang von einzelnen LLMs (Large Language Models) zu Ökosystemen autonomer, kollaborativer Agenten hat jedoch eine neue Klasse von Risiken eingeführt: die systemische Instabilität. Wenn Agenten mit gegensätzlichen Zielen (z. B. Umsatzmaximierung vs. Risikominimierung) ohne strikte Einschränkungen interagieren, kann das System in Zustände ewiger Oszillation oder entscheidungsbezogener Divergenz geraten.

Dieser technische Leitfaden untersucht die Anwendung der Systemtheorie und der optimalen Steuerung, um die Konvergenz in KI-Agenten-Netzwerken im Hypothekensektor zu gewährleisten, und schlägt robuste Architekturen vor, die auf deterministischen Supervisoren basieren.

Entropie in finanziellen Multi-Agenten-Systemen

Im Gegensatz zu herkömmlicher Software, die auf imperativer Logik basiert, sind Multi-Agenten-Systeme intrinsisch probabilistisch. In einem finanziellen Kontext ist dieser schwache Determinismus inakzeptabel, wenn er nicht verwaltet wird. Stellen wir uns eine Triade von Agenten vor:

- Angebotsersteller (Sales Agent): Optimiert für Kundenkonversion und Zinswettbewerbsfähigkeit.

- Underwriter (Risk Agent): Optimiert für Vorsicht und Einhaltung der Kreditkriterien.

- Compliance (Legal Agent): Optimiert für die Einhaltung von Vorschriften (z. B. AI Act, lokale Bankvorschriften).

Ohne eine Steuerungsarchitektur kann ein komplexer Hypothekenantrag eine positive Rückkopplungsschleife erzeugen. Der Angebotsersteller schlägt einen aggressiven Zinssatz vor; der Underwriter lehnt diesen ab und fordert höhere Sicherheiten; der Angebotsersteller passt das Angebot geringfügig an; die Compliance meldet eine durch die Änderung verursachte dokumentarische Inkonsistenz. Das Ergebnis ist ein rechnerischer Deadlock oder, schlimmer noch, eine halluzinierte Entscheidung aufgrund von Kontext-Erschöpfung.

Angewandte Systemtheorie: Konvergenz und Stabilität

Um Stabilität zu konstruieren, müssen wir das Agentennetzwerk als dynamisches System behandeln. Das Ziel ist es, sicherzustellen, dass das System für jeden Input (Hypothekenantrag) in endlicher Zeit gegen einen Gleichgewichtszustand (endgültige Genehmigung oder Ablehnung) konvergiert.

Das Problem der Grenzzyklen (Limit Cycles)

In der Mathematik ist ein Grenzzyklus eine geschlossene Trajektorie im Phasenraum. In Multi-Agenten-Systemen im Finanzwesen manifestiert sich dies, wenn Agenten endlos verhandeln, ohne einen Konsens zu erreichen. Um dieses Risiko zu mindern, müssen globale Kostenfunktionen implementiert werden, die die Dauer der Verhandlung bestrafen.

Ein effektiver Ansatz ist die Anwendung des Konzepts der Lyapunov-Stabilität. Wir können eine “Energiefunktion” des Systems $V(x)$ definieren, wobei $x$ den Status des Hypothekenantrags darstellt. Die Stabilität ist garantiert, wenn die zeitliche Ableitung der Energiefunktion negativ ist ($dot{V}(x) < 0$), d. h. wenn jede Interaktion zwischen Agenten die Unsicherheit oder den Abstand zum Abschluss des Vorgangs verringert.

Architektur des deterministischen Supervisors

Die technische Lösung zur Vermeidung von Divergenz liegt nicht in der Verbesserung der einzelnen KI-Modelle, sondern in der Einführung eines deterministischen Supervisors. Diese Komponente ist keine generative KI, sondern ein endlicher Automat (FSM) oder eine starre Regel-Engine.

Der Supervisor fungiert als “Sicherheitsbegrenzer” mit folgenden Aufgaben:

- Durchsetzung der Topologie: Definiert, wer mit wem und in welcher Reihenfolge sprechen darf (z. B. darf der Angebotsersteller den Kunden nicht kontaktieren, wenn der Compliance-Agent den Output des Underwriters nicht validiert hat).

- Schleifenerkennung: Behält einen Hash der vorherigen Zustände des Vorgangs bei. Wenn der aktuelle Zustand identisch mit einem vor $N$ Schritten besuchten Zustand ist, unterbricht der Supervisor die Schleife und erzwingt eine menschliche Eskalation oder eine Standardablehnung.

- Temperaturabfall: Um die Konvergenz zu fördern, kann der Supervisor bei jeder Verhandlungsiteration eine progressive Reduzierung der “Temperatur” (Kreativität) der Agenten erzwingen, was sie zu konservativeren und standardisierteren Antworten zwingt.

Fallstudie: Das Hypotheken-Ökosystem (Angebotsersteller vs. Underwriter)

Analysieren wir ein spezifisches Design-Pattern für die Verwaltung eines risikoreichen Hypothekenantrags.

Divergenzszenario

Der Benutzer beantragt eine Hypothek mit 95% LTV (Loan-to-Value). Der Angebotsersteller erkennt ein hohes Einkommen und schlägt die Hypothek vor. Der Underwriter stellt fest, dass der Arbeitssektor des Kunden volatil ist, und lehnt ab. Der Angebotsersteller schlägt daraufhin eine Zusatzversicherung vor. Der Underwriter akzeptiert die Versicherung, verlangt aber einen höheren Zinssatz. Der Angebotsersteller berechnet den Zinssatz neu, der jedoch die vom Compliance-Agenten erkannte Wuchergrenze überschreitet.

Lösung: Das Pattern “Gedämpfter Konsens”

Um dieses Szenario zu lösen, implementieren wir das Pattern des Gedämpften Konsenses:

- Schritt 1: Die Agenten haben ein begrenztes Budget an “Verhandlungs-Token” (z. B. maximal 3 Iterationen).

- Schritt 2: Jeder Gegenvorschlag muss sich um ein signifikantes Delta (vom Supervisor definiert) vom vorherigen unterscheiden. Mikroskopische Änderungen sind nicht zulässig.

- Schritt 3: Wenn am Ende der Iterationen kein Konsens (Gleichgewichtszustand) besteht, versucht das System nicht, den Konflikt autonom zu lösen, sondern friert den Zustand ein und ruft menschliches Eingreifen an.

Strategischer Human-in-the-loop: Jenseits des Fallbacks

Im Jahr 2026 hat sich das Konzept des Human-in-the-loop (HITL) weiterentwickelt. Es ist nicht mehr nur ein Notfallmechanismus, sondern eine aktive Komponente des Regelkreises. In Multi-Agenten-Systemen im Finanzwesen muss der Mensch nicht jede Operation validieren (ineffizient), sondern nur bei kritischen Risikoschwellen eingreifen.

Die Architektur darf dem menschlichen Bediener nicht das rohe Chat-Protokoll zwischen den Agenten zeigen, sondern eine strukturierte Konfliktzusammenfassung:

“Agent A schlägt X basierend auf dem Einkommen vor. Agent B lehnt X basierend auf der Volatilität des Sektors ab. Das berechnete Risikodelta beträgt 15%. Erzwingung genehmigen oder ablehnen?”

Dieser Ansatz verwandelt den menschlichen Bediener in ein “Orakel”, das die semantische Mehrdeutigkeit löst, die mathematische Modelle nicht auflösen können, und erhält so die Effizienz des automatisierten Prozesses für 90% der Standardfälle.

Technische Implementierung und Best Practices

Für Entwickler, die diese Systeme bauen (unter Verwendung fortschrittlicher Frameworks, die von LangGraph oder AutoGen abgeleitet sind), sind hier die grundlegenden Best Practices:

- Statische Typisierung der Outputs: Erlauben Sie Agenten niemals, in unstrukturiertem Freitext zu kommunizieren. Verwenden Sie strikte JSON-Schemata (Pydantic-Modelle) für jeden Nachrichtenaustausch. Dies verhindert Halluzinationen im Kommunikationsprotokoll.

- Deterministische Timeouts: Jeder Aufruf an einen Agenten muss einen strengen Timeout auf Infrastrukturebene haben.

- Logging des Entscheidungsbaums: Für Audit-Zwecke (im Finanzwesen unerlässlich) reicht es nicht aus, das Ergebnis zu speichern. Der gesamte Verhandlungsgraph zwischen den Agenten muss persistiert werden, um das “Warum” einer Entscheidung bei einer regulatorischen Prüfung rekonstruieren zu können.

Fazit

Die Stabilität von Multi-Agenten-Systemen im Finanzwesen ist keine emergente Eigenschaft, sondern eine Anforderung, die explizit entworfen werden muss. Durch den Einsatz deterministischer Supervisoren, Iterationslimits und eines strategischen HITL ist es möglich, die Kraft der autonomen KI zu nutzen und gleichzeitig die Risiken chaotischen Verhaltens zu mindern. Die Zukunft der Hypothekenautomatisierung liegt nicht in intelligenteren Agenten, sondern in robusteren Kontrollsystemen.

Häufig gestellte Fragen

Das größte Risiko ist die systemische Instabilität, bei der Agenten mit gegensätzlichen Zielen, wie Umsatzmaximierung und Risikominimierung, in endlose Verhandlungsschleifen geraten. Ohne strikte Kontrollen führt dies zu rechnerischen Stillständen oder divergenten Entscheidungen, was den schwachen Determinismus, der für probabilistische Modelle typisch ist, in kritischen Kontexten wie der Kreditvergabe inakzeptabel macht.

Diese Komponente fungiert als endlicher Automat, der strikte Kommunikations- und Topologieregeln zwischen den Agenten durchsetzt. Der Supervisor verhindert Divergenz, indem er repetitive Zyklen durch Hashes früherer Zustände erkennt und einen Temperaturabfall anwendet, wodurch die Modelle gezwungen werden, innerhalb einer endlichen Zeit gegen konservativere und standardisierte Antworten zu konvergieren.

Es handelt sich um eine technische Methode zur Lösung von Verhandlungskonflikten zwischen Agenten, indem ein begrenztes Budget an Iterationen festgelegt wird und verlangt wird, dass sich jeder Gegenvorschlag signifikant vom vorherigen unterscheidet. Wenn nach Verbrauch der Verhandlungs-Token kein Konsens erreicht wird, friert das System den Zustand ein und fordert ein strategisches menschliches Eingreifen an, anstatt endlos weiterzulaufen.

Für Audit-Zwecke und die Einhaltung von Bankvorschriften reicht es nicht aus, nur das Endergebnis eines Vorgangs zu speichern. Es ist notwendig, den gesamten Graphen der zwischen den Agenten stattgefundenen Verhandlungen zu persistieren, um den logischen Grund einer spezifischen Entscheidung rekonstruieren zu können, was Transparenz und vollständige Rückverfolgbarkeit bei Inspektionen durch Regulierungsbehörden garantiert.

Im Jahr 2026 fungiert der Mensch nicht mehr als einfacher Validierer jeder Operation, sondern wird zu einem strategischen Orakel, das nur bei kritischen Risikoschwellen oder Deadlocks eingreift. Das System präsentiert dem Bediener eine strukturierte Zusammenfassung des semantischen Konflikts zwischen den Agenten, was eine schnelle Lösung von Mehrdeutigkeiten ermöglicht, die mathematische Modelle nicht autonom auflösen können.

Quellen und Vertiefung

- Europäische Kommission: Der europäische Rechtsrahmen für KI (AI Act)

- BaFin: Aufsichtliche Prinzipien für Big Data und Künstliche Intelligenz

- Wikipedia: Grundlagen und Definition von Multiagentensystemen (MAS)

- Wikipedia: Mathematische Grundlagen der Ljapunow-Stabilität in dynamischen Systemen

- Bank für Internationalen Zahlungsausgleich (BIZ): Risiken von KI und ML in Finanzdienstleistungen

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.