Siamo nel 2026, e il confine tra la realtà biologica e la simulazione digitale non è mai stato così sottile. Immaginate di rispondere a una chiamata da un numero sconosciuto. Dite semplicemente: “Pronto, chi parla?”. Una frase banale, durata forse meno di un respiro. Eppure, in quel brevissimo lasso di tempo, un algoritmo in ascolto ha già catturato tutto ciò che serve. La Clonazione Vocale, l’entità tecnologica al centro della nostra analisi odierna, ha raggiunto un livello di sofisticazione tale da rendere obsoleti i vecchi paradigmi di sicurezza biometrica. Non servono più ore di registrazione in studio; oggi, la regola aurea è quella dei tre secondi. Ma cosa accade esattamente in questo frammento di tempo all’interno dei circuiti di un’architettura neurale? Come può una macchina estrapolare l’intera gamma espressiva di un essere umano da un campione così esiguo?

L’evoluzione del silenzio: dai sintetizzatori alla mimesi perfetta

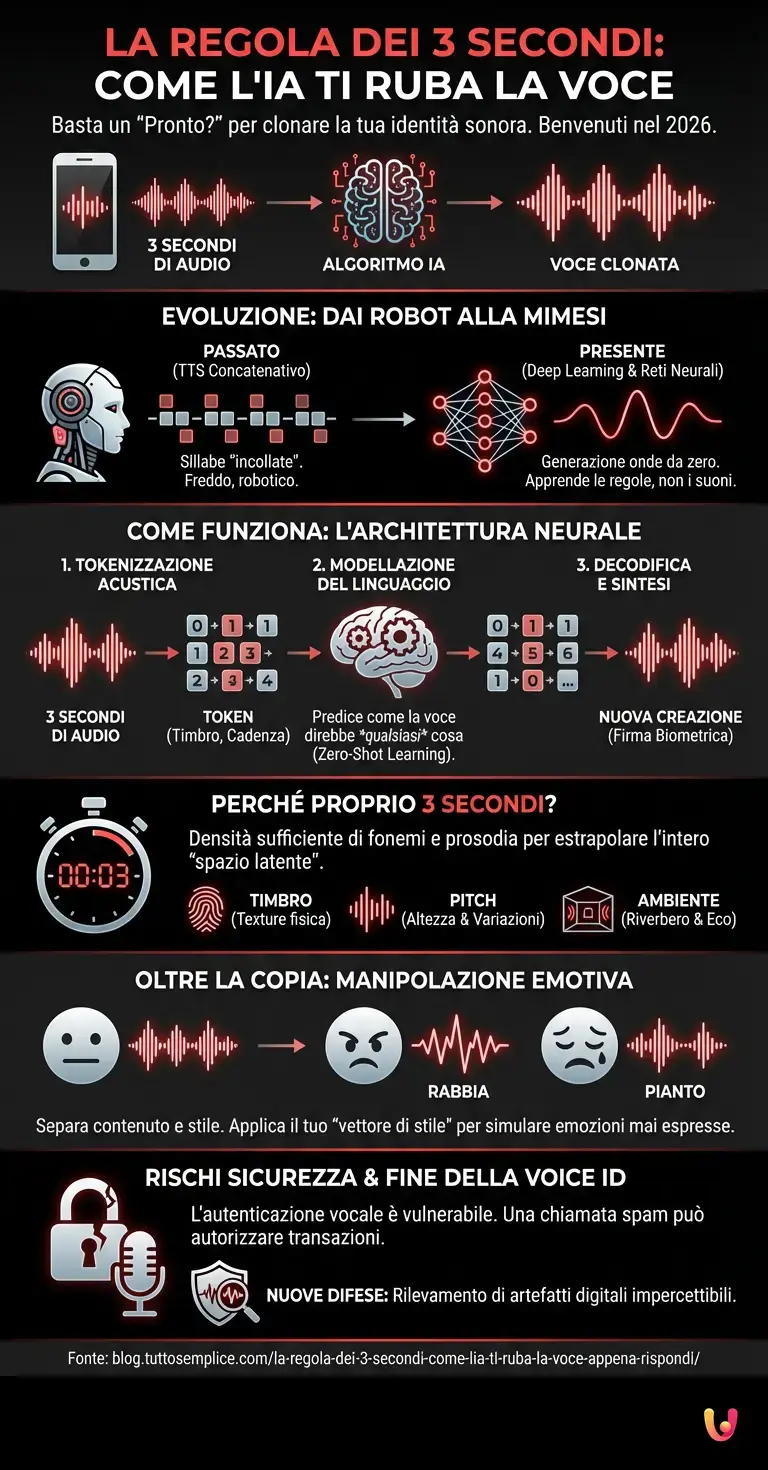

Per comprendere la gravità e la meraviglia tecnica della regola dei tre secondi, dobbiamo guardare indietro al progresso tecnologico degli ultimi anni. Fino a poco tempo fa, la sintesi vocale (Text-to-Speech o TTS) si basava su un approccio concatenativo: enormi database di sillabe e parole registrate da attori venivano “incollate” insieme. Il risultato era comprensibile, ma roboticamente freddo. Mancava il “fantasma nella macchina”: l’intonazione, il respiro, l’imperfezione umana.

La svolta è arrivata con l’introduzione del Deep Learning e delle reti neurali profonde. Invece di incollare suoni, l’Intelligenza Artificiale ha imparato a generare onde sonore da zero, prevedendo come un segnale audio dovrebbe evolversi millisecondo dopo millisecondo. Modelli pionieristici come VALL-E di Microsoft, presentati già nel 2023, hanno gettato le basi per ciò che oggi, nel 2026, è diventato uno standard accessibile. Questi sistemi non memorizzano suoni; apprendono le regole statistiche che governano la voce umana.

Sotto il cofano: come funziona l’architettura neurale audio

Il segreto della regola dei tre secondi risiede in un cambio di paradigma nell’architettura neurale: il passaggio dalla spettrografia ai codec audio neurali. Tradizionalmente, l’audio veniva convertito in spettrogrammi (rappresentazioni visive delle frequenze). I moderni modelli di AI, invece, trattano l’audio in modo simile a come i LLM (Large Language Models) come ChatGPT trattano il testo.

Il processo avviene in tre fasi distinte e quasi istantanee:

- Tokenizzazione Acustica: L’audio di tre secondi della vostra voce viene scomposto in “token” discreti. Immaginateli come i mattoncini LEGO fondamentali del vostro timbro. L’algoritmo non “sente” il suono, ma lo codifica in una sequenza numerica che rappresenta le caratteristiche uniche della vostra laringe, la risonanza nasale e la cadenza.

- Modellazione del Linguaggio Acustico: Qui entra in gioco il Machine Learning avanzato. Il modello utilizza questi token per comprendere non solo cosa avete detto, ma come lo avete detto. Grazie a un addestramento su decine di migliaia di ore di parlato (un benchmark di dati colossale), l’IA è in grado di predire come la vostra voce pronuncerebbe qualsiasi altra parola, anche in lingue che non parlate.

- Decodifica e Sintesi: Infine, un decoder neurale trasforma la sequenza di token predetti in una forma d’onda audio grezza. Il risultato non è una copia; è una nuova creazione che possiede la vostra firma biometrica.

Perché proprio tre secondi? La matematica della voce

La curiosità principale che ci spinge oggi è: perché tre secondi? Perché non dieci, o uno solo? La risposta risiede nella densità dell’informazione fonetica e prosodica. Tre secondi di parlato continuo contengono solitamente una frase completa o una clausola significativa. In questo lasso di tempo, un essere umano produce una varietà sufficiente di fonemi (suoni distintivi) e, soprattutto, rivela la sua prosodia (il ritmo e l’intonazione).

Gli algoritmi di Zero-Shot Learning (apprendimento senza esempi specifici precedenti) sono progettati per estrapolare l’intero “spazio latente&re; della voce di un individuo partendo da questo piccolo campione. In tre secondi, l’IA cattura:

- Il Timbro: La “texture” fisica della voce.

- Il Pitch: L’altezza fondamentale e le sue variazioni.

- L’Ambiente Acustico: Se parlate da una stanza con eco o da un’auto, l’IA replicherà anche quel riverbero, rendendo il falso indistinguibile dal vero.

Se il campione fosse inferiore ai tre secondi, il modello potrebbe non avere abbastanza dati sulla transizione tra i fonemi, rischiando di produrre una voce instabile o generica. Oltre i tre secondi, il guadagno in termini di fedeltà diminuisce drasticamente: l’algoritmo ha già “capito” chi siete.

Oltre la copia: emozioni e ambiente acustico

Ciò che rende questa tecnologia affascinante e al contempo inquietante è la capacità di preservare l’emotività. A differenza dei vecchi sistemi di sintesi vocale, le moderne IA generative non si limitano a leggere un testo con la vostra voce. Possono modificare l’emozione. Partendo dal vostro campione neutro di tre secondi, l’automazione avanzata permette di farvi urlare di rabbia, sussurrare dolcemente o piangere disperatamente.

Questo avviene perché i modelli separano il contenuto (le parole) dallo stile (l’emozione e il timbro). Una volta isolato il “vettore dello stile” dai vostri tre secondi, questo può essere applicato a qualsiasi contenuto testuale, modulando i parametri per simulare stati d’animo che non avete mai espresso durante la registrazione originale. È il trionfo del Deep Learning sulla rigidità biologica.

I rischi della sicurezza e la fine dell’autenticazione biometrica

La democratizzazione di questi strumenti pone interrogativi critici. Fino a pochi anni fa, la voce era considerata un’impronta digitale sicura. Banche e servizi di assistenza utilizzavano la “voice ID” come metodo di autenticazione. Oggi, nel 2026, la regola dei tre secondi ha reso questi sistemi vulnerabili.

Un malintenzionato non ha bisogno di hackerare un server; gli basta una telefonata di spam, un video sui social media o un messaggio vocale intercettato. Con tre secondi di audio, è possibile generare frasi di consenso per autorizzare transazioni o accedere a dati sensibili. Questo ha costretto l’industria della sicurezza informatica a sviluppare nuovi benchmark di difesa, basati non più sul riconoscimento della voce, ma sul rilevamento di artefatti digitali impercettibili all’orecchio umano che distinguono l’audio sintetico da quello organico.

In Breve (TL;DR)

Basta un frammento audio di tre secondi affinché l’intelligenza artificiale catturi la tua firma biometrica e replichi ogni sfumatura vocale.

Attraverso la tokenizzazione acustica e il Deep Learning, gli algoritmi ricostruiscono l’intera gamma espressiva partendo da un brevissimo campione sonoro.

La densità informativa di una singola frase permette ai sistemi Zero-Shot Learning di estrapolare la tua identità vocale con precisione inquietante.

Conclusioni

La regola dei tre secondi non è solo una curiosità tecnica; è il simbolo di un’era in cui la nostra identità digitale è sempre più fluida e, paradossalmente, sempre più esposta. L’Intelligenza Artificiale ha decodificato la complessità della fonazione umana, riducendola a una sequenza di vettori matematici replicabili in un istante. Se da un lato questo apre porte straordinarie per l’intrattenimento, il doppiaggio automatico e l’accessibilità per chi ha perso la voce, dall’altro ci impone una nuova consapevolezza. La nostra voce, un tempo inimitabile sigillo della nostra individualità, è ora un dato replicabile. E per rubarlo, non serve più un furto elaborato: basta il tempo di dire “Pronto?”.

Domande frequenti

Grazie all’evoluzione delle reti neurali profonde e del Deep Learning, oggi sono sufficienti appena tre secondi di audio continuo per clonare fedelmente una voce umana. In questo brevissimo lasso di tempo, gli algoritmi moderni riescono a catturare la densità delle informazioni fonetiche essenziali, inclusi il timbro, il pitch e la prosodia. A differenza dei vecchi sistemi che richiedevano ore di registrazione, i modelli attuali utilizzano l’apprendimento Zero-Shot per estrapolare l’intera gamma espressiva di un individuo da un campione minimo, rendendo la replica indistinguibile dall’originale.

Il processo si basa su un cambio di paradigma tecnologico che utilizza codec audio neurali invece della tradizionale spettrografia. L’audio viene scomposto in token acustici discreti, che fungono da mattoncini fondamentali del timbro vocale. Successivamente, un modello di linguaggio acustico analizza questi token per comprendere lo stile e l’intonazione del parlante, prevedendo come la voce pronuncerebbe altre parole. Infine, un decoder neurale sintetizza una nuova forma d’onda audio che possiede la firma biometrica dell’utente, creando un audio sintetico generato da zero.

La capacità di clonare una voce in pochi secondi ha reso estremamente vulnerabili i sistemi di autenticazione biometrica vocale, precedentemente considerati sicuri da banche e servizi clienti. I malintenzionati possono utilizzare brevi campioni audio, ottenuti da telefonate spam o social media, per generare frasi di consenso e autorizzare transazioni fraudolente. Di conseguenza, l’industria della sicurezza sta abbandonando il semplice riconoscimento vocale a favore di sistemi avanzati capaci di rilevare artefatti digitali impercettibili all’orecchio umano per distinguere l’audio sintetico da quello organico.

Sì, le moderne IA generative hanno superato la lettura robotica dei testi e sono ora in grado di manipolare l’emotività e il contesto ambientale. Gli algoritmi separano il contenuto delle parole dallo stile vocale, permettendo di applicare stati d’animo come rabbia, sussurri o pianto alla voce clonata, anche se il campione originale era neutro. Inoltre, l’IA è in grado di replicare l’ambiente acustico di provenienza, come l’eco di una stanza o il rumore di fondo di un’auto, aumentando drasticamente il realismo della simulazione.

Rispondere a numeri sconosciuti espone al rischio che un algoritmo in ascolto registri la vostra voce. Poiché bastano tre secondi di parlato, anche una frase banale di saluto fornisce dati sufficienti per creare un clone vocale. Una volta acquisito il campione, la vostra voce può essere utilizzata per truffe telefoniche, accessi non autorizzati a dati sensibili o per ingannare contatti fidati, rendendo la propria identità biometrica un dato facilmente replicabile e sfruttabile per scopi illeciti.

Fonti e Approfondimenti

- Garante Privacy: Scheda informativa sui rischi dei deepfake e furto di identità

- Federal Trade Commission: Allerta sulle truffe tramite clonazione vocale IA

- Europol: Rapporto sulle sfide della manipolazione audio/video per le forze dell’ordine

- Wikipedia: Storia e tecnologie della sintesi vocale (dal concatenativo alle reti neurali)

Hai trovato utile questo articolo? C’è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.